- Réseaux différents pour prédateurs ou pollinisateurs

- Images du cerveau

- Les singes parlent avec les mains

<- Revue des sciences précédente | Revue des sciences suivante ->

Revues : Pour la Science - Science&Vie

Brèves : Physique - Climat - Biologie - Santé - Technologie

Il faut bien le dire, la crise semble presque anecdotique devant les avancées de la science qui continuent sans en être apparemment affectées et nous étonnent toujours autant car, à l'opposé de ce qu'on croit ordinairement, ce que les sciences nous apprennent, c'est l'étendue de notre ignorance et la fragilité de nos certitudes. Ainsi, j'ai trouvé très instructif que le récit s'ébauche avec le mime chez les singes qui "parlent avec les mains" éclairant d'un jour nouveau les origines du langage. C'est surtout la physique qui s'affole en attendant que le LHC produise des résultats, les données contradictoires de l'astrophysique renforçant l'hypothèse d'un mauvais calibrage des instruments et de modèles trompeurs mais nos représentations sont encore une fois complétement bouleversées (avec l'interprétation entropique de la gravité ou bien un univers non homogène où nous aurions une position privilégiée, soit par le vide qui nous entoure, soit par une "constante" de structure fine qui ne serait pas constante selon le côté de l'espace où on la mesure, ce qui rendrait exceptionnel qu'elle puisse être compatible avec la vie!). De quoi donner le tournis. Pour les mathématiques, c'est très différent, on est dans la certitude de l'hypothèse et les vérités éternelles. Ce qui est difficile, c'est d'y comprendre quelque chose étant donné le niveau d'abstraction atteint mais c'est un domaine où la France s'illustre encore avec 2 médailles Fields, or, les mathématiques, c'est l'avenir (on le voit, pas seulement avec les modèles financiers mais aussi avec Google, entre autres). La seule autre bonne nouvelle, c'est l'invention de l'hygroélectricité sensée tirer de l'électricité de l'humidité de l'air, pas sûr que le rendement soit assez bon mais, à l'évidence, on manque de tout sauf d'énergie ! On a largement les moyens de se passer de pétrole (en 10 ans prétendent les Australiens un peu trop optimistes), pas besoin de s'engager dans des voies trop coûteuses, des scientifiques appelant à l'abandon du projet Iter dont les coûts explosent. L'urgence, c'est le climat plus que l'énergie. C'est une très bonne chose que le rapport de l'ONU rappelle à l'ordre le GIEC qui a été blanchi de pratiques frauduleuses mais critiqué fortement sur ses pratiques, il y a de grands progrès à faire pour construire une véritable intelligence collective qui en est à ses balbutiements. A noter, le revirement de Bjørn Lomborg qui reconnaît désormais cette urgence climatique. Sur ce plan, comme sur d'autres, il n'y a pas de quoi pavoiser. Sans parler du tremblement de terre en Californie qui est relativement imminent et pourrait accélérer l'histoire, on doit affronter déjà une nouvelle spéculation sur le blé à cause des intempéries, la hausse soudaine des prix pouvant provoquer des famines. Ce qui caractérise peut-être le plus notre moment actuel, pourtant, c'est surtout le renforcement du contrôle des Etats sur les réseaux, le rôle grandissant de la Chine et le retour des Etats dans la régulation de l'économie s'accompagnant d'un retour de son contrôle des populations. La combinaison de l'introduction d'une censure étatique et de l'analyse en temps réel des conversations téléphoniques a de quoi nous inquiéter sérieusement (sans parler de l'augmentation de débit des puces RFiD). Qu'on y ajoute le prochain traité ACTA et les menaces sur la neutralité du net, il semble bien qu'on vit la fin de l'âge d'or d'un internet libertaire, sauf à recréer un réseau en P2P sans provider (réseaux sans fil instantanés entre mobiles ou WiFi) mais ce n'est pas encore assez opérationnel pour l'instant. En tout cas, cela milite pour une pluralité des réseaux selon leur destination et les situations locales (après l'unification, l'éclatement?).

Pour la Science no 395, Les fractales 3D

Rien de bien nouveau sur les fractales, sauf qu'on n'écrit plus fractal comme avant mais qu'on se conforme à l'usage en mettant un "e" désormais. Sinon, on avait déjà parlé des fractales en 3 dimensions. On peut juste noter qu'une coupe de la Mandelbulb (fractale en 3 dimensions) donne bien l'ensemble de Mandelbrot bien connu. Mieux vaut regarder cette vidéo.

- Dangereuses perversions, p15

Ivar Ekeland

La vitesse de la lumière devient une limite: si vous êtes à Paris, si les prix changent à Londres, le temps que l’information vous parvienne, c’est trop tard, le temps que votre ordre parvienne sur place, ils auront encore changé. Voilà pourquoi les stratégies de trading sont désormais probabilistes: à l’échelle de la milliseconde, les algorithmes considèrent le prix comme aléatoire.

Le « trading haute fréquence » représente à l’heure actuelle environ le tiers de l’activité des Bourses européennes et cette proportion va croissant. Je ne veux pas terminer sans rendre un hommage vibrant à la Commission européenne, qui, sans autre argument qu’une foi profonde dans les vertus du marché, foi qui n’est en rien soutenue par la science économique, se lance dans une expérience grandeur nature, dont le résultat va affecter les économies et les investissements de millions de personnes.

- L'Univers perd-il de l'énergie ?, p30

Tamara Davis

L'énergie totale d'un système isolé, tel l'Univers, devrait être conservée. Or la lumière issue des galaxies lointaines semble perdre de l'énergie en raison de l'expansion de l'Univers. Y a-t-il un paradoxe ?

Presque toute l'information dont nous disposons sur le cosmos nous parvient sous forme de lumière. L'une des principales caractéristiques de ce rayonnement est que, à mesure qu'il parcourt la distance qui nous sépare des sources lointaines à travers l'Univers en expansion, il est décalé vers le rouge (sa longueur d'onde est étirée). Mais plus la longueur d'onde est grande, plus l'énergie est basse. Aussi une question vient-elle immédiatement à l'esprit : quand la lumière subit le décalage vers le rouge lié à l'expansion de l'Univers, où va son énergie ? Est-elle perdue, violant de ce fait le principe de conservation de l'énergie ?

Non. À l'échelle des interactions des photons avec d'autres particules, l'énergie est toujours conservée, même si le flux de lumière dans son ensemble subit un décalage vers le rouge en traversant l'espace en expansion. De même, pour les phénomènes astrophysiques qui se produisent au sein des galaxies, les violations du principe de conservation de l'énergie sont impossibles, et ce principe repose sur de solides fondements.

Ce principe a été validé empiriquement à de multiples reprises, mais il existe également de bons arguments théoriques en sa faveur. Il y a près d'un siècle, la mathématicienne allemande Emmy Noether lui a donné des fondements robustes en découvrant que les lois de conservation reposent sur des symétries.

L'écoulement du temps ne modifie pas les lois de la physique classique. Si vous répétez une même expérience à des instants différents, le résultat sera toujours le même. Il s'agit de la symétrie par translation dans le temps. Les lois physiques ne changent pas non plus selon le lieu où vous vous trouvez ; c'est la symétrie par translation dans l'espace. Enfin, elles sont identiques quelle que soit la direction dans laquelle vous regardez (symétrie par rotation). Bien sûr, l'environnement peut changer selon l'endroit, le moment et la direction d'observation, mais les lois sous-jacentes qui décrivent comment cet environnement se « comporte » sont indépendantes du lieu, de l'orientation et du temps. Comme celle du cercle, ces trois symétries sont continues.

Ce que Noether a découvert, c'est qu'à chaque fois que la nature présente une symétrie continue, une loi de conservation l'accompagne, et réciproquement. En particulier, la symétrie par translation dans l'espace implique que la quantité de mouvement est conservée ; la symétrie par rotation garantit la conservation du moment cinétique ; et la symétrie par translation dans le temps équivaut à la conservation de l'énergie.

Ainsi, l'hypothèse de la conservation de l'énergie est aussi solide – mais pas plus – que celle selon laquelle les lois de la physique sont les mêmes au moment présent, dans le passé ou dans le futur. Si cette symétrie par translation temporelle était prise en défaut, la conservation de l'énergie serait remise en cause. Comme nous allons le voir, c'est de ce côté-là que la conservation de l'énergie pourrait faillir dans le contexte cosmologique.

Ainsi, à l'instar de la lumière qui perd de l'énergie à mesure que sa longueur d'onde est étirée, la matière perd de l'énergie en ralentissant. À première vue, les deux situations semblent différentes, mais en réalité, la mécanique quantique unifie les deux. Dans la description quantique de la matière, les particules dotées d'une masse présentent également des propriétés ondulatoires. Louis de Broglie a montré au début du xxe siècle que plus la quantité de mouvement d'une particule est grande (la quantité de mouvement est le produit de la masse par la vitesse), plus sa longueur d'onde est courte et plus son énergie est élevée (il a obtenu en 1929 le prix Nobel pour cette découverte).

On ne voit jamais des objets usuels adopter un mouvement ondulatoire, car leur masse est énorme comparativement aux échelles quantiques. Une balle de tennis servie à 180 kilomètres par heure, par exemple, a une longueur d'onde de l'ordre de 10–33 mètre. Un électron animé de la même vitesse a, lui, une longueur d'onde de 12 micromètres : c'est encore petit, mais 28 ordres de grandeur plus grand que pour une balle de tennis, et cela ne passe pas inaperçu au niveau du comportement des électrons.

Le calcul montre que lorsque les particules de masse non nulle ralentissent au cours de leur trajet dans l'Univers en expansion, leur longueur d'onde augmente exactement dans la même proportion que celle des photons sur le même parcours. Ainsi, lumière et matière semblent perdre de l'énergie exactement de la même façon dans l'Univers en expansion, et dans les deux cas, le principe de conservation de l'énergie semble violé. Dans le cas de la matière, cela s'explique par le fait que nous mesurons la vitesse dans des référentiels différents, c'est-à-dire par rapport aux galaxies qui s'éloignent.

Comment concilier cette non-conservation de l'énergie avec le théorème de Noether ? En fait, il n'y a pas de raison que le théorème de Noether s'applique à notre Univers en perpétuel changement. D'après la théorie de la relativité générale, la matière et l'énergie courbent l'espace, et lorsqu'elles se déplacent ou suivent le mouvement d'expansion général, la forme de l'espace change en conséquence. Cette malléabilité de l'espace implique que le comportement de l'Univers n'est pas symétrique par translation dans le temps.

Le principe de conservation trouve là sa limite : quand le temps et l'espace eux-mêmes ne sont pas immuables, la symétrie par translation dans le temps est perdue, et la conservation de l'énergie avec elle.

Nous sommes libres de considérer le mouvement relatif des galaxies qui s'éloignent mutuellement comme une expansion de l'espace ou comme un mouvement à travers l'espace ; la différence est essentiellement sémantique.

Il n'y a donc rien de mystérieux dans la perte d'énergie des photons : les galaxies qui émettent et où sont mesurées ces énergies s'éloignent les unes des autres, et la perte d'énergie est simplement une question de perspective et de mouvement relatif.

Néanmoins, nous avons vu que définir l'énergie de l'Univers dans sa globalité pose un problème fondamental, parce que nous ne pouvons pas lui attribuer une valeur unique. Ainsi, l'Univers ne viole pas le principe de conservation de l’énergie, pour la bonne et simple raison que cette loi n’a pas vocation à s’appliquer à l’Univers entier.

La thermodynamique est vraiment à l'honneur ce mois-ci, mais on devrait dire plutôt "la loi des grands nombre" ou des probabilités qui expliquerait que le réel soit mathématisable. Ici, l'idée intéressante, c'est le théorème de Noether et le fait que la symétrie temporelle serait violée par la transformation de l'univers, principe même de l'entropie, mais le raisonnement prend curieusement la forme de la blague juive dite du chaudron, à prétendre 1) qu'il n'y a pas de violation de la conservation de l'énergie, 2) que cette violation a lieu depuis toujours et que 3) la question elle-même n'a pas de sens !

Les efforts pédagogiques de l'auteur sont certes louables mais leur inconvénient c'est de vouloir gommer les problèmes pour nous donner l'illusion de comprendre, et que donc le pédagogue comprend parfaitement ce qui est pourtant incompréhensible parce qu'incomplet et approximatif (nous ne comprenons pas tout parce qu'il nous manque des informations et qu'il y a des incohérences entre nos théories que devront résoudre des théories futures). Une bonne partie du prestige d'Einstein vient de ce que la relativité peut avoir d'incompréhensible. On suppose que lui comprenait très bien de quoi il s'agissait alors qu'il n'a fait que prendre des formules au sérieux, comme Newton avec la formule de la gravitation, sans du tout pouvoir comprendre pourquoi la formule marche, pure constatation (hypotheses non fingo). Le génie de Newton comme d'Einstein, c'est justement de ne pas comprendre, ne pas chercher à sauver nos intuitions, nos représentations, nos convictions métaphysiques dans la mathématisation de l'expérience. Le progrès, ici, c'est de ne pas comprendre, ne pas prétendre au bien connu. Comme pour la philosophie, et toute histoire à suspens, on ne pourra comprendre qu'à la fin peut-être, quand la théorie sera complète si c'est possible un jour... Ce que nous enseigne la physique constamment, c'est bien que nous avions tort de croire parfaitement savoir de quoi il retourne, tort de croire que d'autres savaient très bien et qu'il n'y avait plus aucun mystère ("Il n'y a donc rien de mystérieux dans la perte d'énergie des photons" dit-elle!). Tant de trop belles théories se sont révélées fausses. Hélas, certains en tirent la conclusion idiote que n'importe quel délire pourrait être vrai alors qu'il faudrait au contraire en rabattre sur nos prétentions, redoubler de prudence dans nos convictions, se confronter à l'expérience et se persuader que de près la réalité est toujours très différente de ce qu'on imagine. Il faudrait plutôt une anti-pédagogie, donc, pour montrer le caractère révolutionnaire de la science en train de se faire et pas encore dogmatisée. Cela n'enlève pas l'intérêt de l'effort pédagogique à essayer de donner une représentation cohérente d'un état du savoir mais seulement pour en souligner les incohérences justement et non pour lui donner une forme dogmatique qui évacue les questions quitte à le faire au prix de contradictions grossières trahissant leur fonction de refoulement. L'expansion elle-même, sur laquelle travaille l'auteur, est loin d'être acquise, des théories concurrentes la réfutant tout comme la matière noire, il ne faut donc pas en tirer des conclusions prématurées sur leurs prétendues évidences...

- La parole aux singes, p46

On ne s'étendra pas sur cet article qui n'aborde rien de neuf par rapport à ce dont on avait déjà parlé ici, en particulier le début de syntaxe ("Wak-oo Krak-oo Wak-oo Krak-oo Krak-oo" pour l'aigle) qui montre qu'on n'est pas dans le pur émotionnel. Cela ne suffit pas à faire un langage de ce qui n'est qu'un code plus qu'une syntaxe mais éclaire tout de même sur les précurseurs du langage (émotion-> code-> syntaxe-> récit).

On ne s'étendra pas sur cet article qui n'aborde rien de neuf par rapport à ce dont on avait déjà parlé ici, en particulier le début de syntaxe ("Wak-oo Krak-oo Wak-oo Krak-oo Krak-oo" pour l'aigle) qui montre qu'on n'est pas dans le pur émotionnel. Cela ne suffit pas à faire un langage de ce qui n'est qu'un code plus qu'une syntaxe mais éclaire tout de même sur les précurseurs du langage (émotion-> code-> syntaxe-> récit).

La brève du mois qui montre que les singes "parlent avec les mains" me semble bien plus décisive car on aurait là un début de récit, ce qui est tout autre chose, à faire référence à un événement passé mais qui passe ici par le mime plus que par le langage, par l'image plus que par le son. Tout cela semble confirmer que ce qui fait la spécificité du langage humain, c'est bien de détacher le sens du son et du corps (de la présence), c'est le lexique plus que la syntaxe sans doute ainsi que le passage de l'impératif au récit (le mot chien n'aboie pas).

- L'essor des réseaux sans fil instantanés, p52

Comment assurer des communications en toutes circonstances, par exemple en cas de séisme majeur ? La solution réside dans des réseaux sans fil autonomes et dépourvus d'infrastructure fixe.

Ce qu'on appelle réseaux ad hoc sont des réseaux décentralisés (P2P) où les communications sont retransmises par les mobiles eux-mêmes, sans provider, donc. Une solution sans doute pour échapper à la censure et construire un réseau alternatif mais l'article aborde tous les problèmes que cela pose et qui sont loin d'être résolus, notamment pour les vidéos ou conversations en continue mais cela devrait être accessible pour les textes au moins.

- Suicide et immortalité quantiques

Jean-Paul Delahaye semble toujours aussi fasciné par les paradoxes et les idées fumeuses, réduisant les mathématiques à un jeu de l'esprit. Cela donne parfois des découvertes remarquables comme le théorème d'András Sárközy (sic!) sur l'ordre inévitable mais c'est assez rare. Ce qu'on peut reprocher, c'est un manque de rigueur qui écarte les objections et non l'audace supposée. Il faut le répéter, au contraire de ce qu'on croit, la folie est un excès de logique ("Le fou est celui qui a tout perdu sauf la raison", Chesterton).

Jean-Paul Delahaye semble toujours aussi fasciné par les paradoxes et les idées fumeuses, réduisant les mathématiques à un jeu de l'esprit. Cela donne parfois des découvertes remarquables comme le théorème d'András Sárközy (sic!) sur l'ordre inévitable mais c'est assez rare. Ce qu'on peut reprocher, c'est un manque de rigueur qui écarte les objections et non l'audace supposée. Il faut le répéter, au contraire de ce qu'on croit, la folie est un excès de logique ("Le fou est celui qui a tout perdu sauf la raison", Chesterton).

Lorsqu'il touche des sujets trop graves, le raisonnement semble outrepasser ses droits et apparaît intolérable. Aux yeux de certains, on n'est pas autorisé à jouer avec toutes les idées.

Il est absolument ridicule de prendre au sérieux l'interprétation des mondes multiples de la mécanique quantique introduite par Hugh Everett que l'expérience ne vérifie en rien mais dont l'intérêt est, là encore, uniquement critique, témoignant des limites de notre compréhension et du fait qu'elle est pour l'instant "irréfutable" (sans pouvoir être vraie). Se précipiter à croire à cette idée farfelue n'a rien de scientifique alors que cela devrait nous inciter à nous méfier de nos idées au contraire. Dire que cette théorie "gagne des partisans" est donc fallacieux, ce qui ne veut pas dire qu'elle n'a pas un noyau de vérité, évitant "l'effondrement" de la fonction d'onde, interprétée justement ce mois-ci comme la preuve qu'on vit dans un univers infini où les différentes possibilités se superposeraient (l'intégrale des chemins) et non dans une multiplication d'univers séparés. Théorie aussi douteuse mais qui témoigne du même problème. Tout cela n'empêche pas, au contraire, qu'on peut s'amuser à suivre les conséquences absurdes des mondes multiples, avec sa roulette russe quantique, à condition de ne pas faire mine d'y croire pour gruger son public. C'est un peu comme le pari de Pascal un rideau de fumée qui tient surtout à l'utilisation de l'infini, qui permet tout, effectivement, alors que notre existence se confronte à la finitude.

- Du sang bleu dans les veines ?, p90

C'est tout bête mais le sang n'est jamais bleu, il est toujours rouge, ce n'est donc pas parce qu'il est bleu que les veines nous apparaissent de cette couleur, mais par effet d'optique...

À travers la peau, nous voyons les veines bleues, alors que le sang est rouge : notre cerveau et l'interaction de la lumière avec la peau nous jouent des tours...

- Manque de dopamine et créativité

La molécule DRD2 est un récepteur neuronal qui assure la transmission de l'influx nerveux d'un neurone à l'autre.

Localisé à la surface des neurones, le récepteur DRD2 véhicule les effets cérébraux de la dopamine, une molécule souvent associée au plaisir ou à l'apprentissage. Quand la dopamine se fixe sur ses récepteurs DRD2, les neurones du thalamus inhibent les neurones du cortex préfrontal, situés à l'avant du cerveau, avec lesquels ils sont connectés.

Chez les personnes dont le thalamus renferme peu de récepteurs, le cortex préfrontal est moins inhibé que la moyenne des individus. Étant plus actif, il produit davantage d'idées.

La découverte ici, c'est le récepteur spécifique DRD2, mais on savait depuis longtemps que se dopaminer ne favorise pas la créativité mais la réalisation, il vaut mieux déprimer pour être créatif sauf que là, on ne réalise rien souvent...

Science&Vie no 1116, "Gravitation, elle ne serait qu'une illusion"

Science&Vie a été assez réactif puisqu'ils ont fait leur gros titre sur une théorie qui date du mois de janvier mais dont j'allais parler dans les brèves car le NYT avait attiré l'attention dessus en juillet et depuis elle fait parler d'elle. Leur titre est racoleur ("Gravitation, elle ne serait qu'une illusion") car, bien sûr, ce n'est pas une illusion, pas plus que la chaleur à laquelle elle serait comparable n'est une illusion d'être uniquement un phénomène macroscopique et non pas microscopique. Il serait plus juste de titrer : "La gravité, un retour à l'équilibre ?" mais Pour la Science s'était permis la même facilité en 2006 pour présenter La théorie holographique de la gravitation dont c'est la suite. Verlinde se situe effectivement dans la théorie holographique qui vient du fait que toute l'information d'un trou noir se trouve à sa surface, encodant en 2 dimensions un espace en 3 dimensions (ce qui serait confirmé par la supraconductivité), mais il en fait une interprétation plus thermodynamique que Juan Maldacena qui en est à l'origine en 1997, ou Leonard Susskind plus récemment.

"Comme en thermodynamique, la gravitation surgit de la tendance du système à retourner vers son état d'équilibre".

Une telle force, dite entropique, n'a pas d'autre raison d'être que la tendance à retourner vers ses configurations microscopiques les plus probables.

La gravité serait donc un effet émergent, effet de masse d'un retour à l'équilibre comme un élastique tendu revient à sa configuration initiale. Ce n'est pas tant la gravité qui serait une illusion que le Big Bang, l'expansion de l'univers n'étant qu'un retour à l'équilibre aussi. Il est intéressant que Ted Jacobson qui avait déjà déduit la théorie de la gravité d'Einstein de la thermodynamique avoue ne pas comprendre Verlinde. Parfois, c'est ne pas chercher à comprendre qui constitue un progrès et Verlinde pourrait être dans la même position par rapport à Jacobson que Einstein par rapport à Planck ou Poincaré.

Dans cette conception entropique de la gravité (qui est ici trop simple, pas assez élaborée) il y aurait un temps statistique, combinatoire qui nous mène à l'état de plus grande probabilité (tout en rendant de plus en plus probable les événements improbables et la complexification), mais qui n'est pas de même nature que le temps de la mécanique, vitesse ou accélération, bien que lié au déplacement des masses. Or, ce qui est curieux, c'est que la gravité puisse être assimilée à une accélération (dans un ascenseur), ce qui ne semble pas compatible avec cette théorie (de plus, je trouve qu'il y a trop de ressemblances entre la gravité et l'électromagnétisme pour que ce soit complétement autre chose, à moins que l'électro-magnétisme soit entropique aussi ?).

Ensuite, Science&Vie s'égare un peu, comme souvent, sur la notion d'information en confondant la carte et le territoire, le signifiant et le signifié, l'information en physique n'étant qu'un concept abstrait désignant une quelconque mesure physique. Il ne devrait pas y avoir une telle confusion entre le matériel et l'immatériel, les mots et les choses... La bonne interprétation est celle de Bohr, qui lui aussi refusait de devoir comprendre, s'opposant cette fois à Einstein : on n'a pas affaire au réel mais seulement à des informations sur lui, selon un très classique kantisme d'ailleurs.

Brèves et liens

Physique

cosmologie, astronomie, physique quantique

- Born in an Infinite Universe: a Cosmological Interpretation of Quantum Mechanics

Anthony Aguirre, Max Tegmark, David Layzer

Ce papier m'a semblé très intéressant bien que je n'y comprenne pas grand chose mais il arriverait à donner plus de cohérence à la physique quantique. Le cosmos infini expliquerait l'incertitude quantique et il n'y aurait pas vraiment effondrement de la fonction d'onde, ni des mondes multiples mais un seul monde avec des superpositions infinies...

Ce papier m'a semblé très intéressant bien que je n'y comprenne pas grand chose mais il arriverait à donner plus de cohérence à la physique quantique. Le cosmos infini expliquerait l'incertitude quantique et il n'y aurait pas vraiment effondrement de la fonction d'onde, ni des mondes multiples mais un seul monde avec des superpositions infinies...

Il y en a d'autres qui délirent sur le libre-arbitre. Ce n'est pas la première fois qu'on veut identifier l'incertitude quantique avec un libre-arbitre qui n'a aucune consistance, notion purement religieuse qui est identifiée par les physiciens à l'arbitraire du moment où ils font la mesure. La liberté est tout autre chose, liée à l'incertitude du monde et à notre manque d'information, rien à voir avec cette espèce de roulette russe !

- Une lentille gravitationnelle nous condamne à une expansion sans fin

L'analyse de la “distorsion gravitationnelle” a permis d'estimer une quantité d'énergie noire qui semble nous condamner à une accélération de l'expansion jusqu'à la mort thermique, réfutant une inversion cyclique menant à un Big Crunch.

Cependant l'énergie noire et l'expansion restent contestées, notamment parce que la conservation de l'énergie serait violée (peut-être pas, voir plus haut), l'hypothèse ayant déjà été faite que cette illusion d'optique pourrait venir du fait que nous sommes dans une région relativement vide d'un univers plus vaste. Ce que viennent d'ajouter des chercheurs, c'est que cela pourrait expliquer le manque de lithium constaté, déduction contestable d'expliquer une erreur par une autre.

- La "constante de structure fine" varie selon la direction de l'espace examinée !

A relier à la brève précédente mais encore plus étonnant : de nouvelles données semblent indiquer que la "constante de structure fine" (interaction entre électron et photon) varie selon la direction de l'espace examinée, ce qui est difficile à avaler et pourrait là aussi être lié à un mauvais calibrage des instruments de mesure ou serait-ce la détection d'un mouvement dans l'éther ? Une des conséquences si cela se vérifie (ce qui est tout de même très improbable), c'est que les conditions de la vie ne seraient réunies que dans notre zone d'espace, expliquant le paradoxe de Fermi, nous serions vraiment seuls dans l'univers. On est pris de vertige...

- Explorer l'époque de réionisation de l'Univers

L'Univers est entré dans un âge sombre, juste après que les atomes d'hydrogène se soient recombinés, et avant que les premières sources (étoiles et quasars) puissent se former et envoyer leur première lumière. Cette lumière a commencé à réioniser l'hydrogène, d'abord autour des sources, puis progressivement l'Univers entier s'est réionisé. Cette époque de réionisation est estimée durer entre les redshifts de 12 à 6 (ou quand l'Univers avait entre 3 et 7 pourcents de son âge). Observer la raie émise par l'hydrogène à 21cm, décalée vers les longueurs d'onde métriques, pendant cette époque, permettra d'étudier la formation des premières structures de l'Univers. Les astronomes de l'observatoire de Paris ont prédit le signal à 21cm par des simulations numériques, traitant le transfert radiatif avec moins d'approximations que les travaux précédents. Ils prouvent que le signal serait plus fort et plus facile à observer au début de l'époque.

En utilisant le VLT de l’ESO, une équipe d’astronomes européens a pu démontrer pour la première fois qu’un magnétar – un type rare d’étoile à neutrons – a été formé à partir d’une étoile ayant une masse d’au moins 40 fois celle du Soleil. Ce résultat représente un véritable défi pour les théories en vigueur sur l'évolution des étoiles puisqu’une étoile aussi massive était supposée devenir un trou noir et non un magnétar. Ce résultat soulève donc une question fondamentale : quelle masse doit réellement avoir une étoile pour devenir un trou noir ?

- Un système solaire à 127 années lumière

Avec au moins 5 planètes, ce système solaire semble assez semblable au nôtre pour qu'on y trouve une Terre favorable à la vie, peut-être, à une distance qui reste astronomique mais on n'est qu'au début de la recherche d'exoplanètes qu'on peut imaginer atteindre par étapes un jour, permettant de rêver à la colonisation d'autres systèmes solaires si chère à Stephen Hawking, bien qu'on ne soit pas fait pour de longs voyages dans l'espace, le mollet, notamment étant gravement affecté par l'apesanteur.

Par ailleurs, on a trouvé à 100 années lumières une étoile ayant un cycle d'activité magnétique semblable à celui du soleil.

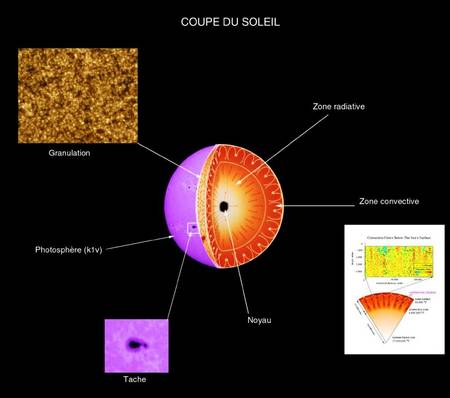

- Le soleil plus vieux de 2 millions d'années

Pour la chondrite du Sahara, les deux horloges donnent le même résultat. Et recule un peu l’âge du système solaire, qui serait donc de 4,5682 milliard d’années.

La différence n’est pas anecdotique pour les astrophysiciens qui tentent de comprendre dans quelles circonstances est né le Soleil. L’un des éléments clefs de cet environnement primitif est le fer-60, un isotope radioactif dont la demi-vie est de 2,6 millions d’années. Cela signifie, pour un échantillon donné, qu’il perd la moitié de son fer-60 au bout de cette période.

Repousser la naissance du système solaire de presque deux millions d’années revient donc à ajouter pas mal de fer dans son berceau. Ce qui confirmerait l’idée selon laquelle des supernovae ont explosé au moment où se formait le Soleil, ces explosions d’étoiles géantes en fin de vie sont en effet réputées pour leur capacité à injecter d’importantes quantités de fer dans leur environnement.

Voir aussi Futura-Sciences.

- De la matière noire dans le Soleil ?

Selon deux chercheurs de l’Université d’Oxford, la matière noire pourrait montrer indirectement sa présence juste sous nos yeux, en influençant la structure du Soleil. Elle permettrait de résoudre le « problème de la composition solaire » découvert grâce à l’héliosismologie.

Les grandes plaines lisses du Nord de la planète rouge ne sont pas les vestiges d'un ancien océan. Et la plupart des traces d'écoulement visibles en surface ne sont pas liées à un cycle de l'eau. Ce sont juste les témoins de la fonte soudaine de glace résiduelle piégée en sous-sol. Ces événements auraient été provoqués par des remontées de lave voici 3,6 milliards d'années.

L'époque où l'eau coulait en abondance sur Mars aurait été bien plus courte qu'on ne le pensait. Il y a 4,1 milliards d'années, la planète avait déjà perdu ses étendues liquides.

Un océan global a malgré tout bel et bien existé sur Mars. En de rares endroits, l'instrument Omega a permis d'en découvrir la signature minéralogique, sous la forme d'argiles (ou phyllosilicates). L'astrophysicien explique :

« Les terrains martiens où affleurent ces phyllosilicates sont sans doute notre meilleur espoir, dans tout le système solaire, d'obtenir un témoignage sur les conditions d'apparition de la vie. »

- La Lune a perdu 100m de diamètre !

- Nous sommes cernés par les astéroïdes

Cette vidéo montre 30 ans de détection des astéroïdes du système solaire. Au début il y en a peu mais avec les nouvelles méthodes, ces cailloux se sont multipliés (sur la fin de la vidéo), les plus dangereux étant en rouge.

- Une poche de magma originel datant de 4,5 milliards d'années

C'est dans l'île de Baffin, au nord du Canada, qu'on a trouvé cette poche épargnée par la tectonique des plaques depuis l'origine !

« Dans notre modèle, une croûte primitive a été formée par la solidification de l'océan de magma. Instable à la surface de la Terre parce qu'elle était riche en fer, elle a fini par couler, emportant des éléments incompatibles avec elle jusqu'à la base du manteau, où certains vestiges demeureraient aujourd'hui. »

- Un switch sans interaction grâce à l'effet Zenon

L'effet Zenon, c'est qu'à observer une particule quantique, on la fige. En maintenant l'observation on empêche donc un état de changer et en arrêtant l'observation, il change. Nouvelle méthode qui aura des applications.

- Des bits quantiques alliant métal et semi-conducteur

Comment manipuler les spins pour transporter une information de façon fiable ? Min Ouyang et ses collègues, à l'Université du Maryland, ont proposé une solution. Ils ont élaboré des nanostructures constituées de métal et de semi-conducteur, dans lesquelles on peut, via une interaction entre lumière et matière nommée effet Stark optique, manipuler le spin des électrons de la couche semi-conductrice.

Ces structures sont des nanobilles de métal recouvertes d'une coquille de matériau semi-conducteur. Des paires électron-trou, nommées excitons, peuvent se former dans le semi-conducteur, par exemple quand un électron absorbe un photon d'un rayonnement incident ; leur énergie correspond à la hauteur de la « bande d'énergie interdite » du semi-conducteur. Des oscillations de charge apparaissent à l'interface avec le noyau métallique : ce sont les plasmons de surface, des ondes de densité d'électrons auxquelles sont soumis les électrons libres à l'interface du semi-conducteur et du métal.

Grâce à ce système, l'équipe du Maryland a étudié l'effet Stark optique, qui se produit lorsque le champ électrique de l'onde lumineuse incidente est comparable aux champs électriques qui lient les électrons aux noyaux atomiques, et ce qui peut alors modifier les états quantiques de ces électrons (dont leur spin).

En contrôlant la fréquence et l'intensité de la résonance, les physiciens maîtrisent l'effet Stark optique et peuvent ainsi manipuler le spin porté par les électrons de la couche semi-conductrice. Cerise sur le gâteau, la méthode utilisée pour confectionner l'interface métal/semi-conducteur monocristallin est simple à mettre en œuvre et peu coûteuse ; elle est en attente de brevet.

- Une nano-antenne rend les photons directionnels

Il s'agit d'une sorte de nano-antenne tv en or mais dont les applications peuvent être importante en cryptographie, en informatique quantique, etc.

Il ya d'autres façons de rediriger des photons avec des dispositifs simples. Une façon consiste à mettre des points quantiques dans des cavités afin que la lumière ne puisse s'échapper que dans une seule direction. Mais l'utilisation de nano-antennes devrait être plus efficace car elle permet de détecter beaucoup plus de photons.

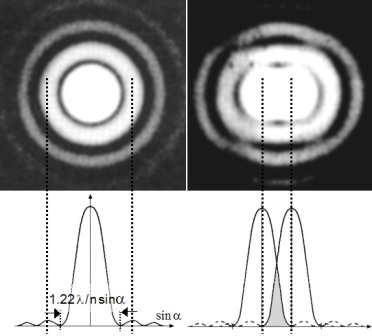

- Les microscopes optiques passent de 200 à 0,5 nanomètres

Jusque-là, la résolution d'un microscope optique semblait irrémédiablement limitée à 200 nanomètres. En utilisant des capteurs CCD, le prix Nobel Steven Chu vient pourtant d’obtenir des images de molécules avec une résolution de l’ordre 0,5 nanomètre.

Pour obtenir cette résolution, les chercheurs utilisent un système adaptatif de contre-réaction qui optimise la formation d’une image sur le capteur CCD, malgré la non-uniformité de la capacité de détection des grains de lumière par les pixels de la plaque du capteur.

- Les fractales, une clé de la supraconductivité à haute température ?

Dans la quête d'explication pour l'énigmatique supraconductivité à haute température critique, un élément inattendu vient d'être découvert grâce aux rayons X de l’ESRF à Grenoble. Une structure fractale joue un rôle dans la température de transition de phase de certains cuprates supraconducteurs.

Antonio Bianconi, de l'Université de Rome La Sapienza, a en effet exposé, avec ses collègues, un échantillon d'oxyde mixte de cuivre et de lanthane supraconducteur aux rayons X générés à l'European Synchrotron Radiation Facility (ESRF).

Des zones d’ordres et de désordres au niveau de la distribution des atomes d'oxygène ont alors été découvertes, avec des motifs se répétant à plusieurs échelles, de façon similaire à ceux des fractales, comme l’ensemble de Mandelbrot. Ces structures se manifestaient par une certaine loi de puissance décrivant l’intensité de la lumière diffractée. Or, plus cette loi de puissance se rapprochait de celle que l’on attend d’une structure fractale pour un échantillon d’oxyde considéré, plus la température critique de celui-ci était élevée.

- Des mémoires en plastique grâce à la spintronique

Un groupe de chercheurs de l’Ohio State University a réussi à construire une mémoire d’ordinateur en plastique. Basée sur la toute nouvelle spintronique, une telle mémoire est plus petite et moins gourmande en énergie. Surtout, elle pourrait être incorporée à des dispositifs électroniques originaux, comme des écrans souples.

Epstein et ses collaborateurs ont donc réussi à utiliser pour stocker des données un polymère semi-conducteur magnétique, le tetracyanoethanide de vanadium. Ce matériau est d’ailleurs le premier aimant organique fonctionnant à température ambiante. On peut transférer sur lui des électrons et les orienter dans un sens avec un faible champ magnétique. Les électrons peuvent alors passer dans une couche de matériau ferromagnétique classique, mais seulement si le spin des électrons y est orienté de la même manière. Ainsi, on peut lire des données juste en déterminant si la résistance est faible (les électrons passent facilement) ou élevée (le transfert de charges est très limité). C’est exactement ce qu’il faut pour réaliser des dispositifs spintroniques légers, économes et flexibles.

- Le contrôle de l'effet piézoélectrique des boites quantiques

Un point quantique présente un diamètre d’à peine dix à 15 atomes, soit moins de dix nanomètres. En comparaison, le diamètre de la double hélice de l’ADN fait deux nanomètres. Les chercheurs mcgillois ont découvert une nouvelle manière de faire en sorte que les charges individuelles demeurent à la surface du point, ce qui produit un vaste champ électrique au sein du point. Ce champ magnétique produit d’énormes forces piézoélectriques, entraînant une expansion et une contraction importantes et rapides des points en une picoseconde ou moins. De plus, l’équipe est capable de maîtriser l’ampleur de cette vibration.

Les points quantiques de séléniure de cadmium peuvent être utilisés dans une vaste gamme d’applications technologiques. L’énergie solaire est un des secteurs explorés, mais cette nouvelle découverte ouvre la voie à d’autres applications dans des appareils à l’échelle nanoscopique. Elle permet de maîtriser la vitesse et le temps de commutation des appareils nanoélectriques, voire de mettre au point des sources d’alimentation nanoscopiques, grâce auxquelles une petite compression produirait une tension élevée.

Par exemple, on peut analyser les vibrations d’un matériau pour calculer la pression du solvant dans lequel elles se trouvent. Grâce à des mises au point et des recherches plus avancées, peut-être pourra-t-on mesurer la tension artérielle de manière non invasive, en injectant des points, en y dirigeant un laser et en analysant leur vibration pour déterminer la tension.

- On pourra bientôt communiquer par ondes avec des mineurs à 500m de profondeur

Nikola Tesla avait proposé d’utiliser les variations lentes du champ magnétique générées par un électro-aimant. Ayant concrétisé un dispositif de ce genre en 1890, il dut se rendre à l’évidence. La portée des ondes ainsi générées, essentiellement magnétiques, et le bruit accompagnant inévitablement le signal produit, rendaient le concept impraticable.

Le signal à basses fréquences obtenu a franchi 500 mètres de roches et les techniques moderne de traitement du signal utilisé pour les téléphones portables ont permis de contourner l’obstacle du bruit rencontré par Tesla.

Le système peut fonctionner pendant 24 heures avec une simple batterie de 12 volts et il permet de transmettre aussi bien la voix que des textes tapés au clavier. Le système MagneLink est en cours de certification et il devrait donc équiper plusieurs mines aux Etats-Unis dans un avenir proche.

Climat

Climat, écologie, énergies

- Le rapport de l'ONU sur le GIEC est très critique

Voir notamment les conclusions qui préconisent un complet changement d'organisation et de fonctionnement dont il faut se réjouir, avec plus de transparence et de séparation entre l'activité scientifique et de lobbying politique, insistant notamment sur la marge d'erreur. Cela ne remet pas en cause le résultat de leurs travaux ni leur honnêteté scientifique mais devrait renforcer la fiabilité et la confiance dans l'institution. Voir aussi Futura-Sciences.

Voir notamment les conclusions qui préconisent un complet changement d'organisation et de fonctionnement dont il faut se réjouir, avec plus de transparence et de séparation entre l'activité scientifique et de lobbying politique, insistant notamment sur la marge d'erreur. Cela ne remet pas en cause le résultat de leurs travaux ni leur honnêteté scientifique mais devrait renforcer la fiabilité et la confiance dans l'institution. Voir aussi Futura-Sciences.

- Le climat responsable de la disparition des mammouths, pas l'homme

Le débat se poursuit sur l'impact de l'homme. On ne peut ignorer que les grands mammifères ont disparu partout où l'homme a émigré mais bien sûr l'action de l'homme n'est délétère que lorsqu'elle va dans le même sens que les tendances naturelles. Il est déraisonnable de penser que l'homme à lui seul puisse être la cause de toutes ces extinctions, le rôle du climat est essentiel, mais il est certain qu'il y a participé et on peut l'accuser d'avoir achevé la bête, sinon les mammouths auraient dû disparaître bien avant ! Cette étude est un peu l'envers de la précédente qui expliquait l'extension des forêts par la disparition des grands mammifères alors qu'ici, c'en serait la cause...

Le débat se poursuit sur l'impact de l'homme. On ne peut ignorer que les grands mammifères ont disparu partout où l'homme a émigré mais bien sûr l'action de l'homme n'est délétère que lorsqu'elle va dans le même sens que les tendances naturelles. Il est déraisonnable de penser que l'homme à lui seul puisse être la cause de toutes ces extinctions, le rôle du climat est essentiel, mais il est certain qu'il y a participé et on peut l'accuser d'avoir achevé la bête, sinon les mammouths auraient dû disparaître bien avant ! Cette étude est un peu l'envers de la précédente qui expliquait l'extension des forêts par la disparition des grands mammifères alors qu'ici, c'en serait la cause...

Après le bon coup de froid dû à la dernière période glacière qui a eu lieu il y a plus de 20 000 ans, il y a eu moins de nourriture disponible pour les mammouths. Avant cela, il était fréquent de trouver des mammouths laineux un peu partout en Europe. Ensuite, ils se sont regroupés vers le nord de la Sibérie il y environ 14 000 ans de cela pour que l'espèce finisse par s'éteindre il y a 4 000 ans environ.

Les conditions froides et sèches de la dernière glaciation et la réduction de la concentration en CO2 n'a pas favorisé la croissance des arbres. Il est donc apparu beaucoup de petites végétaux (au lieu de grandes étendues de forêts) : ces petits végétaux étaient intéressants pour les grands herbivores. Lorsque le climat est devenu plus chaud et humide, les arbres ont pris la place des pâturages et il n'y eu plus assez à manger.

- Un été 2010 exceptionnellement chaud selon les données spatiales

L’été 2010 aura été marqué par des événements météorologiques d’une rare violence qui ont affectés de nombreuses régions de la planète. La carte mondiale des températures pour le mois de juillet permet de mieux comprendre la répartition de ces catastrophes naturelles.

En détails, cela donne une température moyenne en Europe orientale, supérieure de 5 degrés aux moyennes historiques. L'Est des États-Unis a également connu une vague de chaleur inhabituelle mais pas aussi grave que dans certaines parties de l'Eurasie. D’autres régions de la planète, comme le Groenland et le nord-ouest du Pacifique, ont dû composer avec des températures très élevées.

En revanche, d'autres régions du globe ont connu des températures plus basses que la normale, notamment en Asie centrale et en Amérique du Sud. Des pays comme l’Argentine ont été confrontées à des vagues de froid sans précédent avec d’abondantes chutes de neiges et des températures diurnes négatives. Enfin, dans la majeure partie de l'Antarctique orientale, les températures ont été inférieures à la normale, même si la péninsule a connu, elle, un épisode moins froid.

Le “minimum solaire” a été atteint en décembre 2008. Le dernier cycle solaire a duré le record de 12.6 ans. C'est la durée la plus longue depuis presque 200 ans. La moyenne des cycles est typiquement de 10.7 ans. Cette particularité serait due à un courant de plasma qui transporte le plasma de la surface vers le pôle. Ensuite, le plasma s'enfonce vers le coeur du soleil avant de remonter vers l'équateur. Lors des cycles précédents, ces courants de plasma ne s'étendaient que sur les deux tiers du chemin. Cette dernière fois, le courant de plasma a réalisé le chemin complet jusqu'aux pôles. D'autres spécialistes pensent que ce n'est pas l'étendue du courant qui compte, mais sa vitesse : on a enregistré des vitesses records depuis 5 ans.

Par ailleurs, le refroidissement solaire des années 2007-2009 a provoqué une étonnante contraction de la "thermosphère" située entre 90km et 500km qui s'est refroidie de 23° et contracté de 30% !

- Incendies en Russie liées aux inondations au Pakistan

Les deux événements sont très distants, mais ils pourraient bien avoir la même base. Le lien serait la mousson asiatique, car il s'agit d'une des plus grandes forces atmosphériques de la planète. La mousson est un processus saisonnier de vents qui amènent de la pluie et des crues au Pakistan et dans d'autres pays asiatiques lors de l'été. Cela conduit également les masses d'air jusqu'en Europe.

L'air aspiré depuis la haute atmosphère par les vents de la mousson doit redescendre quelque part. La plus grande partie de cet air s'installerait au-dessus de la Russie. Cela créé des conditions de haute pression qui favorisent les vagues de chaleur et engendre l'absence de nuages.

- Un immense iceberg se sépare du Groenland

Plusieurs satellites, dont Envisat, ont photographié la rupture du grand glacier Petermann, au Groenland, et le début de la dérive d'un iceberg géant de 245 kilomètres carrés.

Par ailleurs, on a découvert du pétrole près du Groenland

- Des bactéries nettoient la marée noire provoquée pa BP

Comme on l'avait dit le mois dernier, la catastrophe n'est pas aussi importante qu'on a pu le craindre, notamment grâce à des bactéries friantes de pétrole.

Comme on l'avait dit le mois dernier, la catastrophe n'est pas aussi importante qu'on a pu le craindre, notamment grâce à des bactéries friantes de pétrole.

Dans les échantillons contaminés, les bactéries seraient deux fois plus nombreuses que dans les échantillons d’eau saine. Mais ce ne sont pas n’importe quelles bactéries : les gènes retrouvés et analysés démontrent qu’ils appartiennent majoritairement à une espèce de gamma-protéobactéries psychrophiles (qui aiment les eaux froides) des fonds marins encore inconnue jusqu’ici. Ces organismes, proches des bactéries Oleispirea antarctica et Oceaniserpentilla haliotis connues pour leur appétit pour le pétrole, contribueraient fortement à la diminution de la masse de brut dispersée.

Les fonds marins seraient aussi dans un état bien meilleur qu'attendu. Les dégâts sont toutefois à déplorer sur les côtes de la Louisiane où déjà plus de 1.000 tortues, 70 mammifères marins et 4.000 oiseaux ont été retrouvés morts.

- Du gaz et du pétrole en Méditerranée

L'Est de la Méditerranée renfermerait d'énormes quantités de pétrole et de gaz. Problème : les eaux ne sont pas clairement délimitées, et trois pays, le Liban, Israël et Chypre, revendiquent leur souveraineté sur la totalité des réserves, ou au moins sur une part du gâteau.

L'annonce faite par la compagnie américaine Nobel Energy sur la présence de 453 milliards m3 de gaz au large d'Israël a suscité de vives craintes et menaces dans la région, chaque partie entendant faire respecter sa souveraineté et ne pas se faire spolier par le voisin.

- L'Australie alimentée à 100% par du renouvelable d'ici 10 ans ?

Tout est faisable avec des technologies actuellement disponibles. 98% des besoins énergétiques pourraient être atteints avec l'énergie éolienne (40 %) et l'énergie solaire (par concentration et stockage dans du sel fondu) pour le reste. Cela pourrait créer 80 000 emplois pour la création des installations et 45 000 pour le suivi et la maintenance.

La Grande-Bretagne vise 2030 pour le zéro-carbone, ce qui est plus raisonnable bien qu'encore optimiste...

- Convertir la chaleur en électricité solaire

En se servant de la chaleur pour faciliter l'expulsion d'électrons, on arrive à convertir 50% de l'énergie solaire en électricité alors que le photovoltaïque n'arrive qu'à 15%. De plus les matériaux sont bien moins chers.

- L'hygroélectricité pour faire de l'électricité avec l'humidité de l'air

Ce n'est pas pour tout de suite, mais c'est assez génial permettant de prendre le relais du solaire quand il ne fait pas beau, et même d'éviter les orages peut-être !

Fernando Galembeck, de l'Université de Campinas au Brésil, vient de montrer que la vapeur d'eau dans l'air humide peut se charger en électricité et la transférer aux matériaux avec lesquels elle entre en contact. Il affirme qu'il devrait être possible de concevoir des capteurs qui exploitent ce comportement pour générer de l'électricité. La technologie, qu'il qualifie de "hygroelectricity" pourrait constituer une alternative à l'énergie solaire dans des endroits sans lumière du soleil mais avec beaucoup d'humidité. On pourrait s'en servir aussi pour empêcher les coups de foudre, selon lui, en vidant l'air de son électricité.

- Des catalyseurs 10 000 fois plus efficaces avec un laser

Le méthane, mélangé à de la vapeur d’eau, se transforme en hydrogène et en CO2 au contact d’une surface de nickel. Avec un puissant laser, les chimistes on pu exciter et orienter les molécules de gaz – un peu comme avec un joystick. Surprise: le procédé démultiplie l’efficacité de la réaction. «L’amélioration est impressionnante, commente Rainer Beck, en charge du projet à l’EPFL. Avec le laser, la rapidité de la catalyse est augmentée par un facteur allant de 1000 à 10 000 !»

La transformation du méthane présente un grand intérêt environnemental. En effet ce gaz, massivement utilisé comme combustible, dégage une importante quantité de CO2. «Nous pourrions imaginer le transformer sur les sites de captage, ce qui nous permettrait alors de capter le CO2 à la source et de nous servir de l’hydrogène, un combustible qui ne rejette que de l’eau.» Le procédé mis au point à l’EPFL ne peut pas s’appliquer à une échelle industrielle. Mais les travaux de Rainer Beck laissent entrevoir de futures améliorations.

- Une hydrolienne géante en Ecosse

- L'eau en poudre pour stocker le CO2

Au 240e colloque national de l’American Chemical Society, des chimistes britanniques ont présenté les derniers résultats sur un matériau bien singulier : l’eau sèche. Poudreuse, constituée de 95% d’eau, cette substance paraît prometteuse comme piège à CO2 et pour transporter des matières dangereuses.

Ce n’est pas une blague de 1er avril, l’eau sèche existe bel et bien et elle a même été découverte une première fois en 1968 avant de l’être à nouveau en 2006 par des chercheurs britanniques de l’Université de Hull.

Il s’agit en fait de minuscules gouttelettes d’eau enrobées de silice et qui se présentent comme une poudre ressemblant au sucre. Tout comme l’aérogel qui est constitué principalement d’air, l’eau sèche (dry water en anglais) contient 95% d’eau.

Ils ont d’abord montré que l’eau sèche pouvait absorber une quantité non négligeable de méthane et donc servir à stocker et transporter du gaz naturel. Le méthane est en général transporté soit après refroidissement à -113 °C, soit sous une pression d’environ 500 bars. Mais il se combine à l’eau sèche à seulement -70°C.

Puis les chimistes ont découvert que l’eau sèche pouvait stocker aussi du CO2, jusqu’à 3 fois plus que de l’eau ou de la silice normales. Pour eux, elle constituerait donc un bon moyen pour réaliser des puits à carbone afin de limiter le réchauffement climatique. On pourrait même piéger d’autres gaz gênants libérés par l’industrie.

- Des enzymes de plantes parasites pour des biocarburants

Lors du processus d'infestation des cellules de la plante hôte par la plante parasite, cette dernière utilise certaines enzymes particulières qui "décomposent les parois végétales de la plante hôte avec une grande efficacité et permettent à la plante parasite d'établir des suçoirs pour pomper eau et nutriments", indique Krause qui estime que "ces enzymes pourraient faciliter le processus de décomposition et que des biocarburants pourraient être produits à partir de mauvaises herbes, à basse température et avec un procédé moins énergivore".

- Les écosystèmes tropicaux seraient gravement menacés

D'ici à la fin du siècle, les forêts tropicales auront été en grande partie détruites : il n'en restera plus qu'un tiers en Amérique du Sud et 30% en Afrique. Quant au nombre d'espèces qu'elles abritent, il sera amputé de 80%. C'est ce que prédit la première étude quantitative de l'effet possible des changements climatiques sur la biodiversité. La menace qui pèse ainsi sur l’Homme est, elle, inconnue.

De plus, le froid a été la cause d'une hécatombe animale sans précédent dans l’Amazone.

Vingt ans de mesures des déchets en plastique dans l'Atlantique nord montrent que la quantité est élevée... mais il en manque. Ou bien les humains gèrent de mieux en mieux leurs déchets, ou bien cette pollution part se camoufler en des endroits inconnus des scientifiques, peut-être, par exemple, le tube digestif d'animaux marins.

Un fait est troublant : les quantités pêchées sont à peu près stables depuis vingt ans. Or la production de déchets a, elle, augmenté. Pourquoi n'observe-t-on pas la même tendance à la surface et au sein des masses d'eau atlantiques ?

Les morceaux de plastique peuvent se fragmenter jusqu'à atteindre des tailles minuscules, voire microscopiques, donc devenir insaisissables par un filet... mais pas par les organismes filtreurs du plancton qui pourront donc en ingérer. Ils peuvent aussi finir par se fixer sur des organismes marins et, après la mort de leur porteur, couler avec lui pour se fondre dans le sédiment marin.

Des observations antérieures montrent bien que le plastique peut disparaître à nos yeux tout en continuant à polluer l'océan. En 2004, Richard Thompson, de l'Université de Plymouth (Royaume-Uni), avait fait sensation en publiant les résultats d'une étude sur 20 plages britanniques montrant la présence de fragments de matière plastique de toutes tailles, jusqu'à 20 microns. Etendue en 2006 à différentes régions du globe, sur plusieurs continents, l'étude s'est conclue par des résultats similaires. En 2009, Katsuhiko Saido, chimiste de l’Université Nihon (Chiba, Japon), avait démontré que les polymères peuvent se dégrader dans l'océan, contrairement à ce que l'on croyait. Cette transformation chimique conduit au bisphénol A (BPA) et à l'oligomère PS (la brique élémentaire du polystyrène), deux produits qui ne sont pas sans effet sur les organismes vivants.

- De la viande artificielle pour nourrir les gens en 2050

Un rapport récent a fait l'état des lieux concernant les terres disponibles : on en trouve de moins en moins. Les fermiers auront donc du mal à satisfaire la demande à partir de 2050. Une première solution serait la viande artificielle en cuve et l'autre solution consiste à utiliser les nanotechnologies qui seraient le vecteur privilégié pour délivrer les médicaments au bétail.

Biologie

évolution, génétique, biodiversité, éthologie, anthropologie, neurologie

- Réseaux différents pour prédateurs ou pollinisateurs

Un des intérêts de cette étude est de montrer que l'architecture des réseaux est différentes pour les prédateurs et les pollinisateurs : cloisonné pour les prédateurs qui défendent leur territoire, et emboîté pour les pollinisateurs coopératifs. Cela démontre qu'il y a une pluralité de systèmes et de logiques cohabitant sur le même territoire, différents types de réseaux et 2 façons d'être solidaires dans la stabilisation d'un écosystème par les rapports de force et la circulation de l'information. Il ne faut donc pas trop généraliser ni croire qu'on pourrait vivre dans un système unifié (totalitaire).

Un réseau trophique se définit comme l'ensemble des relations alimentaires entre espèces au sein d'une communauté et par lesquelles l'énergie et la matière circulent.

Un réseau mutualiste se définit comme l'ensemble des relations à bénéfice réciproque entre les espèces d'une communauté.

L'architecture des réseaux favorisant la stabilité des communautés écologiques diffère fondamentalement entre les réseaux trophiques ("qui mange qui") et les réseaux mutualistes ("qui pollinise qui"). Leurs résultats théoriques concluent que, pour être stables, les réseaux d'interactions mutualistes doivent présenter une architecture emboitée alors que les réseaux trophiques doivent adopter une architecture compartimentée. Cette différence d'architecture se retrouve dans un grand nombre de réseaux empiriques de pollinisation (mutualiste) et d'herbivorie (trophique).

Une architecture compartimentée indique qu'un réseau est organisé en plusieurs groupes d'espèces interagissant davantage au sein des groupes qu'entre groupes (figure ci-dessus), alors qu'une architecture emboitée indique qu'un réseau est organisé autour d'un seul groupe d'espèces généralistes interagissant entre elles et avec les espèces plus spécialistes (figure ci-dessus). Quant à la stabilité d'une communauté (c'est-à-dire l'ensemble des espèces du réseau), elle caractérise la capacité de la communauté à résister aux perturbations.

Une architecture compartimentée indique qu'un réseau est organisé en plusieurs groupes d'espèces interagissant davantage au sein des groupes qu'entre groupes, alors qu'une architecture emboitée indique qu'un réseau est organisé autour d'un seul groupe d'espèces généralistes interagissant entre elles et avec les espèces plus spécialistes (figure ci-dessus). Quant à la stabilité d'une communauté (c'est-à-dire l'ensemble des espèces du réseau), elle caractérise la capacité de la communauté à résister aux perturbations.

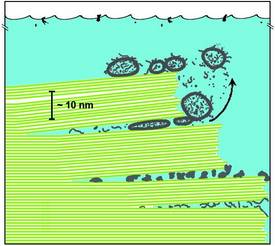

Schéma montrant des biomolécules piégées entre des feuilles de mica dans un océan primitif. Les lignes vertes représentent des feuilles de mica et les structures grises représentent diverses molécules biologiques anciennes et des vésicules de lipides. D'après l'hypothèse reposant sur le mica, le va-et-vient de l'eau entre les feuillets peut déplacer de haut en bas. Ces mouvements et l'énergie associée pourraient avoir forcé les molécules biologiques ou des acides gras à former des cellules.

En 2007, Helen Hansma, de l’Université de Santa Barbara en Californie, proposait que l’apparition des premières cellules vivantes avait eu lieu entre des feuilles de mica. Elle a continué à développer sa théorie et vient de publier un article de fond sur le sujet dans le numéro de septembre 2010 du Journal of Theoretical Biology.

C’est en partie par hasard qu’Helen Hansma en est venue à postuler un monde de mica qui aurait précédé un monde à ARN.

Prise de passion pour ce minéral dont les feuillets ne sont épais que d'un nanomètre d’épaisseur environ, elle finit par observer un détail intriguant dans plusieurs échantillons qu’elle avait collectés dans une mine du Connecticut. La surface de certains des feuillets de mica était couverte de molécules organiques.

Elle s’est alors souvenue que l’ARN et le mica, tout comme beaucoup de protéines et de lipides, possèdent des charges négatives. Or, les groupes phosphates de l’ARN sont espacés d’un demi-nanomètre, exactement la distance séparant les charges négatives sur le mica. Mieux, les feuillets de mica sont riches en potassium avec une concentration très similaire à celle de nos cellules.

- Un switch pour produire ou non une protéine

On n'est plus obligé de détruire un gène pour empêcher l'expression d'une protéine, on peut bloquer sa production et la reprendre ensuite à la demande, selon des méthodes proches des régulations génétiques constituées d'inhibitions et d'inhibitions de l'inhibition, etc. C'est un progrès important.

On n'est plus obligé de détruire un gène pour empêcher l'expression d'une protéine, on peut bloquer sa production et la reprendre ensuite à la demande, selon des méthodes proches des régulations génétiques constituées d'inhibitions et d'inhibitions de l'inhibition, etc. C'est un progrès important.

Le commutateur est créé par des séquences d'ADN qui peuvent être ajoutées à n'importe quel gène et qu'un bioingénieur veut contrôler. Lorsque la cellule entame la première étape de l'expression de ce gène - produire une molécule intermédiaire d'ARN qui peut être «lue» pour produire la protéine en cause - il crée également l'interrupteur de l'ARN. Lorsque le premier, ARN "off" est produit, il verrouille le ribosome, l'empêchant de fabriquer cette protéine particulière. Lorsqu'on fabrique le deuxième, c'est le switch "on" qui est produit qui se lie au premier ARN, l'interrupteur, libérant ainsi le ribosome qui peut en reprendre la production.

- Une nouvelle forme de vie au fond du lac Baïkal

"Nous avons l'impression qu'il s'agit d'une nouvelle forme de vie, jamais découverte auparavant. Elle se présente sous la forme de boules de 1 à 3 cm de diamètre remplies de composés organiques morts. Il est très probable qu'il s'agit d'une colonie de microbes inconnus", a indiqué le chercheur.

Ces organismes vivent au fond du lac à proximité des sorties de méthane. "Il est très probable qu'ils se nourrissent de méthane".

- Nouvelle technique de microscopie dynamique de la cellule

La technique permet d'enregistrer plusieurs dizaines de milliers de trajectoires de molécules uniques sur une seule cellule et d'en étudier la dynamique à l'échelle nanométrique. Les chercheurs ont démontré son efficacité sur divers systèmes cellulaires (cellules hétérologues, fibroblastes ou neurones en cultures) pour étudier différentes molécules membranaires. La simplicité, l'adaptabilité et la fiabilité de cette nouvelle méthode permettent d'ores et déjà d'envisager un grand nombre d'études inaccessibles jusqu'alors par la microscopie optique conventionnelle. En particulier, il devient possible de "filmer" l'évolution d'une seule cellule, par exemple un neurone, avec une résolution spatiale de 50 nanomètres pour une cadence d'imagerie correspondant à celle de la vidéo (20 images pas seconde). Les chercheurs bordelais ont déjà entamé l'étude de la structuration dynamique des récepteurs de neurotransmetteurs dans les synapses de neurones vivants.

- Stresser les légumes pour produire plus d'anti-oxydants

Certaines études avaient montré que la sécheresse et autres contraintes stressantes pouvaient stimuler l'accumulation de composants plus riches en polyphénols. Les chercheurs ont donc cherché les processus mécaniques pouvant appliquer un stress aux végétaux : ultrasons et chocs électriques par exemple. Les traitements par chocs électriques (chocs de 15 V durant 10, 20 ou 30 minutes) ont permis de doubler les niveaux de certains antioxydants. Cinq minutes de traitement par ultrasons ont permis d'accroître l'activité des antioxydants de 1.5 fois et le contenu en polyphénols de 1.2 fois.

- Le cancer commence avec les éponges dont les organismes pluricellulaires descendent

Les éponges sont les premiers organismes pluricellulaires connus jusqu'ici et avec lesquelles tous les animaux partagent 4670 gènes, dont 1286 nous distinguent des unicellulaires, permettant la communication entre cellules et contrôlant leur prolifération et donc les cancers qui sont inhérents aux organismes pluricellulaires avec des mécanisme qu'on retrouve chez l'homme.

Il faut remarquer qu'il semble qu'il y a une confusion entre pluricellulaires (organisme) et multicelluaires (colonie). Voir aussi Futura-Sciences.

On a par ailleurs trouvé des éponges plus anciennes.

- Disparition des dinosaures : plusieurs météorites

Il y aurait eu au moins un autre impact de météorite, en Ukraine quelques milliers d'années après celui du Golfe du Mexique, et sans doute d'autres. La cause pourrait en être une collision ayant fragmenté un corps céleste.

Il y aurait eu au moins un autre impact de météorite, en Ukraine quelques milliers d'années après celui du Golfe du Mexique, et sans doute d'autres. La cause pourrait en être une collision ayant fragmenté un corps céleste.

La petite grenouille Microhyla nepenthicola, qui vit dans les forêts humides de Bornéo, mesure à peine plus d'un centimètre de longueur.

- Les salamandres sont des plantes !

Les salamandres semblent décidément très originales... Des scientifiques ont montré l’existence d’une algue photosynthétique à l’intérieur des cellules de cet amphibien. Une symbiose de ce type n’avait encore jamais été observée chez les vertébrés.

Pour offrir l’habitat aux algues, la salamandre doit donc y trouver son compte. Les travaux des chercheurs laissent penser que la photosynthèse a lieu à l’intérieur des cellules de la salamandre et qu’elle approvisionnerait l’animal en produits directement issus du processus de photosynthèse : de l’oxygène et des hydrates de carbone (les sucres).

Par ailleurs, en s'inspirant de ce que sait faire la salamandre, des chercheurs ont réussi, chez la souris, à régénérer du tissu musculaire viable.

- Des lézards qui deviennent vivipares

C'est un serpent à pattes du sud de l'Australie (New South Wales) dont on observe avec étonnement l'évolution qui donne la clé de la transition entre les ovipares et les vivipares.

C'est un serpent à pattes du sud de l'Australie (New South Wales) dont on observe avec étonnement l'évolution qui donne la clé de la transition entre les ovipares et les vivipares.

La transition ne serait d'ailleurs pas si difficile à obtenir que cela. Le processus premier consiste à retenir plus longtemps les oeufs dans l'utérus afin de les protéger du froid déjà. Ensuite, plus l'oeuf est gardé longtemps dans l'utérus, plus la coquille devient fine. A l'heure actuelle, ces lézards naissent au sein d'une simple et fine membrane ; la mère s'occupe même à déchirer l'enveloppe dès la naissance.

- Les crocodiles plus différenciés qu'on ne croyait

En fouillant une rivière tanzanienne, des paléontologues ont découvert un crocodile, appartenant à une espèce inconnue, vieux de 105 millions d’années.

La découverte d’un animal, de la taille d’un gros chat, doté d’une dentition porche de celle des mammifères et ayant un mode de vie terrestre soutient un consensus croissant selon lequel les crocodiles étaient autrefois bien plus variés qu’aujourd’hui et dominants un certain nombre de niches écologiques dans l’Hémisphère Sud.

Voir aussi Futura-Sciences.

- Le bébé mammouth Khroma exposé

On pourrait prélever son ADN bien conservé. Il aurait encore du lait dans son estomac, depuis 50 000 ans !

- Des puces pour pister – et sauver – les abeilles

Le Royaume-Uni lance un vaste programme de recherche pour comprendre les surmortalités chez les insectes pollinisateurs. Parmi les projets : l'installation de puces RFID pour identifier les abeilles entrant et sortant de la ruche.

Grâce au programme Insect Pollinators Initiative, les biologistes pourront équiper 16.000 insectes avec ces petites puces et donc étudier assez finement comment des pesticides peuvent éventuellement affecter l'activité des insectes pollinisateurs.

Ceci dit, il apparaîtrait que ce sont bien les pesticides les principaux responsables de la disparition des abeilles.

- Les chauves-souris menacées par le syndrome du nez blanc

Le syndrome du nez blanc découvert à l'origine dans l'Etat de New York se propage rapidement dans tout le Nord-Est du pays et touche actuellement sept espèces de chauves-souris. Son nom vient du champignon blanc qui pousse sur leur nez, leurs ailes et leurs oreilles, l'infection poussant les animaux à rester actifs en hiver alors qu'ils devraient hiberner. Les chauves-souris épuisent ainsi leurs réserves de graisses et dans une colonie en hibernation environ 73 pour cent d'entre elles périssent alors chaque année.

Sinon, une étude sur le virus de la rage et de sa transmission confirme que les virus sont bien liés à un espèce spécifique :

Les chercheurs ont scruté les ressemblances entre les chauves-souris qui étaient impliquées dans ces infections interspécifiques. Bien que l'on explique en général de telles infections par la proximité physique des animaux, comme dans le cas du SRAS et des marchés couverts en Chine, l'équipe de Streicker a trouvé que la génétique semble être plutôt le facteur déterminant. La probabilité qu'une infection ait lieu puis soit transmise était directement liée à la proximité génétique des espèces de chauves-souris considérées.

Les auteurs proposent donc que des défenses similaires entre organismes favorisent les échanges viraux et que cette similarité est plus importante que l'exposition répétée au virus, idée qui "va à l'encontre du paradigme que les virus à ARN sont notre pire cauchemar pour l'émergence de nouvelles maladies" indique Peter Daszak dans un article associé.

- Ce n'est pas la taille du cerveau qui fait l'intelligence

Les comparaisons avec les autres animaux des insectes aux rats et aux gorilles, montre que ce n'est pas la taille du cerveau qui est déterminante. Nous avons une densité beaucoup plus grande de neurones que les rats mais nous avons aussi plus de cellules gliales dont l'importance est illustrée par le cerveau d'Einstein, ce qui est un peu ridicule...

- Cartographie du cerveau du rat

Le système complexe qu’est notre cerveau ne serait pas organisé de manière hiérarchisée mais ressemblerait plus à un réseau de type Internet où tout communique avec tout. Un moyen qui permettrait au cerveau d’utiliser des voies neuronales alternatives en cas de dommages.

Le prélèvement des cerveaux des rats, la réalisation de coupes et leur observation au microscope confocal permet de visualiser les traceurs après l’ajout d’anticorps fluorescents spécifiques à chacun (une couleur est attribuée à chaque traceur) et donc de déterminer les neurones impliqués dans les circuits. Cette technique permet de visualiser deux circuits ou zones d’un même circuit simultanément et dans les deux directions.

Les chercheurs ont appliqué cette méthode à une région du cerveau de rat, impliquée dans la satisfaction procurée par la nourriture et ont publiés leurs observations dans le journal PNAS. Les résultats montrent un circuit très complexe sous forme de boucles et de circuits qui ne semblent pas hiérarchisés : il n’y a ni haut ni bas, à l'image du réseau Internet.

- IBM cartographie le cerveau du macaque

La nouveauté, c'est d'avoir le réseau précis des connexions à longue distance (reliant des zones du cerveau éloignées). Ce qui apparaît, c'est l'existence d'un noyau qui pourrait représenter le coeur de la conscience, en tout cas de l'unité du cerveau (ce qui semble contredire partiellement la brève précédente).

"The core spans parts of premotor cortex, prefrontal cortex, temporal lobe, parietal lobe, thalamus, basal ganglia, cingulate cortex, insula, and visual cortex".

Le cortex pré-frontal servirait à l'intégration et la distribution de l'information (routeur?).

Profondeurs du cervelet: la matière blanche (orange) se distingue de deux types de matière grise (bleu: couche granuleuse; jaune: couche moléculaire). Même les vaisseaux sanguins (rouge) et les différentes cellules (image en bas) sont clairement visibles.

Pour cela, ils utilisent une technique de mesure entièrement nouvelle, un type de radiographie appelé imagerie par contraste de phase. Au lieu de mesurer le rayonnement absorbé par le tissu, comme pour une radiographie traditionnelle, Bert Müller et son équipe ont mesuré la force avec laquelle un tissu défini peut dévier les rayons.

- Les singes parlent avec les mains

On a vu par exemple un singe mimer une blessure qu'il avait eue au pied une semaine plus tôt.

La plupart du temps, les singes recouraient à ce type d'expression corporelle lorsque le message premier avait échoué. Certaines fois, il s'agissait de reproduire une scène du passé et, pour d'autres, afin de déjouer l'attention et voler quelque chose. Cette pratique semble assez rare toutefois.

C'est quelque chose qui me semble primordial (voir plus haut La parole aux singes) même si c'est à peine ébauché chez les singes, la place du théâtre et du mime dans la constitution du récit, avec la conscience du passé, avant même le passage au langage où le mot se détache de l'émotion. On peut en déduire que l'acteur qui joue son texte est une figure archaïque, un peu comme la lecture à haute voix, la puissance du langage se situant au contraire dans sa capacité à viser l'universel, négation de la présence comme des effusions animales dans une prose qui devient purement informative.

- Lucy avait-elle des outils ?

Une nouvelle découverte avance de plusieurs centaines de milliers d’années l’utilisation des premiers outils. Lucy, la célèbre australopithèque, aurait pu s’en servir.

Les résultats de leur datation, rapportés dans la revue Nature de cette semaine, démontrent que nos lointains ancêtres ont commencé à se servir d’outils il ya 3,4 millions d’années, soit 800 000 ans plus tôt qu'établi à ce jour.

Selon l’auteur, les marques retrouvés sur les os auraient pu être l’œuvre d’Australopithecus afarensis, une des premières espèces d’hominidés à laquelle appartiennent les fossiles «Lucy» et «Selam ».

« Cette découverte spectaculaire modifie la période d’apparition d’un comportement qui va tout changer pour nos ancêtres » explique Zeresenay Alemseged, « L’utilisation de l'outil a fondamentalement modifié la façon dont nos premiers ancêtres étaient en interaction avec la nature, ce qui leur a permis de manger de nouveaux types d'aliments et d'exploiter de nouveaux territoires. »

Voir aussi Futura-Sciences.

Ce n'est pas vraiment une découverte mais la confirmation par l'horloge génétique de nos mitochondries que l'""homo sapiens'' date de 200 000 ans, du côté des femmes, du moins. Pour les hommes, s'il y a eu croisement avec un Néandertal il y a 60 000 ans, ce serait plus compliqué et la femme qui aurait donné naissance à cet hybride viable, peut-être unique, serait une nouvelle Eve sans doute, mais on est encore dans une grande incertitude à ce sujet.

- La vie sexuelle de nos ancêtres préhistoriques

Homosexualité, jeux érotiques : une exposition espagnole présentera la vie intime de nos aïeux du paléolithique, taboue jusqu'ici.

La sexualité liée au plaisir, à la sensualité et non à la seule reproduction existait déjà il y a entre 35 000 ans et 10 000 ans [période du paléolithique supérieur, lorsque l'Homo sapiens est arrivé en Europe, ndlr]. Les bases de notre comportement sexuel actuel se trouvent à cette époque.

C'est une quinzaine de gravures sur pierre et de sculptures représentant des humains dans le détail (relatif) de leur anatomie -chose rare selon le préhistorien- qui l'ont convaincu de monter cette exposition. On y (re)découvre, selon lui, les positions les plus variées, des scènes de masturbation, des godemichés, un cas potentiel de zoophilie et même un voyeur.

- Le premier festin connu de l’humanité daté d'il y a 12.000 ans

Les carapaces des tortues ont été retrouvées sous, autour et au-dessus des restes d’une vieille femme chamane qui a probablement été enterrée suivant les rituels de l’époque. Ces données suggèrent que le repas a été consommé en même temps que la célébration des funérailles de cette femme.

Les Natoufiens, puisque c’est de cette communauté qu’il s’agit, vivaient dans cette région à l'époque de l’épipaléolithique tardif (entre -14.500 et -11.500 ans). Au départ, les populations étaient mobiles et séparées en petits groupes. Si la nourriture venait à manquer, les tensions qui survenaient étaient simplement réglées par le déménagement d'un des groupes vers des terres plus accueillantes.

Peu à peu, au fil de l’accroissement de la population et donc de la réduction de l’espace attribué à chacun, les groupes ont été amenés à se rencontrer de plus en plus fréquemment et les tensions ont probablement été de plus en plus nombreuses. Finalement, les communautés se sont sédentarisées et ont appris à cultiver la terre et à pratiquer l’élevage pour réduire les problèmes liés à la nourriture.

La transition vers la sédentarisation a probablement été facilitée par ce genre de festins, d’après Natalie Munro, une des anthropologues impliqués dans l’étude. En effet, ces événements de fête où la nourriture est abondante permettent de réduire les tensions et de contribuer à l’amélioration des relations sociales au sein des communautés.

Ce n'est pas vraiment nouveau, et on avait vu que c'était le cas pour les animaux aussi qui ne changent pas de personnalité même quand ils changent de contexte.

Ce n'est pas vraiment nouveau, et on avait vu que c'était le cas pour les animaux aussi qui ne changent pas de personnalité même quand ils changent de contexte.