- L'entropie négative

- La quantification des trous noirs

- Un trou dans le temps

- Maintenir l'intrication dans la durée

- Une nanosphère superposée en 2 endroits à la fois

- Ce qui n'est pas génétique dans l'évolution

- Un signal bioélectrique précéderait la différenciation des organes

- La personnalité d'animaux sans cerveau

- Pas de grand-parents avant 30 000 ans

- Nous étions 10 fois plus nombreux que Neandertal

- Nos ancêtres les Gravettiens

- Le cerveau du vague au précis

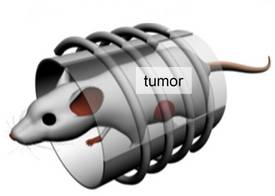

- On a fait pousser une dent de souris dans un rein…

<- Revue des sciences précédente | Revue des sciences suivante ->

Revues : Pour la Science

Brèves : Physique - Climat - Biologie - Santé - Technologie

Explosion de l'exploitation des gaz de schiste dans le Wyoming.

Il faut le répéter, non seulement la science n'est pas la vérité (l'économie encore moins bien sûr) mais elle se confronte plutôt à nos propres limitations en réfutant à chaque fois ce qu'on croyait vrai. C'est sans doute la physique qui nous dévoile le plus l'étendue de notre ignorance à mesure même des progrès de nos connaissances. Elle nous donne encore une fois l'occasion de vérifier comme une idée devenue hégémonique comme celle de l'inflation peut soudain être complètement remise en cause et abandonnée, phénomène qu'on retrouve dans l'idéologie (notamment économique) et qui laisse de l'espoir sauf que certains s'imaginent du coup que toute la physique pourrait n'être qu'illusion et purement conventionnelle ! C'est quand même très embêtant quand on découvre qu'on ne sait pas grand chose des trous noirs et qu'on est donc bien incapable de prédire ce qui arrivera au LHC, pour l'instant bien décevant. Il est très intéressant par contre de comprendre avec les octonions la nécessité de la cohérence mathématique des théories physiques (j'ai trouvé cela passionnant pour ma part). Plus troublant, une nouvelle étude montre que les anciennes accusations de Stephen Jay Gould contre Samuel George Morton qu'il accusait de fausser les données par préjugé raciste se retournent contre lui par préjugé anti-raciste... Il semble de même que les efforts pour nous rapprocher Neandertal étaient un peu exagérés (mais rien de plus incertain que notre préhistoire, c'est même pour cela qu'on a, cette fois encore, une série de découvertes nous faisant encore changer d'avis comme tous les mois!). Il n'y a pas que les erreurs de bonne foi, on vient ainsi de découvrir (confirmer) que les essais cliniques de médicaments ont fait l'objet de véritables fraudes massives. Il y a aussi une polémique sur le rapport du GIEC prévoyant 80% de renouvelables en 2050. C'est effectivement dommageable que ce soit rédigé par Greenpeace et non par des experts indépendants mais ce n'est qu'un des scénarios possibles envisagés, certes pas le plus probable, et cela rejoint d'autres rapports allemands ou européens notamment, ce n'est donc pas si absurde ni impossible. Ce qui est certain, c'est que ça ne se fera pas tout seul et que cela exigerait des politiques volontaristes de grande ampleur, un "green New Deal" que le prix du pétrole et la crise pourraient favoriser mais qui restent encore plus qu'improbables, hélas, en tout cas on n'en prend pas le chemin avec une hausse constante des émissions de gaz à effet de serre malgré les annonces continuelles de progrès considérables dans la production et le stockage d'énergies renouvelables.

Le numérique pourrait aussi participer largement aux économies de ressources alors même qu'il aggrave plutôt la situation pour l'instant. Les imprimantes 3D intègrent l'industrie devenant un élément essentiel de la conception et de la fabrication industrielle au lieu de permettre de se passer d'industrie en décentralisant la production... L'évolution du numérique se poursuit à un rythme accéléré entraînant une obsolescence rapide qu'on ne peut dire programmée, l'avenir restant toujours aussi incertain. Ainsi, Intel ne croit pas aux tablettes qui devraient être remplacées à court terme par des formes plus modulaires et multi-fonctions. Il semble aussi que Google passe de sa phase adolescente de croissance à une rationalisation plus industrielle de l'exploitation de sa position dominante, vérifiant le fait que toute puissance finit pas être employée quelques soient les réticences ou l'idéalisme de départ. Ainsi, l'enjeu principal de Google+ serait surtout le ciblage marketing (Microsoft se permet de critiquer dans une vidéo l'exploitation qu'en fait déjà Gmail) mais Google se lance aussi dans la politique et la lutte contre le terrorisme avec Google Ideas. On voit comment la société de l'information produit ses propres ennemis en surévaluant les actions spectaculaires comme porteuses de messages (ce n'est en rien une spécificité islamiste comme le tueur norvégien le rappelle mais bien de notre époque). On peut douter de projets qui semblent bien naïfs comme celui de simulation de la société pour en prévoir les crises (et les risques terroristes) mais cela devrait produire tout de même quelques résultats exploitables sans doute. Signalons une vidéo intéressante (en anglais) où l'intervenant considère notamment que l'arrivée du HTML5 qui peut lancer toutes sortes d'applications constitue une véritable révolution et la fin du PC (de Microsoft). Il parle aussi de la domination d'Apple (qui devance tous ses concurrents) mais aussi de l'échec de Google trop pollué désormais, donnant l'avantage à d'autres outils de recherche.

La guerre numérique pour les droits fait toujours rage. Pour Hadopi qui commence ses réponses graduées, il y aurait 18 millions de fraudeurs ! Cependant, les entreprises qui se sont lancés dans les brevets numériques en découvrent les impasses dans des procès réciproques et sans fin. Ainsi, les brevets logiciels pourraient bloquer le développement d'Android, montrant l'absurdité de tout breveter. Alors que les brevets étaient destinés à favoriser la diffusion des techniques, on a recréé un système de péage paralysant, un peu comme au Moyen-Âge. Ainsi, le driver Kinect a été intégré à la nouvelle version Linux 3.0 mais il fait l'objet lui aussi de plainte pour violation de brevets ! C'est sans doute sur ce terrain que ce joue l'avenir du numérique et de la gratuité des biens communs immatériels. Par contre avec l'intensification des volumes, ce devrait bien être la fin de la neutralité du net, de là à crier à la mort d'internet comme le font certains, c'est très exagéré. C'est peut-être aussi la fin de l'anonymat sur le réseau (Google+ n'accepte que les véritables identités) et de l'illusion que cet espace public pourrait rester dans la sphère privée. Les mésaventures des Anonymous qui ont été assez rapidement arrêtés démontrent qu'il est bien difficile de rester anonyme sur internet même pour des hackers, d'autres hackers pouvant se battre contre eux. Cela n'empêche pas que se développent des programmes permettant de contourner la censure des Etats.

Le domaine de la robotique pouvait sembler faire du surplace alors que l'intelligence des robots a fait de tels progrès qu'ils pourraient devenir vite indispensables mais ce sont les voitures automatiques qui débarquent sur les routes bien plus tôt que prévu. On n'entendait plus beaucoup parler non plus de nanotechnologie ces derniers temps, sinon pour en déplorer le coût et les limites mais voilà une série d'annonces qui témoignent du passage désormais à la production de masse, avec une première génération de machines outils nanométriques, en premier lieu pour l'électronique et la recherche. Des "capes d'invisibilité" de toutes sortes sont aussi très à la mode. En biologie, le plus curieux, c'est un mystérieux signal bioélectrique qui précéderait la différenciation des organes, organogenèse qui se révèle bien plus programmée que ne le prétendaient certains. Enfin, il est rassurant dans ce monde vieillissant d'apprendre que l'explosion culturelle de l'humanité pourrait être due principalement à l'allongement de la vie, à ses vieux porteurs de mémoire, avec un effet exponentiel en fonction de la démographie. On pourrait penser que le fait d'arriver bientôt au pic mondial de population devrait avoir des effets semblables mais la pression écologique va être très forte et les nouvelles populations sont très jeunes, sans parler du fait que les fous réussiraient mieux en politique que les gens normaux, à ce qu'il paraît. Le seul espoir (?), c'est qu'il paraît qu'il suffit que des idées soient adoptées par 10% de la population pour faire basculer soudain une majorité...

Pour la Science no 406, Les couleurs oubliées de l'Antiquité

- Les couleurs dans l'antiquité, p28

- Les couleurs dans l'antiquité, p28

Outre le fait que même les très beaux marbres étaient peints, le plus intéressant, c'est que leurs couleurs n'étaient pas les nôtres :

Les termes sumériens et akkadiens de couleur désignent ainsi manifestement plutôt des catégories abstraites que les couleurs telles que nous les comprenons. Même le célèbre bleu des carreaux de la Porte d’Ischtar n’a pu être relié à aucun des termes trouvés sur les tablettes cunéiformes. Manifestement, les Babyloniens ne faisaient pas de différence entre le bleu et le vert, mais plutôt entre le bleu foncé et le bleu clair.

À tel point que les spécialistes de la traduction se sont même demandé un moment si les Anciens étaient à même de percevoir le bleu ou bien s’ils n’avaient tout simplement pas de mots pour le nommer.

- L'inflation cosmique remise en question, p52

Selon la théorie de l'inflation, proposée il y a 30 ans, l'Univers aurait connu une brève phase d'expansion vertigineuse juste après le Big Bang. Cependant, cette théorie qui est au cœur de la cosmologie moderne souffre de sérieuses difficultés.

L'énergie potentielle de l'inflaton peut entraîner l'expansion de l'Univers à un rythme accéléré. Ce processus peut lisser et aplanir l'Univers à condition que le champ reste sur le plateau suffisamment longtemps (environ 10–30 seconde) pour dilater l'Univers d'un facteur 1025 ou plus.

Les arguments en faveur de l'inflation peuvent être résumés en trois points. Premièrement, l'inflation est inévitable.

Deuxièmement, l'inflation explique pourquoi l'Univers est si homogène et plat aujourd'hui.

Troisièmement, et ce point est certainement le plus convaincant, la théorie de l'inflation a une grande portée prédictive. De nombreuses observations du rayonnement de fond diffus cosmologique (le fossile de la première lumière émise après le Big Bang) ou de la distribution des galaxies ont ainsi confirmé que les fluctuations de la distribution d'énergie dans l'Univers primitif étaient presque invariantes d'échelle.

Reprenons le premier point : l'inflation est-elle vraiment inévitable ? Peut-être, mais si c'est le cas, il y a un corollaire embarrassant : une « mauvaise» inflation est plus probable que la « bonne». Par mauvaise inflation, on entend une période d'expansion accélérée dont le résultat est en contradiction avec les observations, par exemple qui engendre des fluctuations de température trop grandes.

Non seulement la mauvaise inflation est plus probable que la bonne, mais il est encore plus vraisemblable qu'il n'y ait pas d'inflation du tout ! (...) La conclusion, assez troublante, de R. Penrose est qu'il est 10(10100) fois plus probable d'obtenir un univers plat sans inflation qu'avec inflation !

Une autre approche qui conduit à la même conclusion est d'extrapoler l'histoire de l'Univers primitif à partir des conditions actuelles en remontant le temps à l'aide des lois physiques. (...) un nombre écrasant d'extrapolations font intervenir une inflation insignifiante.

Un univers plat et homogène est improbable, et l'inflation est un mécanisme puissant pour obtenir ces propriétés, mais cet atout est contrebalancé par le fait que les conditions requises pour amorcer la bonne dose d'inflation sont encore plus improbables !

Nous avons vu que les fluctuations quantiques peuvent légèrement retarder le moment où l'inflation prend fin. Les petites fluctuations ont de petits effets. Cependant, les fluctuations étant aléatoires, elles seront grandes dans certaines régions de l'espace, et conduiront à des retards importants.

Ces régions en retard sont extrêmement rares, et on pourrait penser qu'elles sont négligeables. Mais elles sont en inflation ! Elles continuent ainsi à se dilater vertigineusement et, en quelques instants, éclipsent les régions où l'inflation s'est déjà terminée. Le résultat est un océan d'espace en inflation entourant de petites îles emplies de matière et de rayonnement.

La théorie originelle suppose que l'inflation conduit à un résultat prévisible régi par les lois de la physique classique. En réalité, c'est la physique quantique qui gouverne l'inflation.

Une théorie alternative à la cosmologie inflationnaire que mes collègues et moi-même avons proposée jouit précisément de cette propriété. Selon cette « théorie cyclique », comme on la nomme, le Big Bang n'est pas le commencement de l'espace et du temps, mais plutôt un « rebond » à partir d'une phase précédente de contraction vers une nouvelle phase d'expansion, accompagnée par la création de matière et de rayonnement. Cette théorie est cyclique parce que, au bout de 1 000 milliards d'années, l'expansion dégénère en contraction, jusqu'à un nouveau rebond et ainsi de suite. Le point clef est que le lissage de l'Univers se produit avant le Big Bang, au cours de la période de contraction (de façon moins intuitive que la dilatation, une contraction suffisante rend aussi un matériau homogène).

Même si on peut comprendre l'enthousiasme de physiciens comme Brian Greene, devant ce qui apparaissait comme un puzzle se complétant comme par miracle au fil des ans et permettant de tout expliquer (y compris la matière, pas seulement sa répartition ou la géométrie de l'univers), je n'ai jamais été convaincu jusqu'ici par l'inflation, théorie ad hoc basée sur rien ou presque, un peu comme le boson de Higgs auquel elle pourrait être reliée (champ de Brans-Dicke) et dont on peut croire qu'on a trouvé des traces, ce qui reste à prouver. Une théorie ne peut être vraie par chance, il faut qu'elle parte d'une observation. La réalité a toujours été très différente de ce qu'on en avait imaginé avant d'y aller voir de plus près. C'est peu de dire qu'on n'a aucune prescience du réel, la pensée déductive est très incertaine, on voit bien avec Descartes toutes les hypothèses fantaisistes auxquelles cela pouvait le conduire. Il faut souvent des années avant qu'une absurdité admise par presque tous révèle soudain son caractère intenable et purement fictionnel. Ce n'est pas qu'on pourrait généraliser pourtant à toute la science ce caractère dogmatique, on n'est pas dans la religion et ces modes sont à chaque fois un événement ponctuel et transitoire, comme les théories de l'auto-organisation par exemple, mais on ne peut mettre au même niveau la relativité ou la physique quantique dont les formules sont vérifiées constamment. Le délire s'accroche à ce qu'on n'a pas encore observé (comme un trou noir, dont l'existence reste très hypothétique). Quand on a des formules qui marchent, c'est seulement leur interprétation qui peut être délirante ou précipitée.

- Des octonions pour la théorie des cordes, p70

Les articles passionnants et compréhensibles sur les mathématiques sont très rares. L'approche historique trop délaissée se révèle un puissant moyen d'en comprendre les enjeux. L'intérêt, ici, c'est de comprendre les raisons des multiples dimensions de la théorie des cordes assurant sa cohérence, c'est-à-dire la possibilité d'effectuer des opérations arithmétiques bien que dans une géométrie non-commutative.

Vers 1806, le Genevois Jean-Robert Argand répandit l'idée que les nombres complexes représentent des points sur un plan. L'idée est simple : dans a + bi, le nombre a indique la position horizontale du point correspondant, tandis que le nombre b spécifie sa position verticale.

On peut ainsi se représenter n'importe quel nombre complexe comme un point du plan, mais Argand est allé un peu plus loin : il a montré que les opérations arithmétiques (addition, soustraction, multiplication et division) sur les nombres complexes peuvent être interprétées comme des manipulations géométriques dans le plan.

En 1835, à l'âge de 30 ans, le mathématicien et physicien William Rowan Hamilton découvrit comment traiter les nombres complexes comme des couples de nombres réels. À l'époque, les mathématiciens écrivaient généralement les nombres complexes sous la forme a + bi introduite par Argand, mais Hamilton remarqua que rien ne nous empêche de considérer le nombre a + bi comme une façon particulière de noter le couple (a, b) formé par les deux nombres réels a et b.

Cette notation permet d'additionner et de soustraire facilement des nombres complexes. Il suffit en effet d'additionner ou de soustraire les nombres occupant la même position dans les couples de nombres réels : ainsi, (a, b) + (c, d) = (a + c, b + d).

Hamilton recherchait un système tridimensionnel de nombres où l'on peut ajouter, soustraire, multiplier et diviser. La division est la partie difficile : un système de nombres où l'on peut diviser (c'est-à-dire où tout élément non nul a un inverse pour la multiplication) est ce qu'on appelle une algèbre de division. Ce n'est qu'en 1958 que trois mathématiciens ont prouvé un fait remarquable soupçonné depuis des décennies : toute algèbre de division doit être de dimension 1 (l'algèbre des nombres réels), 2 (les nombres complexes), 4 ou 8.

Hamilton lui-même avait trouvé une solution le 16 octobre 1843. Il marchait à Dublin avec sa femme le long du Royal Canal, en route vers une réunion de l'Académie royale irlandaise, quand il eut une révélation soudaine. En dimension 3, on ne pouvait pas décrire les rotations et les dilatations à l'aide de trois nombres seulement. Il fallait un quatrième nombre, ce qui donnait lieu à un ensemble quadridimensionnel de nombres nommés quaternions et écrits sous la forme a + b i + c j + d k. Ici, les « nombres » i, j et k sont trois différentes racines carrées de –1.

Trois nombres servent à caractériser une rotation dans l'espace (...) Le quatrième nombre dont on a besoin sert à décrire la dilatation (l'étirement ou le rétrécissement).

Aujourd'hui, dans beaucoup de ces applications, les quaternions ont été remplacés par des cousins plus simples : les vecteurs, que l'on peut considérer comme des quaternions particuliers, de la forme b i + c j + d k (le premier nombre a vaut simplement zéro). Les quaternions conservent cependant leur niche : ils sont efficaces pour représenter les rotations tridimensionnelles sur ordinateur.

Les quaternions décrivent des rotations en trois dimensions, et l'on sait que le résultat de plusieurs rotations successives dépend de l'ordre dans lequel elles ont été effectuées. (...) Puisque le résultat dépend de l'ordre, la composition des rotations n'est pas commutative. De même, la multiplication des quaternions ne l'est pas.

Les octonions sont bien plus étranges encore. Non seulement leur multiplication n'est pas commutative, mais ils contreviennent à une autre loi familière de l'arithmétique : l'associativité, c'est-à-dire l'égalité (x y) z = x (y z).

Ils sont étroitement liés à la géométrie en dimensions 7 et 8, et on peut décrire les rotations dans ces espaces multidimensionnels à l'aide de multiplications d'octonions.

Si l'univers est, en dehors du temps, de dimension 1, 2, 4 ou 8, les particules de matière comme de force seraient des ondes décrites par un seul type de nombres, à savoir des nombres d'une certaine algèbre de division, où l'addition, la soustraction, la multiplication et la division sont possibles. En d'autres termes, dans ces dimensions, les vecteurs et les spineurs coïncident : les uns comme les autres sont simplement des nombres réels, des nombres complexes, des quaternions ou des octonions, respectivement. La supersymétrie émerge naturellement et fournit ainsi une description unifiée de la matière et des forces. Une simple multiplication décrit les interactions, et toutes les particules (quel que soit leur type) sont décrites à l'aide du même système de nombres.

On montre que l'évolution dans le temps modifie les dimensions dans lesquelles la supersymétrie apparaît naturellement, en en ajoutant deux : une pour la corde, et une pour le temps. Au lieu de supersymétrie en dimension 1, 2, 4 ou 8, on obtient une supersymétrie en dimension 3, 4, 6 ou 10.

Or, comme par hasard, les théoriciens des cordes nous disent depuis des années que seules les versions à dix dimensions de la théorie sont cohérentes. Les autres sont entachées de défauts nommés anomalies : quand on calcule certaines grandeurs de deux façons distinctes, on obtient des résultats différents. Il n'y a qu'en dimension 10 que la théorie des cordes pourrait être valide. Mais la théorie des cordes à dix dimensions est, comme nous venons de le voir, la version de la théorie qui utilise les octonions.

Avec la théorie M, il faudra ajouter encore une autre dimension aux membranes... Ce qui est passionnant, c'est de voir que la théorie des cordes a une nécessité purement mathématique d'assurer sa cohérence. Dire cela n'est pas une critique, seule l'expérience doit trancher, rechercher une cohérence est une bonne méthode de construction d'hypothèses et renvoie à des contraintes réelles. Ainsi, on peut remarquer que les coordonnées supplémentaires ne renvoient pas forcément à des dimensions supplémentaires : la dilatation n'ajoute pas une dimension à l'espace mais à son évolution seulement, ce qui correspond à un étirement en 2 dimensions et fait penser à la relativité. Si les quaternions sont des objets en 3 dimensions, on peut penser qu'il suffit d'ajouter une seule autre dimension pour aboutir aux octonions, les autres coordonnées n'étant que relatives aux déformations dans cet hyperespace. Cela n'explique pas mieux ce que serait cette dimension supplémentaire mais réduit la question à une seule dimension invisible au lieu de 6 ou 7 (tout cela étant pure divagation d'un complet amateur!).

- Le soleil et le cancer de la peau, p44

Les rayons ultraviolets A, B et C du Soleil endommagent les bases de l’ADN. Les ultraviolets C sont les plus énergétiques et les plus absorbés par l’ADN, mais l’atmosphère les réfléchit totalement : aucun ne parvient sur Terre. Quelques pour cent seulement des ultraviolets B et environ 30 pour cent des ultraviolets A traversent l’atmosphère, de sorte que le rayonnement atteignant la surface terrestre est composé de 95 pour cent d’ultraviolets A et de 5 pour cent d’ultraviolets B. Bien que ces derniers soient moins délétères que les ultraviolets C pour l’ADN des cellules de peau, ils y déclenchent des réactions chimiques qui créent des « photoproduits ». De plus, les ultraviolets A engendrent la production de radicaux libres. Ces molécules – photoproduits et radicaux libres – peuvent provoquer des mutations, voire des cancers.

Ce qu'il faut retenir, c'est que les crèmes solaires ne protègent pas des ultraviolets A considérés comme moins agressifs que les B mais qui n'en produisent pas moins des molécules excités plus réactives et donc dangereuses.

- La culturonomique, p82

Les sondages donnent accès à des informations globales sur de grands ensembles impossibles à explorer de manière exhaustive : groupes humains, populations animales, objets sortant d’une chaîne de production, etc. Malheureusement, les sondages ne voient pas les faibles fréquences.

Sans les approches exhaustives ou presque exhaustives, de nombreux faits restent invisibles ou impossibles à mesurer. L’informatique élargit le champ des variables évaluables : elle offre des capacités de stockage massif d’informations, elle réalise des collectes de faits, de chiffres et d’images à grande échelle et les automatise. Elle donne aussi des moyens de traitement numériques ultrarapides pour l’exploration des gigantesques bases de données. Plusieurs domaines de recherche sont nés ou ont été renouvelés. Ainsi, la fouille de données (data mining) conçoit des méthodes pour extraire l’information pertinente des masses inouïes de données enregistrées sur les supports numériques.

On entre dans l'époque des données de masse. Le problème, c'est que les statistiques n'ont souvent aucun sens, ou plutôt elles semblent toujours en avoir un qui n'est souvent qu'une illusion (une corrélation n'est pas une causalité). Comment donc interpréter la fréquence des mots dans l'immense bibliothèque numérisée par Google ? Cette nouvelle discipline, la culturomique, a des bases bien fragiles, cela ne veut pas dire qu'on ne pourra rien en tirer (un peu comme des tentatives de modéliser les sociétés). Ce qui est étudié ici, c'est la fréquence des mots en fonction des dates (ce qui ne tient pas compte du fait que le corpus n'est plus du tout le même) et que chacun interprétera en fonction de son idéologie.

- Le cerveau caché de Michel-Ange, p88

Dans deux panneaux du plafond de la chapelle Sixtine, la Création d'Adam et la Séparation de la lumière et des ténèbres, Michel-Ange aurait dissimulé des planches anatomiques du système nerveux.

Brèves et liens

Physique

cosmologie, astronomie, physique quantique

- La signification de l'entropie négative

La suppression des données d'un disque dur pourrait conduire, dans des conditions bien particulières, à un refroidissement du système. Telle est la conclusion d'une étude réalisée conjointement par des physiciens de l'Université d'Oxford, de l'Université nationale de Singapour et de l'ETH Zürich (Institut fédéral de technologie de Zürich), et parue dans le journal Nature au mois de juin 2011. L'étude a pour titre: "The thermodynamic meaning of negative entropy" (La signification thermodynamique de l'entropie négative).

Le travail de l'équipe de chercheurs a été de démontrer que lors de la suppression d'information, l'entropie du système, et donc sa capacité à produire de la chaleur ou à se refroidir, était conditionnée par l'information quantique qu'un observateur possède sur ce système.

En physique, selon le principe de Landauer, la suppression de données stockées sur un système possède un coût de travail inhérent et de ce fait dissipe de la chaleur. Cette théorie suppose que l'information sur le système à effacer est classique, et ne s'étend pas aux cas où un observateur peut avoir des informations quantiques sur ledit système. L'étude parue dans Nature démontre que le principe de Landauer ne s'étend pas au domaine de la physique quantique où il peut y avoir suppression de données sans dissipation de chaleur, voire même refroidissement.

Pour Renato Renner, un des auteurs de l'article : "l'étude a démontré que dans les deux cas, en théorie de l'information et en thermodynamique, le terme entropie décrit en fait la même chose, et ce même dans le régime de la mécanique quantique. Notre équipe a montré que pour les deux domaines, l'entropie est considérée comme une marque de manque de connaissances".

Je n'ai pas lu l'article de Nature, c'est donc sûrement que je n'y comprends rien mais c'est typiquement pour moi l'illustration des confusions en physique à la fois sur le concept d'entropie et celui d'information. Il se peut qu'en agissant directement sur la fonction d'onde représentant un disque dur on l'efface sans apport d'énergie significative et donc sans dégagement de chaleur mais cela paraît très théorique et peu praticable. Ce n'est imaginable au mieux que pour une remise à zéro totale et non pour l'effacement de millions de bits dispersés sur le disque dur et comportant des adresses, des longueurs spécifiques et des codes de contrôle d'erreur. On ne peut passer ainsi de l'information quantique à l'information numérique qui sont d'un autre ordre et le dégagement de chaleur ne dépend pas de l'information qu'on en a. On peut certes inverser l'entropie, notamment en produisant de l'énergie à partir de la chaleur, ce qui est assez nouveau et très prometteur, mais c'est tout autre chose. Si l'entropie est bien relative à nous, comme la vitesse, elle ne résulte pas d'un manque de connaissance mais de l'évolution naturelle de l'improbable au probable et si la valeur de l'information est dans son improbabilité c'est parce que cela permet d'inverser localement l'entropie en la canalisant ou bien en tirant parti des fluctuations statistiques. Reste qu'un ordinateur quantique ne manipulant que quelques qbits doit pouvoir effectivement les effacer sans dégagement de chaleur ni dépense d'énergie pour forcer un changement d'état mais ce sont des systèmes déjà très réfrigérés de toutes façons. Ce qui est contestable ce sont les conclusions qui en sont tirées plus que ce mécanisme spécifique qui reste intéressant en lui-même.

- Une réfutation du théorème de Bell ?

Rien compris...

- La quantification des trous noirs

Si les trous noirs n'étaient pas quantifiés, il s'en produirait à chaque collision de particule. Il faut donc un minimum de masse et d'énergie pour créer un trou noir "primordial" comme il a pu s'en former juste après le Big Bang. Cela relance l'intérêt pour la formation de trous noirs au LHC mais Technology Review s'alarme de notre ignorance à ce sujet et des risques encourus à en produire...

J'avais attiré l'attention depuis longtemps sur le sujet (Trous noirs dans le principe de précaution) mais j'avais été convaincu par le fait que de telles collisions énergétiques se produisent couramment dans la haute atmosphère (entre autres). Il y a quand même une grosse différence avec le LHC fournissant potentiellement beaucoup plus de masse à l'appétit d'un trou noir. A la réflexion, l'argument des scientifiques a la forme du sophisme dit du chaudron troué puisqu'on nous dit que le LHC ne créera pas de trous noirs, que s'il en crée ce sera de petits trous noirs s'évaporant immédiatement et que de toutes façons il se crée en permanence des trous noirs autour de nous ! La vérité, c'est qu'on ne sait pas grand chose sur les trous noirs, même pas si ils existent réellement (l'existence d'une "singularité" étant plus que douteuse), on reste là-dessus des savants fous bien ignorants mais la perspective d'être soudain avalé par une expérience irréfléchie nous menant à une véritable fin du monde cette fois est paradoxalement ce qui peut rendre l'existence plus légère !

- RadioAstron, le Hubble russe, découvrira-t-il des trous de ver ?

Le plus gros télescope spatial est russe et il vient de déployer son miroir fait de 27 pétales de fibres de carbone. Destiné à faire de la synthèse d’ouverture en radioastronomie, il pourrait révéler, entre autres, que certains quasars sont en réalité des trous de ver connectant notre univers à un autre.

En effet, la résolution atteinte devrait nous révéler ce qui se passe au plus près de l'horizon du trou noir supermassif à l'origine du rayonnement des quasars.

Il avait déjà suggéré, avec Igor Novikov, que certains noyaux actifs de galaxies, comme celui de M 87, pourraient bien être des trous de ver formés dans des phases très primitives de la naissance de l’univers !

Connectant notre cosmos avec des univers parallèles, ils pourraient ressembler à des trous noirs mais n’en seraient pas à cause de l’absence d’un horizon des événements. Cette absence d’horizon et les modifications engendrées concernant les orbites des plasmas proches de l’entrée d’un trou de ver confondue avec l’horizon d’un trou noir, pourraient être visibles avec la résolution record d’un radiotélescope dont le diamètre est de l’ordre de la distance de la Terre à la Lune.

- Confirmation de l'énergie noire dans le rayonnement fossile

- Une énorme masse d'eau presque depuis les origines de l'univers

Ce nuage de vapeur d'eau renferme 140 trillions de fois le volume d'eau contenu dans les océans de la Terre !

Le gigantesque nuage flotte près d'un trou noir, à quelques dix milliards d'années-lumière de notre planète.

Il n'y a donc rien d'exceptionnel à la présence d'eau sur une planète.

- 1% des étoiles de notre galaxie pourraient abriter une vie complexe

En fait pas tout-à-fait car dans 75% des cas, les planètes ne tourneraient pas sur elle-mêmes offrant toujours la même face à leur soleil, ce qui n'est pas très favorable mais il ne serait pas aussi impossible qu'on le croyait qu'il y ait des planètes habitables près du centre de la galaxie car si la menace de supernovae y est beaucoup plus grande, sur le nombre quelques planètes pourraient être préservées de leur dévastation.

En fait, quand on voit qu'il nous a fallu plus de 4 milliards d'années pour en arriver là, il me semble quand même peu probable qu'on trouve d'autres planètes préservées aussi longtemps (peut-être une ou deux quand même ?) mais des formes de vie moins évoluées (bactéries, voire des petits vers?) sont presque certaines. Etant données les distances, la rencontre d'extraterrestres est malgré tout à peu près exclue. Sauf énorme surprise, nous restons seuls sur la Terre...

- L'anomalie Pioneer due à la chaleur de la sonde spatiale

Le fait que la décélération inexpliquée des sondes Pioneer soit exponentielle semble indiquer que cela viendrait de la chaleur produite par le plutonium-238 qui leur sert de carburant et qui décroit aussi exponentiellement mais pourrait freiner la sonde spatiale en étant focalisée dans une seule direction.

- La fusion aneutronique pour les engins spatiaux

Le bilan final de la réaction est la production de trois noyaux d’hélium animés d’une énergie cinétique de 2,9 MeV et qui sont éjectés à grande vitesse.

Selon les calculs de Chapman, on obtient ainsi un système de propulsion quarante fois plus efficace que le meilleur des systèmes de propulsion ionique dont dispose actuellement l’Humanité et ce d’autant plus que chaque impulsion du laser devrait générer environ 100.000 particules alpha.

C'est un robot qui ne ressemble à rien de connu sur Terre, ce pourquoi je le considère comme le premier robot spatial : une quasi sphère qui flotte en apesanteur dans la station spatiale qu'il peut inspecter, en se déplaçant de façon autonome, et apporter d'autres services aux astronautes par l'intermédiaire d'un smartphone Samsung qui sert d'interface.

C'est un robot qui ne ressemble à rien de connu sur Terre, ce pourquoi je le considère comme le premier robot spatial : une quasi sphère qui flotte en apesanteur dans la station spatiale qu'il peut inspecter, en se déplaçant de façon autonome, et apporter d'autres services aux astronautes par l'intermédiaire d'un smartphone Samsung qui sert d'interface.

- Un photon ne peut aller plus vite que la lumière

A partir d'une nouvelle étude vérifiant le fait qu'un photon ne pouvait pas dépasser la "vitesse de la lumière", Laurent Sacco fait mine qu'on pourrait remonter dans le temps (ce qui est absurde et qu'on verrait bien si des voyageurs du futurs se mêlaient de nos affaires!).

Je n'y ai pas compris grand chose et j'ai peur de mal traduire mais de même que des métamatériaux permettent de faire des "capes d'invisibilité" que certaines ondes traversent sans déformation, de même on pourrait s'en servir pour isoler une bulle de temps (mais pendant un temps très bref de 110 nanosecondes).

Je n'ai pas compris grand chose non plus à une expérience sensée rendre compte d'une "fin du temps" avec des métamatériaux et qui aboutirait simplement à une divergence des champs...

- Des métamatériaux pour isoler des champs magnétiques

C'est une "cape d'invisibilité magnétique" qui donnerait l'impression qu'un aimant a été désaimanté. Les applications ne m'ont pas semblé claires d'autant qu'il faudrait des supraconducteurs, ce qui en limite les usages.

- Une cape d'invisibilité dans l'eau

Là, on voit bien l'utilité mais y arriver pour des objets de la taille d'un sous-marins reste controversé.

Enfin, c'est juste un excès de boson W, à confirmer... Pour l'instant, c'est plutôt la déception, aucun résultat notable jusqu'ici !

Il est vrai que les nouvelles bornes sur la masse du boson de Higgs font qu’il est probablement léger et dans un intervalle d’énergie entre 115 et 140 GeV, là où, paradoxalement, il est le plus difficile à trouver. Mais Rolf Heuer s'attend au cours de l’année 2012 à un progrès d’un facteur dix dans la quantité de données accumulée. Selon ses estimations, à la fin de l’année prochaine, on saura alors si oui ou non le boson de Higgs existe.

- Un cousin du neutron découvert au Fermilab : le baryon Xi

L'article de Laurent Sacco sur les quarks est intéressant.

- Maintenir l'intrication dans la durée

C'est sans doute très important, par un mécanisme de correction d'erreur, on pourrait maintenir une intrication aussi longtemps qu'on le veut en s'affranchissant de la décohérence simplement en réparant toute perte de l'intrication qui se signale par une émission de photon en la rétablissant.

C'est sans doute très important, par un mécanisme de correction d'erreur, on pourrait maintenir une intrication aussi longtemps qu'on le veut en s'affranchissant de la décohérence simplement en réparant toute perte de l'intrication qui se signale par une émission de photon en la rétablissant.

- Limiter la décohérence avec un champ magnétique

Pour essayer de résoudre ce problème, des chercheurs s’intéressent aux aimants moléculaires. Il s’agit de molécules contenant des ions paramagnétiques et qui peuvent se comporter comme un aimant permanant macroscopique ; un excellent système à la frontière du monde classique et quantique d’une certaine façon.

L'expérience a montré l'importance du champ magnétique dans la prolongation de l'état de cohérence quantique du système, en plein accord avec les calculs. Les résultats obtenus suggèrent qu'il est possible d'atteindre un temps de décohérence d’environ 500 microsecondes, augmentant d’un facteur proche de mille les résultats précédemment obtenus dans ce domaine de recherche.

Cela paraît moins décisif que la correction d'erreur précédente mais devrait pouvoir se combiner avec ?

- Une nanosphère superposée en 2 endroits à la fois

Une sphère en verre de 40 nanomètres peut être repoussée par un laser mais il serait possible de superposer 2 positions à la fois...

Un alliage connu sous le nom de TPS qui peut, lorsqu'il est chauffé, passer progressivement d'un état amorphe à un état cristallin permettrait des mémoires qui ne se limitent pas à un 0 ou 1. De quoi permettre de simuler le fonctionnement des neurones notamment mais le problème, c'est qu'on perd ainsi la correction d'erreur alors que le numérique est parfaitement capable de simuler l'analogique.

- Des ondes solitaires dans l'eau

Ces phénomènes non linéaires qui ont causé la perte de nombreux bateaux se produisent encore plus dans les sociétés. On voit que lorsqu'il y a des secousses, on peut avoir une apparence de calme un moment avant qu'une vague gigantesque emporte tout... On appelle improprement ces phénomènes non linéaires des "cygnes noirs" car ils ne sont pas arbitraires ni aléatoires résultant d'une accumulation d'énergie précédente, seul le moment et l'endroit sont imprévisibles (expliquer n'est pas prédire).

Climat

Climat, écologie, énergies

Depuis une dizaine d'années, les événements El Niño semblent impacter davantage le centre que l'est du Pacifique tropical tout en étant moins intenses. Des chercheurs issus du Laboratoire d'études en géophysique et océanographie spatiales (LEGOS/OMP, UPS / CNRS / CNES / IRD), de l'Institut géophysique du Pérou (IGP) et de l'Université de Concepción (Chili) viennent de démontrer notamment que ce type d'El Niño, appelé El Niño Modoki, existait déjà dans le passé mais qu'il survenait moins souvent qu'aujourd'hui.

Enfin, étant donné que les effets de la variabilité tropicale ENSO se transmettent rapidement le long des côtes du Pérou et du Chili modifiant de manière drastique les écosystèmes qu'elles accueillent, cette étude jette les bases méthodologiques d'une étude d'impact d'ENSO sur le climat de ces régions.

Comme toutes les modifications du climat, les conséquences peuvent en être effectivement dramatiques pour certains territoires.

- Les trapps de lave causes des extinctions massives ?

Ce n'est pas vraiment nouveau et ne remet pas en cause l'hypothèse d'une collision avec un astéroïde qui aurait pu déclencher un tel épisode volcanique en Inde mais les extinctions massives pourraient être reliées principalement à la tectonique des plaques libérant des bulles gigantesques de magma chaud comme il en existerait encore à 3000km sous l'Afrique et qui dateraient de la formation de la Terre, il y a 4,5 milliards d'années, constituant ainsi des "bombes à retardement" !

Ce n'est pas vraiment nouveau et ne remet pas en cause l'hypothèse d'une collision avec un astéroïde qui aurait pu déclencher un tel épisode volcanique en Inde mais les extinctions massives pourraient être reliées principalement à la tectonique des plaques libérant des bulles gigantesques de magma chaud comme il en existerait encore à 3000km sous l'Afrique et qui dateraient de la formation de la Terre, il y a 4,5 milliards d'années, constituant ainsi des "bombes à retardement" !

Leur analyse suggère que le manteau contient une abondance de matières radioactives, produisant de la chaleur, ce qui en fait un endroit exceptionnellement chaud et potentiellement plus susceptible de former de grandes quantités de lave suffisantes pour créer des LIPs (Large Igneous Provinces).

- Le méthane marin cause de l'extinction du trias

C'est la confirmation du seul risque majeur du réchauffement et qui est beaucoup trop minimisé, celui du dégagement du méthane marin, cause de plusieurs extinctions par emballement soudain, au moins il y a 200 millions et 65 millions d'années.

Ce relevé indique qu’au moins 12 000 gigatonnes de carbone (sous forme de méthane) ont été libérées dans l’atmosphère au cours de cette période. Comme l'activité volcanique qui a accompagné l'éclatement de la Pangée a duré pendant au moins 600 000 ans, les chercheurs avancent que c’est cette courte libération de méthane, qui a duré entre 20 000 à 40 000 ans, qui est probablement responsable de l'extinction.

Un tel épisode de rejet massif n’est pas un évènement unique dans l’histoire de la Terre. Lors du Maximum thermique du passage Paléocène-Eocène, il y a 55,8 millions d’années, de 1,500 à 2,000 gigatonnes de carbone furent relâchées dans le système océan/atmosphère en mille ans. Ces rejets entrainent une augmentation importante des températures (le méthane est un des principaux gaz à effet de serre) et une modification drastique du climat.

Plusieurs causes peuvent expliquer ces largages massifs de carbone dans l’atmosphère, mais les auteurs estiment qu’il provient du plancher océanique, produits par des bactéries stimulées par le réchauffement déjà en cours. Elles auraient produit plus de méthane qui a lui-même à son tour accru le réchauffement et emballé le système de régulation thermique.

- Le Japon se lancerait dans l'exploitation du méthane marin

Une exploitation industrielle pourrait entraîner des rejets massifs de méthane dans l’atmosphère, un gaz à effet de serre beaucoup plus puissant que le CO2.

- Le Groenland et l'Antarctique pourraient fondre plus vite que prévu

Dans une étude parue dans Nature Geoscience, des chercheurs américains ont montré que l’océan qui entoure le Groenland subira une augmentation de température de 1,7 °C à 2 °C à l'horizon 2100 (voir le graphique ci-dessous). Concernant l’Antarctique, l’augmentation serait moindre (0,6 °C).

- Les feux de toundra rejettent de plus en plus de CO2

Le réchauffement de l'arctique devrait favoriser ces feux de toundra qui pourraient renforcer le réchauffement...

- Des pesticides pour la déforestation en Amazonie

Les pesticides coûtent moins cher que des bûcherons mais c'est bien sûr dramatique !

- Des terres rares sous la mer

Les gisements seraient considérables.

En attendant, des Japonais ont développé un moteur électrique de 50kW sans aimant permanent et donc sans Neodymium, une des terres rares les plus utilisées.

- Un navire récupérateur d'énergie des vagues

Une fois le navire entièrement chargé d'énergie, il reviendrait au port où l'énergie pourrait être distribuée sur le réseau en fonction des besoins.

Ce concept permettrait d'en finir avec les kilomètres de câbles de transmission indispensables pour acheminer l'électricité produite de la mer vers le continent, câbles dont les coûts ($ 500 000 du kilomètre selon The New Scientist) pèsent évidemment lourd sur la facture énergétique renouvelable.

Les batteries sont prévues pour avoir une capacité de 20 MW/heure, ce qui signifie que, pour faire le plein d'électricité, le navire devra rester en mer un peu plus de 20 heures. L'idée est de produire une électricité à 0,15 $ du kWh, ce qui est beaucoup moins cher que l'énergie produite à partir de la technologie houlomotrice habituelle dont le coût est estimé, aux USA, entre 0,30 $ et 0,65 $ du kWh. En comparaison, le coût de l'énergie éolienne l'offshore américain se situera dans une fourchette de 0,15 $ à 0,24 $ du kWh.

- Des voiles pour récupérer l'énergie houlomotrice

Les câbles, tendus entre deux bornes stations sous-marines dont l'une est un générateur, supportent les voiles sous-marines. Le courant pousse les voiles dans les deux sens et c'est ce mouvement, et non celui des pales d'une hélice, qui va faire tourner le générateur. D'après son constructeur cette technologie très innovante, calquée sur celle du spi des voiliers, aurait la capacité de surpasser toutes les technologies hydroliennes existantes surtout en matière d'efficacité d'extraction énergétique, de réduction des coûts d'installation, de maintenance.

Ce site https://energiesdelamer.blogspot.com... annonce la création d'un portail entièrement dédié aux énergies renouvelables de la mer : https://www.mer-veille.com.

La base en béton creux est remorquable sur site comme une barge et coulée sur le fond marin en la remplissant d'eau ou de sable. Le rotor est plus spectaculaire puisqu'il s'agit d'un rotor à 6 ailerons qui se déploient en fonction de la force du courant à traiter. De cette façon les rotors ne causent pas de friction inutile avec la masse d'eau et optimise l'énergie contenue dans le courant.

- Des champs magnétiques stimulent la croissance des algues

L'équipe de chercheurs a observé alors que les algues semblaient croître plus rapidement sous certaines conditions de niveau et de durée d'exposition aux champs magnétiques. Ce niveau d'exposition idéal a été découvert par l'équipe de Wang qui a pu optimiser les performances au point de quadrupler la croissance de la biomasse, augmentant la quantité de la masse oléagineuse à l'intérieur des algues, ainsi que la présence d' antioxydants très recherchés tels que l'Astaxanthin dans les cellules.

- Les algues à l'origine du pétrole

À partir d’une algue qui a contribué à la formation des gisements d’hydrocarbures fossiles, des chercheurs réinventent le pétrole. C’est une piste vers une nouvelle voie de production d’hydrocarbures à partir d’organismes vivants, que les chercheurs imaginent génétiquement modifiés.

L’algue Botryococcus braunii est remarquable par sa capacité à produire et à stocker une huile de très bonne qualité pour des réutilisations futures dans l’industrie pétrochimique.

Par ailleurs, on pourrait utiliser des algues pour aider à décontaminer l'eau rejetée par les réacteurs à Fukushima.

- Une photosynthèse artificielle

La technique développée par Wendy Flavell, professeur à l’institut des sciences du photon de l’Université de Manchester et ses collègues, se rapproche des systèmes végétaux, d’où le qualificatif de « photosynthèse artificielle ». Ce dispositif solaire est en effet pensé à l’échelle nanométrique : des boîtes quantiques servent de collecteurs de photons et des molécules-catalyseurs tapissent leur surface pour permettre les réactions chimiques. La longueur d’onde de la lumière absorbée peut être choisie en modifiant la taille de ces boîtes. Des porphyrines, un type de molécules impliquées dans la photosynthèse, sont également associées aux boîtes quantiques comme collecteurs de photons.

Une boîte quantique est un dispositif cristallin nanométrique et semi-conducteur exploitant les propriétés quantiques. Depuis des années, des travaux ont montré qu’elles pouvaient faire de très bons capteurs de lumière et des applications sont imaginées dans les domaines des lasers et des panneaux solaires. Ici, quand la lumière est absorbée, des transporteurs de charges électriques sont créés et interagissent avec un substrat au niveau du catalyseur pour produire le carburant. C'est une sorte de pile à combustible inversée alimentée en énergie solaire.

Il est ainsi possible d’extraire de l’hydrogène à partir d’eau ou de transformer du méthane en méthanol liquide.

La plus haute construction humaine devrait être une cheminée : deux fois la hauteur de l'Empire State Building. Il s'agit de la pièce maîtresse d'une centrale solaire qui devrait être établie à 200 km environ de Phoenix, à l'Ouest de la ville. On estime que cette centrale pourra alimenter 150 000 foyers.

- Des cellules solaires imprimées

L'efficacité n'est que de 1% mais le coût est très faible.

Par ailleurs DuPont investit dans une société commercialisant une peinture photovoltaïque à base de silicium et destinée à compléter les panneaux photovoltaïques plutôt qu'à les remplacer.

- Des cellules photovoltaïques à vaporiser

Mitsubishi Chemical a développé une technologie permettant de vaporiser, à l'instar des bombes de peinture, des cellules photovoltaïques sur des supports tels que des bâtiments ou des châssis de voitures.

Ces composés de carbone fonctionnent, une fois séchés et solidifiés, comme des semiconducteurs. Ils génèrent alors de l'électricité en réaction à la lumière.

De nombreux chercheurs essaient d'augmenter au maximum le rendement de la conversion d'électricité des cellules photovoltaïques en spray. Mitsubishi a ainsi développé le premier prototype au monde capable de convertir la lumière en électricité avec un rendement pratique de 10,1%.

Le procédé de fabrication de ces cellules étant très simple, la production en série du produit ne devrait pas être un obstacle et permettrait de diviser par dix le coût actuel de fabrication.

- Des métamatériaux élargissent le spectre des cellules photovoltaïques

Les métamatériaux peuvent transformer le rouge en bleu !

- Des cristaux optiques en 3 dimensions

Cette illustration montre l'arséniure de gallium (bleu) qui pousse autour d'un modèle pour créer un cristal photonique en trois dimensions.

De quoi améliorer les LEDs et les capteurs solaires.

- La production en quantité de nanotubes pour améliorer les transmissions électriques

Une méthode appelée amplification triple le volume de nanotubes du même type. De là à en équiper toutes les lignes électriques... L'avantage cependant, c'est qu'il n'y aurait pas de dissipation de chaleur.

- Des nanostructures pour doubler la capacité des batteries

Des nouvelles comme cela, il y en a tous les mois mais cette fois ce sont des Chinois qui développent ces batteries et surtout à un surcoût réduit à 20%, ce qui laisse présager une commercialisation prochaine de ces nouvelles électrodes pour batteries lithium-ions.

Des nouvelles comme cela, il y en a tous les mois mais cette fois ce sont des Chinois qui développent ces batteries et surtout à un surcoût réduit à 20%, ce qui laisse présager une commercialisation prochaine de ces nouvelles électrodes pour batteries lithium-ions.

- Stocker l'énergie solaire dans des nanotubes qui la restituent sous forme de chaleur

Un groupe de chercheurs du MIT aurait trouvé un nouveau principe de stockage efficace et peu coûteux avec un matériau basé sur des nanotubes de carbone. Il ne s'agit pour le moment que de calculs.

Le principe du stockage de l'énergie du rayonnement solaire est expliqué sur ce schéma. 1, la molécule absorbe du rayonnement, 2 elle change de forme en conséquence en traversant une barrière d'énergie séparant deux états quantiques (3). Elle reste dans un état excité indéfiniment en attendant une action extérieure (4), par exemple un flash de lumière ou un léger chauffage. Elle retourne alors à sa forme initiale (6) en libérant de la chaleur (5).

En fixant des molécules d’azobenzène, un composé chimique comprenant deux anneaux phényls liés par un double pont N=N, sur les nanotubes de carbone, le résultat devrait être spectaculaire si l'ont en croit les calculs des chercheurs.

Non seulement le matériau obtenu serait bien plus économe à fabriquer mais la densité de l’énergie stockée serait dix mille fois plus grande ! Ce qui le rend comparable à ce que l’on sait faire avec des batteries au lithium. De nouveau, l’énergie du rayonnement solaire est stockée indéfiniment grâce à un changement de forme de la structure moléculaire. On peut ensuite la libérer sous forme de chaleur.

C'est une alternative aux supercondensateurs mais ce n'est pas l'électricité qui est stockée, seulement la chaleur qu'on sait déjà assez bien stocker.

- Un ventilateur pour réduire de 7% la consommation d'électricité

Ce ventilateur silencieux augmenterait la vitesse des micro-processeurs tout en faisant baisser la consommation des ordinateurs. Avec ce "Cooler Sandia", le ventilateur est en même temps le dissipateur thermique : des bandes de lames métalliques tournent au-dessus de la source de chaleur placé sur un coussin mince d'air.

Ce projet soutenu par Bill Gates consiste à transformer nos déjections en hydrogène pouvant alimenter une lampe, voire un mécanisme d'auto-nettoyage.

- Des réacteurs nucléaires à uranium 238

Ce nouveau type de réacteur nucléaire dit "traveling wave reactor", et financé entre autres par Bill Gates, utilise juste un peu d'uranium 235 (uranium enrichi et rare) pour initier une réaction en chaîne utilisant ensuite de l'uranium 238 beaucoup plus abondant. Il est supposé plus sûr car il n'a pas besoin de système électrique pour le refroidir mais produit quand même, de façon transitoire, du plutonium 239. Le principe est proche de celui d'une mèche qui brûle d'un bout à l'autre jusqu'à épuisement du carburant. Les premiers projets parlaient d'en faire des réacteurs individuels alors qu'il s'agit désormais de construire une centrale classique sur ce nouveau principe.

- Des robots boules pour inspecter les canalisations des centrales nucléaires

Ces robots sont de trop grande taille pour qu’on puisse parler de poussière intelligente mais l’idée est similaire en cela qu’un nombre important de ces engins autonomes pourrait patrouiller en permanence dans les canalisations et en surveiller l'état. Ils doivent avoir une forme presque sphérique pour leur éviter de se retrouver coincés quelque part dans le réacteur. Ce qui veut dire qu’on ne peut pas utiliser d’hélice pour la propulsion ou pour orienter la sphère dotée d’une caméra.

- La carte de pollution aux PCB

- Du plastique à base de canne à sucre

- Les maisons Nano en kit de Tata à 500€

Le groupe Tata compte lancer sa maison Nano à monter en une semaine d'ici six à huit mois sur le marché national.

La maison-kit de 20 mètres carrés sera proposée au prix de 32.000 roupies (720 USD, 509 euros) et fournie avec portes, fenêtres et toit. Les murs intérieurs seront recouverts soit de jute soit de fibre de coco.

Voilà les seules images que j'en ai trouvé :

On trouve aussi ces images pour illustrer ces maisons en kit, ce qui serait beaucoup mieux mais bien peu probable ou alors une version de luxe qui ne serait pas au même prix (il faut attendre d'en savoir un petit peu plus) :

Biologie

évolution, génétique, biodiversité, éthologie, anthropologie, neurologie

- Des traces de photosynthèses de 3 milliards d'années

Les filaments sur cette image sont des restes de tapis microbiens datant de 3,3 milliards d'années.

La région de Barberton en Afrique du Sud est célèbre dans le monde de la géologie. On y trouve des roches datant de l’Archéen, non loin desquelles coule la rivière Komati. Elle a donné son nom à des laves particulièrement fluides qui coulaient là-bas il y a plus de 3 milliards d’années, les komatiites. Leur viscosité devait être similaire à celle de l’eau puisqu'elles s'écoulaient à des températures supérieures à 1.400 °C et probablement à plus de 1.600 °C.

En utilisant des microscopes électroniques et de la lumière synchrotron, les chercheurs ont examiné de plus près ce qui s’est révélé être les restes fossilisés d’un tapis microbien datant de 3,3 milliards d’années et qui s’était développé à la surface de sables volcaniques dans une zone de marécages de la région de Barberton. Ils y ont trouvé des filaments de 0,3 micromètre de long, correspondant à des microbes silicifiés et ainsi préservés par des fluides riches en silice d’origine probablement hydrothermale.

- Ce qui n'est pas génétique dans l'évolution

La présence d'une transmission culturelle des préférences sexuelles est fortement suspectée chez la mouche du vinaigre suite à une expérience publiée en 2009, qui utilisait des mâles poudrés en vert ou en rose, comme sur la photo. Il est apparu qu'après avoir observé trois fois de suite un mâle rose en train de copuler puis un mâle vert se faisant rejeter par une autre femelle, une femelle observatrice apprenait à préférer les mâles roses. L'inverse donnait les mêmes résultats. Cette expérience suggère que l'hérédité culturelle pourrait exister même chez des invertébrés non sociaux.

Aujourd'hui, les arguments s'accumulent qui montrent que l'évolution ne se cantonne pas à la seule information génétique, mais touche aussi à la transmission d'informations non contenues dans l'ADN. Celles-ci vont de la transmission de variation dans l'expression des gènes (ce que l'on appelle la variation épigénétique), à l'hérédité écologique et culturelle en passant par les effets parentaux. Il s'agit par exemple, chez l'homme, du savoir transmis socialement sur les risques d'ingestion de tel ou tel champignon.

L'article publié fournit de nombreux autres exemples de ces informations non génétiques, comme la tendance qu'ont les cafards à fuir la lumière, un comportement que l'on pensait entièrement contrôlé par les gènes avant qu'une étude ne montre qu'il est en partie acquis suite à des interactions sociales. Autre exemple: plusieurs travaux suggèrent que la manière de chanter chez certains oiseaux, appelée dialecte et dont on sait qu'elle est souvent transmise indépendamment de la variation génétique, peut conduire à l'isolement de groupes d'individus et à la spéciation, c'est-à-dire à l'apparition d'une nouvelle espèce.

- Un signal bioélectrique précéderait la différenciation des organes

Ainsi, le développement de la tête d'une grenouille est précédé d'un flux de particules chargées à l'endroit où doivent émerger les yeux, le nez, la bouche. En fait il y a d'abord des charges négatives dans tout l'embryon, puis des charges positives aux endroits indiqués, puis un flash final avant la différenciation. C'est un peu comme si on arrêtait tout le processus en se mettant en mode commande, qu'il y avait localisation (on ne sait comment) des zones à modifier puis une activation finale, se traduisant peut-être par un dépliement de l'ADN, avant de revenir à la normale, à un mode décentralisé.

Cela impliquerait que les gènes architectes utiliseraient cette localisation électrique ? En tout cas, cela confirme qu'il y a bien un plan préalable et non pas auto-organisation spontanée.

- La personnalité d'animaux sans cerveau

Même des animaux sans cerveau comme les anémones ont une "personnalité", des réactions typiques, ce qui n'est guère étonnant dès lors que le système hormonal est doté d'une variabilité naturelle selon les individus, mais le plus étonnant, c'est qu'elles semblent pouvoir résoudre des problèmes relativement complexes ou plutôt sont capables d'apprentissages basiques (comme fuir celui qui nous a déjà foutu une raclée), ne se réduisant donc pas à de purs automatismes.

Il ne serait pas impossible que les capacités d'apprentissages, qui prennent le relais de l'apprentissage génétique par la sélection naturelle, se soient développées sous la pression des conflits dans la même espèce et la constitution de hiérarchies, de même qu'on sait qu'on trouve les plus gros cerveaux chez les animaux qui vivent en groupe ou en meutes. L'extension aux autres facteurs de survie viendrait par surcroît.

- La sexualité pour lutter contre les parasites

L'avantage principal de la sexualité serait de protéger des parasites qui évoluent rapidement. Des espèces qui se reproduisent par clonage y succomberaient plus facilement (ce qui n'est pas bon pour les parasites non plus !). Ceci dit, un insecte a abandonné la reproduction sexuée il y a 1,5 millions d'années, ce qui pourrait être un phénomène assez courant quitte à la retrouver ensuite. Il y a aussi des papillons moitié mâle, moitié femelle :

- La disparition des grands prédateurs mène aux catastrophes...

Quand on retire le superprédateur, c'est tout l'écosystème qui est perturbé. Selon une étude récente, ces perturbations peuvent avoir des conséquences bien plus larges que ce qu'on imaginait.

Au sein de cet écosystème, la diminution du nombre de grands prédateurs, comme le léopard ou le lion, a entraîné une cascade d’événements : les babouins olive, exposés à une prédation amoindrie, se sont multipliés. Leurs exigences en espace et en nourriture ont augmenté et ils se sont ainsi rapprochés des habitations humaines. Les parasites intestinaux des babouins, dont la population a augmenté en même temps que celle des babouins, ont finalement été transmis aux humains. Voici l’exemple de la modification d’une chaîne alimentaire ayant des conséquences sanitaires pour l’Homme.

Autre exemple : en Afrique de l’Est, l’introduction de la peste bovine a provoqué le déclin des populations des grands herbivores tels que le gnou ou encore le buffle. Cause immédiate : augmentation du couvert végétal (voir l'illustration ci-dessus), ce qui provoque une augmentation de l’ampleur des incendies dans les plaines.

Un herbivore peut donc être un superprédateur ! Rien de bien neuf puisque l'auteur de Robinson Crusoé racontait déjà des histoires de ce genre avec surpopulation de chèvres sur une île où l'introduction de prédateurs rétablissait un équilibre.

Les chercheurs racontent que les Neonothopanus gardneri éclairent presque assez pour servir de liseuse !

La raison de cette luminescence reste mystérieuse mais cela pourrait attirer des insectes pollinisateurs ? ou éviter d'être piétinés ?

- Une plante qui attire les chauve-souris

La plante serait une sorte de balise à ultrasons facilement repérable par les chauve-souris qui la pollinisent.

- Un ver hydrothermal au microscope

Bien évidemment cette image a été prise par un microscope électronique extrêmement puissant. Celui-ci peut amplifier jusqu’à un million de fois les sujets à l’étude.

L’animal à l’air aimable qui se trouve sur l’image est en réalité un ver. Celui-ci s’épanouit dans des fissures terrestres où l’on trouve des gazs chauds et beaucoup d’humidité. Pour info ce ver hydrothermal n’est pas pourvu de tube digestif, il est rempli de bactéries qui transforment l’hémoglobine en composés de carbone. L’organisme du ver peut ensuite les assimiler aisément.

- L’œil de l’anableps voit aussi bien dans l'air que dans l'eau

L’œil de l’anableps , ce petit poisson d'eau douce vivant dans les mangroves, est bien connu pour son architecture étonnante qui lui permet de voir à la fois sous et hors de l’eau. Un étudiant canadien vient de montrer que les deux parties de la rétine sont elles aussi spécialisées grâce une jolie astuce génétique.

La coupe de l'œil de l'anableps montre les deux zones de la rétine (en rouge) spécialisées chacune pour recevoir la lumière venant de l'air ou de l'eau. Les deux trajets de la lumière sont marqués par les lignes noires. On remarque que la forme du cristallin (la lentille) n'est pas la même pour les deux directions.

- Un poisson qui fracasse un coquillage sur un rocher

- Le crapaud arc-en ciel réapparait

On ne l'avait pas vu depuis 1924 !

- Le fossile d'un insecte hybride

Des ailes d’éphémère, un corps de libellule et des pattes de mante religieuse, ce fossile d’insecte découvert au Brésil aurait 120 millions d'années.

Les larves de Coxoplectoptera (qui ressemblent à de petites crevettes) étaient probablement aquatiques et devaient flotter sur l’eau. Après sa métamorphose, l’insecte avait un mode de vie mixte, l’exosquelette renforcé et certaines pièces buccales indiquent qu’il était sans doute capable de creuser de petites galeries sur les rives afin de piéger ses proies.

Ils pensent avoir trouvé des indices établissant que les ailes se forment à partir de plaques dorsales thoraciques sous le contrôle de gènes liés aux pattes qui sont recrutés pour guider leur développement.

- Un seul gène pour les ailes du papillon

Article intéressant à la fois pour les phénomènes de convergences et pour les rôles multiples d'un seul gène.

Un seul gène peut donc être à l’origine d’une variété de caractéristiques physiques. Il semblerait qu’une variabilité du segment cis-régulateur, qui permet de déclencher l’expression du gène, soit à l’origine de la variabilité phénotypique. De plus, ce même gène optix est aussi responsable de la couleur des yeux du papillon.

- Mortalité des abeilles due à l'association entre insecticides et parasites

L'infection par Nosema ceranae, un parasite responsable de la nosémose, entraîne une plus forte mortalité des abeilles lorsque celles-ci sont exposées à de faibles doses d'insecticides.

Cet effet combiné sur la mortalité des abeilles apparaît pour une exposition quotidienne à des doses pourtant très faibles (plus de 100 fois inférieures à la DL50 de chaque insecticide). La synergie observée ne dépend pas de la famille d'insecticides puisque les deux molécules étudiées, le fipronil et le thiaclopride, appartiennent à des familles différentes.

Voir aussi Futura-Sciences. Mais, en fait, c'est leur système immunitaire qui est atteint et qui ne résiste plus ni aux champignons, ni aux acariens, ni aux virus.

- Les dinosaures avaient bien le sang chaud

En étudiant le foramen du fémur, cet orifice qui laisse passer les vaisseaux sanguins, des chercheurs australiens, canadiens et allemands ont montré que les dinosaures avaient une activité importante. Ce qui suggère qu'ils étaient des animaux à sang chaud.

Cela fait bien 10 fois qu'on le prouve ! En tout cas, il y avait effectivement des dinosaures au moment de la chute de l'astéroïde, il y a 65 millions d'années, ce dont certains semblaient douter...

- Pour les oiseaux se tenir sur 2 pattes précède le vol

Le chercheur croit que l'émergence de muscles agrandis pour pouvoir se tenir sur deux pattes aurait permis de ce fait les capacités tant pour le vol que pour la nage.

Tout cela ne serait dû qu'à la perte d'un gène qui est critique pour les autres animaux à sang chaud de générer de la chaleur pour leur survie (cela protège les nouveaux nés mammifères de l'hypothermie grâce à l'action de cellules graisseuses particulières). Chez les oiseaux, la chaleur provient des muscles. Cette théorie est séduisante, car elle explique que certains oiseaux ne doivent pas impérativement avoir des ancêtres volants (on pense aux autruches ou aux pingouins).

Ce qui distingue l'oiseau de l'homme est donc bien qu'il est "un animal bipède et sans plumes" !

La conclusion serait qu'Archaeopteryx ne serait plus un oiseau...

Voir aussi The Telegraph.

- Pour les perruches, même le cri est appris

Quand elle est jeune, la perruche se voit attribuer une signature par ses parents adoptifs ou biologiques : l’adulte qui s’occupe des jeunes leur donne un modèle de cri que chacun des jeunes adapte pour qu’il devienne unique. Une sorte de nom.

D’abord, ce ne sont pas nécessairement les parents biologiques qui enseignent les cris à leur progéniture. C’est simplement le premier adulte qui va s’en occuper. En outre, quand l’adulte qui enseigne le cri n’est pas un des parents biologiques, le cri appris ne ressemble pas nécessairement à celui des parents biologiques. Preuve que ce cri n’a aucune source génétique.

- Le premier qui sort de l'oeuf se débarrasse de l'autre

Les "Fous de Nazca" (Nazca booby) pondent 2 oeufs mais le premier qui naît est très agressif, bourré de testostérone, et repousse l'autre oeuf, le condamnant à mort, celui-ci n'étant qu'un oeuf de secours alors qu'un seul petit peut être élevé à la fois. Pour les "Fous à pieds bleus" (représenté sur l'image ci-contre), les niveaux de testostérone sont moins élevés et l'agression sur les plus jeunes ne se produit qu'en cas de manque de nourriture.

Les "Fous de Nazca" (Nazca booby) pondent 2 oeufs mais le premier qui naît est très agressif, bourré de testostérone, et repousse l'autre oeuf, le condamnant à mort, celui-ci n'étant qu'un oeuf de secours alors qu'un seul petit peut être élevé à la fois. Pour les "Fous à pieds bleus" (représenté sur l'image ci-contre), les niveaux de testostérone sont moins élevés et l'agression sur les plus jeunes ne se produit qu'en cas de manque de nourriture.

- Les dauphins mettent des gants pour fouiller le fond

Pour ne pas ne faire mal au bec en fouillant les fonds marins, les dauphins ont appris à mettre une éponge...

- Un dauphin qui chasse à l’électricité

Le dauphin de Guyane est capable de repérer ses proies en détectant leur champ électrique.

C’est un nouveau sens que les biologistes viennent d’identifier chez le dauphin de Guyane (Sotalia guianensis) : l’électroréception. Jusqu'à aujourd’hui, cette capacité n’était connue que chez les poissons, les amphibiens, et deux mammifères ovipares, ou monotrèmes, l'ornithorynque et l'échidné.

Les biologistes ont pu étudier des structures présentes sur son rostre et appelées « cryptes vibrissales » qui sont associées aux moustaches chez les mammifères. Après examen, les chercheurs n’ont pas trouvé trace de poil à l’intérieur mais une substance gélatineuse, semblable au gel présent dans les récepteurs électrosensibles des poissons et au mucus présent dans ceux de l'ornithorynque.

Cette découverte devrait en amener d’autres. En effet, l’étude montre que l’électrorécepteur est dérivé d’un organe mécanosensoriel présent chez la grande majorité des mammifères. Il est donc vraisemblable d’en trouver chez d’autres espèces, particulièrement chez celles qui ont un mode de vie aquatique ou semi-aquatique.

Voir aussi Futura-Sciences.

- La vie sociale des éléphants d'Asie

Au lieu des trois amis supposés, il apparaît que les éléphants étudiés peuvent en avoir plus de dix, et même jusqu’à cinquante ! L’équipe a aussi remarqué que les animaux les plus sociables étaient les plus volages, changeant fréquemment de camarades, alors que ceux qui ont un groupe plus restreint sont fidèles à un noyau dur. Enfin, au lieu de perdre contact avec d’anciens amis, ces pachydermes conservent des liens forts même après des absences de plus d’un an.

- Des Gibbons aux joues blanches

Les gibbons s'avèrent être les singes les plus romantiques puisqu'ils destinent constamment leur chant à leur dulcinée à qui ils demeurent fidèles leur vie durant. On estime ces primates en péril puisque certains les chassent pour l'apparente vertu médicale de parties spécifiques de leur corps. La perte de leur milieu de vie naturel constitue également une très grande menace qui pèse sur ces animaux en voie d'extinction.

- Des singes utilisent des bouts de bois pour se faire les ongles

Sinon, des scientifiques s'affolent à l'idée qu'on fasse des singes sachant parler...

- La bipédie dès les premiers Australopithèque, il y a 4 milliards d'années

Les caractères de la marche bipède moderne seraient bien plus anciens que prévu. Des chercheurs anglais ont analysé très précisément les fameuses empreintes de pas de Laetoli, en Tanzanie. Elles ont été laissées par un ancêtre qui se tenait bien droit et marchait un peu comme nous...

Ça n’est pas l’arrière du pied qui assure la locomotion. Au contraire, Australopithecus afarensis se tenait droit, et c’est l’avant du pied, en particulier le gros orteil, qui dirigeait la marche comme c’est le cas pour nous près de 4 millions d’années plus tard.

Nombre de publications imaginaient l’émergence de ces fonctions il y a 1,9 million d’années seulement.

Mais malgré ses pieds efficaces et sa démarche altière, les scientifiques britanniques se refusent encore à croire que l’animal ait pu marcher ou courir sur de longues distances. La faute au reste de sa morphologie, un corps long et des jambes courtes à l’inverse d'Homo sapiens, un cousin apparu bien plus tard et qui a su marcher tout autour de la planète.

Voir aussi "Pour la Science".

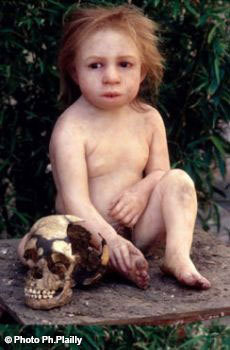

- Confirmation des traces de Neandertal dans notre ADN hors d'Afrique

Une nouvelle étude confirme que des gènes de Néandertal subsistent aujourd’hui chez les populations hors de l’Afrique sub-saharienne. Il y aurait bien eu hybridation en Europe il y a quelques dizaines de milliers d’années, comme d’autres études l’avaient montré.

On n'insiste pas assez sur le fait que cette hybridation était exceptionnelle, sinon unique pour se retrouver identique dans toutes les populations du monde hors d'Afrique. Il faudrait rappeler aussi qu'on ne trouve pas trace de Neandertal dans l'ADN des mitochondries, ce qui signifie qu'il n'y a pas eu de mère néandertale dans notre lignée. Même si, normalement, les croisements n'étaient pas viables soit pour des raisons de volume du crâne par rapport au bassin de la femme, soit des risques d'éclampsie comme l'hypothèse en a été faite, cela n'empêche pas que quelques rejetons aient survécu. Il faudrait plutôt rapprocher la date supposée de cette hybridation avec celle de l'explosion culturelle, géographique et démographique. Une étude génétique a prétendu que c'était un gène lié au risque (et au TADH) qui nous distinguait des Africains. C'est peut-être qu'il fallait être un peu folle pour risquer ces relations presque toujours mortelles pour la femme ? Tout cela reste très hypothétique.

- Des "goulots d'étranglement" il y a 10 000 et 60 000 ans

C'était déjà connu mais une méthode plus précise confirme des "goulots d'étranglement" pour les populations hors d'Afrique il y a 10 000 et 60 000 ans, dans une moindre mesure pour les Africains. La question qui se pose est celle de savoir si c'est à cause de quelque cataclysme ou plutôt par le remplacement, sans croisement, des anciens hommes par une petite population plus évoluée, par exemple à cause du langage il y a 60 000 ans et de l'agriculture il y a 10 000 ans ?

- Pas de grand-parents avant 30 000 ans

On mourait trop tôt avant pour être grand-parent mais on peut penser que cela a constitué un grand progrès pour la mémoire du groupe, la transmission et la complexification de la culture. Ce serait notamment, ce qui nous différencierait de Néandertal (avec une plus grande néoténie aussi) puisqu'il n'y avait chez lui que 4 trentenaires pour 10 jeunes néandertals de 15 à 30 ans alors qu'il y en avait 20 pour 10 jeunes sapiens ! Cela aurait pu commencer vers 60 000 ans pour un tout petit nombre et expliquer largement le bond en avant de cette époque fondatrice ? Difficile de savoir pourquoi la durée de vie s'est allongée. La raison en pourrait être génétique ou dans la nourriture ou la façon de la cuire ou les techniques de chasse. On peut imaginer tout autant une raison culturelle comme le "respect des anciens" ? Celui-ci pourrait être lié au langage narratif et aux mythes ?

On mourait trop tôt avant pour être grand-parent mais on peut penser que cela a constitué un grand progrès pour la mémoire du groupe, la transmission et la complexification de la culture. Ce serait notamment, ce qui nous différencierait de Néandertal (avec une plus grande néoténie aussi) puisqu'il n'y avait chez lui que 4 trentenaires pour 10 jeunes néandertals de 15 à 30 ans alors qu'il y en avait 20 pour 10 jeunes sapiens ! Cela aurait pu commencer vers 60 000 ans pour un tout petit nombre et expliquer largement le bond en avant de cette époque fondatrice ? Difficile de savoir pourquoi la durée de vie s'est allongée. La raison en pourrait être génétique ou dans la nourriture ou la façon de la cuire ou les techniques de chasse. On peut imaginer tout autant une raison culturelle comme le "respect des anciens" ? Celui-ci pourrait être lié au langage narratif et aux mythes ?

- Les groupes humains 10 fois plus nombreux que Neandertal

Outre que Neandertal en était encore au Châtelperronien alors que les Sapiens en étaient à l'Aurignacien (avec notamment l'art pariétal), les Sapiens devaient être 10 fois plus nombreux - à relier avec la brève précédente, un allongement de la longévité pouvant être une des raisons de cet accroissement démographique. On supposait que le Châtelperronien était contemporain de l'Aurignacien à cause de mouvements de terrain ayant mélangé les strates mais le premier serait bien spécifique de Neandertal et le second de Sapiens, les différences étant à la fois démographiques, culturelles (plus d'interactions sociales et d'échanges "marchands") et techniques (notamment pour la conservation de la nourriture), ce qui devrait suffire à expliquer leur suprématie et la disparition de Neandertal, opposé à des groupes bien plus nombreux que lui, au moment d'un soudain refroidissement, vers 40 000 ans. L'histoire n'est cependant pas linéaire (voir brève suivante) et il faut se rappeler que ce n'est pas la seule disparition de populations, le remplacement par de nouvelles vagues de colons (les agriculteurs notamment) étant bien la norme habituelle et non le métissage, qui est une pratique assez récente sur grande échelle, même entre Sapiens !

Voir aussi The Telegraph.

- Le Gravettien remonterait à 34 000 ans

Le site Buran-Kaya III, en Crimée du Sud, révèle que la culture gravettienne est apparue en Europe de l'Est plus tôt qu'on ne le pensait. Ses individus appliquaient un traitement mortuaire à des crânes humains (cannibalisme ?).