- La synthèse de l'ARN aux origines de la vie

- Le chaînon manquant : notre ancêtre lémurien

- Le calcul mental comme déplacement spatial

<- Revue des sciences précédente | Revue des sciences suivante ->

Revues : Pour la Science - La Recherche

Brèves : Physique - Climat - Biologie - Santé - Technologie

La physique nous réserve encore des surprises de taille malgré la panne du LHC. Ce mois-ci ce sont les singularités nues qui risquent de remplacer les trous noirs comme objet central de la gravitation quantique (unification de la relativité générale et de la mécanique quantique) alors que le retour de la supergravité pourrait menacer la théorie des cordes et que le débat fait rage pour savoir si l'énergie noire est constante ou décroit. Pendant ce temps là, justement, l'Autriche quitte le LHC pour faire des économies en ces temps de crise... Du côté du climat il n'y a pas que des mauvaises nouvelles pour une fois, ce qui est une surprise en soi, puisque le soleil pourrait ralentir le réchauffement, ce qui ne devrait pas durer longtemps, mais c'est toujours ça de pris car on est de mieux en mieux outillé et c'est essentiellement une course de vitesse. Sauf que c'est un peu comme pour la crise, il suffit d'une petite amélioration pour bloquer toute action et, alors qu'on risque une catastrophe pire que prévue, on peut s'attendre à ce qu'on en profite plutôt pour brûler le pétrole supplémentaire devenu accessible par la fonte de l'Arctique ! Il se pourrait aussi que les cycles de Dansgaard-Oeschger soient à prendre en compte, aggravant la situation dans l'hémisphère nord. La découverte de notre ancêtre lémurien n'est pas rien car c'était un chaînon manquant et les voies de la synthèse de l'ARN renforcent l'hypothèse d'un monde ARN à l'origine de la vie. A part ça, la perspective d'implanter des RFid dans le cerveau pour servir de neurostimulateur semble un peu effrayante alors que cela pourrait s'avérer fort utile pourtant. On ne s'émerveille même plus de pouvoir (difficilement) écrire par la pensée, ni de commander un curseur avec les yeux. Par contre, l'arrivée des pico-projecteurs lasers est sans doute loin d'être un gadget, pouvant éventuellement rivaliser avec les écrans pour une consommation très inférieure. D'autant plus que la déportation de la puissance sur le réseau achève la suppression de la séparation entre téléphone et ordinateur. Reste la question du clavier. Enfin, signalons que Science&Vie a refondu complètement son site (sans grand intérêt) et que le service d'abonnements de La Recherche a été complètement désorganisé par son déménagement ! A ce jour, il n'est toujours pas assuré que cette revue des sciences continue, on verra bien...

Pour la Science no 380, Les singularités nues

- Les singularités nues, p22

On n'est pas du tout certain que les singularités nues existent, c'est-à-dire des effondrements gravitationnels sans horizon de schwartzschild pour piéger la lumière. On n'était pas tellement sûr non plus de l'existence des trous noirs (qu'on n'a jamais vraiment vu encore, et pour cause) mais la simple hypothèse théorique des singularités nues permet déjà de dissiper pas mal de fantasmes et d'obscurantismes liés à l'opacité de trous noirs. En effet, ce n'est pas parce qu'on ne voit plus ce qui se passe que c'est si différent du reste de l'univers, à l'exception peut-être de la singularité elle-même à l'échelle de Planck. Un grand pas donc dans l'éclaircissement de la question, même si, répétons-le, les singularités nues n'existaient pas. Par ailleurs, on verra dans les brèves qu'il y a le retour de l'hypothèse que les particules seraient des trous noirs mais elles pourraient aussi bien être des singularités nues ?

La densité y devient bien infinie, mais ce n'est pas le cas de l'intensité de la gravité, si bien que la relativité générale n'y est jamais mise en défaut. La matière tombant sur ces singularités ne serait pas comprimée en une tête d'épingle, et les traverserait plutôt que d'y disparaître.

Dans une étoile homogène, toute l'étoile se condense dans un même mouvement en un point. Au centre, la gravité devient vite telle que la lumière est piégée bien avant que la singularité se forme. Celle-ci reste donc cachée par l'horizon.

Considérons maintenant une étoile où la densité décroît du centre vers la surface, avec une structure en oignon, formée de couches concentriques de matière de densité différente (on néglige la pression). L'intensité de la gravité agissant sur chaque couche dépend de la masse de celle-ci. Les couches internes, plus denses, étant soumises à une attraction gravitationnelle plus forte, elles s'effondrent plus vite que les couches plus externes. Toute l'étoile ne s'effondre pas en même temps en une singularité. Le délai qui apparaît ainsi entre l'effondrement des différentes couches peut retarder la formation d'un horizon des événements. Si l'horizon peut se former quelque part, ce sera dans les couches internes, les plus denses. Mais si la densité décroît trop rapidement avec la distance, les couches internes ne représentent pas suffisamment de masse pour que la compacité critique soit atteinte et que la lumière soit piégée. La singularité qui se forme est donc nue. Ainsi, si l'inhomogénéité est faible, un trou noir se forme, mais au-dessus d'une valeur critique, c'est une singularité nue qui apparaît.

Une singularité marquerait l'endroit où le monde physique se termine. Nous devrions l'envisager comme un événement plutôt qu'un objet, un moment où la matière en effondrement atteint un « bord » et cesse d'être, comme un Big Bang inversé.

Dans ce cas, des questions comme « Que peut-il sortir d'une singularité nue ? » n'ont pas vraiment de sens : il n'y a aucun endroit duquel sortir, parce que la singularité est seulement un moment dans le temps. Ce que nous observons n'est pas la singularité elle-même, mais les processus qui se déroulent dans des conditions extrêmes dans le voisinage de cet événement.

Ces théories supposent une densité infinie peu pensable, comme tout ce qui est infini, et une perte de masse qui devrait pouvoir se mesurer. Théorie des cordes et gravitation quantique à boucles évitent ces infinis.

Pour étudier l'apport observationnel potentiel des singularités, nous avons récemment simulé l'effondrement d'une étoile en une singularité nue, en prenant en compte les effets prédits par la gravitation quantique à boucles. Selon cette théorie, l'espace est constitué de minuscules quanta, qui deviennent perceptibles quand la matière est suffisamment dense ; il en résulte une force répulsive qui empêche la densité de devenir infinie. Dans notre modèle, une telle force répulsive disperse l'étoile et dissout la singularité. Près du quart de la masse de l'étoile est ainsi éjectée au cours de la dernière fraction de seconde. Juste avant, un observateur lointain aurait vu brusquement diminuer l'intensité du rayonnement issu de l'étoile en train de s'effondrer, résultat direct d'effets de la gravitation quantique.

L'explosion libérerait des rayons gamma de haute énergie, des rayons cosmiques et d'autres particules telles que des neutrinos.

- Influences subliminales, p30

La motivation subliminale pousse à agir sans que le sujet concerné n'en ait conscience. Mais elle ne peut pas forcer cette personne à agir contre sa volonté...

Les théories en vogue, telle celle du neurobiologiste français Stanislas Dehaene, distinguent deux étapes dans la perception : une première non consciente traitant les attributs dits de bas niveau, et une seconde consciente pour les attributs dits de plus haut niveau. La frontière entre bas et haut niveau a fait l’objet d’intenses controverses. Les attributs de bas niveau ont longtemps été limités à des caractéristiques élémentaires telles la forme, la taille et la couleur. Aujourd’hui, on sait que les traitements non conscients sont en fait plus riches, incluant même les aspects sémantiques.

En 1972, les psychologues américains Robert Rescorla et Allan Wagner ont énoncé une loi simple pour décrire la dynamique de l’apprentissage, c’est-à-dire la formation des associations au cours du temps.

Cette loi stipule que l’apprentissage est à la mesure de la surprise. Si on est surpris par le résultat des actions, on apprend plus et plus vite. Si l’on n’est pas surpris, cela signifie que l’on pouvait prévoir le résultat, et donc qu’on connaissait déjà l’association. Dans le cas de l’apprentissage par renforcement, la surprise correspond à l’erreur de prédiction de la récompense : la différence entre la récompense obtenue et la récompense qui était attendue. Autrement dit, si l’on obtient plus de récompense que prévu, les associations sont renforcées ; si l’on en obtient moins, elles sont au contraire affaiblies.

Quel est donc l’effet des récompenses sur le comportement ? Les indices prédisant la récompense ont la double capacité d’orienter le comportement – vers l’alternative la mieux récompensée – et d’augmenter son intensité – d’autant plus que la récompense est importante.

Ce phénomène de motivation subliminale est accompagné d’une augmentation de la conductance cutanée, proportionnelle aux enjeux monétaires. Cette réaction est liée à la transpiration, résultant elle-même de l’activation du système nerveux végétatif. Elle est considérée comme un reflet des réactions émotionnelles et elle augmente en cas de stress notamment.

Comment se comportent les participants si on démasque les stimulus, c’est-à-dire si on leur montre explicitement les pièces de monnaie ou les indices annonçant le résultat du pari ? Les résultats sont les mêmes, mais les sujets, en moyenne, font plus d’effort ou prennent plus de risques quand les stimulus annoncent davantage de récompense. Autrement dit, les effets des stimulus conscients sont plus importants, mais qualitativement identiques à ceux obtenus avec les stimulus inconscients. C’est aussi vrai des activations cérébrales : ce sont les mêmes circuits qui s’activent et orientent le comportement quand la motivation est consciente, mais l’efficacité est supérieure.

En d’autres termes, si les participants avaient été conscients des stimulus, ils auraient agi comme ils l’ont fait, mais avec plus de force et de constance. Nous ne voyons donc pas bien l’intérêt qu’auraient les publicitaires à masquer leurs messages ; ils ne feraient que dégrader les effets recherchés sur le choix des consommateurs…

Ecouter l'émission sur France-Culture.

- Bientôt des pico-projecteurs laser, p50

Le vert manquait à la palette des diodes laser. De nouvelles techniques sont en train de combler cette lacune de la gamme des lasers miniatures.

Cette avancée permettra de réaliser des projecteurs de haute qualité et assez petits pour tenir dans un téléphone portable.

L'intégration de pico-projecteurs aux portables (depuis fin 2008 avec le MPRO 110 de 3M de qualité inférieure) pourrait permettre de se passer d'écrans, au moins dans certains cas. Or ce sont les écrans qui consomment le plus d'électricité. Ces appareils plus performants devraient sortir dès la fin de l'année (Le show WX de Microvision et l'appareil de Light Blue Optics).

Voir aussi TechnologyReview.

- Des oeufs durs aphrodisiaques ?, p99

Les œufs durs mal cuits auraient-ils, grâce à l'hydrogène sulfuré, des vertus aphrodisiaques ?

On vient de découvrir que l'hydrogène sulfuré est efficace contre les dysfonctionnements de la fonction érectile ! Roberta d'Emmanuele di Villa Bianca et ses collègues des Universités de Naples, de Glasgow et de Los Angeles ont étudié les tissus du pénis et découvert que ces tissus expriment de l'hydrogène sulfuré : le gaz favoriserait l'érection en relâchant les tissus autour des vaisseaux sanguins, permettant l'afflux de sang dans le pénis.

Autrement dit, le gaz à l'odeur d'œuf pourri pourrait trouver sa place dans une thérapeutique utile, notamment en complément du Viagra, qui n'est pas efficace chez tous les patients.

Le Viagra stimule la production de monoxyde d'azote, qui relâche les tissus péniens. Le traitement par l'hydrogène sulfuré semble analogue, relaxant le muscle lisse du tissu pénien nommé corps caverneux, mais par une chaîne moléculaire différente. Toutefois, un médicament ne sera pas disponible avant une dizaine d'années. En attendant, les terrines de truite aideront peut-être l'hydrogène sulfuré ingéré à agir là où il est attendu.

La Recherche no 431, Neandertal, pourquoi a-t-il disparu ?

On ne s'apesantira pas sur la disparition de Neandertal dont on a déjà parlé (l'émergence de l'humanité), sinon pour noter qu'entre 60 000 et 25 000 ans, réchauffements et refroidissements brusques se sont succédé tous les 500 à 1470 ans, en suivant des cycles de Dansgaard-Oeschger (cycles inexpliqués à ce jour, peut-être liés au Gulf Stream). Entre 2 phases, la température atmosphérique du Groenland pouvait varier de plus de 10°C. Certains pensent que ce cycle est spécifique aux périodes glaciaires alors que d'autres pensent qu'il pourrait expliquer en partie le réchauffement de l'Atlantique nord depuis le petit âge glaciaire. Bien sûr cela ne concerne pas le réchauffement global et n'élimine en rien la part humaine mais pourrait plutôt l'aggraver dans l'hémisphère nord !

- Un algorithme pour découvrir des lois de la nature, p28

Deux chercheurs viennent de publier un algorithme pour produire, à partir de données tirées de l'expérience, un système d'équations simples.

Il collectent toutes les données du système à étudier, puis ils calculent la manière dont elles varient les unes par rapport aux autres, c'est-à-dire qu'ils en estiment de façon approchées les "dérivées partielles". Ils fabriquent ensuite des formules mathématiques à tester, d'abord au hasard. Une formule étant à tester, on en calcule les dérivées partielles que l'on compare alors à celles fournies par les données. L'algorithme ne retient alors que les formules les plus précises et les plus simples.

Brèves et liens

Physique

cosmologie, astronomie, physique quantique

- Le retour de la supergravité

La nouvelle est potentiellement considérable mais c'est surtout l'article de Laurent Sacco qui est intéressant, c'est la science en train de se faire, la science des hypothèses. Non pas qu'on puisse y comprendre quelque chose mais cela n'empêche pas que ce soit passionant à lire. Ne pas comprendre ne doit pas être un obstacle à la lecture. On commence toujours par ne pas comprendre mais à force, on finit par avoir une petite idée de ce dont il s'agit. En tout cas on pourrait peut-être se passer de la théorie des cordes (ce qui m'étonnerait quand même), théorie qui n'est d'ailleurs qu'une généralisation, par une autre généralisation : ce qui confirme que la physique avance par unification des forces. Il faut quand même dire que pour l'instant, on n'a découvert aucune particule supersymétrique...

En 1976, un groupe de physiciens, Daniel Z. Freedman, Peter van Nieuwenhuizen et Sergio Ferrara, de l’Université de Stony Brook, découvrirent une merveilleuse généralisation de la théorie de la relativité générale qu’ils baptisèrent la supergravité.

Les particules de matière comme les neutrinos et les quarks sont décrites par des spineurs alors que les gluons et les photons par des vecteurs. C’est une autre façon de dire que les particules de matière sont des fermions alors que les particules médiatrices des forces sont des bosons.

Dans le cadre de la supersymétrie, il est possible de considérer une sorte de super-espace dans lequel les bosons et les fermions sont des composantes d’une sorte de super vecteur qui peut tourner autour de l’analogue d’axes dans l’espace. De cette façon, fermions et bosons deviennent inséparables et à chacune des particules connues dans le modèle standard des interactions correspond un superpartenaire. Ainsi, aux quarks fermioniques sont associés des bosons, les squarks, et aux gluons et photons bosoniques sont associés des gluinos et des photinos, qui sont des fermions.

Il se trouve que la supersymétrie conduit naturellement à considérer une généralisation de la théorie d’Einstein, cette dernière, même, s’en déduit. La différence est que l’analogue du photon des ondes électromagnétiques devient pour les ondes gravitationnelles, dont on a des preuves indirectes avec l’étude des pulsars, une particule bosonique que l’on appelle le graviton, qui n’est pas un vecteur mais un tenseur. Il existe cependant un superpartenaire associé au graviton et qui est un fermion, le gravitino.

De plus, la théorie incorporait un grand nombre de nouvelles particules qui ressemblaient aux particules du modèles standard et surtout, elles étaient suffisamment nombreuses pour pouvoir peut-être correspondre à toutes celles que l’on connaissait alors.

L’espoir du début des années 1980 était donc que si l’on savait faire correctement tous les calculs dans la théorie de supergravité, non seulement on pourrait en déduire le modèle standard mais on finirait aussi par prouver que toutes les divergences infinies disparaissaient dans tous les calculs possibles. Le prix Nobel Murray Gell-Mann était par exemple parvenu à dériver l’existence de fermions qui possédaient les mêmes charges fractionnaires que les quarks.

Hélas, assez rapidement, on découvrit que la supergravité N=8 était désespérément rebelle à la présence de neutrinos et d’électrons violant la parité comme dans le modèle des interactions électrofaibles.

Si l’on en croit les travaux de chercheurs comme Michael Green, Pierre Vanhove et plus récemment Zvi Bern et Lance Dixon, certaines des divergences que l’on croyait devoir apparaître en supergravité N=8 au début des années 1980 lorsque l’on serait capable de pousser les calculs quelques crans plus loin… ne sont tout simplement pas là !

Il se pourrait donc bien qu’une théorie de supergravité pure en 4 dimensions, celle avec N=8, soit non seulement finie mais contienne effectivement le modèle électrofaible avec violation de la parité. La théorie des cordes n’est peut-être pas nécessaire après tout...

- Les particules seraient des trous noirs ?

L'hypothèse n'est pas nouvelle mais n'était guère prise au sérieux jusqu'ici. Si les dimensions supplémentaires de la théorie des cordes redonnent à la gravitation une force de niveau comparables aux autres forces à l'échelle de Planck, c'est pourtant ce qui serait le plus probable, impliquant dès lors une diversité des trous noirs à la mesure de la diversité des particules, ce qui semble assez difficile à comprendre.

- L'énergie noire est une constante cosmologique

Pour mieux caractériser l'énergie sombre, Riess a utilisé le télescope spatial Hubble (combiné avec les données de 2003 du satellite Wilkinson Microwave Anisotropy Probe ou WMAP, de la NASA) pour affiner la valeur du taux de l'expansion de l'Univers avec une précision de 3%.

La constante de Hubble est désormais connue à moins de 5% près, plus précisément H0 = 74,2 ± 3,6 km/sec/mégaparsec. A cette précision, l’énergie noire est toujours bien décrite par un modèle de vraie constante cosmologique et aucune trace bien distincte de physique au-delà du modèle standard n’émerge.

- L'expansion de l'Univers commence-t-elle à décélérer ?

D’après Starobinsky et ses collègues Arman Shafieloo, de l'Université d'Oxford, et Varun Sahni de l’Université de Pune (Inde) si l’on étudie sans a priori sur la valeur de l’énergie sombre l’expansion de l’Univers depuis moins de 4 milliards d’années à l’aide des supernovae SN Ia situées à quelques milliards d’années-lumière de notre Galaxie, on trouve des indications intrigantes en faveur d’une variation de sa valeur.

Ainsi, il se pourrait que l’expansion accélérée de l’Univers ait diminué depuis moins de 2,5 milliards d’années, au point de se changer tout récemment en une véritable décélération.

S'ils ont raison, plus que jamais l’avenir de l’Univers est incertain mais l’on pourrait bien voir là les premières manifestations des modèles de supergravité appliqués à la cosmologie par Andrei Linde et sa femme Renata Kallosh. Dans quelques dizaines de milliards d’années seulement, l’Univers subirait alors un Big Crunch en se contractant à nouveau, peut-être pour rebondir en un nouveau Big Bang…

- Images spectaculaires de Mars

Ces « araignées » sont formées par du gaz (dioxyde de carbone) circulant librement sous la couche de glace, et qui profite de l’amincissement de cette fine pellicule au début de l’été pour s’en échapper lors des premiers jours d’été.

Des poussières sont alors entraînées depuis la surface sous-jacente, et se déposent aux alentours de la résurgence, retombant sous forme de traînées sombres au gré des vents. Ces traces disparaissent dès que la fonte des glaces est achevée.

- L'europium, le nouveau supraconducteur

L’europium est un élément du tableau de Mendeleïev possédant des propriétés magnétiques. A priori, ce ne peut donc pas être un supraconducteur. Et pourtant... Une équipe américaine vient de démontrer qu'il le devient sous une forte pression.

Avec son étudiant Mathew Debessai, James Schilling a soumis de l’europium refroidi à 1,8 kelvin à une pression de 80 GPa, c'est-à-dire 790.000 atmosphères à l’aide d’une cellule à enclume de diamants. L’europium est une terre rare de symbole Eu et de numéro atomique 63 s’oxydant rapidement à l’air libre lorsqu’on le chauffe. On le classe parmi les matériaux paramagnétiques, ce qui normalement l’exclut des candidats possibles pour la recherche de nouveaux éléments supraconducteurs.

- Les lois de la thermodynamiques s'appliquent aux nanotubes

Lorsque l’on considère un petit nombre de particules, les fluctuations statistiques peuvent être suffisamment grandes pour ne plus donner des lois en accord avec la thermodynamique, bien que toujours conformes aux principes de la physique statistique.

Un nanotube de carbone chauffé, composé de moins de 20 millions d’atomes, allait-il toujours émettre de la lumière en accord avec la loi du corps noir de Planck ?

Ils ont commencé par fabriquer un nanotube de carbone d’un diamètre d’environ 100 atomes afin de réaliser une lampe à incandescence.

A leur surprise, puisque que les 107 atomes de carbone du nanotube restent largement sous la limite thermodynamique de 1023 atomes environ, la répartition de l’énergie lumineuse selon la longueur d’onde étudiée suit bel et bien, à la précision des mesures actuelles, la loi du corps noir à une température T.

C'est assez important, à la fois pour la physique théorique et pour les nanotechnologies, leur robustesse statistique.

- Extraterrestres : silence radio

L'équation de Drake (Fét est le taux de formation des étoiles dans la Galaxie. Ppla est la probabilité qu'une étoile possède des planètes. Npla est le nombre moyen de planètes habitables par étoile. Pvie est la probabilité que la vie apparaisse sur une planète habitable. Pint est la probabilité que l'intelligence apparaisse sur une planète où la vie est apparue. Pcom est la probabilité qu'une forme de vie intelligente développe des moyens de communiquer avec d'autres mondes. T est la durée de vie d'une civilisation communicante).

C'est peut-être que les extra-terrestres ne communiquent pas par ondes radios, trop primitives, mais le plus probable c'est qu'on soit hors de portée d'éventuelles civilisations ou que les civilisations évoluées soient si peu durables qu'il n'y ait aucune chance qu'elles puissent être contemporaines...

Voilà une décennie que le projet de calculs distribués Seti(arobase)home a été lancé. Après l’équivalent de plus de deux millions d’années de temps d’analyse effectuées sur des ordinateurs personnels de près de 5,2 millions d’internautes, aucune trace d’un signal radio émis par une civilisation extraterrestre n’a encore été trouvée.

Seti@home pourrait bien s’arrêter en 2011, faute de crédits, suite aux restrictions budgétaires menaçant jusqu’au radiotélescope d’Arecibo lui-même.

Climat

Climat, écologie, énergies

C'est une chance inespérée que l'activité solaire soit au plus bas, permettant de réduire un peu le réchauffement mais cela ne durera pas toujours, quelques années tout au plus (sauf si on connaissait un « Minimum de Maunder » peu probable qui pourrait durer plusieurs dizaines d'années), et la conjonction avec La nina peut être bien trompeuse sur l'ampleur du "refroidissement" attendu. C'est en tout cas une période où les sceptiques peuvent mettre leurs théories à l'épreuve.

Si le renforcement du rayonnement dû au cycle solaire (d’une dizaine d’année) ne se manifestait pas, le forçage négatif, par rapport au rayonnement solaire moyen serait équivalent à sept années d’augmentation de CO2 au taux de croissance actuel. « Il ne faut donc pas s’attendre à un nouveau « petit âge glaciaire, » concluent les scientifiques de la NASA.

La carte des anomalies de la température mondiale en 2008 (à droite de la Fig. 1), montre que la température de la plupart des régions du monde a été près de la normale ou plus chaude que dans la période de référence (1951-1980). L’Eurasie, l’Arctique et de la péninsule Antarctique ont été exceptionnellement chaudes, tandis que la plus grande partie de l’océan Pacifique a été plus froide que la moyenne à long terme. La température relativement basse dans la zone tropicale du Pacifique est due à la force de La Niña qui est apparue durant la première moitié de l’année.

Compte tenu de notre prévision d’un prochain phénomène El Niño en 2009 ou début 2010, il semble toujours probable qu’un nouveau record de la température mondiale sera établi dans les prochains 1 à 2 ans, et ce malgré la modération résultant des effets négatifs de la réduction du rayonnement solaire.

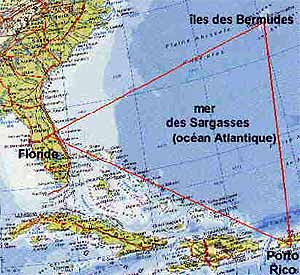

- La fin du réchauffement et le triangle des Bermudes ?

La plupart des climatologues contestent que la part du soleil soit plus importante que la part des gaz à effet de serre. Comme on est dans une période d'inactivité solaire, c'est l'occasion de mesurer l'impact des variations solaires. Ce sont les faits bien sûr qui trancheront. Les Russes (qui ont intérêt au réchauffement) nous avaient assuré que le permafrost ne libèrerait pas de méthane (ce qui ne paraît pas si sûr pourtant) et pensent maintenant que le réchauffement, c'est terminé !

La plupart des climatologues contestent que la part du soleil soit plus importante que la part des gaz à effet de serre. Comme on est dans une période d'inactivité solaire, c'est l'occasion de mesurer l'impact des variations solaires. Ce sont les faits bien sûr qui trancheront. Les Russes (qui ont intérêt au réchauffement) nous avaient assuré que le permafrost ne libèrerait pas de méthane (ce qui ne paraît pas si sûr pourtant) et pensent maintenant que le réchauffement, c'est terminé !

D'autres pensent au contraire que Les effets du réchauffement seraient largement sous-estimés et pourraient se situer entre 3,5° et 7,4°C en 2100, sans parler des catastrophes naturelles que cela provoque...

Le professeur Lev Karline, recteur de l'Université d'hydrométéorologie de Saint-Pétersbourg, qui est également un Centre régional de formation de l'Organisation météorologique mondiale, estime que le réchauffement climatique touche à sa fin.

"Il y a tout lieu de penser que les prévisions augurant un réchauffement climatique ne vont pas se justifier: dans les prochaines décennies, nous retrouverons les normes climatiques que nous avons connues dans les années 70 du XXe siècle", affirme le chercheur pétersbourgeois.

Cela paraît bien peu probable, il faudrait que le soleil soit vraiment très faiblard pendant très longtemps, mais ce serait bien sûr une très bonne nouvelle, inespérée. On devrait être vite fixé avec le prochain El Niño.

Aux mêmes sources on trouve une explication du triangle des Bermudes qui pourrait être moins farfelue qu'elle n'y paraît car il est sûr que les hydrates de méthane sont présents et peu profonds. De là à faire tomber des avions...

"Dans le fond de l'Atlantique, dans la région des Bahamas, de la Californie et des îles Bermudes, sont concentrées d'énormes quantités d'hydrates de méthane. Lorsqu'il s'y produit des mouvements de terrain, il se forme des fractures tectoniques et des hydrates de méthane commencent à se décomposer. Il se dégage alors du gaz. Si un navire tombe dans ce milieu, en raison de la baisse brutale de la densité de l'eau, il est attiré vers le fond. Le même effet destructeur s'observe lorsqu'un avion est pris dans nuage de méthane, formé par le dégagement de ce gaz dans l'atmosphère: l'avion s'écrase."

- Alerte à la fonte des glaces

- La fonte de l'arctique due à la dérive des glaces

Le comportement mécanique de la banquise arctique favoriserait son démantèlement et son déclin rapide. En s'appuyant sur le mouvement d'un réseau de bouées dérivantes, des chercheurs de l'INSU-CNRS, de l'Université Joseph Fourier et de l'Université de Savoie ont mis en évidence une forte augmentation de la vitesse de dérive des glaces et de la déformation interne de la banquise depuis 30 ans. Ces deux effets liés aux propriétés mécaniques de la banquise contribuent par eux-mêmes au déclin rapide de la banquise arctique.

Après avoir évalué les ressources naturelles possibles au nord du cercle polaire, des chercheurs annoncent que l'on pourrait bien y trouver 30 pour cent du gaz et 13 pour cent du pétrole qui restent à découvrir sur la planète.

La majeure partie du pétrole sera découverte sous l'océan, sur les marges continentales, et que cela pourrait s'avérer économiquement significatif pour les pays arctiques tels que les États-Unis, le Canada, le Danemark et le Groenland, la Norvège et la Russie. Les plus grandes réserves de gaz naturel sont néanmoins prédites dans des régions territoriales réclamées à la fois par la Russie et la Norvège. Les chercheurs précisent que la région pétrolifère la plus probable en Arctique se trouve au large de l'Alaska, dans la mer des Tchouktches.

Quand on vous dit qu'il y a trop de pétrole et d'hydrocarbures ! Certes, cela ne va pas bouleverser le marché mais ça fait quand même cercle vicieux, la fonte de la banquise augmentant la quantité d'énergies fossiles qui seront brûlées jusqu'à la dernière goutte...

- Le biochar comme possible puits à carbone?

Le biochar, pour « bio-charcoal », est un charbon d’origine végétale obtenu par pyrolyse de biomasse végétale d’origines diverses, généralement des déchets de scierie ou des résidus agricoles. Se présentant sous forme de petits fragments noirs, il sert à amender les sols et est présenté comme un excellent capteur de carbone. Mais il faut regarder de près...

Composé en majeure partie de carbone, le biochar s'obtient par pyrolyse (carbonisation avec peu ou pas d'oxygène) de matières organiques diverses. Le procédé produit également, en proportion dépendant de la méthode, un biocarburant liquide.

Les végétaux terrestres utilisés captent le gaz carbonique par photosynthèse et en produisent par la respiration. Les techniques envisagées, utilisant la pyrolyse, récupèrent la moitié du carbone et le restitue au sol sous forme de biochar et permettent également la production de biocarburants. Le biochar est durablement séquestré dans le sol, mis à part un léger relargage estimé à 5%. Le bilan global est négatif, avec 20% de carbone prélevé à l'atmosphère. © CSFD

Quel est le bilan énergétique et carboné global de la production par pyrolyse de biocarburant et de biochar ? Aucune estimation chiffrée n’a été trouvée à ce sujet.

En guise de conclusion, le biochar ne semble pas être une solution toute faite au problème de restauration de sols et de stockage de carbone. Son intérêt pour la lutte contre la désertification dans les terres sèches n’est absolument pas prouvé. Il semble actuellement possible et intéressant d’utiliser la pyrolyse pour la production de biocarburant et de biochar pour valoriser les résidus de l’industrie forestière et amender les sols acides des zones humides.

Dans certaines situations favorables, le développement du biochar constitue un des outils de séquestration du carbone atmosphérique, mais certainement pas la panacée. En particulier, des études doivent être conduites pour connaître les mécanismes d’action du biochar dans les sols avant d’inciter à sa généralisation.

- SeedMagazine : Le futur subira-t-il la géo-ingénierie ? (angl.)

Pour combattre le réchauffement climatique faudra-t-il lancer des miroirs dans l’espace, ensemencer les océans avec du fer ou saupoudrer des particules de soufre dans l’atmosphère ? Ces idées, longtemps en marge des sciences, entrent désormais dans le dialogue des experts cherchant des solutions au changement climatique. Le conseiller scientifique du président Obama, John Holdren, a estimé que cela devait être notre dernier recours, mais d’autres sont plus optimistes sur l’emploi de ce types de moyens. Reste à savoir comment évaluer les solutions ? Comment les mettre en place ? Qui pourrait décider ? 5 experts répondent à Seed Magazine dans un dossier passionnant.

Biologie

évolution, génétique, biodiversité, éthologie, anthropologie, neurologie

- La synthèse de l'ARN aux origines de la vie

De nouveaux travaux de chimie prébiotique montrent que la synthèse de la molécule d’ARN aurait été possible dans la soupe primitive terrestre.

Ils sont composés de trois éléments : un sucre (ribose), une base azotée ou nucléobase (guanine, cytosine, adénine..) et un groupe phosphate.

Comment ces trois ingrédients ont-ils pu s’assembler spontanément ? Jusqu’à présent les chimistes n’ont pas réussi à lier la nucléobase et le sucre. John Sutherland et ses collègues de l’université de Manchester ont pris un chemin différent : au lieu de partir d’un sucre d’un côté et d’une base de l’autre, ils les font émerger d’un précurseur commun. De plus, au cours de leurs expériences, les trois chercheurs ont découvert que le phosphate jouait un rôle crucial de contrôle et de régulation des réactions chimiques. Dernier acte : l’action des ultra-violets, qui détruisent certains produits dérivés de la réaction qui permettent la formation d’une seconde nucléobase.

A partir de briques élémentaires (glycéraldéhyde, cyanimide, cyanoacétaldéhyde, cyanoacétylène, phosphate inorganique) qu'on supposait présentes dans une marre d'eau il y a 4 milliards d'années, on a imaginé un cycle plausible (...) Le ballon est donc chauffé puis refroidi, alors que des tuyaux souples approtent en permanence de l'azote gazeux, présent en grande quantité dans l'atmosphère prébiotique. une fois le précurseur commun (2-aminooxazol) formé, tout va très vite. L'accumulation de plusieurs molécules de ce précurseur permet d'obtenir le sucre - le ribose - et la base azotée - la cytosine - liés ensemble. Suit une étape qui ajoute le phosphate manquant pour que le nucléotide soit complet (...) 3 jours durant le ballon est irradié avec une lampe UV (...) Résultat de cette manipulation ; l'obtention de 2 des 4 nucléotides de l'ARN, la cytosine et l'uracile (Science&Vie août 2009).

- Le débuts de la vie sur Terre repoussés à plus de 4 Milliards d'années

Il y a près de quatre milliards d’années, la Terre, et tout le système solaire, a connu une période marquée par l’augmentation notable du nombre d’impacts de météorites et de comètes. C’est le Grand bombardement tardif (ou Late Heavy Bombardment, LHB en anglais). La violence des chocs successifs a profondément modifié la biosphère et la vie (si elle était présente) de la Terre primitive et a même eu des répercussions sur la croute de notre planète. A tel point que de nombreux scientifiques pensent que la Terre a été « stérilisée » durant cette période.

Des chercheurs due l’Université du Colorado, Oleg Abramov et Stephen Mojzsis, estiment au contraire que tout trace de vie n’a pas forcément était vaporisée et que des microbes vivant sous la surface ont pu survivre tout au long de cette période apocalyptique.

Ces nouveaux résultats repoussent les débuts de la vie possible sur Terre bien avant la période de bombardement. Cela ouvre la possibilité que la vie soit apparue en même temps que les premiers océans, il y a 4,4 milliards d’années.

- S'inspirer des plantes pour mieux maîtriser nos flux d'énergie et de matière

Des chercheurs du CNRS, de l'INRA et du CEA ont développé un modèle mathématique représentant les voies de biosynthèse des acides aminés chez la plante Arabidopsis. Ce modèle a permis de reproduire fidèlement des mesures réalisées avec des plantes entières, démontrant ainsi son exactitude. Des simulations ont alors permis de comprendre qualitativement et quantitativement le fonctionnement d'un tel réseau de contrôle.

Partant du principe que la nature, dans sa capacité à gérer des systèmes complexes, était sans doute un bon exemple à suivre pour améliorer notre maîtrise des flux de matière et d'énergie, les chercheurs se sont fixés comme objectif de modéliser un système métabolique comprenant de nombreuses bifurcations et un réseau dense de contrôles (synergie, feedback, inhibitions, activation, doubles contrôles). Ils se sont inspirés de modèles expérimentaux pour obtenir les informations nécessaires à la mise en place du modèle mathématique:

- mesure de la vitesse à laquelle les "robots" (les enzymes) transforment ou assemblent des pièces (les métabolites).

- mesure de la sensibilité de certains "robots" (les enzymes allostériques) à différents signaux (selon les niveaux de certains stocks, ces enzymes clé travailleront plus ou moins vite).

- comptage du nombre de robots impliqués à chaque étape grâce à des anticorps reconnaissant spécifiquement ces enzymes.

Le modèle a également permis de reproduire quantitativement le comportement de certaines plantes mutantes. Ces résultats validant le modèle, des simulations, intégrant la modification de certains paramètres, ont alors été réalisées et ont permis de comprendre qualitativement et quantitativement le fonctionnement d'un tel réseau de contrôle.

Ces problématiques de contrôle rencontrées dans les systèmes vivants se rapprochent de celles rencontrées, par exemple, dans un réseau électrique.

- Le chaînon manquant : notre ancêtre lémurien

Ida, notre ancêtre lémurien, vieux de 47 millions d'années, avant la séparation d'avec les singes.

La première surprise vient du remarquable état de conservation de l'animal, daté de 47 millions d'années, c'est-à-dire de l'éocène moyen. Le squelette, long de un mètre avec la queue, est complet à 95% et comporte des traces de quelques parties molles et même du contenu de l'estomac... On sait ainsi que ce mammifère était un herbivore se nourrissant de fruits, de graines et de feuilles.

Avec son pouce opposable, ce fossile est celui d'un primate et son âge le situe avant la séparation des deux lignées menant, pour l'une, aux singes (dont les hommes) et pour l'autre aux lémuriens et aux autres primates prosimiens. D'ailleurs, ses caractéristiques générales sont celles d'un lémurien mais d'autres, comme l'absence d'une griffe sur l'un des doigts (utilisée par les lémuriens pour se nettoyer le pelage) ou la structure d'un os du pied, l'astragale, le rapprochent des singes. L'animal appartient donc à un groupe dont nous faisons nous-mêmes partie aujourd'hui.

- L'effondrement des colonies d'abeilles atteint le Japon

Alors que le phénomène de disparition des abeilles semblait épargner le Japon, c’est un effondrement de 50% du nombre de colonies qui vient d’y être constaté.

Détectée pour la première fois aux Etats-Unis en 2006, le phénomène appelé syndrome d’effondrement des colonies semble faire suite à la réduction la réduction inhabituelle du nombre d’insectes pollinisateurs (car guêpes et bourdons sont aussi affectés). Comme une pandémie, il s’est rapidement étendu en Europe puis à Taiwan.

Les causes de cette surmortalité, qui prend des proportions préoccupantes, restent pourtant mystérieuses.

Paradoxalement, un article publié le 7 mai dernier dans la revue Current Biology par le chercheur argentin Marcelo Aizen et son collègue canadien Lawrence Harden, rédigé sur la base des statistiques de l'Organisation des Nations unies pour l'agriculture et l'alimentation (FAO), fait état d’une augmentation de 45% du nombre de colonies d’abeilles à l’échelon mondial.

Comment expliquer une telle différence ? Il existerait, selon les chercheurs, une évolution très contrastée des populations apicoles au niveau mondial, les réductions – très réelles – constatées aux Etats-Unis et en Europe étant compensées par une hausse importante en Chine, en Argentine et au Canada.

- Le dauphin commun menacé de disparition

- Le gène du langage implanté chez des souris

Pour comprendre comment le langage s’est développé chez l’être humain, des chercheurs ont inséré dans le génome des souris la version humaine du gène FoxP2, considéré comme crucial dans l’évolution du langage articulé chez l’Homme.

Enard et ses collègues ont observé quelques modifications dans des circuits neuronaux, au niveau des noyaux gris centraux, qui sont, chez l’Homme, impliqués dans le langage.

Les cris poussés par les souriceaux séparés de leur mère –des ultrasons- sont émis sur une fréquence plus basse chez les rongeurs génétiquement modifiés, rapportent les chercheurs.

Il y aurait aussi une baisse de la dopamine (privilégiant la réflexion sur l'action et l'exploration) ainsi qu'une plus grande connectivité des neurones.

En fait c'est juste les pattes qui sont vertes, sinon les ouistitis, ça ressemble déjà à ça !

Pour la première fois, des généticiens ont réussi à créer une lignée de primates transgéniques. Les singes manipulés portent un gène qui code pour une protéine verte fluorescente. Cet exploit en génie génétique ouvre la voie vers de nouveaux modèles animaux de maladies humaines.

Il s'agit du premier cas jamais établi dans le monde d’une manipulation génétique transmise à la génération suivante chez un primate.

La vidéo est amusante même si la musique n'est pas terrible !

Tous ces danseurs non humains étaient des spécialistes de l'imitation, essentiellement des perroquets. Tous sauf un car l'équipe a sélectionné aussi un éléphant d'Asie... Or, on connaît un de ces pachydermes, décrit en 2005, qui se montrait capable d'imiter le bruit d'un camion. « Il semble bien que l'imitation vocale et le sens du rythme reposent sur les mêmes bases neurologiques ».

- Le calcul mental comme déplacement spatial

La gauche, c'est la soustraction, et la droite l'addition ! Simple liaison des chiffres avec l'écriture de gauche à droite ?

Grâce à l’imagerie cérébrale par résonance magnétique à 3 Teslas de NeuroSpin, ces équipes viennent de mettre en évidence un rapprochement inattendu entre les représentations des nombres et celles de l’espace dans le cerveau.

À partir des images IRM de haute résolution obtenues, les chercheurs ont été en mesure de déduire, essai par essai, si la personne avait orienté son regard vers la droite ou vers la gauche, avec un taux de succès de 70 %. Plus surprenant, cette classification s’est étendue au calcul mental: les chercheurs ont ainsi observé la même distinction entre l’activité cérébrale évoquée pendant les mouvements à gauche ou à droite et pendant les opérations de soustraction ou d’addition – que ces opérations soient réalisées avec des ensembles concrets d’objets (calcul non symbolique) ou avec des nombres symboliques (calcul symbolique) présentés sous formes de chiffres arabes.

Ils en ont conclu que le calcul mental ressemblait à un déplacement spatial. Par exemple, dans une certaine mesure, lorsqu’une personne qui a appris à lire de gauche à droite, calcule 18 + 5, son attention se déplace "vers la droite" de 18 à 23 dans l’espace des nombres, comme si les nombres étaient représentés sur une ligne virtuelle.

Toutes les images ne sont pas aussi probantes mais c'est fascinant...

- Une statuette humaine de 35.000 ans !

Une petite figurine en ivoire de 6 centimètres de haut, représentant un corps de femme dont les organes sexuels ont été significativement exagérés, vient d’être découverte dans une grotte à Hohle Fels, dans le Jura souabe, en Allemagne. Son âge, estimé à 35.000 ans minimum, prend de court les préhistoriens en reculant d’au moins dix millénaires la date d’apparition de ce type d’art.

"Sa réalisation remonte à au moins 35.000 ans mais je pense qu’elle est bien plus ancienne".

L’archéologue João Zilhão, de l’Université de Bristol (Royaume-Uni) souligne l’importance de cette découverte, qui permet d’établir avec quasi-certitude que les humains modernes ont commencé à créer l’art dès leur arrivée en Europe, ou très peu de temps après. La synchronisation de la naissance de l’art fait actuellement l’objet de débats au sujet de la nature et des origines des divers comportements humains. Certains scientifiques pensent en effet que le développement de l’art serait l’indication d’un développement plus avancé des capacités cognitives de l’Homme moderne, une des raisons pour lesquelles il aurait progressivement supplanté le Néandertalien.

Notre espèce date d'un peu avant 50 000 ans, date à laquelle on observe "le changement comportemental le plus radical que les archéologues aient jamais étudié", ce dont cette statuette donne une preuve de plus et qu'on peut attribuer à l'apparition du langage narratif, bien que certains le datent de bien avant (au moins 150 000 ans) mais on ne s'explique pas alors ce saut culturel...

- Les hommes de Cro-Magnon mangeaient-ils les Néandertaliens ?

En fait rien de très nouveau puisqu'on savait que des homo sapiens étaient (parfois) cannibales et des Néandertaliens aussi. Rien d'étonnant donc à ce que des sapiens puissent manger des Néandertaliens !

En fait rien de très nouveau puisqu'on savait que des homo sapiens étaient (parfois) cannibales et des Néandertaliens aussi. Rien d'étonnant donc à ce que des sapiens puissent manger des Néandertaliens !

En réexaminant des restes humains dans une grotte connue en Charente, une équipe française pense avoir découvert un fragment de mandibule d'un jeune Néandertalien portant des traces d'instruments coupants. Hypothèse envisageable : les habitants de la grotte – nos ancêtres – auraient dévoré cet enfant.

Le scénario décrit par Fernando V. Ramirez Rozzi semble plaider pour des affrontements violents, qui pourraient avoir eu raison des Néandertaliens, aux armes peut-être moins efficaces.

Santé

génétique, traitements, nutrition, hygiène

- Bientôt un vaccin grippal express

Le secret ? Il s’agit d’utiliser le virus de la maladie dont, par manipulation génétique, on a enlevé le gène de la protéine NS1 qui en est le facteur pathogène. Il s'agit donc d'un virus atténué, souvent qualifié de « vivant ». Une fois modifié, il est mis en culture, et au bout de quelques jours seulement, on dispose d’un produit prêt à être administré sous la forme d’un spray nasal.

La récente pandémie grippale servira bientôt de banc d’essai en grandeur nature du nouveau procédé. "Nous attendons en effet de ces jours-ci des échantillons du virus A(H1N1), a révélé Thomas Muster. Cela devrait nous permettre de montrer d'ici deux à trois semaines notre capacité à réagir en temps réel à une véritable menace et à proposer un premier vaccin efficace".

- Dégénérescence de l'oeil précurseur des maladies neurologiques

Les cellules qui soutiennent habituellement la survie de cellules nerveuses (neurones) jouent aussi un rôle actif et majeur dans la mort de neurones dans l'œil.

Type de cellules le plus abondant dans le système nerveux, les cellules gliales sont considérées comme des cellules "partenaires" des cellules nerveuses, leur procurant soutien, substances nutritives et un environnement optimal. Toutefois, cette étude indique que les cellules gliales ont aussi un côté plus sinistre qui leur permet de déclencher ou d'exacerber la mort neuronale dans des pathologies.

"La mort de cellules neuronales déclenchée par le glutamate est une étape clé dans un grand nombre de lésions et de maladies, et cette étude est importante, car elle fournit un guide pour les événements cellulaires et moléculaires qui permettent à cela de se produire, explique le Pr Philip Barker, neuroscientifique à l'INM. Le fait que des événements précis de signalisation dans les cellules gliales soient importants pour déclencher la mort de cellules neuronales est surprenant et laisse entrevoir de nouvelles cibles thérapeutiques pour des affections où l'excitotoxicité est en cause."

En interrompant les événements de signalisation dans les cellules gliales voisines, les chercheurs ont pu protéger la majorité de ces neurones, ce qui confirmait le rôle clé des événements liés aux cellules gliales dans la mort déclenchée par le glutamate.

Cette nouvelle compréhension de la cascade excitotoxique de la mort de cellules nerveuses fournit des cibles claires pour une intervention thérapeutique fructueuse dans le cas d'un large éventail de maladies neurologiques et neurodégénératives.

- La thérapie génique pour le Parkinson

- La thérapie génique pour le Parkinson

En augmentant la production de GABA, affectée par le déficit de dopamine, grâce à la thérapie génique, l'état des patients parkinsonien s'améliorerait nettement.

- La "trisomie 21" protège du cancer

Le Down Syndrom ou "trisomie 21" est provoqué par une copie supplémentaire du chromosome 21, ce qui réduirait les cancers en empêchant les cellules cancéreuses de former des vaisseaux pour être irrigé par le sang, ce qui est cohérent avec le fait que les enfants trisomiques naissent souvent avec une malformation cardiaque.

- Les oestrogènes renforcent la réponse immunitaire

Ce n'est pas toujours aussi bénéfique que ne le présente l'article de renforcer l'inflammation mais il est indéniable que cela rend les femmes plus résistantes.

Les œstrogènes produits naturellement par les femmes pourraient bloquer la sécrétion d'une enzyme, la Caspase-12, qui interrompt le processus inflammatoire. Ainsi la présence d'œstrogènes aurait un effet positif sur l'immunité innée. « Ces résultats prouvent donc que la réponse inflammatoire innée chez les femmes est plus puissante que chez les hommes, ».

Quelques semaines après la parution du nouveau brûlot du Professeur Jean-Claude Lefeuvre, qui lançait, à nouveau, un véritable cri d’alarme sur la dramatique pollution de la quasi-totalité des ressources en eau françaises, c’est l’association Aqui’Brie, implantée en Seine-et-Marne, qui sonne à son tour le tocsin. Les eaux franciliennes sont de plus en plus contaminées par les pesticides. Ainsi, des traces de glyphosate, une molécule issue d’un désherbant répandu, ont elles-été détectées dans la nappe de Champigny, qui alimente en eau un million de Franciliens.

Des chercheurs ont étudié deux groupes de consommateurs de café, pendant deux semaines un groupe a reçu sa dose de caféine quotidienne, l'autre a reçu un placebo décaféiné. Bien que l'on constate une diminution du flux sanguin vers le cerveau, le groupe placebo s'est considéré aussi éveillé que l'autre pendant la journée.

Par contre, le groupe qui n'a pas reçu sa dose de caféine a souffert de maux de tête typiques et de baisses de tonus occasionnelles au début de l'étude. Mais après quelques jours, ils ne voyaient aucune différence. Ce sont la des effets physiologiques de l'arrêt de la consommation de caféine.

Selon l'étude, le seul bénéfice de la consommation de café chez les habitués est d'éviter les symptômes du sevrage. Une fois que le sevrage a eu lieu, les consommateurs ne voient aucune différence. C'est différent chez les consommateurs occasionnels, dont le corps ne s'est pas habitué à la prise de caféine.

D'autres pensent au contraire que le meilleur moyen de consommer de la caféine est de la prendre sous la forme de petites doses fréquentes, plutôt qu’une grosse quantité en une fois.

- Un électrocardiographe portable à connecter à un mobile

L'électrocardiographe se porte attaché à un collier passé autour du cou. Il surveille en permanence un certain nombre de paramètres physiologiques, le rythme cardiaque, la température et la position du corps par rapport à l'horizontale. Les données sont transmises à un mobile équipé d'un adaptateur.

L'appareil présenté produit plus qu'un électrocardiogramme. Ses capteurs enregistrent également la température de la peau et ses accéléromètres miniatures repèrent la position de la personne et peuvent donc détecter une chute.

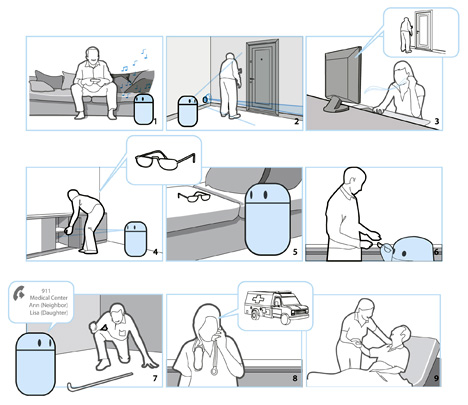

- Des RFiD comme neurostimulateurs

Des RFiD (en bleu) sont injectés dans la moelle épinière (sans batterie) et leur stimulation est contrôlée par le patient ou un programme grâce à un petit appareil extérieur.

Technologie

biotechnologies, énergie, nanotechnologies, robotique, informatique

Cette boîte est faite entièrement d'ADN et peut s'ouvrir pour libérer son contenu.

Dans les limites de ce qui est physiquement possible, un groupe de chercheurs, parmi lesquels se trouve Min-Feng Yu, Ning Wang et Yang Xiang, viennent de réussir à créer une nano-aiguille en nitrure de bore de 50 nanomètres de diamètre pouvant servir, entre autres, à manipuler certaines réactions chimiques directement à l’intérieur d’une cellule.

Recouverte d’une fine couche d’or et attachée à une pipette en verre, cette nano-aiguille pénètre facilement la membrane d’une cellule et permet d’y déposer de une à quelques molécules seulement. Ces dernières, qui sont fixées à la surface de l’or, se libèrent facilement dans le cytoplasme une fois l’extrémité de l’aiguille à l’intérieur de la cellule.

On peut aussi injecter directement des nanoparticules magnétiques ou des boîtes quantiques, ce que les chercheurs ont fait comme ils l’expliquent dans une publication de Nano Letters. Yu et ses collègues ont ainsi suivi en détails le chemin individuel des boîtes quantiques fluorescentes qu’ils ont introduites de cette manière, et ce, jusque dans le noyau des cellules. Ces boîtes peuvent servir à étudier la dynamique moléculaire et physique se produisant dans les cellules.

On en avait déjà parlé en juillet 2008.

En 2008, l'équipe avait montré un circuit électronique souple réalisé à l'aide d'un polymère élastique rendu conducteur par l'addition de nanotubes de carbone. L'écran souple ne serait alors qu'une des applications de ces circuits électroniques déformables dans tous les sens.

Sur ce matériau souple et conducteur, l'équipe de Takao Someya a installé un réseau de diodes organiques (Oled) et de transistors pour les contrôler. Pour le fabriquer, la technique ressemble... à celle de l'impression à jet d'encre. Les nanotubes sont dissous dans un liquide chargé (comportant des ions), lequel est ensuite projeté sous pression sur une pâte de polymère. Une grille sert de masque pour imprimer le motif du circuit.

Le résultat est une surface capable d'allumer individuellement des pixels et que l'on peut étirer jusqu'à une fois et demie la taille initiale, avec une déformation assez faible de chaque point lumineux.

De plus, bien d'autres applications sont envisageables, comme l'ont déjà étudié les chercheurs japonais. Takao Someya a déjà commencé à explorer la possibilité d'en faire une sorte de peau électronique qui donnerait à un robot le sens du toucher.

Il y a aussi le G-CNT, formé de nanotubes de carbone et de graphène. Transparent et peu coûteux, il remplacerait avantageusement l'ITO, aujourd'hui indispensable aux écrans plats mais menacé par la pénurie d'indium. Il pourrait aussi servir pour des cellules photovoltaïques.

- Concentrateurs photovoltaïques

Il y avait déjà des loupes sur certains panneaux solaires mais la combinaison de concentrateurs (utilisés dans le solaire thermique) avec le photovoltaïque fait chuter radicalement le coût du solaire ainsi que la quantité de semi-conducteurs nécessaire.

De plus, grâce à des imprimantes à jet d'encre le coût des cellules photovoltaïques devraient baisser, là aussi, en réduisant la quantité de silicium par 2 !

- Des micro-onduleurs pour panneaux solaires

Il serait plus efficace et moins cher de doter chaque panneau d'un micro-onduleur plutôt que d'avoir un seul onduleur pour tous les panneaux ce qui limiterait sa puissance au panneau le moins performant.

- Le deutérium ultra-dense pour la fusion

Le deutérium ultra-dense l’est un million de fois plus que la glace de deutérium déjà employée dans des expériences de fusion inertielle avec des faisceaux lasers. Le résultat est qu’il est plus facile et moins coûteux en énergie de le comprimer pour atteindre la température et la pression nécessaire à l’amorce d’une fusion. Ce matériau pourrait donc bien révolutionner dans un avenir proche les recherches en fusion contrôlée

- Abandon de la voiture à hydrogène

Steven Chu, le secrétaire à l'énergie d'Obama, arrête le plan de soutien à la voiture à hydrogène présenté par Bush comme une alternative alors qu'il faudra de 10 à 20 ans pour que la filière soit opérationnelle. Ce qui n'empêche pas de continuer à utiliser l'hydrogène pour stocker les énergies renouvelables.

- Transformer les ordures en carburant

Sans incinération, par plasma-gazéification.

La technologie développée par Carbon Sciences recourt à des micro-organismes, qu'elle appelle « bio-catalyseurs » : dans un premier temps il faut « déstabiliser » le dioxyde de carbone en le mélangeant avec de l'eau. Puis les micro-organismes, protégés par des coquilles de polymère spécialement mises au point, se chargent de recomposer hydrogène et carbone pour produire du méthanol, qui peut être raffiné en essence ou en carburant pour l'aviation.

Le mécanisme est le même que celui mis en oeuvre dans la nature, lors de la genèse des hydrocarbures. Mais dans le procédé de Carbon Sciences, « les biocatalyseurs sont protégés » et réutilisés, si bien que l'essence peut être produite avec un prix de revient « très, très compétitif ».

Jusqu'à présent, le défaut de ce procédé résidait dans son coût élevé : les micro-organismes devaient être remplacés après chaque réaction. Désormais, grâce à des nano-coquilles de polymère mis au point par Carbon Sciences, ces organismes peuvent être réutilisés jusqu'à plusieurs millions de fois, et permettent de parvenir à un prix équivalent à celui de l'éthanol.

Rien de très nouveau a priori. On parlait déjà du méthanol pour recycler le co2 dans EcoRev' en 2005. Il faudrait en savoir plus sur les catalyseurs biologiques utilisés. La seule question est celle de l'efficacité et du prix, ce qui est la nouveauté revendiquée par Carbon Sciences mais qu'on doit croire sur parole pour l'instant... Bien sûr, le co2 se retrouve dans l'atmosphère à la fin. Simplement au lieu de produire du co2 dans les centrales à charbon et dans les moteurs de voiture, là on ne le produit qu'une fois. Comme le méthanol émet 2 fois moins que le fuel, on a un bilan carbone divisé par 4. Ce n'est pas rien, mais ce n'est pas du renouvelable malgré tout ! D'une certaine façon, si ces demi-mesures marchent elles retarderont de véritables énergies renouvelables mais c'est mieux que rien pour l'instant quand même ! Par contre Science&Vie fait le constat, p38, de l'impossibilité de stocker le co2 sous terre à cause de l'eau qui le dissous.

- Une mini pile à combustible (au méthanol)

Avec une puissance de 50 milliwatts par centimètre cube, c'est la plus petite et la plus performante pile à combustible du monde !

Comme toutes les piles de ce type, celle-ci produit du courant grâce à une réaction électrochimique: l'oxydation d'un combustible. En l'occurrence, la réaction a lieu ici entre du méthanol et de l'air. Le dispositif ? Une fine membrane en plastique prise en sandwich entre deux galettes de silicium creusées de microcanaux. C'est dans ces fins sillons que l'on fait circuler le méthanol, issu d'un réservoir extérieur à la pile, et l'air, nécessaire à la réaction.

- Réduire la consommation des appareils numérique à la source

L'IEA invite les industriels à recourir aux dernières technologies disponibles pour réduire encore la consommation de leurs appareils électroniques. L'IEA estime ainsi qu'il serait possible de diviser par deux la consommation d'énergie des produits et conduire à une consommation globale augmentant de moins de 1% par an jusqu'en 2030.

Pour l'IEA, il ne s'agit pas seulement d'utiliser les composants les plus performants mais bien d'inciter les fabricants à s'organiser pour garantir les politiques d'efficacité énergétique les plus performantes, avec un encadrement des pouvoirs publics.

La consommation des appareils électroniques (surtout télévisions et autres écrans) atteindrait 15% de la consommation (d'électricité j'imagine), ce qui est insoutenable mais il y a de grandes marges d'amélioration. Voir aussi Futura-Sciences. On peut ajouter les ravages provoqués par les métaux rares (Coltan, Indium, etc.) dont on devrait essayer de se passer.

- Samsung lance les PRam, concurrentes des mémoires Flash internes

En juin prochain, le fondeur sud-coréen démarrera la production de masse des PRam de 512 Mo, ces mémoires permanentes dites à changement de phase. Leur usage est le même que les mémoires Flash Nor, que l'on trouve dans les ordinateurs, les baladeurs ou les appareils photo mais la vitesse et la durée de vie sont paraît-il bien supérieures. Samsung rejoint ainsi Intel et STMicroelectronics sur ce marché prometteur.

Par rapport à une mémoire Nor, le principe apporte en lui-même un gain de vitesse en écriture. En effet, la cellule peut changer d'état directement. Autrement dit, si une cellule contenait un 1, l'écriture d'un 0 effacera l'information antérieure. Dans une mémoire Flash, il faut au contraire effacer le 1 avant d'écrire un 0. L'amélioration serait énorme, les fabricants annoncent une vitesse trente fois supérieure. De plus, la PRam serait plus solide à l'usage. La durée de vie, mesurée en nombre de cycles d'écritures et de lectures, serait, selon Samsung, dix fois supérieure à celle d'une mémoire Flash ordinaire, qui se situe entre 10.000 et 100.000.

D'un prix de revient inférieur (de 20% semble-t-il) aux mémoires Flash, ces PRam pourraient rapidement envahir les appareils portables et leur apporter une vitesse de réaction plus élevée.

- Des netbooks à moins de 200€

Ce netbook SurfOne à écran 7" est nettement moins performant que le eeePc à peine plus cher et risque d'être un "produit jetable" après 1 ou 2 ans d'utilisation mais à 175€ il rend l'informatique de plus en plus accessible.

Déporter puissance et stockage sur le réseau, c'est l'avenir et ça consomme moins !

Déporter puissance et stockage sur le réseau, c'est l'avenir et ça consomme moins !

Le problème avec les téléphones mobiles, c’est que tout le monde voudrait qu’ils fonctionnent comme des ordinateurs alors qu’ils n’en ont pas les capacités. Un chercheur d'Intel, propose de créer un clone de chacun de nos téléphones qui vivrait “dans les nuages” et qui nous permettrait d’utiliser des capacités de calcul depuis notre mobile. C’est l’idée qui anime CloneCloud, utiliser les connexions mobiles haut débit pour accéder à un téléphone amélioré sur des serveurs distants. L’avantage est de permettre d’économiser la batterie et le processeur du mobile… Une reconnaissance d’image sur mobile est trop longue à faire tourner, alors qu’avec un tel système, il ne requiert que quelques secondes.

- Les pays pauvres réinventent le SMS, et l’avenir des mobiles

Il a fallu 15 ans pour que le quart de l’humanité soit doté d’un téléphone mobile, en 2003, et quatre ans seulement pour que la moitié de la population mondiale, soit 3,8 milliards d’individus, en soit équipée. La quasi-totalité des futurs nouveaux entrants résident désormais dans les pays du Sud, où les usages sont bien différents de ce que l’on connaît dans nos contrées dites “développées“.

La question n’est pas tant celle du développement des infrastructures, ni de l’abaissement des coûts d’abonnement ou des portables, que celle des bouleversements qu’engendreront la profusion des usages, et la connectivité permanente, dès lors que toute l’humanité, ou presque, sera connectée.

Le rapport avance que dans les 50 pays les plus pauvres, la croissance de la téléphonie mobile avoisine les 70% par an, et ce, depuis l’an 2000. Les acteurs industriels savent s’adapter, ne serait-ce que parce que s’ils n’intègrent pas dès maintenant ce marché, d’autres pourraient s’y implanter plus et mieux. Ainsi, Vodaphone, qui proposait des forfaits à 100$ par mois il y a quelques années, commercialise aujourd’hui des abonnements de l’ordre de 5$, et des fabricants comme Nokia proposent des portables pour moins de 25$.

Pour John West, “en terme d’ubiquité, la question n’est plus de savoir si la quasi-totalité des gens possèdera un téléphone mobile relié à des réseaux avancés permettant la diffusion de vidéos ainsi que la géolocalisation, mais quand“. Et pour lui, cet horizon ne sera pas atteint dans quelques décennies, mais dans quelques années.

Une bonne partie d’entre eux sont illettrés, voire analphabètes. Or, les interfaces sont essentiellement textuelles, et les représentations iconographiques demeurent basées sur les cultures occidentales.

- Free Wifi: un réseau communautaire d'accès Internet

L'accès au web va être beaucoup plus aisé en déplacement, durant les vacances grâce à un nouveau service ouvert par Free. La FreeWifi permet à chaque abonné ou futur abonné de se connecter en wifi aux Freebox V5 dont le réseau est activé ce qui permet de créer un réseau communautaire.

Problème : le service semble réservé à ceux qui sont "dégroupés". Ce réseau pourrait avoir été lancé du fait que Free ne devrait pas avoir la licence 3G avec laquelle le réseau Wifi pourrait entrer en concurrence.

Marshall Kirkpatrick est sérieux en évoquant cette convergence d’un nouveau genre, à la suite de Jeremiah Owyang de Forrester dans son rapport sur l’avenir du web social. Les développements que préparent Firefox (340 millions d’utilisateurs estimés) devraient en effet rapprocher le navigateur d’un réseau social, alors que Facebook lui, intègre de plus en plus toute navigation à son site.

- Wolfram Alpha, les débuts...

L’impression dominante est que WA ressemble surtout à un système capable de commander en langage naturel des applications du logiciel Mathematica (un logiciel du même Stephen Wolfram) qu’un ordinateur capable de calculer des réponses dans divers domaines à partir d’une base de données véritablement encyclopédique.

Ces premiers essais montrent que WA est très sensible à la forme de la question et même à la typographie. Le logiciel ignore cousteau mais connaît Cousteau.

A la question « France vs India », la réponse est un tableau comparé assez instructif des deux pays. J’apprends ainsi que le PIB de l’Inde est légèrement inférieur à la moitié du PIB de la France et que si l’espérance de vie moyenne dans notre pays est de 81 ans, elle est de moins de 70 ans en Inde.

Notons que Microsoft aussi lance un nouveau moteur (Bing) qualifié pompeusement de décisionnel sous prétexte qu'il classe les réponses...

La messagerie partagée (pour les entreprises surtout?).

Wave permet d’abord une communication écrite enrichie : contrairement aux mails, que vous écrivez puis envoyez, votre message Wave est partagé en permanence avec votre ou vos interlocuteurs, voire, si vous le souhaitez, sur des sites web. Le message n’est pas uniquement dans votre boite ou dans celle de vos contacts ; elle est disponible à tous, tout le temps. De cette manière, tout les utilisateurs qui y ont accès peuvent l’enrichir à tout moment, y ajouter des contenus, de la musique, des cartes, un agenda… Voire même des applications, par le biais d’extensions que tout un chacun pourra ajouter à son service. Google a par exemple montré que deux utilisateurs de Wave pouvaient jouer aux échecs, par un simple plug-in. Ce qui est possible car toutes les modifications effectuées sur une « wave » sont par ailleurs visibles instantanément par vos contacts. Vous pouvez ainsi discuter, jouer, partager des contenus en temps réel via ce service. Impressionnant !

Voir aussi Rue89 ou techno-science.

- Google street view interdit au Japon et en Grèce

Alors que les caméras de la section cartographie de Google Street View sillonnent le monde entier, pays après pays et région après région, les autorités japonaises ont fait savoir que les Google Cars étaient persona non grata sur leur territoire. En cause, l’architecture des constructions, qui place souvent le seuil des fenêtres ou la hauteur des murets sous l’objectif des caméras installées sur le toit de la voiture, permettant ainsi de dévoiler la vie intime des habitants.

- EyeSeeCam : diriger par les yeux

L'intérêt de cette nouveauté est de contrôler à distance divers outils grâce à un dispositif placé sur la tête de son utilisateur. Concrètement, il s'agit d'un casque qui contrôle tous les mouvements des yeux de l'utilisateur. Composé de caméras, de miroirs et de LEDs, ce casque interprète tous les mouvements oculaires et transmet ces informations à l'ordinateur auquel il est relié, avec une capacité d'envoi d'information de l'ordre de 600 fois par seconde. Cet ordinateur est alors capable de communiquer ces données à différents périphériques, tels que des caméras ou des robots, à l'aide d'une connexion sans fil.

Ces lunettes interactives utilisent la rétine en qualité d’écran transparent virtuel. Le but est d’offrir la possibilité de contrôler un périphérique externe sans l’intervention des mains. L’utilisateur observe non seulement un affichage de contenu, mais peut également naviguer et faire des sélections dans un environnement totalement transparent. Ce système est fait pour ceux qui veulent avoir les mains libres pendant leur travail tout en profitant de la puissance d’un ordinateur.

Le CBS (Command Button Sensor) est inédit. Il s'agit d'un capteur qui se fixe facilement sur la tempe ou la joue et permet de cliquer.

Des chercheurs français proposent un nouvel interface cerveau-machine qui permet d’agir par la pensée. Ils mettent ce logiciel gratuitement à la disposition des acteurs de la recherche dans ce domaine.

Pour écrire, le cobaye a devant les yeux un écran noir et blanc où sont disposées les lettres de l'alphabet. Des flashs lumineux éclairent alors aléatoirement et rapidement les lettres. Le cobaye compte le nombre de fois que la lettre souhaitée s’éclaire. Lorsqu'il l'a repérée dix fois, une onde cérébrale se crée, associée à la détection d'un stimulus attendu. Celle-ci est repérée dans la foule de signaux électriques et le système donne l'ordre d'afficher la lettre souhaitée.

Faute de pouvoir associer avec certitude un signal à une lettre, les chercheurs utilisent des ondes générées par une activité cérébrale spécifique pour faire écrire par la pensée.

D'autres applications sont sensibles à des signaux cérébraux provenant de zones motrices. Un objet virtuel peut ainsi être soulevé par la seule force de la pensée. En l'occurrence, il suffit de penser à remuer ses pieds pour qu'un vaisseau spatial échappé de la Guerre des Etoiles se soulève lorsque le "mouvement" s'arrête.

Dans une visite virtuelle de musée, le visiteur peut se déplacer en pensant à fermer la main droite ou gauche ou déplacer un ballon sur un terrain de jeu.

On peut voir des vidéos : commander un ordinateur (et une balle de Ping Pong) par la pensée mais surtout, on peut télécharger le logiciel !

On trouve de tout et pour quelques produits "écolos" (économiseur d'eau, éclairage oled, barbecue solaire), beaucoup de produits énergivores (poubelle réfrigérante) et de purs gadgets...

- Memo, projet de robot personnel pour malades atteint d’Alzheimer

- Un robot-poisson pour détecter la pollution

Ce poisson-robot aux allures d'une carpe scrute les fonds marins à la recherche de pollution.

Équipé d'une batterie, son autonomie est de 8 heures de nage. Il rentre automatiquement au port lorsque ses batteries sont faibles pour les recharger.

On peut imaginer ce robot détecter des fuites de carburant en nageant près d'un bateau, par exemple. Dès qu'il en détecte, il transmet l'information à ses congénères, et envoie également l'information au centre scientifique via un réseau Wifi. Il a pour principe de travailler en groupe (grâce à une communication par ultrasons).

International Conference on Robotics and Automation (ICRA 2009)

RiSE V3 grimpe un poteau électrique à la vitesse de 21cm par seconde.

Pendant 18 mois, 12 équipes composées d’étudiants, de chercheurs et d’ingénieurs ont travaillé pour réaliser ces petits avions présentés le 26 mai par l’ONERA (Office national d’étude et de recherche aérospatiale) et la DGA (Délégation générale pour l’armement).

Loin d’être des maquettes d’amateurs, ces drones d’un diamètre compris entre 50 et 70 centimètres, pour un poids allant de 476 grammes à quelques kilos, participaient au Challenge Minidrones 2007-2009. Le concours organisé par les deux organismes imposait un cahier des charges particulièrement ambitieux : les engins devaient en théorie servir d’éclaireur en zone de combat, de manière totalement autonome en modifiant automatiquement leur parcours si nécessaire et en transmettant des images de la zone survolée en direct.

- Des robots-pingouins volants

C'est assez extraordinaire à voir ces pingouins artificiels qui nagent ou volent. Ceux qui volent sont remplis d'hélium. L'intérêt, c'est une dépense d'énergie minime.

A la Foire de Hanovre, Festo a montré un engin autonome, capable de se mouvoir comme le manchot véritable. Les tests ont montré une consommation d’énergie de 20 à 30% inférieure aux moyens de locomotion habituellement dévolus à ce type de déplacement sous l’eau.

Ces maquettes de 77 cm de longueur et 19 cm de diamètre maximum sont construites sur un squelette d’acier inclus dans une matrice de silicone flexible, leur permettant d’imiter les mouvements naturels du manchot. Les surfaces flexibles des ailerons et des pattes arrière (faisant office de gouvernail) s’orientent ainsi naturellement selon un angle optimal, leur corps flexible permettant encore plus de souplesse. Ils peuvent ainsi modifier leur angle de tangage, prendre des virages très serrés ou même nager à reculons.

Les segments de la tête, du cou et de la queue ont été conçus pour reproduire ceux de l’original, bâtis sur un assemblage de vérins, de leviers et de joints recouverts d’un revêtement souple et déformable. Ces segments sont reliés entre eux par des joints rotatifs pour une plus grande liberté de mouvement.

L’ensemble est animé par un seul moteur électrique, dont la vitesse de rotation contrôle aussi la fréquence de battement des ailes, montées sur un ingénieux système différentiel permettant d’en varier alternativement l’amplitude. Le système est conçu dans son ensemble afin que, grâce notamment avec le principe de torsion élastique des ailes en cours de battement, la nage ressemble à celle des manchots. La vitesse atteinte est de 5 km/h avec une autonomie de 6 à 7 heures.

Parallèlement à cette réalisation, les ingénieurs de Festo ont également construit un modèle volant, dont le torse, construit en matériaux légers, est totalement étanche et rempli d’hélium. D’une longueur cette fois de 3,70 mètres pour 88 cm de diamètre pour seulement 1 kg (sans hélium), celui-ci évolue de la même façon que le précédent, non dans l’eau, mais bien dans l’air libre !

Communiquant avec un centre de contrôle aussi bien qu’entre eux, ils peuvent se mouvoir indépendamment sans jamais se heurter ou évoluer en groupe comme de véritables animaux.

<- Revue des sciences précédente | Revue des sciences suivante ->

Les commentaires sont fermés.