- Toutes les particules intriquées ?

- Le risque de trous noirs au LHC réévalué

- Des constantes fondamentales changeraient dans le temps et l'espace

- L'ancêtre de la vie aurait été un super-organisme marin

- Naissance de la parole

- Les questions du cerveau

- L'orgasme féminin en IRM

- Les fibres optiques rattrapées par le sans fil

- Des bombes à 6000km/h et la militarisation de l'espace

<- Revue des sciences précédente | Revue des sciences suivante ->

Revues : Sciences et Avenir - Pour la Science - Science&Vie

Brèves : Physique - Climat - Biologie - Santé - Technologie

Commençons par les bonnes nouvelles. Certains démographes pensent qu'on ne devrait pas atteindre les 9 milliards et que dès 2050 nous serons en décroissance du moins de la population qui devrait se limiter à 5 milliards en 2100, ce qui veut dire aussi qu'on vit sans doute le dernier âge de la jeunesse (comme déjà au Japon, en Europe et en Chine) ? C'est l'Afrique surtout qui devrait voir sa population exploser mais c'est un continent très peu peuplé. il y a aussi l'exploration de la mer qui n'a pas vraiment commencé encore. Une autre bonne nouvelle, ce serait le déclin de l'épidémie du Sida ? De son côté, la physique est très excitante en ce moment et bien que cela ne vienne pas d'où on l'attendait, comme à chaque fois, on sent bien qu'on est à l'aube d'une nouvelle révolution scientifique. En tout cas, des neutrinos trop rapides au Higgs introuvable en passant par l'inexplicable orientation de l'espace ou le mouvement des galaxies vers un autre univers peut-être, on ne sait plus où on est (sans parler de la matière noire ou l'énergie noire) ! Il n'y a pas que des raisons de se réjouir cependant. Le plus grave, potentiellement, c'est la réévaluation des risques de trou noir au LHC, ce qui serait la seule véritable fin du monde pour notre planète et tout son biotope, preuve qu'on prend en aveugle des risques insensés. Les biotechnologies sont sans doute une menace encore plus réelle, par exemple de rendre la grippe beaucoup plus mortelle (voir aussi New Scientist). Le risque nucléaire est toujours bien présent mais ce n'est rien à côté de ces nouveaux risques de plus en plus démesurés, d'une puissance qui nous dépasse et peut nous mener à notre perte, sans parler du climat où il semble qu'on y court avec la sortie du Canada du protocole de Kyoto, assistant à une désagrégation du même ordre que celle produite par la crise (toujours aussi insoluble avec l'imbrication des dettes). 2012 s'annonce vraiment mal.

Alors même qu'on célèbre le rôle des réseaux dans les révolutions, on fait tout pour mettre fin à leur caractère libertaire. La censure du web en Chine se renforce par l'engagement des providers à supprimer rumeurs, pornographie, fraudes et informations illégales afin que le web devienne un « foyer positif et magnifiquement spirituel ». On a vu aussi qu'internet était plus fragile qu'on ne dit, deux fournisseurs de routeurs étant trop dominants (Cisco et Juniper), la mise à jour des routeurs de Juniper a provoqué une panne mondiale, du moins sur une bonne partie du réseau. Des raisons de plus de garder ses données chez soi ce qui n'empêche pas de profiter de l'ubiquité du réseau pour qu'elles soient accessibles de partout, ce que permet le tout nouveau cloud personnel qui est déjà disponible avec OpenSuse12.1. Pour sa part Ubuntu s'étend à la télévision, visant la convergence numérique entre tous les écrans et périphériques. Il faut signaler aussi qu'une nouvelle application Facebook, Send Money, permet de transférer de l'argent à un ami, via PayPal, sans frais (ce qui est très étonnant). Un article enfin tente de nous sensibiliser au fait que nous sommes désormais à l'ère des Big Data qui devraient permettre un saut cognitif comparable à l'invention du microscope découvrant un nouveau monde, mais cette fois, c'est plutôt le macroscope espéré par Joël de Rosnay, nous dévoilant de nouvelles dimensions de notre humanité prise en masse avec les flux qui la traversent.

Sciences et Avenir no 778, Premiers échos des mondes cachés

C'est Sciences et Avenir qui est à l'honneur ce mois-ci, plus intéressante que les autres revues pour une fois. Toujours aussi écolo, un article, p8, sur les gaz de schiste prévient que le danger vient des forages profonds et pas seulement de la fracturation qu'il ne suffit donc pas d'interdire. On apprend aussi, p24, qu'on vient de découvrir à Coliboaia en Roumanie une grotte ornée semblable à celle de Chauvet et datée de 35 000 ans, témoignant de l'unité de culture de ces nouveaux européens. Même s'il n'y a rien de vraiment neuf pour nous car on en a déjà parlé, le dossier sur la détection d'autres univers est assez passionnant, manifestant à quel point on est déjà entré dans un autre monde et une nouvelle physique bien que restant très spéculative encore.

C'est Sciences et Avenir qui est à l'honneur ce mois-ci, plus intéressante que les autres revues pour une fois. Toujours aussi écolo, un article, p8, sur les gaz de schiste prévient que le danger vient des forages profonds et pas seulement de la fracturation qu'il ne suffit donc pas d'interdire. On apprend aussi, p24, qu'on vient de découvrir à Coliboaia en Roumanie une grotte ornée semblable à celle de Chauvet et datée de 35 000 ans, témoignant de l'unité de culture de ces nouveaux européens. Même s'il n'y a rien de vraiment neuf pour nous car on en a déjà parlé, le dossier sur la détection d'autres univers est assez passionnant, manifestant à quel point on est déjà entré dans un autre monde et une nouvelle physique bien que restant très spéculative encore.

Notre univers n'est-il qu'une bulle au milieu d'une myriade d'autres univers-bulles, ou univers-vallées, enchâssés dans un ensemble encore plus vaste, un méga-univers? Dans son dossier de décembre 2011, Sciences et Avenir explore les pistes apportées par les premiers résultats du satellite Planck.

- Planck piste l'empreinte d'un autre monde, p50

Si 2 bulles univers se forment assez près l'une de l'autre alors, elles pourraient se heurter lorsqu'elles entrent toutes deux en expansion rapide. Ces collisions de bulles produisent des perturbations spécifiques que nous appelons "sillage cosmique".

L'empreinte laissée par ces collisions avec un autre univers devrait se présenter sous la forme d'un cercle symétrique, dont le coeur correspond à la direction du centre de l'autre bulle.

Si notre univers a été heurté par un autre avant l'inflation, il s'est probablement formé un "mur de domaine" entre les 2 univers. Ce mur aurait des propriétés intrinsèques, notamment une très haute tension de surface, et se déplacerait à une vitesse extravagante, quasiment à la vitesse de la lumière. Selon l'impulsion de départ, il irait soit vers l'intérieur, soit vers l'extérieur de notre bulle-univers. Dans le premier cas, "au moment où je vous parle, ce mur est peut-être en train de foncer vers nous à la vitesse de la lumière, annihilant tout sur son passage", sans que nous puissions détecter aucun signe avant-coureur !

Si, par chance, le mur de domaine s'éloigne vers l'extérieur de notre univers, l'accident ne laissera derrière lui que les fameux ronds dans l'eau, le sillage cosmique.

On en avait parlé en janvier 2011.

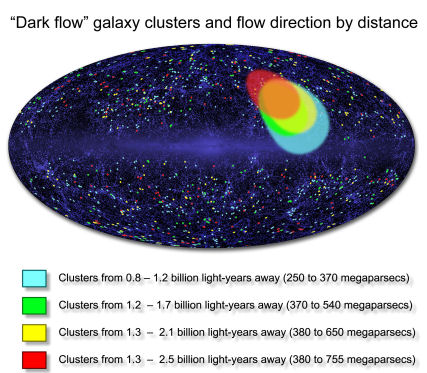

- Un mystérieux Fleuve noir entraîne les galaxies, p56

L'échantillon d'amas tout entier se déplaçait à une vitesse quasiment homogène et dans la même direction ! jusqu'à ne distance d'au moins 2,5 milliards d'années-lumière de nous les amas de galaxie naviguent de conserve à la vitesse d'environ 600 à 1000 km/s vers un port inconnu.

"Nous soupçonnons que l'origine du Dark Flow se trouve dans la structure primordiale de la trame de l'espace-temps, qui date d'avant la période d'inflation cosmologique. Cette expansion extrêmement rapide de l'univers a repoussé des structures massives bien au-delà de l'horizon cosmologique actuel, situé à environ 45 milliards d'années-lumière".

On en avait parlé en Mai 2010. Le tout est de savoir si c'est une énorme masse à l'intérieur de notre univers qui attire ces galaxies ou le flot d'une fontaine blanche à l'origine de notre univers ou encore l'attirance d'un autre univers...

On avait aussi parlé en août 2010 et janvier 2011 du sujet de l'article suivant, p58, la possibilité de confirmer que notre univers est à l'intérieur d'un trou noir par la détection de sa rotation donnant une direction privilégiée à l'espace, mais j'avais fait cette réserve :

Pour ma part, ce qui me semble ne pas aller, c'est qu'un trou noir n'est pas un événement ponctuel, comme une collision de membranes par exemple ou le supposé Big Bang, il est toujours en formation. Il y aurait donc création de matière dans le nouvel univers à mesure que de la matière tomberait dans le trou noir, sorte de porte du temps vers d'autres univers, trou de vers plutôt, mais qu'advient-il lors de l'évaporation du trou noir ?

- Les grands empires africains, p44

Dans ces régions, à l'instar de ce qui s'est déroulé le long de la vallée du Nil, à partir du premier millénaire avant notre ère, on est passé de proto-chefferies à de véritables chefferies et cités-Etats, avant que ne se constituent des royaumes et des empires. dès qu'une élite émergeait pour des raisons variées - religieuses, politico-guerrières, etc., -, un groupe dominant se mettait en place. puis, comme on ne peut pas dominer en permanence par la coercition, il y avait création de systèmes symboliques pour naturaliser cette domination. d'où l'apparition de divinités, par exemple.

Rien de bien neuf bien que "trop occulté", à part l'utilisation du fer au Cameroun dès la fin du 3ème millénaire, mais le plus amusant, c'est que Augustin Holl s'appuie sur un livre de Jacques Bude, "L'Obscurantisme libéral et l'investigation sociologique" (1973) pour soutenir que les dominants tendent à naturaliser l'ordre établi, et ce faisant engendrent des formes discursives qui se positionnent comme objectives et légitimes. Rousseau disait pourtant déjà la même chose ("Le plus fort n'est jamais assez fort pour être toujours le maître, s'il ne transforme sa force en droit, et l'obéissance en devoir."), sans parler de Marx ou Foucault mais il suffit de faire un peu d'histoire des religions pour s'en convaincre.

L'article sur les graffitis et panneaux de Pompéi, p60, confirme qu'il n'y a rien de neuf sous le soleil, notamment la haine des pauvres : "J'ai horreur des pauvres ! Celui qui demande quelque chose gratuitement est un fou : qu'il donne de l'argent et il recevra la marchandise".

- Les virus comme armes, p110

Non, les virus ne sont pas de simples parasites, non les virus n’ont pas évolué égoïstement, en volant les gènes des organismes qu’ils envahissaient… bien au contraire, éléments essentiels dans l’équilibre de la biosphère, ils ont co-évolué avec leurs hôtes…

Je considérais jusque là les virus comme "l'information circulante", ayant sans doute "inventé" l'ADN et permettant l'échange de gènes, ou bien agissant comme régulateurs de la densité de population (notamment dans les océans en fonction de la profondeur) ou encore servant à éliminer les cellules cancéreuses (à quoi servirait le rhume notamment), mais il y aurait une autre fonction importante, celle d'arme contre des envahisseurs détruisant leur environnement, ce que j'avais repéré avec la peste protégeant les Egyptiens des Assyriens. Je n'avais pas compris pourtant que c'était beaucoup plus général (mais cela peut être inversé, les européens envahissant les Amériques et décimant les populations avec leurs virus).

En tout cas, les virus sont bien partie intégrante du génome (tout comme nos bactéries commensales) du fait qu'ils sont en général spécifiques à une espèce et que les organismes résistants à ces virus n'ont pas survécu ou du moins n'ont pas été sélectionnés par rapport à ceux qui y restaient vulnérables.

Lorsqu'un virus infecte une espèce vivante, il se produit une première phase de "symbiose agressive", au cours de laquelle le virus élimine une partie de la population infectée. Vient ensuite la deuxième phase : le virus et les hôtes survivants se sont "acclimatés" l'un à l'autre en un partenariat où chacun trouve un avantage. Si un ennemi se met à envahir la niche écologique de l'hôte et à épuiser ses ressources alimentaires, le virus a la possibilité de sauter la barrière des espèces et d'éliminer ainsi l'ennemi au plus grand bénéfice de l'hôte...

Il en va tout autrement pour les virus modifiés artificiellement qui pourraient être dévastateurs puisqu'on a appris en ce début de mois de décembre qu'un virus de la grippe H5N1 modifié serait le plus mortel jamais rencontré...

Pour la Science no 410, La Voie lactée déformée par la matière noire

- La puissance des méthodes quasi-aléatoires

Les méthodes de Monte Carlo font intervenir des nombres pseudo-aléatoires pour effectuer de lourds calculs numériques. Mais des nombres dits quasi-aléatoires, où le hasard a moins de place, se révèlent parfois plus efficaces.

Au début des années 1990, Spassimir Paskov, étudiant en thèse à l'Université Columbia, commençait à analyser un instrument financier exotique nommé cmo (Collateralized Mortgage Obligation, obligation garantie par une hypothèque) introduit par la banque d'investissements Goldman Sachs. Il cherchait à estimer la valeur actuelle d'un cmo, d'après les possibles encaissements à venir correspondant à des milliers d'emprunts-logement sur 30 ans. Il ne s'agissait pas simplement d'appliquer la formule usuelle pour les intérêts composés. Beaucoup d'emprunts-logement sont liquidés en avance quand le logement est vendu ou refinancé ; certains emprunts ne sont pas honorés ; les taux d'intérêt montent et baissent. Ainsi, la valeur actuelle d'un cmo sur 30 ans dépend de 360 (30 3 12) flux de trésorerie mensuels incertains et interdépendants. Il s'agissait donc plutôt d'évaluer une intégrale dans un espace à 360 dimensions.

Il n'y avait aucun espoir de faire une évaluation exacte. S. Paskov et son directeur de thèse, Joseph Traub, ont décidé d'essayer une technique d'approximation quelque peu obscure, la méthode de « quasi-Monte Carlo ». Un calcul de Monte Carlo ordinaire prend des échantillons aléatoires dans l'ensemble de toutes les solutions possibles. La variante « quasi » effectue un échantillonnage d'un type différent, non aléatoire, mais pas tout à fait régulier non plus. S. Paskov et J. Traub ont trouvé que certains de leurs programmes de quasi-Monte Carlo tournent mieux et plus vite que la technique classique. Leur découverte permettrait à un banquier ou un investisseur d'estimer la valeur d'un cmo en quelques minutes de calcul seulement, au lieu de plusieurs heures.

Cela ferait une belle histoire si l'on pouvait alors raconter que la période « d'exubérance irrationnelle » qui a suivi sur les marchés financiers (la frénésie des transactions de produits dérivés complexes, et le triste cortège de crise, effondrement, récession, chômage) avait pour origine une innovation mathématique dans l'évaluation des intégrales de dimension élevée. Mais ce n'est pas le cas ; il y avait d'autres causes à cette folie.

Cependant, les travaux de S. Paskov et J. Traub ont bien eu un effet : ils ont suscité un extraordinaire regain d'intérêt pour la méthode de quasi-Monte Carlo.

Ces méthodes aléatoires imitent les stratégies exploratoires du vivant (générateurs aléatoires de diversité), un peu comme la canne tâtonnante de l'aveugle. Ce n'est donc pas le caractère vraiment aléatoire qui compte mais uniquement d'en mimer le caractère erratique pour cribler sa cible.

- Les grands-parents : un moteur de l'évolution

La survie de plus en plus fréquente d'humains âgés a sans doute contribué au succès évolutif des hommes anatomiquement modernes.

Les recherches que j'ai conduites avec mes collègues montrent que les adultes assez âgés pour être grands-parents ne sont fréquents dans les sociétés humaines que depuis la Préhistoire récente. Elles indiquent par ailleurs que l'augmentation de leurs effectifs s'est produite à peu près en même temps que les mutations culturelles ayant conduit à des comportements modernes, notamment la communication par symboles qui sous-tend l'art et le langage. Ces découvertes suggèrent que l'allongement de la durée de vie a eu de profonds effets sur la démographie, les interactions sociales et la génétique des premières populations d'hommes anatomiquement modernes (Homo sapiens). Elles pourraient aussi expliquer leur succès évolutif par rapport aux humains archaïques, tels que les Néandertaliens.

Nous nous attendions à voir la longévité augmenter au fil du temps, et c'est bien le cas : elle croît légèrement avec le temps à travers l'ensemble des échantillons. Bien plus frappant est le fait que, sur une même durée, le ratio vieux-jeunes est multiplié par cinq ! Ainsi, pour dix jeunes adultes néandertaliens qui mouraient entre 15 et 30 ans, seulement quatre adultes passaient 30 ans, alors que dix jeunes adultes anatomiquement modernes européens du Paléolithique supérieur (il y a entre 35 000 et 8 000 ans) pouvaient être accompagnés par 20 adultes assez âgés pour être leurs grands-parents.

Trente ans, c'est aujourd'hui la fleur de l'âge ! Même les chasseurs-cueilleurs des périodes récentes dépassaient la trentaine. Les Néandertaliens de Kaprina, cependant, ne sont pas les seuls dans ce cas à leur époque. Dans les quelques endroits où ont été découverts un grand nombre d'individus fossilisés, la même mortalité élevée est observée. C'est ainsi le cas à Sima de los Huesos, à Atapuerca, en Espagne, un site datant de quelque 600 000 ans, où tous mouraient avant 35 ans et très peu atteignaient cet âge.

Cette longévité, qui, initialement, fut la conséquence imprévue d'un changement culturel, est devenue une condition préalable à la mise en place de comportements modernes. Ces innovations ont accru à leur tour l’importance des aînés et leur longévité, d’où un essor démographique qui a eu des effets culturels et génétiques profonds sur nos ancêtres.

On en avait déjà parlé au mois d'août (et déjà en 2009), ce n'est donc pas une véritable nouveauté mais il est bon d'insister sur l'importance de l'augmentation de l'espérance de vie et du soin aux plus âgés dans les fondements de la culture et l'avantage que procurait la présence de grand-parents assurant la continuité de la culture, peut-être l'élément le plus décisif dans la domination de l'homo sapiens sur Neandertal avec la constitution de groupes plus nombreux, à l'origine de la révolution culturelle des années -50 000. Du coup, le langage narratif pourrait être beaucoup plus ancien sans avoir pu porter à toutes ses conséquences avant que les grands parents ne puissent raconter de vielles histoires ?

Article amusant sur les contradictions de l'absolu comme de l'infini.

Le premier paradoxe de la toute-puissance est le paradoxe de la pierre. Il semble être connu depuis le XIIe siècle et a été discuté par Averroès (1126-1198) et Thomas d'Aquin (1224-1294). Il s'exprime sous la forme d'une question : Un être tout-puissant peut-il créer une pierre si lourde qu'il ne puisse la soulever ? S'il ne peut créer une telle pierre, c'est qu'il n'est pas tout-puissant. S'il le peut, alors, puisqu'il ne pourra pas soulever la pierre créée, c'est qu'il n'est pas tout-puissant. Conclusion : il n'existe pas d'être tout-puissant.

Thomas d'Aquin répond que ce type de paradoxe se fonde sur une incompréhension de la toute-puissance. Un être tout-puissant ne l'est que dans la mesure où ses actes ne s'opposent pas à la logique, c'est-à-dire ne sont pas des absurdités : « Ce qui implique contradiction ne tombe pas sous la toute-puissance de Dieu. » Créer un « cercle carré » est logiquement impossible. Cela n'a aucun sens de demander une telle chose à un être tout-puissant. Être tout-puissant, c'est seulement disposer du pouvoir de faire tout ce qui ne s'oppose pas à la logique.

Le philosophe anglais contemporain Tzachi Zamir soutient que la toute-puissance inclut la possibilité de ne plus l'exercer et qu'un être tout-puissant peut décider à tout moment, puisqu'il est libre, de ne plus l'être : un charpentier peut décider de construire un bateau si lourd qu'il sera incapable de le soulever une fois terminé. Dieu peut faire de même : il n'y a donc pas de contradiction en soi dans la question de la lourde pierre.

Certains philosophes ont défendu l'idée que le dieu de la Bible, réputé omnipotent, pouvait s'opposer à la logique. Descartes, par exemple, attribue au dieu des chrétiens le pouvoir extrême de changer des vérités qui nous semblent nécessaires, y compris les vérités mathématiques.

À l'opposé des idées de Descartes sur le pouvoir supposé de son dieu de changer même les mathématiques, saint Augustin (354-430) dans La cité de Dieu définit l'omnipotence comme la possibilité de faire tout ce que nous voulons, et non tout ce que nous pouvons imaginer qu'un être pourrait vouloir.

Cette solution n'est guère satisfaisante : pour être omnipotent, il suffit de ne rien vouloir ! Chacun peut devenir tout-puissant en limitant ses désirs à ce qu'il lui est facile d'obtenir.

Nul être ne peut être "tout puissant", annulant logique et temporalité en identifiant cause efficiente et objectif final ou séparant le positif du négatif qui est son envers, pas plus qu'il ne peut être "omniscient" (il y a de l'indécidable, de l'incalculable et de l'imprévisible, tout savoir se construisant sur l'ignorance, toute information réduisant une incertitude préalable constituant sa pertinence, sinon elle est ignorée). Il est bien sûr absurde de penser qu'un dieu pourrait décider de la logique qui ne fait que tirer les conséquences d'un énoncé ou axiome. En fait, ce ne sont que des mots et le sentiment de toute-puissance, qui n'a rien d'aussi exceptionnel, vient de la possibilité de dire n'importe quoi et de la position d'auteur que nous donne l'énonciation, faisant partie des maladies du langage.

Science&Vie no 1131, "Dinosaure, Mammouth, Neandertal peuvent revivre''

Ainsi on apprend, p66, que des généticiens envisagent sérieusement de reconstituer le génome de l'homme de Neandertal par réécriture génétique des millions de différences répertoriées... On peut vraiment s'attendre au pire avec les biotechnologies, pas seulement des hommes augmentés mais des hommes diminués, si l'on peut dire (sans parler des armes biologiques) ! Dans ce cas pourtant on ne reconstituerait pas un véritable homme de Néandertal car les mitochondries seraient humaines alors qu'elles étaient différentes, ne témoignant d'aucun croisement avec une femme néandertale. Bien sûr on ne peut nier que l'expérience serait pleine d'enseignements mais si l'éthique a un sens, c'est bien de ne pas transformer de hommes en cobayes comme de vulgaires nazis (mais pourra-ton l'empêcher?).

Pour les mammouths comme les dinosaures on est encore loin du compte pour y arriver (voir les critiques de Jacques Testart|https://www.futura-sciences.com/fr/news/t/paleontologie/d/des-mammouths-clones-patureront-ils-dans-la-toundra-dici-5-ans_35178/]), on est bien dans le sensationnalisme mais cela donne quand même une idée de ce qui va se faire dans pas si longtemps.

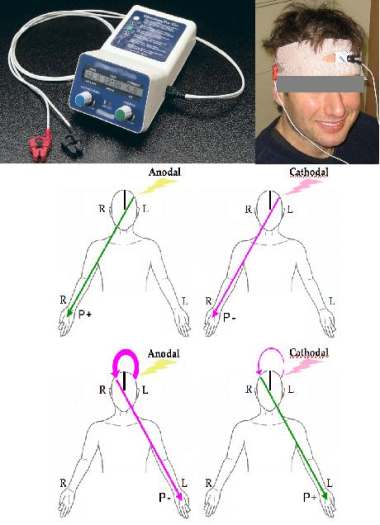

Un autre article un peu douteux, p96, prétend qu'on pourrait doper facilement son cerveau avec une pile de 9 volts !

Une pile d 9 V, un petit montage électronique de régulation du courant, deux électrodes (en pratique, du tissu imprégné d'eau salée) et un bandeau élastique pour plaquer les électrodes du crâne.

En pratique, la tDCS (stimulation transcrânienne par courant continu) ne provoque aucun comportement nouveau des neurones : elle ne fait que les rendre plus réactifs aux signaux qu'ils échangent entre eux, en modifiant la polarisation électrique de leurs membranes. En clair, elle facilite leur activité.

Quelle que soit la durée ou l'intensité de la stimulation, la fonction cérébrale visée ne sera améliorée que lors d'exercices portant sur cette capacité précise.

"Mais s'il y a vraiment un effet de potentialisation, il reste difficile de déterminer quel circuit cérébral et au niveau de quelle électrode l'effet se produira".

Il paraît cependant que l'effet serait confirmé par l'imagerie cérébrale, ce qui aurait relancé l'intérêt pour cette technique on ne peut plus simple (voir aussi le Cephaly plus bas).

Enfin, le plus important peut-être, la revue nous alerte, p104, sur les feux de charbon qui se déclenchent spontanément dans les mines à charbon abandonnées et qu'on ne sait pas éteindre. Le phénomène prend une ampleur inquiétante, tout comme les incendies spontanés des tourbières qui pourraient représenter 10 à 30% des émissions humaines...

Tout cela à vérifier mais auquel il n'est pas inutile de porter toute son attention.

Brèves et liens

Physique

cosmologie, astronomie, physique quantique

- Du nouveau sur la fonction d'onde et l'intrication

Pour les auteurs, la fonction d'onde ne serait pas statistique mais bien réelle (que faire alors de sa part aléatoire?) sinon toutes les particules seraient intriquées... ce qui est peut-être la bonne interprétation. Dans un cas comme dans l'autre de quoi repenser complètement la mécanique quantique.

Ils fondent leur explication sur un phénomène quantique : l’intrication. Quand deux particules sont intriquées on ne peut plus ensuite modifier l’état de l’une de ces deux particules sans modifier l’autre, quelle que soit la distance qui les sépare. Les trois scientifiques présentent un théorème montrant que si la fonction d'onde était un outil purement statistique, alors même les particules non liées se comporteraient ainsi. Ce qui est très improbable, les chercheurs en concluent que la fonction d'onde doit être un objet physique bien réel.

L’année dernière, une équipe française (CNRS/CEA) avait réussi à observer les fonctions d’ondes des électrons de la molécule de diazote (N2). Ce qui indiquait, déjà, que cette modélisation du comportement particulaire n’est pas qu’une simple opération de pensée.

Antony Valentini, physicien théorique à l’université Clemson de Caroline du Sud (Etats-Unis), le qualifie de « sismique » tant ses répercussions pourraient être importantes notamment dans les domaines de l’information ou du cryptage quantique.

Toujours cité par Nature News, Robert Spekkens, autre théoricien quantique, parle lui d’un article «fantastique» mais n’approuve pas la conclusion des auteurs. Pour lui, leur théorème prouve que toutes les particules quantiques, intriquées ou non, sont au final reliées.

Par ailleurs personne n'a prétendu que la fonction d'onde n'était qu'une opération de pensée et pour l'observer, il faut bien interagir avec et donc actualiser ses probabilités.

- Confirmation de neutrinos plus rapides que la lumière ?

Pour réduire l’incertitude liée au top départ des neutrinos, de nouvelles mesures ont été réalisées fin octobre début novembre avec des bouffées de protons plus courtes (environ 3 nanosecondes) et séparés de 500 nanosecondes. 20 passages de neutrinos (on dit événement en physique) ont pu être observés. Les résultats sont comparables aux précédents, affirme Dario Autiero. Les neutrinos ont toujours 60 nanosecondes d’avance.

Voir aussi Pour la Science, Techno-Science mais la controverse n'est pas terminée, notamment parce que, par analogie avec la vitesse des particules plus rapides que la lumière dans l'eau, cela devrait leur faire perdre de l'énergie, ce qui n'est pas le cas ici. Le suspens continue.

- Le risque de trous noirs au LHC réévalué

Après avoir déjà alerté l'opinion au mois d'août, ce nouvel article de Technology Review dénonce des erreurs de calcul sur les risques encourus et une trop grande assurance sur un phénomène qui reste spéculatif par absence d'expérience justement. Un risque de 1 sur 5000 de disparition de la Terre est certes déjà bien trop élevé. L'augmentation de la puissance du LHC doit donc se faire dans des conditions maximales de sécurité.

Après avoir déjà alerté l'opinion au mois d'août, ce nouvel article de Technology Review dénonce des erreurs de calcul sur les risques encourus et une trop grande assurance sur un phénomène qui reste spéculatif par absence d'expérience justement. Un risque de 1 sur 5000 de disparition de la Terre est certes déjà bien trop élevé. L'augmentation de la puissance du LHC doit donc se faire dans des conditions maximales de sécurité.

Bientôt la véritable fin du monde ? En 2012 ? Heureusement, il serait peu vraisemblable qu'on puisse créer des trous noirs aux énergies du LHC.

Par ailleurs on s'inquiète de ce que le LHC serait arrêté s'il découvrait le Higgs pour lequel il a été construit. Le fait qu'il n'existe pas serait donc une garantie de pouvoir continuer ses expérimentations. Peter Higgs ne croit pas pour sa part à cette inexistence car cela rendrait le modèle standard incohérent mais c'est ce qu'on pouvait croire pour l'éther notamment (qui certes fait retour mais sous une toute autre forme, celle des champs quantiques) et c'est bien une constante des sciences, en particulier la Physique, de contredire nos certitudes les plus ancrées et les argumentations logiques les plus convaincantes.

- Le LHC enregistre une dissymétrie entre matière et antimatière

- Créer matière et antimatière à partir du vide... et d'énergie

Un champ électrique de l'ordre du trillion (milliard de milliards, 10 puissance 18) de volts par mètre créerait des paires de particules et d'antiparticules à partir du vide. Des lasers haute puissance en construction en Allemagne et en République Tchèque devraient permettre d'atteindre ces valeurs à partir de 2015.

- Produire de la lumière à partir du vide

Le principe, c'est qu'un élément conducteur (ici des électrons supraconducteurs) à une vitesse d'un quart de la vitesse de la lumière va transmettre une partie de son énergie cinétique aux particules virtuelles produites par le vide, les transformant en particules réelles ou rayonnement. Après l'effet Casimir, qui rapproche 2 miroirs dans le vide par la pression des particules virtuelles, on a donc ici une autre confirmation de la production de ces particules virtuelles dans le vide.

Le principe, c'est qu'un élément conducteur (ici des électrons supraconducteurs) à une vitesse d'un quart de la vitesse de la lumière va transmettre une partie de son énergie cinétique aux particules virtuelles produites par le vide, les transformant en particules réelles ou rayonnement. Après l'effet Casimir, qui rapproche 2 miroirs dans le vide par la pression des particules virtuelles, on a donc ici une autre confirmation de la production de ces particules virtuelles dans le vide.

Voir aussi Futura-Sciences.

- L'accélération de l'expansion causée par le manque de matière ?

Lorsque la densité de matière serait trop faible elle aurait une pression négative pouvant expliquer l'expansion (ce serait donc l'espace vide qui enflerait ?).

Je n'ai pas bien compris mais c'est une tentative de théoriser un bord de l'univers où il n'y aurait ni temps ni espace et où le "vide" serait vide de champs et pas seulement de matière. Il y aurait aussi des bulles de néant...

- Des constantes fondamentales changeraient dans le temps et l'espace

La constante de structure fine, exprimée avec des constantes fondamentales de l’électrodynamique quantique, changerait non seulement dans le temps mais aussi dans l’espace.

Ce n’est pas la première fois que Michael Murphy et John Webb font état d’observations suggérant que la valeur de cette constante fondamentale, fixant l’intensité des forces électromagnétiques entre des particules chargées, n’était pas la même dans le passé reculé de l’univers. Aujourd'hui, l’équipe entourant ces deux chercheurs annonce que non seulement les observations portant sur la lumière des quasars sont plus solides, mais qu’en plus d’une variation dans le temps, on observe maintenant une variation dans l’espace !

Selon les astrophysiciens, lorsque l’on regarde dans deux directions opposées de la voûte céleste, le sens de variation de la valeur de cette constante est aussi différent. Dans une direction, sa valeur était plus faible dans le passé et dans une autre elle était plus forte.

- Des quasars lointains à la loupe

Des disques de matière extrêmement lumineux situés autour de trous noirs ont été observés avec une nouvelle technique permettant de grossir ces objets situés dans un univers très lointain.

Les quasars sont des astres qui brillent comme des étoiles mais qui sont situés au cœur des galaxies et doivent leur luminosité à la présence d’un trou noir massif. La matière qui tourne en orbite autour du trou noir, à très grande vitesse, avant d’être aspirée, dégage de grandes quantités d’énergie.

Cette technique consiste à transformer une galaxie située entre l’observateur (Hubble) et le quasar en loupe grossissante. La lumière, comme l’espace-temps, est déviée et déformée par la masse d’un corps. Si les trois sont alignés, l’objet, la lentille et l’observateur, l’image de l’objet forme un anneau autour de la lentille.

- Chercher la lumière de grandes villes pour détecter des extra-terrestres

Voir aussi Futura-Sciences.

- On va se prendre sur la tête le satellite pour Mars

L'échec est dû à un problème de logiciel : on ne peut ainsi même plus commander la sonde. On essaie de nous rassurer en disant que l'engin va se désintégrer en l'air. D'autres experts pensent qu'il existe un fort risque que le carburant gèle et que le tout revienne bien frapper la surface de notre planète avec ses 12 tonnes de produits hautement toxiques...

- La faille de Fukushima sous surveillance

Par ailleurs le coeur fondu pourrait atteindre le sol. La catastrophe de Fukushima semble donc loin d’être terminée...

- Manipuler des nanoparticules avec des électrons

On le faisait déjà avec ce qu'on appelle des "pinces optiques" mais avec les électrons d'un microscope électronique, on aurait une sensibilité mille fois supérieure.

- Une condensation Bose-Einstein dans des noyaux atomiques

- Encore une vidéo de lévitation supraconductrice

- Un acier capable de remplacer le titane

Il s'agit d'un acier non magnétisable possédant une structure cristalline austénitique, transformée par écrouissage. C'est l'étape de transformation par écrouissage qui rend l'acier suffisamment résistant, davantage même que le titane. De plus, cet acier reste insensible aux champs magnétiques à température extrêmement basse. Enfin, le coût de l'acier est trois fois moins élevé que celui du titane.

Les quasi-cristaux sont des matériaux dont les atomes présentent une structure régulière - ils suivent des règles mathématiques - mais ne se répètent jamais. Ils ont été décrits pour la première fois par Daniel Shechtman, scientifique israélien, en 1982. Pour cette découverte, il a été récompensé par le prix Nobel de Chimie 2011.

Dans la revue Physical Review Letters, des chercheurs de l’université du Michigan présentent un nouveau quasi-cristal identifié grâce à des simulations informatiques. Ils se composent de particules en forme de bipyramides tétraèdres. C’est seulement le deuxième quasi-cristal composé de particules solides connu.

L’arrangement des atomes dans les quasi-cristaux leur confère des propriétés particulières. Ils sont typiquement durs et cassants et se comportent comme des isolants thermiques et électriques bien que ce soient des alliages métalliques. Ils peuvent rentrer dans la composition de certains revêtements (ce qui a été réalisé dans le cas d'une poêle anti-adhésive) ou en tant qu'isolant thermique dans les moteurs diesels.

Voir aussi Sciences et Avenir et Futura-Sciences.

Climat

Climat, écologie, énergies

- La mer gèle et les étoiles de mer avec

Le documentaire Frozen Planet de la BBC montre comment l'eau de mer peut geler par endroits, via un courant froid qui tue tout sur son passage. Le processus est très particulier et s'observe dans les océans arctique et antarctique.

Le processus, filmé en timelapse, prend plusieurs heures.

Voir aussi Futura-Sciences.

- Les micro-organismes du permafrost pourraient capturer le méthane dégagé

Une expérience de laboratoire à partir d'un prélèvement de permafrost porté à 5°C semble montrer que les dégagements de méthane se réduisent assez rapidement par l'action de micro-organismes qui reviennent à la vie et transforment ce méthane en CO2. De quoi réduire le risque de la bombe méthane mais pas de le supprimer puisqu'on sait qu'un tel emballement a déjà eu lieu dans le passé.

Une expérience de laboratoire à partir d'un prélèvement de permafrost porté à 5°C semble montrer que les dégagements de méthane se réduisent assez rapidement par l'action de micro-organismes qui reviennent à la vie et transforment ce méthane en CO2. De quoi réduire le risque de la bombe méthane mais pas de le supprimer puisqu'on sait qu'un tel emballement a déjà eu lieu dans le passé.

Voir aussi Futura-Sciences.

- Fonte du pergélisol: la bombe à retardement climatique

La fonte accélérée des sous-sols arctiques gelés, le pergélisol, va encore accentuer l'effet du réchauffement climatique dans des proportions d'autant plus inquiétantes qu'elles sont largement sous-estimées par les modèles climatiques actuels.

Au total, les terres arctiques renfermeraient quelque 1700 milliards de tonnes de carbone.

C'est «environ quatre fois plus que tout le carbone émis par les activités humaines au cours des temps modernes et le double de ce que contient l'atmosphère actuellement»

Selon leurs calculs, la fonte du pergélisol va relâcher dans l'atmosphère un volume de carbone équivalent à celui produit par la déforestation, si cette dernière se poursuit au rythme actuel. Mais ces émissions auront un impact sur le réchauffement climatique 2,5 fois plus élevé, car la fonte du pergélisol produit non seulement du dioxyde de carbone (CO2), mais aussi du méthane (CH4).

Quel que soit le scénario de réchauffement retenu, l'essentiel du carbone émis dans l'atmosphère serait du CO2, le méthane ne représentant qu'environ 2,7% du total. «Néanmoins, le CH4 ayant un potentiel de réchauffement global plus élevé, il serait responsable de plus de la moitié du changement climatique induit par les émissions de carbone du pergélisol».

- Le réchauffement moins sensible au CO2 que prévu ?

La comparaison avec le réchauffement de la fin du dernier âge glaciaire qui se termine à partir de 20 000 ans semble indiquer que l'effet du CO2 se situerait dans la fourchette basse de ce qui avait été prévu, à 2,4°C en 2100 plutôt que 4°C. Cela fait une grosse différence entre le difficile et l'ingérable mais c'est sans doute une conclusion hâtive car trop linéaire en ces domaines où le passage d'un seuil (comme la disparition de la calotte arctique) peut déclencher un emballement, d'autant que cette bonne nouvelle est relativisée par le fait qu'on devrait connaître une accélération des effets, assez dramatiques si on les compare au dernier grand réchauffement, et compensée par la mauvaise nouvelle d'augmentation considérable des émissions de CO2. L'incertitude règne mais les risques restent.

Voir aussi Futura-Sciences.

- En réduisant le CO2 on taxe le CAC40 au profit de l'emploi

- Imprimer le graphène en 3D avec une jet d'encre

- Des électrodes de batterie en graphène et silicium

Les batteries lithium-ion pourraient voir leur autonomie décuplée et le temps de recharge se réduire à un quart d’heure : c’est ce que démontre une équipe de physiciens. L’astuce : modifier la structure des électrodes pour les rendre plus efficaces, avec du graphène, du silicium et des trous.

Il y a aussi une cathode en hexacyanoferrate de cuivre. Voir aussi Futura-Sciences.

- Des batteries aux fluorures métalliques sans lithium

Les fluorures métalliques sont certes déjà utilisés en tant que matériau de conversion dans les batteries lithium-ion. Cependant, il est possible de s'affranchir de l'élément lithium en employant des électrolytes contenant du fluor, une anode en métal et une cathode en fluorure métallique. Les batteries ainsi obtenues présentent une capacité et une sécurité nettement plus élevées que celles utilisant la technologie lithium-ion. Dans le cas présent, ce sont les anions fluorure qui assurent le transfert de charges. "Du fait que plusieurs électrons par atome métallique peuvent être transférés, ce concept permet d'obtenir des densités d'énergie importantes - jusqu'à dix fois plus élevées que les batteries lithium-ion actuelles".

- Extraire du lithium de la saumure utilisée en géothermie

On pourrait en extraire aussi du manganèse et du zinc.

Par exemple, ce stockage par hydrogène solide.

- Des piles à combustibles plus efficaces

C'est une pile à combustible à oxyde solide qui fonctionne à 350°C au lieu de 900°C et peut utiliser de l'essence.

- Record d'efficacité pour une cellule photovoltaïque: 36.9%

Cette avancée est possible grâce à la structure en trois couches de la cellule photovoltaïque : une première couche d'arséniure d'indium-gallium, une seconde couche d'arséniure de gallium au milieu, puis une couche d'arséniure d'indium-gallium pour la couche supérieure. Cette structure permet d'atteindre à la fois une absorption maximale et une efficacité de conversion très importante. Elle est utilisée pour les satellites spatiaux.

Sharp annonce avoir atteint cette efficacité de conversion grâce à la réduction de la résistance des jonctions entre les couches de cellules photovoltaïques en série.

- Des nanostructures absorbant plus d'énergie solaire

- SOLARSHIP: un dirigeable 100% électro-solaire !

- Des centrales solaire se feront peut-être

Tout peut être mis en place en moins de 30 ans si on le souhaite ardemment. L'idée est que ces centrales collectent depuis l'espace l'énergie du soleil (24h/24) et la renvoient vers la Terre. Mettre une centrale de ce type en orbite est réalisable techniquement d'ici une décennie environ en utilisant les technologies disponibles ou en développement.

Les avantages de l'énergie solaire collectée dans l'espace par rapport à l'énergie solaire au sol sont qu'il n'y a aucune influence météorologique ou moyen difficile de stockage.

- L'exploitation intensive des gaz de schiste

Aux États-Unis, Fort Worth est la première grande ville à avoir autorisé l'exploitation du gaz de schiste dans son périmètre. Enquête sur une déferlante incontrôlée.

- La fracturation hydraulique cause des tremblements de terre

- EDF pourrait abandonner l'EPR ?

Cet article n'a pas plu à EDF qui l'a démenti, pour des raisons commerciales évidentes, mais qui pourrait être quand même vrai, l'EPR étant ingérable, produit d'une collaboration avec les Allemands désormais caduque. Seulement, il faut terminer les chantiers en cours dont celui de Finlande qui devrait s'achever en 2012, avec 5 ans de retard tout de même ! On le dit plus sûr mais pas beaucoup plus que les centrales actuelles avec sans doute plus de problèmes à cause d'une trop grande complexité des sécurités électroniques...

Caractéristiques de l'EPR et chantiers à travers le monde. © ide.fr

- Charger une voiture électrique sans contact : tests prometteurs au Japon

Mistubishi voit des chargeurs publics répartis partout où les voitures se garent...

Un chargeur électrique à distance est en test au Japon. Basé sur une technique nouvelle mise au point par une start-up américaine, Witricity, il permet de recharger les batteries d’une voiture électrique, avec une puissance de plus de 3 kW et une perte inférieure à 10 %.

Sur le plan théorique, le problème est bien compris, le phénomène à l’œuvre étant le même qu’à l’intérieur d’un transformateur. Un courant alternatif circulant dans un anneau ou une bobine de cuivre génère un champ magnétique qui s’étend aux alentours. Si un second anneau de cuivre est approché du premier, ce champ y génère un courant électrique. Au prix d’une perte d’énergie, la puissance électrique a bien été transmise d’un anneau à l’autre.

Avant de créer Witricity, l’équipe du MIT (dont André Kurs, Robert Moffatt et Marin Soljačić) avait découvert comment obtenir une résonance entre les champs des deux anneaux pour obtenir un bon rendement, c’est-à-dire réduire la perte d’énergie. Aujourd’hui, l’entreprise annonce dépasser les 90 %. Autrement dit, un peu moins de 10 % de l’énergie électrique est perdue.

- Recharger sa voiture électrique en roulant

Grâce à un couple de bobines placées l'une sous l’asphalte et l'autre dans la voiture, les scientifiques ont réussi, en laboratoire, à faire passer l’énergie de la première vers la seconde. Les deux bobines sont associées grâce à une longueur d'onde très précise.

Ils ont mesuré que 10 kilowatts pouvaient être transférés au bout de 7 microsecondes, avec une efficacité de 97 %, ce qui est suffisant dans le but d'effectuer une recharge à la vitesse autorisée sur une autoroute.

Cette fois on est très loin de l'opérationnel.

- Des nanomatériaux pour rendre les voitures plus légères

De nouveaux nanomatériaux ultra-résistants, résultats d'un projet de recherche financé par l'union européenne pourraient rendre les voitures jusqu'à 100 kg plus légères et réduire la consommation de carburant de 5%. Les résultats du projet "Nanotough" dirigé par l'université d'Aalborg ont porté leurs fruits et sont maintenant présentés comme l'une des plus belles réussites de la commission recherche et innovation de l'union européenne.

Au cours des 3 dernières années, les chercheurs ont testé différents nanomatériaux afin d'élaborer de nouveaux plastiques assez résistants pour concurrencer les matériaux actuellement utilisé qui contiennent souvent des renforts métalliques.

Les pare-chocs automobiles sont l'une des pièces pour lesquelles les chercheurs de Nanotough ont été le plus à même de réduire le poids. Les crash-tests planifiés pour la fin de l'année devraient aider à démontrer que ceci a pu être réalisé sans faire de concession sur la sécurité. De même, des prototypes de tableaux de bords et de pneus possédant des propriétés de résistance accrues ont pu être élaborés en utilisant de la nano-argile. Les mêmes principes ont été appliqués pour la conception de joints et de fixations pour l'industrie aérospatiale ainsi que pour l'élaboration de nouvelles méthodes d'emballage.

- Une prise qui se débranche toute seule

Son nom est Eco-Socket, et elle a le mérite d'être « intelligente », plutôt que de laisser un appareil à batterie branché alors que celui-ci est chargé complètement, l'Eco-Socket éjecte la prise grâce à son mécanisme. Une innovation au concept simpliste qui a été imaginée par le designer Ya-Hui Chi et a été réalisée pour le concours Liteon Award 2011.

Ces ampoules s'allument instantanément, n'émettent quasiment ni UV, ni infrarouges. Les modèles vendus aux États-Unis sont disponibles à partir de 20$ pour l'équivalent d'une ampoule incandescente de 40W (qui consomme 10W en réalité) jusqu'à 60$ pour un équivalent de 75W halogène (18W en réalité).

- Des bouteilles de vin en carton plastifié

Scénario d’utilisation des terres agricoles et forestières (pdf).

- Airdrop, un récupérateur d'humidité autonome

Le dispositif pompe de l'air dans un réseau de tuyaux souterrains frais qui va condenser l'eau. L'humidité ainsi récoltée va alimenter les racines d'une plante voisine. On peut espérer récupérer au moins 11,5 ml d'eau par mètre cube d'air. Un tel système autonome (qui n'a pas besoin d'énergie externe) pourrait faire pousser des plantes dans les régions les plus sèches. Le prix Dyson était de 14 000 dollars.

- Une forêt verticale en plein cœur de Milan

Les structures pourront accueillir plus de 900 arbres et plantes qui occuperaient normalement 3.000 m² si cette forêt se trouvait à l’horizontal. Les plantes absorberont la poussière et le dioxyde de carbone, fourniront de l’oxygène et protégeront les immeubles du bruit et de la chaleur.

- Une maison de Hobbit écolo et pas chère

- Un maison qui fait de la musique quand il pleut

Biologie

évolution, génétique, biodiversité, éthologie, anthropologie, neurologie

La présence d'eau sur Mars est de plus en plus attestée pour le passé laissant penser que la vie a pu s'y développer qui pourrait s'être réfugiée sous terre désormais.

- La vie sous les glaces d'Europe ?

De nouvelles analyses des images fournies par la sonde Galileo qui a exploré Jupiter et ses lunes entre 1995 et 2003 confirment la présence de grandes étendues d’eau liquide, du volume des Grands Lacs d’ Amérique du Nord, sous la surface glacée d’Europe, l’un des quatre plus gros satellites de la planète.

Dans la revue Nature, des astronomes de l’université du Texas démontrent que « même si la couche de glace est épaisse, elle peut se mélanger vigoureusement. Cela qui rend Europe et ses océans plus habitables ». Les scientifiques se sont concentrés sur les images de deux structures à peu près circulaires déformée par des fissures et de la glace morcelée.

Selon les chercheurs, l’eau liquide plus chaude peut remonter jusqu’à trois kilomètres de la surface et fait craquer la glace au-dessus. Ces poches d’eau pourraient constituer un milieu propice au développement de la vie.

Voir aussi Futura-Sciences.

- L'ancêtre de la vie aurait été un super-organisme marin

La reconstitution des protéines les plus anciennes retrouvées dans toutes les cellules vivantes montre que LUCA avait des enzymes pour casser et extraire de l'énergie des nutriments, ainsi que les mécanismes pour faire des protéines mais manquait des mécanismes liés à la lecture ou la formation de l'ADN.

- LUCA pouvait utiliser aussi bien les nitrates que le carbone pour produire de l'énergie.

- LUCA ne pouvait avoir que des membranes isoprénoïdes, beaucoup plus perméables que les membranes plus tardives.

- LUCA devait avoir aussi des organelles ou compartiments cellulaires différenciés.

Le point crucial, c'est que LUCA était un "progenote", avec un faible contrôle de ses protéines. Les progenotes peuvent fabriquer des protéines en utilisant un modèle génétique mais sans correction d'erreurs ce qui fait que les protéines avaient peu de chance de ressembler au modèle.

La question du ribosome n'est pas abordée qui ne semble pas présent à ce stade mais qui, étant commun à toutes les cellules, doit dater aussi de cette lointaine époque.

Il devait donc y avoir une soupe de gènes, le règne des virus permettant de sélectionner les protéines utiles et de construire les bases de la vie (de là à parler de super-organisme...). Les véritables cellules auraient été concomitantes avec les premières traces d'oxygène, il y a 2,9 milliards d'années (après l'oxydation du fer marin par les volcans bien qu'une nouvelle étude recule l'oxygénation d'1 milliard d'années !). On comprend bien que cet organisme primitif ne pouvait plus exister en compétition avec la reproduction des cellules actuelles, sauf que, ce qui en reste, ce sont justement les virus (mais qui sont des bouts d'ADN alors que LUCA ne connaissait que l'ARN).

- Les protéines du ribosome le stabilisent

Le ribosome est une magnifique machine moléculaire responsable de la traduction de l'ARN messager, c'est à dire de la synthèse des protéines. Chez E. coli, il est constitué de trois molécules d'ARN et de cinquante quatre protéines ribosomiques. L'ARN ribosomique (ARNr) est l'acteur principal de la traduction.

Ils ont étiré à l'aide de pièges optiques des molécules individuelles d'ARN et ont observé l'interaction avec la protéine L20. L'utilisation de cette technique montre de manière directe que la protéine agit comme une pince stabilisant la structure de ses sites de liaison à l'ARN, qui constituent le coeur du fonctionnement du ribosome.

En résumé, sur cet exemple de l'interaction L20-ARN, les chercheurs ont démontré que l'étirement d'un fragment d'ARN permet de dire où et avec quelle affinité il interagit spécifiquement avec une protéine. Aucune autre technique ne peut donner cette double information. Ces résultats présentent un intérêt général pour la biologie (assemblage du ribosome et régulation de la traduction) et la physique (physique statistique et mesures de force sur molécule unique).

- Des anticorps poussent les microbes à s'entretuer

Des anticoprs font croire à certaines bactéries qu'elles sont en surnombre afin qu'elles s'exterminent entre-elles. Cela se fait aussi en accroissant les communications entre les bactéries. Cette découverte révèle donc un mécanisme insoupçonné qui a de grandes implications médicales.

- Archaeopteryx avait un plumage noir

C'est en Argentine qu'une équipe de paléontologues de l’université de Louisville a fait cette découverte : deux crânes appartenant à une espèce de mammifère primitif du crétacé supérieur et baptisé le Cronopio dentiacutus, ce dernier a été identifié comme appartenant aux dryolestoïdes, groupe de mammifères éteint, probablement en amont des lignées de marsupiaux et placentaires modernes.

La bête mesurait entre 10 et 15 cm et était munie d'une mâchoire au long museau et d'incisives acérées ainsi que de larges yeux.

- Un poisson à 3 yeux (près d'une centrale nucléaire!)

- Des rhinocéros héliportés pour les sauver...

19 rhinocéros ont ainsi été héliportés sur 1500km par le WWF pour sauver cette espèce menacée du braconnage pour leurs cornes.

- Disparition des abeilles, des remèdes pire que le mal

Censés protéger les colonies d'abeilles domestiques contre leurs parasites, un antibiotique et des acaricides constituent, lorsqu'ils sont associés, un cocktail mortel. C'est ce que montre une étude américaine, confirmant l'idée que le mal qui frappe les abeilles partout dans le monde est le résultat d'une combinaison de facteurs.

Ils ont en effet montré que couplé avec l’antibiotique, le coumaphos fait passer la mortalité des abeilles de 7 % à 51 % et le fluvalinate de 5,6 % à 39 %.

- Des ruches pour éloigner les éléphants

90 % des éléphants sont effrayés quand ils entendent le bourdonnement des abeilles et fuient. De plus, lors de la fuite, ils émettent un grondement spécifique qui prévient leurs congénères du danger.

Dix-sept fermes ont été entourées d’une barrière de ruches (une tous les 10 mètres, reliées deux à deux par des câbles).

Lorsque les éléphants tentaient de s’approcher des fermes protégées par les barrières de ruches, la secousse des câbles provoquait une agitation des abeilles au sein de la ruche, faisant fuir immédiatement les intrus.

- Les corbeaux désignent les objets

Ils peuvent attirer l'attention et désigner des objets avec leur bec à destination d'autres corbeaux qui regardent, témoignant ainsi de leurs grandes capacités de communication et de coopération.

Ils peuvent attirer l'attention et désigner des objets avec leur bec à destination d'autres corbeaux qui regardent, témoignant ainsi de leurs grandes capacités de communication et de coopération.

- Les primates sont devenus sociaux en devenant diurnes

Et en devenant sociaux, ils ont eu besoin d'un plus gros cerveau.

L'utilisation des gestes dans la communication caractérise les singes qui nous sont les plus proches, on peut donc y voir les prémices du langage sauf que ces gestes sont moins stéréotypés chez les singes et qu'ils ne savent pas naturellement montrer du doigt, ce que fait un enfant de 14 mois témoignant de son lien au langage, à la nomination.

L'utilisation des gestes dans la communication caractérise les singes qui nous sont les plus proches, on peut donc y voir les prémices du langage sauf que ces gestes sont moins stéréotypés chez les singes et qu'ils ne savent pas naturellement montrer du doigt, ce que fait un enfant de 14 mois témoignant de son lien au langage, à la nomination.

- Du rôle de la cuisson dans l’évolution

Une étude confirme le fait que la viande cuite fournit plus d'énergie que de la viande crue, un résultat qui suggère que la cuisson a joué un rôle clé dans l'évolution de l'Homme.

Bien que les premiers humains aient commencé à manger de la viande il y a près de 2,5 millions d'années, sans possibilité de contrôler le feu, les premières assiettes préhistoriques contenaient de la viande crue probablement martelée à l’aide d’outils de pierre. Il y a environ 1,9 millions d’années un changement soudain est apparu : la corpulence des premiers humains a augmenté, leurs cerveaux ont pris du poids et ils ont pu se livrer à des activités consommatrices d’énergie comme de longues marches ou courses. Pour les auteurs de l’étude, c’est sans doute la maîtrise du feu et la cuisson de la viande qui ont permis ces évolutions.

Il y a donc confirmation de ce qu'on supposait déjà que la cuisine précède l'hominisation, au moins pour nourrir un plus gros cerveau, et que donc la maîtrise du feu est bien antérieure aux 500 000 ans attestées jusqu'ici. Si on peut dire que l'humanité et la domestication commencent il y a 2 millions d'années, l'homme moderne datant d'un peu plus de 200 000 ans, le commencement de notre histoire et de la culture ne remontent guère avant 50 000 ans (75 000 ?), avec l'augmentation de l'espérance de vie (grand-parents) et des populations. Il est bien difficile de faire ce grand écart entre temps si reculés et si proches...

- De la peau et de l'ADN d'un ancêtre de 1,9 millions d'années

- La parole serait apparue il y a 600 000 ans

Un sac d'air (bulle hyoïde) servant aux cris et vocalisation chez tous les primates jusqu'à Lucy a disparu avec l'Homo heidelbergensis, il y a 600 000 ans, permettant de prononcer des voyelles, le premier son ayant peut-être été "duh" ou "ugg" ! Par contre, du coup on risque d'avaler de travers...

Un sac d'air (bulle hyoïde) servant aux cris et vocalisation chez tous les primates jusqu'à Lucy a disparu avec l'Homo heidelbergensis, il y a 600 000 ans, permettant de prononcer des voyelles, le premier son ayant peut-être été "duh" ou "ugg" ! Par contre, du coup on risque d'avaler de travers...

Voir aussi New Scientist.

- La pêche au thon date de 42 000 ans au moins !

La découverte d’ustensiles de pêche vieux de 42 000 ans indique que les premiers humains ont développé la pratique de la pêche bien plus tôt qu’estimé auparavant.

- Des chevaux tachetés à l'époque de la préhistoire

Selon l’étude menée par le généticien Arne Ludwig (Leibniz-Institut für Zoo, Leibniz, Allemagne) et ses collègues, il existait bien des chevaux à robe léopard il y a 25.000 à 35.000 ans.

Ces chercheurs ont analysé de l’ADN ancien récupéré à partir d’os et de dents de 31 chevaux âgés jusqu’à 35.000 ans, antérieurs à la domestication, qui vivaient en Europe orientale et occidentale, en Sibérie et dans la péninsule ibérique. Les gènes responsables des différentes couleurs de robes étant connus, les chercheurs ont ou constater que 18 de ces chevaux étaient bais, sept étaient noirs et six étaient porteurs de la version du gène associée à la robe léopard. Ces équidés tachetés étaient en Europe, mais aucun en Sibérie.

Ils en tirent la conclusion que la représentation de chevaux tachetés comme à Pech Merle dans le Lot serait réaliste. Pourtant le témoignage d'aborigènes australiens semble attribuer de façon plus plausible ces points à des visions hallucinogènes, marqueur du monde du rêve, le côté réaliste étant ici plus que contestable :

Un peu technique...

- Une partition musicale datant de 1400 av JC

5mn de musique interprétée à partir d'une partition syrienne en cunéiforme d'il y a 3400 ans. Cela évoque plutôt la musique indienne mais pas si loin non plus de la musique arabe ou égyptienne. Le fait que ce soit joué par un spécialiste de la musique juive doit y être pour quelque chose. La fin est un peu pénible.

- La pierre de Soleil des navigateurs vikings

La « pierre de Soleil » mentionnée dans une saga scandinave, qui indiquerait la position du Soleil même par temps couvert, pouvait fort bien être un spath d’Islande selon des études conduites par des physiciens français et leurs collègues.

De fait, on trouve un intriguant passage dans la saga Hrafns où il est dit à peu près ces mots : « Le temps était couvert et orageux... Le roi regarda autour de lui et ne vit ciel bleu... Alors le roi prit la pierre de soleil et la tenant au-dessus de lui, vit d’où le Soleil brillait ».

C'est une façon de lister tout ce qu'on ne sait pas encore :

C'est une façon de lister tout ce qu'on ne sait pas encore :

2.1 Comment apprenons-nous de l'expérience ? (douleur et peine, renforcement des liaisons, élimination des neurones inutilisés)

2.2 Comment le cerveau permet-il de faire des plans sur le futur ?

2.3 Comment trouve-t-on des solutions aux problèmes et comment prenons-nous des décisions ?

2.4 Quels processus donnent sens aux événements ?

2.5 Qu'est ce que l'intelligence et qu'est-ce que penser ?

2.6 Comment invente-t-on de nouvelles idées et qu'on est créatif ? (nouvelles relations)

2.7 Comment sensation, émotion et passion influencent notre comportement ? (l'affect est puissance d'agir)

2.8 Comment le cerveau unifie l'ensemble de ses fonctions ?

2.9 Quels processus font de nous des individus ? (processus sociaux d'individuation)

2.10 Qu'est-ce que la conscience éveillée ?

Questions parallèles :

2.11 Les individus naissent-ils avec différents niveaux de compétences, talents, attributs hérités ?

2.12 Comment le cerveau appréhende le temps ?

2.13 Comment peut-on observer, décrire, définir et mesurer les qualités ?

2.14 Quels sont les bases neurales des caractéristiques de la personnalité ?

2.15 Quel est la nature du lien psychosomatique entre le cerveau et le système immunitaire ?

2.16 Comment préparer notre cerveau à l'explosion des connaissances ? (???)

2.17 Comment préparer notre cerveau à l'allongement de l'espérance de vie ?

2.18 Comment le cerveau traite l'excès permanent d'information ?

2.19 Comment le cerveau fait pour gérer le stress (comme la perte de contrôle d'une situation, ou d'être confronté à trop de responsabilités) ?

- La conscience en 12 points très connectés

Il y aurait dans le cerveau 12 centres identiques avec 2 fois plus de connexions que les autres régions et très connectés entre eux comme au reste du cerveau, ce qui suggère qu'ils pourraient être liés au mécanisme de la conscience. Ces centres ne reçoivent pas des données brutes mais déjà filtrées et structurées. Le centre le plus connecté se trouverait dans le précuneus à l'arrière du cerveau, servant sans doute d'intégrateur. Le second par ordre d'importance se trouve dans le cortex préfrontal repsonsable de la planification et de la focalisation de l'attention. Le troisième concerne l'aire visuelle. Les autres sont l'hippocampe, le thalamus, et le putamen (coordination des mouvements). Tout dysfonctionnement d'un de ces centres affecte l'ensemble du réseau.

Il y aurait dans le cerveau 12 centres identiques avec 2 fois plus de connexions que les autres régions et très connectés entre eux comme au reste du cerveau, ce qui suggère qu'ils pourraient être liés au mécanisme de la conscience. Ces centres ne reçoivent pas des données brutes mais déjà filtrées et structurées. Le centre le plus connecté se trouverait dans le précuneus à l'arrière du cerveau, servant sans doute d'intégrateur. Le second par ordre d'importance se trouve dans le cortex préfrontal repsonsable de la planification et de la focalisation de l'attention. Le troisième concerne l'aire visuelle. Les autres sont l'hippocampe, le thalamus, et le putamen (coordination des mouvements). Tout dysfonctionnement d'un de ces centres affecte l'ensemble du réseau.

- On a vu l'orgasme féminin en IRM

La vidéo montre des niveaux bas en rouge foncé et en jaune, blanc pour les forts niveaux. Si l'on regarde cette vidéo toute scientifique jusqu'au bout, on voit que le cerveau finit « tout en jaune ». Cela montre que le cerveau tout entier ou presque s'illumine.

La stimulation génitale active le cortex sensoriel (système limbique) dans un premier temps. Ensuite, les deux parties suivantes sont le cervelet et le cortex frontal. Enfin, une fois le nirvana atteint dans une apothéose, l'activité orgasmique se concentre sur l'hypothalamus, qui va secréter l'ocytocine et faire se contracter l'utérus. On remarque que le nucleus Accumbens (lié au plaisir et à la récompense) est également touché.

Juste avant l’orgasme surviennent des pics d’activité dans le cervelet et dans le cortex frontal (alors que les muscles se tendent), puis l’hypothalamus inonde le cerveau avec de l’ocytocine et de la dopamine. C’est précisément ce moment qui correspond à l’orgasme.

Voir aussi Futura-Sciences et Gizmodo.

- Les émotions musicales et la voix

"La musique est la langue des émotions", a déjà dit le philosophe Emmanuel Kant, mettant du coup le doigt sur une énigme qui fascine bien des scientifiques. Pourquoi la musique arrive-t-elle à nous faire pleurer, rire, frémir ? Pourquoi les émotions qu'elle véhicule sont-elles reconnaissables par tous les êtres humains, quelles que soient leur langue et leur culture ?

Une hypothèse veut que la musique fasse vibrer les mêmes cordes sensibles que la voix, outil essentiel à la communication humaine. Toutes deux seraient traitées par les mêmes circuits neuronaux. La musique serait en fait une "voix superexpressive", c'est-à-dire une amplification de l'expression vocale comme le sont les masques pour les visages.

Il en est encore plus convaincu depuis une étude effectuée en imagerie par résonance magnétique fonctionnelle (IRMf) chez 50 participants qui lui a permis de découvrir un chevauchement entre la région du cerveau activée par la musique et celle qui est vouée aux expressions vocales. "Les sujets ont écouté des extraits musicaux, diverses langues, des bruits de klaxon et de claquements de porte, des cris, des pleurs, etc., raconte-t-il. Au terme de l'exercice, on a aussi remarqué que la musique animait un endroit précis du cerveau situé bilatéralement sur le planum temporal. Cette zone est légèrement devant celle consacrée à la voix. C'est la première fois qu'on repère de la sorte une région musicale dans le cerveau."

Il ne faudrait pas oublier cependant la danse, le rythme du corps pas seulement le ton de la voix.

Santé

génétique, traitements, nutrition, hygiène

- Un poisson rendu transparent pour tester des médicaments anti-cholestérol

- Un spray qui rend les cellules cancéreuses fluorescentes

Un groupe dirigé par le National Cancer Institute Hisataka Kobayashi a développé un spray fluorescent qui peut marquer les cellules du cancer du sein en quelques minutes.

La fluorescence est activée par une enzyme appelée y-glutamyl transpeptidase qui est abondante dans les cellules tumorales, mais pas dans les cellules normales. La sonde qui Kobayashi et son équipe ont conçu une cible contient chimiques de l'enzyme tumorale. Cette enzyme clive le produit chimique du spray, ce qui active le signal de fluorescence.

- Des nano-aimants pour nettoyer le sang

Des nanoparticules aimantées recouvertes de carbone et d'anticorps injectées dans le sang puis filtrées avec une machine à dialyse permettraient de purger le sang de molécules inflammatoires par exemple.

Des nanoparticules aimantées recouvertes de carbone et d'anticorps injectées dans le sang puis filtrées avec une machine à dialyse permettraient de purger le sang de molécules inflammatoires par exemple.

- Une protéine contre les radiations

La bactericidal-permeability-increasing protein (BPI) combiné avec un antibiotique, la fluoroquinolone, augmente la durée de vie des souris irradiés de 10 jours.

Voir aussi Futura-Sciences.

- Des automates pour synthétiser les recherches sur le cancer

- Les tests sanguins de cancers pas assez sensibles

Les protéines peuvent mettre des dizaines d'années à être détectées en quantité suffisante, une fois que la tumeur a grossi dangereusement.

- Des anti-biotiques contre la sclérose en plaque

On a vu que les antibiotiques, tuant toutes les bactéries dans les intestins, permettaient aux souris de ne pas avoir la sclérose en plaques. On a ensuite réintroduit les bactéries progressivement et les symptômes ont repris. Les chercheurs essaient d'identifier la bactérie fautive.

- La toxoplasmose augmente la production de dopamine

Le parasite motive la production et l'émission de dopamine à des niveaux bien supérieurs à la normale. La dopamine a un impact sur la cognition, le mouvement et le comportement. Elle a un impact sur les centres de récompenses et de plaisir du cerveau ... et régule la peur. L'encodage provoqué par le parasite intervient sur le génome lui-même. Les humains sont des hôtes intermédiaires. Le parasite peut s'installer un peu n'importe où dans le cerveau : les symptômes dépendent donc directement de cela.

En réduisant la peur des souris et des rats qu'il infecte le parasite les rend moins peureux et donc plus facilement susceptibles d'être mangés par les chats qui sont la cible finale du parasite. Cette effet dopaminergique se retrouve donc chez les humains infectés.

- Les boissons énergisantes caféinées excitent et dépriment

La consommation excessive de boissons énergisantes pourrait jouer un rôle dans le déclenchement des phases maniaques ou dépressives chez des patients souffrant d'un trouble bipolaire et de problèmes de toxicomanie.

Jusqu'à tout récemment, une seule canette de boisson énergisante pouvait contenir l'équivalent de cinq tasses de café. Au mois d'octobre, Santé Canada a imposé aux fabricants une limite de 180 mg de caféine par canette, soit environ un café moyen. "On sait qu'une intoxication à la caféine survient lorsqu'on en boit 250 mg et plus".

Les cas relatés dépassaient largement cette dose. Dans les semaines précédant leur hospitalisation, M. A buvait jusqu'à six petites canettes par jour, Mme B en consommait un maximum de huit et M. C en avalait neuf au plus.

Par ailleurs, le café étant une des plus grandes consommations humaines, les traces de caféine dans l'eau sont un bon indicateur de pollution par les rejets humains.

- La dépression de la mère affecte le développement du foetus

- Thé vert et laser rouge contre Alzheimer

- Le neurofeedback contre le Parkinson

Penser aux mouvements du corps améliorerait les symptômes du Parkinson ans 37% des cas.

- Cephaly, la stimulation du cerveau contre la migraine

Le Cefaly, de la taille d'une paire de lunettes, est le premier appareil de neurostimulation externe. Il contient une électrode placée à hauteur du front de manière à agir sur le système nerveux. "Le Cefaly modifie ainsi le seuil de déclenchement des migraines", précise le Docteur Rigaux. "Six utilisateurs sur dix sont satisfaits du traitement".

- Un implant cérébral ultrafin

Plus fin et flexible avec une résolution 50 fois supérieure aux implants précédents, il devrait améliorer aussi l'étude du cerveau.

Plus fin et flexible avec une résolution 50 fois supérieure aux implants précédents, il devrait améliorer aussi l'étude du cerveau.

- Le striatum moins connecté chez les personnes âgées

Le striatum sert normalement aux réponse rapides.

- Une hypophyse créée à partir de cellules souches

Première étape vers la constitution d'organes destinés à être transplantés.

- La transplantation de neurones contre l'obésité

Une nouvelle étude révèle que la greffe de neurones immatures permet de réparer des circuits neuronaux du cerveau et de traiter l’obésité chez des souris présentant un désordre génétique et métabolique.

- Plus on est gros et plus on a besoin de vitamine D

- Le BPA dans les boîtes de conserve

D'après une étude américaine, le bisphénol A serait également présent dans les produits conditionnés en conserve, en migrant sur les aliments sans même être chauffé. Après une expérience de quelques jours, durant lesquels des volontaires ont mangé des soupes en boîte, leur taux de BPA a augmenté de 1.000 % !

Depuis le temps qu'on le disait, et c'est même pire que ce qu'on pouvait croire ! L'étonnant, c'est qu'il faille tant de temps pour faire des études pourtant si simples... Non seulement le BPA stimule l'aromatase transformant la testostérone en oestrogènes, mais sa combinaison avec d'autres perturbateurs endocriniens comme le triclocarban (un antibactérien) aurait de effets imprévisibles...

- Un foie provisoire, par injection de cellules hépatiques, a guéri un bébé

Des cellules hépatiques ont été injectées dans l'abdomen d'un nourrisson, permettant de remplir le rôle du foie pendant que celui-ci était soigné. Un espoir pour les malades du foie, dont la guérison dépend des dons d'organes.

Pour y arriver, les chercheurs placent des fibroblastes - des cellules qui proviennent d'un échantillon de peau - dans un milieu de culture. Ces cellules produisent elles-mêmes la matrice extracellulaire qui assure leur soutien et leur organisation tridimensionnelle. En superposant trois feuillets de tissus ainsi produits, les chercheurs obtiennent une couche de base sur laquelle ils cultivent des cellules urothéliales, les cellules qui tapissent l'intérieur de la vessie. "Placées dans de bonnes conditions de croissance, les cellules se multiplient et s'organisent par elles-mêmes, explique Stéphane Bolduc. C'est ce qui fait l'intérêt de l'approche d'autoassemblage développée au LOEX."

Le modèle de vessie ainsi produit possède une structure semblable à celle de la vessie humaine; sa résistance mécanique est bonne, mais son imperméabilité n'est pas parfaite, un problème important compte tenu de la toxicité de l'urine. Dans l'espoir de corriger ce problème, les chercheurs ont eu l'idée d'ajouter une phase dynamique à leur protocole: vers la fin de la période de développement, la vessie est placée dans un bioréacteur permettant de simuler des cycles de remplissage et de vidange naturels de quatre heures par l'application d'une pression mécanique. Cette approche "physiologique" a permis une différenciation plus poussée des cellules urothéliales. "On observe la formation de cellules spécialisées, appelées cellules parapluie, qui imperméabilisent la paroi. En plus, les propriétés mécaniques de cette vessie équivalent à celles d'une vraie vessie", résume le professeur Bolduc.

- Premier pas vers la lentille de contact numérique

Dans une étude publiée par le Journal of Micromechanics and Microengineering, une équipe présente la première lentille de contact informatisée capable d’afficher une information à la demande. À l'heure actuelle, le dispositif ne contient qu'un seul pixel mais les chercheurs voient cela comme une «preuve de concept » ouvrant la voie à la production de lentilles avec plusieurs centaines de pixels qui pourront alors afficher des courriels ou des messages courts juste devant les yeux.

La lentille de contact, créée par des chercheurs de l'Université de Washington (Etats-Unis) et l'Université Aalto (Finlande), se compose d'une antenne permettant de recevoir des signaux envoyés par une source externe ainsi que d'un circuit intégré permettant de stocker de l’énergie et de la transférer à une puce transparente contenant une seule LED bleue.

Voir aussi Futura-Sciences.

Le chercheur et ses collaborateurs ont développé un système qui analyse et localise dans l'image des objets visuels. Par la suite, ils sont transformés en stimulations auditives stéréophoniques en tenant compte des spécificités de l'audition pour permettre à l'ouïe de repérer les objets dans l'espace.

Pour y parvenir, les chercheurs ont utilisé un modèle de localisation spatiale basé sur les différences interaurales d'amplitude (IAD) pour les hautes fréquences (résultat des écarts de niveau sonore dans les hautes fréquences aux deux oreilles) et les différences interaurales de temps (ITD) pour les basses fréquences (différence dans le temps de captation d'un son par les deux oreilles) qui ont permis d'encoder la position des objets dans l'image.

On avait déjà parlé de voir avec la langue ou d'aveugles faisant du vélo en émettant des "clics" mais cette fois, c'est un système non invasif de transformation de la vision en sons.

Notons que, normalement, la synesthésie résulterait d'une hyperactivité neuronale mais cette capacité présente chez les chimpanzés pourrait avoir eu un rôle dans le langage ou plutôt le proto-langage phonétique (opposé au langage narratif et à sa double articulation). Voir aussi Futura-Sciences.

Technologie

biotechnologies, nanotechnologies, énergie, informatique, robotique

- Souple comme le caoutchouc et façonnable comme le verre

L’équipe de Ludwik Leibler publie dans la revue Science la recette de ce nouveau matériau organique, conçu à partir d’acides gras, de résine époxy et d’un catalyseur. L’objectif des chercheurs étaient de reproduire les excellentes propriétés mécaniques des matériaux composites, ces polymères thermodurcissables, comme la bakélite ou les résines époxy, sans avoir leurs inconvénients.

Leibler et ses collègues ont réussi à concevoir un polymère qui peut être façonné à volonté. Mieux, il présente, comme le verre chauffé, ce passage progressif à l’état solide qui permet de le façonner sans moulage (ce qui n’est pas non possible avec les polymères thermoplastiques). Des matériaux aussi résistants que les résines époxy mais recyclables à l’infini pourraient donc être conçus, affirment les chimistes. Leur nouveau polymère peut être souple (tout en conservant la mémoire d’une forme) ou rigide sans être cassant comme le verre. On peut pratiquer des soudures, des réparations…. des qualités très intéressantes pour faciliter la réparation des carrosseries de voitures fabriquées en matériaux composites.

Voir aussi Futura-Sciences et Techno-Sciences.

- Le matériau solide le plus léger

En construisant un réseau métallique à l’échelle nanométrique, des chercheurs ont réalisé une sorte de nouveau matériau dont l’essentiel du volume est formé d’air. Résultat : une grande résistance, une forte élasticité et une densité de 0,9 mg/cm3, des dizaines de fois plus faible que celle du polystyrène extrudé.

Voir aussi Gizmodo.

- Des nanotubes pour absorber 99,5% de la lumière

Il s’agit en fait d’un revêtement réalisé en nanotubes de carbone capable d’absorber 99.5% des rayons lumineux qui la touchent alors que la peinture noire n’en absorbe « que » 90%. Ces nanotubes sont 10 000 fois plus fins qu’un cheveu humain. Ce revêtement absorbe même 98% des rayons UV (faibles longueurs d’onde) et des infrarouges (longueurs d’ondes élevées).

Cela permettrait de rendre un avion ou un char invisible la nuit.