- Les dangers des nanomatériaux

- L'homme de Néandertal

- Trous noirs ou étoiles noires ?

- Energies renouvelables

- De l'électricité à partir de la chaleur et de la résonance

- Reconstitution d'un film à partir de l'activité du cerveau

<- Revue des sciences précédente | Revue des sciences suivante ->

Revues : Pour la Science - La Recherche

Brèves : Physique - Climat - Biologie - Santé - Technologie

La polémique sur les mails du GIEC manifeste la difficulté d'une démocratie cognitive dont l'action climatique relève, la recherche de la vérité n'étant jamais pure ni facile. Le facteur humain est le maillon faible alors qu'avec le progrès des énergies renouvelables on aurait les moyens d'éviter une catastrophe, certes pas complètement certaine, c'est tout le problème ! Le temps d'adaptation pourrait pourtant être bien plus court que prévu de même que le prix de l'énergie ne devrait pas augmenter tellement, ce qui serait une bonne surprise. En tout cas, la science oblige en permanence à rectifier nos croyances, notamment, ce mois-ci, sur Néandertal plus proche de nous qu'on ne le disait il y a peu encore, mais ce sont les trous noirs qui sont remis en cause aussi par la gravitation semi-quantique qui leur substitue des "étoiles noires" beaucoup moins paradoxales. Sinon, les nanoparticules pourraient être plus dangereuses qu'on ne croyait, du moins si elles devaient s'accumuler très au-delà des seuils actuels, ce qu'il faudrait éviter à tout prix. Le LHC redémarre mais devrait normalement s'arrêter pendant l'hiver ? C'était en tout cas son contrat de ne pas ponctionner la puissance électrique pendant les grands froids. De toutes façons, il ne faut pas attendre des résultats avant le printemps au moins. Il est par contre complètement bluffant qu'on puisse arriver à reconstituer les images d'un film qu'on regarde en analysant notre cerveau ! Je dois dire, enfin, que j'ai hâte qu'on puisse faire des conférences 3D à distance tellement je trouve absurde de traverser toute la France pour parler 20mn !

Pour la Science no 386, Les Néandertaliens

- Les quartiers durables en Europe, p18

- Les quartiers durables en Europe, p18

L'expérience de Stockholm a montré que les changements de modes de vie ont plus d'impacts écologiques que les économies dues aux dispositifs techniques.

Ainsi, l'urbanisme durable se construit dans un champ de tensions entre réponses politiques (mieux partager les ressources de la terre), culturelles (changer de modes de vie), et techniques (utiliser des ressources moins polluantes). Ces trois registres d'action sont déséquilibrés, car l'économie favorise avant tout l'innovation technique et beaucoup moins l'innovation sociale.

- Peut-on se faire des cheveux blancs en une nuit ?, p20

Le blanchissement du cheveu est progressif. Mais alors, comment une chevelure peut-elle blanchir en une nuit ? Ce syndrome, nommé « canitie subite », est aujourd'hui interprété comme une réaction auto-immune : le système immunitaire de l'organisme semble faire une réaction de rejet brutal du système pigmentaire des follicules pileux. Si cette attaque se produit sur une chevelure poivre et sel, contenant à la fois des cheveux pigmentés et d'autres déjà blancs, seuls les pigmentés seront « rejetés », et donc perdus, tandis que les cheveux blancs seront épargnés. Le blanchissement « en une nuit » résulterait d'un rejet sélectif des cheveux pigmentés.

- Les nanomatériaux : quels risques pour l'environnement et la santé ?, p24

Lorsque leur taille est inférieure à 20 nanomètres, de nombreuses nanoparticules présentent des capacités accrues de synthétiser, à leur surface, des radicaux libres, espèces chimiques oxydantes très réactives. Ces radicaux libres provoquent un stress oxydatif et endommagent les membranes cellulaires et les chromosomes.

Les nanotubes de carbone, matériaux formés par l'enroulement de feuillets de graphite, seraient également néfastes pour des truites et des amphibiens (Xenopus laevis), car elles bloqueraient l'activité respiratoire et la digestion. Ainsi, aujourd'hui, une majorité de recherches montrent que les nanoparticules ont des effets cytotoxiques sur les organismes vivants étudiés, mais seulement lorsque les concentrations des nanoparticules dans le milieu dépassent celles que l'on atteindrait vraisemblablement dans les écosystèmes.

Dans le domaine de la santé, les interrogations sur le danger potentiel des nanomatériaux viennent du fait que les nanoparticules se rapprochent, par leurs dimensions, des particules atmosphériques ultrafines, des particules de diamètre inférieur à 0,1 micromètre émises par la combustion des énergies fossiles (automobiles, chauffage, activités industrielles). On sait qu'elles provoquent des pathologies respiratoires et cardio-vasculaires et plusieurs dizaines de milliers de décès chaque année dans le monde. Les nanotubes de carbone ont été aussi rapprochés de l'amiante, cause avérée de plusieurs dizaines de milliers de cancers de la plèvre.

En revanche, les résultats obtenus jusqu'à présent suggèrent que les nanoparticules ne franchissent pas la barrière hémato-encéphalique, vers le cerveau, ni la barrière placentaire, surface d'échange entre la mère et le fœtus. Toutefois, les nanoparticules pourraient pénétrer dans le cerveau par le système olfactif. D'après des expériences réalisées en 1970 chez le singe, des nanoparticules d'or instillées dans les fosses nasales peuvent être transportées par les neurones vers le bulbe olfactif, situé à courte distance du tissu nasopharyngé. Dès lors, la question d'un tel transfert se pose pour les nanoparticules industrielles.

Il est avéré que les particules ultrafines déclenchent, dans les organes où elles s'accumulent, une réponse inflammatoire résultant de la production de radicaux libres. L'inflammation, mécanisme physiologique normal de défense à une agression (microbienne, physique, chimique), peut entraîner diverses pathologies quand elle n'est plus contrôlée : bronchite chronique, fibrose, voire cancer du poumon, maladies cardio-vasculaires, neurodégénérescences.

Voir aussi Effet indirect des nanoparticules sur l'ADN.

- Le crépuscule de l'homme de Néandertal, p 28

Plus que le froid, ces changements incessants de leur environnement ont pu pousser les populations néandertaliennes au-delà du point de non-retour.

Certains parvenaient à s'adapter à ces bouleversements, ce qu'indique l'évolution des outils et des proies ; d'autres succombaient, de sorte que la population néandertalienne globale se fragmentait de plus en plus.

Les travaux publiés en avril dernier par Virginie Fabre et ses collègues, de l'Université de la Méditerranée à Marseille, confortent cette idée. Leur analyse comparative de l'adn mitochondrial des Néandertaliens suggère que la taille de la population néandertalienne oscillait, et que cette population était probablement divisée en au moins trois sous-groupes pendant l'ois-3, l'un dans l'Ouest européen, l'autre dans le Sud, et le troisième en Asie occidentale.

L'homme moderne n'aurait pas exterminé directement l'homme de Neandertal, mais serait entré en compétition avec lui pour les mêmes ressources puisqu'il vivait dans le même milieu. Dans cette concurrence, les Néandertaliens auraient peu à peu perdu du terrain.

Toutefois, la nature exacte de l'avantage compétitif qu'aurait eu l'homme moderne est très débattue. L'une des possibilités serait que l'alimentation des hommes modernes ait été plus diversifiée.

En septembre 2008, Ch. Stringer et ses collègues ont publié des indices montrant que les Néandertaliens des grottes voisines de Gorham et de Vangard chassaient le dauphin et le phoque et qu'ils ramassaient des coquillages. Dans une autre étude en voie de publication, ces chercheurs montrent qu'ils mangeaient aussi des oiseaux et des lapins. Ces découvertes et d'autres, similaires, sur plusieurs autres sites, mettent fin à l'idée reçue suivant laquelle seuls les hommes modernes étaient capables d'exploiter ressources marines.

Longtemps, on a aussi affirmé que l'homme de Neandertal n'avait pas de langage articulé. Cela semble plus qu'improbable aujourd'hui. Tout d'abord, dès 1983, un os hyoïde néandertalien très semblable à celui de l'homme moderne a été découvert à Kébara, en Israël. L'os hyoïde, rappelons-le, est un petit os qui maintient la base de la langue, ce qui le rend indispensable à l'élocution. Plus récemment, en 2007, l'équipe de Johannes Krause, de l'Institut Max Planck d'anthropologie évolutionniste à Leipzig, a montré que ces hominidés portaient la même version du gène foxp2 que les hommes modernes. Or ce gène est associé à l'apparition du langage. Ces indices de l'existence d'un langage articulé néandertalien sont doublés par d'autres qui prouvent que les Néandertaliens pratiquaient des langages symboliques. Ainsi, on sait que certains décoraient leur corps de bijoux et à l'aide de pigments. Pareil comportement implique l'usage de symboles compris par les autres. C'est pourquoi ils sont considérés comme des marqueurs de l'existence d'un langage.

Aujourd'hui, les chercheurs admettent que, pour l‘essentiel, les Néandertaliens et les hommes modernes se comportaient à l'identique. Ils se mettent donc à rechercher l'origine de la disparition des Néandertaliens dans des différences culturelles et biologiques de plus en plus subtiles.

Les aiguilles que les hommes modernes ont laissées derrière eux suggèrent par exemple qu'ils disposaient de meilleurs vêtements et de tentes efficaces pour résister au froid. Les Néandertaliens n'ont pas laissé d'indices qu'ils savaient coudre, de sorte que leurs habits et abris auraient été plus sommaires.

Steven Kuhn et Mary Stiner, de l'Université d'Arizona, ont émis l'hypothèse que l'alimentation variée des premiers Européens modernes aurait favorisé une division du travail dans laquelle les hommes chassaient le gros gibier, tandis que les femmes cueillaient et préparaient les fruits à coque, les graines et les baies. Amateurs de gros gibier, les Néandertaliens auraient au contraire mobilisé pendant la chasse l'ensemble du groupe, donc les femmes et les enfants aussi, pour rabattre les animaux vers les chasseurs aux aguets. En créant à la fois un approvisionnement en nourriture plus fiable et un environnement plus sûr pour élever des enfants, la division du travail aurait permis aux hommes modernes de se multiplier aux dépens des Néandertaliens.

Plusieurs études visant à estimer le taux métabolique de l'homme de Néandertal ont conclu que ces hominidés archaïques avaient besoin de plus de calories quotidiennes que leurs rivaux.

Une autre différence entre les Néandertaliens et les hommes modernes mérite d'être mentionnée. Les recherches menées par Rachel Caspari, de l'Université du Michigan, ont montré que vers 30 000 ans avant le présent, le nombre d'hommes modernes vivant assez longtemps pour devenir grands-parents est monté en flèche. La nature exacte de ce qui a provoqué cette augmentation de la longévité n'est pas claire, mais ce changement a eu deux conséquences importantes : il a augmenté le nombre d'années disponibles pour la reproduction, et donc la fertilité ; ensuite, il a permis aux individus d'accumuler plus de connaissances utiles à la survie.

Il est clair que la façon dont le climat, la concurrence avec les hommes modernes ou les différences physiologiques ont contribué au déclin de l'homme de Neandertal a varié d'un groupe à l'autre et d'une époque à l'autre. Certains groupes ont pu disparaître par maladie, d'autres par croisement. « Chaque vallée raconte probablement sa propre histoire », souligne C. Finlayson.

Quant aux derniers Néandertaliens connus, ceux qui, il y a 28 000 ans, vivaient dans les grottes littorales de Gibraltar, ils n'étaient pas en concurrence avec les hommes modernes, qui ne sont arrivés dans la région que plusieurs milliers d'années après leur disparition.

- Les messages cachés dans les gènes de Neandertal, p34

L'étude des gènes des Néandertaliens a livré quatre informations : l'homme de Neandertal était distant génétiquement de nos ancêtres ; sa lignée est ancienne ; il n'a pas contribué à notre patrimoine génétique ; peu nombreux, ils ont occupé un vaste territoire.

D'après leur adn mitochondrial, les hommes de Neandertal se ressemblaient beaucoup, mais étaient très différents de l'homme moderne, tout en étant bien plus proches de ce dernier que du chimpanzé.

Selon l'horloge génétique mitochondriale, Homo sapiens et Homo neanderthalensis auraient divergé il y a plus de 400 000 ans.

Depuis 2007, les séquences codantes de seulement quatre gènes nucléaires bien identifiés ont été obtenues. Le premier est le gène foxp2, impliqué chez l'homme moderne dans la parole et le langage. Chez les Néandertaliens, ce gène code une protéine identique à celle existant chez l'homme moderne.

Par ailleurs, grâce aux séquences d'adn mitochondrial, on estime que le plus récent ancêtre commun de tous les Néandertaliens a vécu il y a quelque 250 000 ans. L'évolution des Néandertaliens s'est donc déroulée sur une très longue période. Elle peut être retracée par l'identification de caractères néandertaliens typiques déjà présents sur le crâne de l'ancêtre des Néandertaliens Homo heidelbergensis (450 000 ans), puis par leur accumulation progressive au cours du temps sur celui d'Homo neanderthalensis. L'évolution de cette population a donc été progressive et, à son « âge d'or » (vers 120 000 ans), elle est très différente de ses ancêtres et de l'homme moderne.

Comme l'adn mitochondrial ne se transmet que par les femmes, son absence totale dans les cellules humaines actuelles ne peut s'expliquer que de deux façons : par le fait qu'aucune femme néandertalienne n'a eu d'enfants d'hommes modernes, ou que les gènes de ceux qu'elles ont eus ne nous sont pas parvenus.

Dans ce cas, l'explication la plus simple est que ces éventuels enfants métissés n'ont pas eu de descendance. Une autre possibilité serait que leurs gènes et ceux d'éventuels enfants que des Néandertaliens auraient eus avec des femmes anatomiquement modernes ont disparu. Plusieurs mécanismes génétiques pourraient l'expliquer : il y a d'abord la dérive génétique, c'est-à-dire la diminution due au hasard de la fréquence de certains gènes, qui a pour effet de raréfier ces gènes dans une population isolée ; ensuite, l'apport incessant d'adn moderne dû à un afflux continu d'hommes modernes en Europe a pu « diluer » les gènes néandertaliens. Dès lors, plusieurs paléoanthropologues ont proposé une faible contribution des Néandertaliens au réservoir génétique moderne, qui aurait été effacée avec le temps.

Le faible ensoleillement de l'Europe aurait porté à la sélection chez les Néandertaliens et dans la lignée humaine des mutations distinctes, mais ayant les mêmes effets : une peau claire et des cheveux roux.

- Les trous noirs détrônés par les étoiles noires, p60

Personne n'a encore vu un trou noir, et pour cause, ce qui doit inciter à ne pas prendre leur théorie pour argent comptant. Il y a certes des objets supermassifs qui piègent la lumière mais il n'est pas raisonnable de penser qu'il y aurait un effondrement jusqu'à une "singularité" qui n'a aucun sens physique. C'est ce que devrait éliminer une gravité quantique donnant une limite à cet effondrement mais, du coup, ce ne serait plus un "trou" noir mais plutôt une étoile noire. Cet article reste encore très hypothétique mais il a l'intérêt d'ouvrir la piste des effets quantiques sur la gravitation et des alternatives aux trous noirs, comme les singularités nues qu'on avait vues au mois de Mai.

Selon certains théoriciens, des effets quantiques peuvent ralentir et stopper l'effondrement gravitationnel d'un astre massif. En lieu et place d'un trou noir se formerait alors un objet ultracompact qualifié d'étoile noire.

De très nombreuses observations astrophysiques indiquent qu'il existe effectivement dans l'Univers des objets extrêmement denses qui n'émettent aucun rayonnement propre. Bien que la masse de ces objets varie de quelques masses solaires à plusieurs dizaines de millions, leur diamètre va de quelques kilomètres seulement à quelques millions de kilomètres respectivement, une taille en accord avec les prédictions de la relativité générale pour des trous noirs de telles masses.

Pour autant, ces objets sombres et compacts sont-ils vraiment les trous noirs prédits par la théorie de la relativité générale ? Les observations concordent certes très bien avec la théorie, mais la théorie elle-même n'est pas entièrement satisfaisante. En particulier, l'existence d'une singularité au centre des trous noirs est en soi un échec de la relativité à décrire ce lieu, comme c'est le cas dès qu'une théorie physique accouche d'une quantité infinie. La relativité générale est sans doute mise en défaut parce qu'elle ne prend pas en compte les effets quantiques à l'échelle microscopique.

Nous proposons dans cet article l'un de ces scénarios, où des effets liés à l'énergie du vide quantique pourraient empêcher la formation d'un horizon, et donc d'un trou noir, lors de l'effondrement gravitationnel d'une étoile. À la place, un objet que nous avons nommé étoile noire pourrait voir le jour.

Vue de l'extérieur, une étoile noire ressemblerait beaucoup à un trou noir, à la différence qu'elle ne serait pas dissimulée derrière un horizon des événements, ce qui supprimerait bien des aspects paradoxaux des trous noirs.

La théorie quantique des champs considère chaque type de particule fondamentale (électrons, photons, quarks, etc.) comme un champ qui remplit l'espace, à la manière du champ électromagnétique. Les équations de la théorie quantique des champs sont généralement établies dans un espace-temps sans courbure, c'est-à-dire en l'absence de gravité. La gravitation semi-classique formule au contraire la théorie quantique des champs dans un espace courbe. En termes généraux, l'idée de la gravitation semi-classique est de combiner l'influence des champs quantiques à celle de la matière sur la courbure de l'espace-temps.

Cependant, cette approche se trouve immédiatement confrontée à un problème de taille : le calcul direct de l'énergie du vide des champs quantiques (l'énergie minimale, lorsque l'espace est vide de toute particule, encore appelée énergie au « point zéro ») donne un résultat infini.

En fait, ce problème se manifeste aussi en théorie quantique des champs ordinaire (c'est-à-dire dans un espace sans courbure). Heureusement, en l'absence de gravité, seules les différences d'énergies entre les états des particules importent, et la valeur de 'énergie du vide ne joue aucun rôle. Des techniques dites de renormalisation règlent le problème des infinis.

Mais lorsque la gravité entre en scène, on ne peut plus négliger l'énergie du vide.

La gravité semi-classique n'essaie pas de répondre à cette question. On se contente de supposer que, quelle que soit la réponse, la contribution de l'énergie du vide à la densité d'énergie dans un espace-temps plat est exactement compensée de façon à être nulle. Cette hypothèse donne un vide semi-classique autocohérent : la densité d'énergie du vide vaut zéro partout, auquel cas la relativité générale prédit un espace-temps plat.

Les calculs habituels induisent un effondrement très rapide, de l'ordre du temps de chute libre du matériau de la surface de l'étoile jusqu'à son centre. Nous avons découvert que si on suppose un effondrement plus lent – où les particules formant l'étoile, plutôt que de tomber en chute libre, seraient fortement déviées –, les effets quantiques peuvent conduire à la création d'un nouveau type d'objet ultracompact dépourvu d'horizon des événements.

Mais nous savons qu'en réalité, les grands nuages de matière quasi homogènes qui ont émergé du Big Bang ne se sont pas effondrés en chute libre pour former des trous noirs : ils se sont effondrés en structures successives de plus en plus compactes.

Ainsi, grâce aux lois de la mécanique quantique, la matière semble toujours trouver de nouveaux moyens pour retarder l'effondrement gravitationnel. Bien que chacune des configurations stables puisse toujours être rendue instable en ajoutant suffisamment de matière, chaque processus qui retarde l'effondrement offre du temps pour que le tenseur énergie-impulsion renormalisé du vide quantique devienne significatif. Celui-ci pourrait prendre le relais de la matière pour contrebalancer l'attraction gravitationnelle, et du fait que sa force répulsive peut augmenter sans limite, il pourrait mettre un terme définitif à l'effondrement de la matière en un trou noir.

Étant donné qu'elle n'a pas d'horizon, une étoile noire ne peut pas piéger de l'information. Au lieu de cela, les particules émises et tout ce qui reste de matière dans l'étoile noire portent toute l'information initiale. La théorie quantique actuelle suffirait à décrire le processus de formation et d'évaporation de ces objets.

- Energies renouvelables, p68

C'est le plan B de Lester R. Brown qui semble devoir se réaliser...

D'ici 20 ans, en combinant les énergies éolienne, hydraulique et solaire, on pourrait remplacer les énergies fossiles qui s'épuisent et produisent des gaz à effet de serre. On couvrirait ainsi la totalité des besoins énergétiques de la planète.

Les meilleures solutions sont les énergies éolienne, solaire, géothermique, marine et hydraulique. L'énergie nucléaire, le charbon avec recapture et stockage du dioxyde de carbone émis, et l'éthanol apparaissaient comme des solutions moins intéressantes, de même que le pétrole et le gaz naturel.

L'énergie nucléaire produit 25 pour cent de gaz à effet de serre de plus que l'énergie éolienne, si l'on tient compte de la construction des réacteurs, de l'enrichissement et du transport de l'uranium.

Notre plan prévoit des millions de turbines actionnées par le vent et par l'eau et des dizaines de milliers d'installations solaires. Bien que ces nombres paraissent gigantesques, ils ne sont pas hors d'atteinte.

Aujourd'hui, la puissance électrique maximale consommée dans le monde à n'importe quel moment (puissance instantanée) est d'environ 12,5 milliards de kilowatts (12,5 térawatts).

Même si la demande croissait jusqu'à 16,9 térawatts, les sources eau-vent-soleil fourniraient bien plus d'énergie. Les études que nous avons réalisées et celles d'autres chercheurs indiquent que l'énergie potentielle du vent, à l'échelle mondiale, représente à elle seule 1 700 térawatts, et l'énergie solaire 6 500 térawatts.

À l'évidence, il existe suffisamment d'énergies renouvelables disponibles pour couvrir les besoins de la planète. Mais comment fournir les 11,5 térawatts dont le monde aura besoin en 2030 ? Notre scénario propose d'allier les techniques, en insistant sur l'éolien et le solaire et en supposant que neuf pour cent de la demande pourraient être couverts par l'eau. Le vent apporterait 51 pour cent de la demande, au moyen de 3,8 millions d'éoliennes de cinq mégawatts chacune. Bien que ce nombre puisse paraître considérable, il faut rappeler que l'industrie automobile fabrique 73 millions de véhicules chaque année. L'énergie photovoltaïque et les centrales solaires fourniraient 40 pour cent des besoins mondiaux : 30 pour cent du photovoltaïque proviendraient de panneaux solaires installés sur les toits des maisons, des immeubles et des locaux d'entreprises. Quelque 89 000 unités solaires de 300 mégawatts en moyenne chacune seraient également nécessaires. À cela s'ajoutent 900 stations hydroélectriques, dont 70 pour cent sont déjà en place.

Le prix de la construction globale d'un système eau-vent-soleil serait de l'ordre de 70 000 milliards d'euros sur 20 ans.

Sur le même sujet, voir plus bas, La Recherche.

- Libre arbitre et mécanique quantique, p96

Il y a un délire mathématique qui va bien au-delà des modèles financiers. Ici, c'est la réfutation d'une possible fonction de tout l'univers, réfutation déjà initiée par les théories du Chaos (voir ci-après), qui prétend fonder un libre-arbitre absurde qui n'a rien à voir avec notre liberté qui dépend de notre savoir et de notre ignorance. Le véritable intérêt de l'article est de montrer que l'indétermination quantique ne tient pas aux probabilités mais au contexte (c'est un peu la même chose que de passer de statistiques économiques à l'organisation sociale sous-jacente).

Selon J. Conway et S. Kochen, une entité dispose de libre arbitre à l'instant t si son état ne peut pas être décrit comme résultat de l'application d'une fonction, au sens mathématique, portant sur l'état de l'Univers avant l'instant t. Ce libre arbitre, qui n'a rien à voir avec les probabilités puisqu'il affirme juste la non-existence d'une certaine fonction, est un indéterminisme logique (ou si l'on veut préciser, fonctionnel).

Cet indéterminisme est l'impossibilité logique qu'il existe certaines fonctions reliant les états de l'Univers, impossibilité qui signifie que d'instant en instant l'Univers n'est pas contraint par son passé, mais libre de son évolution.

L'utilisation du concept de libre arbitre peut choquer, mais nous verrons qu'en prenant le terme libre arbitre dans le sens donné par J. Conway et S. Kochen, l'expression est bien choisie : elle force à repenser l'indéterminisme de la mécanique quantique sans l'associer à des probabilités, ce qui en éclaircit le sens et la portée.

Le type de liberté des particules jumelles, et plus généralement l'intrication quantique, montrent que quelque chose de très différent de l'aléatoire classique des probabilités joue ici. (...) Dans l'état actuel des connaissances, il est certainement au-delà de nos capacités de compréhension d'établir un lien entre les décisions libres des particules et celles des humains, mais l'aléatoire de la théorie de probabilités ne rend compte ni du libre arbitre des humains ni de celui des particules. »

L'indéterminisme de la mécanique quantique est bien plus subtil et profond que celui décrit par les probabilités et c'est ce que le théorème du libre arbitre montre de manière flagrante, changeant sans doute profondément les analyses qu'on fera à partir de maintenant de la mécanique quantique.

La Recherche no 436, Energies renouvelables

- Le monde quantique est soumis au chaos, p14

Voilà qui confirme l'impossibilité d'une équation de l'univers, même si cela n'a rien à voir avec le "libre-arbitre" comme le prétend J. Conway (voir plus haut). Le caractère non-linéaire des phénomènes chaotiques sensibles aux conditions initiales n'est guère compatible avec l'équation de Schrödinger qui est complètement linéaire et ne s'applique telle quelle qu'à des interactions simples sans doute, son caractère probabiliste pouvant découler justement de l'impossibilité de prendre en compte ses composantes chaotiques. Il semble bien pourtant qu'on supposait déjà un régime chaotique à l'échelle de Planck où les fluctuations du vide sont les plus importantes, inversement proportionnelles à la durée, la stabilité n'apparaissant qu'à l'échelle nanométrique. Dans cet article relativement anodin, c'est le spin d'atomes de césium qui entre dans un régime chaotique après leur collision, prouvant que le monde quantique connaît bien des phénomènes chaotiques non pris en charge par la fonction d'onde.

A noter aussi que lorsqu'un anneau métallique est inférieur au micromètre, un courant électrique s'y propage indéfiniment (ce qui pourrait déboucher sur d'autres types de supraconducteurs?).

- Les promesses des énergies renouvelables, p39

Il n’y a plus de doute, les énergies renouvelables sont enfin entrées dans l’ère industrielle. Mais elles ne répondront pas, à elles seules, à tous les problèmes.

Depuis 2005, le marché du photovoltaïque croît de façon exponentielle : de 40% à 50% chaque année. Et la puissance photovoltaïque installée dans le monde a plus que doublé en 2008 par rapport à l'année précédente, passant de 2,65 milliards à 5,8 milliards de watts-crête.

On nous promet que d'ici 6 ou 7 ans, les coûts de l'électricité photovoltaïque seront concurrentiels avec les énergies actuelles. La fin du pétrole n'est donc même pas le temps de l'énergie chère sauf une courte transition.

- L'énergie éolienne est-elle vraiment "verte" ?, p45

Le problème de l'éolien, c'est la variabilité de la production d'électricité et son stockage qui obligent la plupart du temps à se coupler avec des centrales utilisant des hydrocarbures mais l'interconnexion des réseaux au niveau européen réduirait largement cette variabilité, le stockage sur le réseau étant le plus écologique par rapports aux systèmes actuels (tant qu'on ne dispose pas des supercondensateurs annoncés pour bientôt).

La variabilité de la production d'électricité d'origine éolienne est donc bien moindre à l'échelle nationale, et encore plus faible au niveau européen. De plus, on peut actuellement prévoir cette production avec précision 24 heures à l'avance.

En fin de compte, la solution la plus prometteuse pour "verdir" les éoliennes reste l'adaptation des réseaux à une proportion importante de production électrique variable. De toute façon, elle sera nécessaire pour affronter l'accroissement de la part des énergies renouvelables dans la production électrique.

Dans l'interview d'après, Arthouros Zervos suggère de se servir à l'avenir des voitures électriques pour le stockage de l'électricité :

A terme, si un parc de plusieurs millions de voitures électrique voyait le jour, il pourrait être utilisé comme un moyen de stockage décentralisé par un réseau intelligent. C'est une perspective encore lointaine, mais qui mérite réflexion.

Voir aussi le développement des réseaux intelligents.

- Le monde va trop vite pour l'enfant autiste, p56

Article étonnant qui prétend que l'autisme serait dû à la perception d'une trop grande rapidité du monde pour le décoder, ce qui semble étrange étant donné la rapidité de calcul de certains autistes "Asperger" mais que plusieurs signes corroborent comme la focalisation sur les détails et la mémoire spatiale accrue.

Article étonnant qui prétend que l'autisme serait dû à la perception d'une trop grande rapidité du monde pour le décoder, ce qui semble étrange étant donné la rapidité de calcul de certains autistes "Asperger" mais que plusieurs signes corroborent comme la focalisation sur les détails et la mémoire spatiale accrue.

Un autiste a raconté qu'il lui était difficile de regarder les yeux de quelqu'un parce qu'ils n'étaient jamais immobiles.

Le changement perpétuel qu'il fallait affronter partout ne me donnait jamais le temps de me préparer (...) L'un des procédés qui me permettait de ralentir le monde consistait soit à cligner des yeux, soit encore à éteindre et à allumer alternativement la lumière rapidement...

En fait, un tel trouble du traitement du flux verbal et son amélioration par un ralentissement de la parole ont déjà été démontrés il y a 30 ans chez certains enfants dysphasiques et dyslexiques. or les troubles du langage des jeunes autistes présentent de nombreux points communs avec ceux de ces enfants.

Les personnes autistes intègreraient difficilement et de manière atypique ces informations dans leur propre corps. incapables d'accorder leur rythme à celui d'un environnement perpétuellement changeant, elles y répondraient souvent avec un temps de latence (...) Pour s'adapter à u monde dans lequel les changements sont trop rapides pour elle, la personne autiste aura logiquement tendance à vouloir le ralentir, voire l'arrêter, ou le fragmenter spatialement en de multiples détails plus faciles à percevoir et à intégrer.

A prendre avec précaution, ne serait-ce que parce qu'on regroupe sous la catégorie d'autisme des tableaux cliniques très différents.

Brèves et liens

Physique

cosmologie, astronomie, physique quantique

La lumière superfluide, selon la prédiction faite par Carusotto et Ciuti dès 2004, serait en mesure de traverser tous ces matériaux sans la moindre difficulté: les photons qui la composent auraient des interactions tellement fortes que la lumière elle-même commencerait à se comporter comme un vrai fluide. Un état similaire à celui d'autres "super" comme l'hélium superfluide, qui de liquide normal -comme l'eau- se transforme en un superfluide capable de s'écouler sans aucun frottement.

Une lumière capable de traverser un matériel, sans être altérée, peut apporter d'énormes bénéfices dans le développement des fibres optiques (qui ont valu à leur inventeur, Charles Kao, le prix Nobel de Physique 2009). Elle pourrait permettre non seulement le transport d'information, comme c'est déjà le cas, mais aussi son élaboration: d'énormes quantités de données pourraient être traitées par voie optique par des puces opto-électroniques, à une vitesse impossible à atteindre pour l'électronique actuelle. De nouvelles puces hyper rapides, mais aussi capables d'économiser beaucoup d'énergie par rapport à aujourd'hui.

- Epais de quelques atomes, un film de cuprate reste supraconducteur

Si une seule des couches est dopée avec du zinc, le phénomène de supraconductivité se manifeste toujours à l’interface, sauf que la température de transition de phase passe de 32 à 18 K. Pour les chercheurs, c’est la preuve qu’une seule couche monoatomique de cuprate est suffisante. Cela devrait aider les théoriciens travaillant sur la supraconductivité à haute température critique. En effet, il est plus facile de résoudre des équations quand elles décrivent un phénomène physique que l’on peut ramener à deux dimensions que lorsqu’il faut impérativement considérer le problème à trois dimensions.

Un autre sous-produit de ces expériences est qu’il devient probable que l’on puisse contrôler au moins en partie l’état supraconducteur d’un cuprate à l’aide de champs électriques. On pourrait donc imaginer dans l’avenir l’existence de composants supraconducteurs modulables aux applications imprévues.

- L'ordinateur quantique hybride

Il y a encore quelques années, l'ordinateur quantique me semblait impossible, comme à la plupart des physiciens, au-delà de la manipulation de quelques qubits, avec de nombreux arguments. Cependant, en combinant des approches différentes pour le stockage et les calculs, le passage à la vitesse supérieure semble désormais à portée de main dès lors qu'on peut convertir leurs états les uns dans les autres.

- Explosion d’un astéroïde en Indonésie

L’explosion d’un astéroïde d’une dizaine de mètres au-dessus de l’Indonésie est là pour nous rappeler que les si les gouvernements des pays riches n’investissent pas plus dans la surveillance du ciel et le recensement de ces objets, la Terre risque d’être frappée par surprise avec toutes les conséquences que cela peut avoir pour l’homme et son écosystème.

Cette explosion est survenue le 8 octobre dans la haute atmosphère à une altitude de 15 à 20 kilomètres. Elle n’a provoqué aucun dégât au sol malgré une puissance équivalente à 3 fois la bombe nucléaire qui avait dévasté Hiroshima en 1945 (environ 50.000 tonnes de TNT).

Aucun télescope terrestre ou spatial n’avait repéré cet astéroïde avant qu’il ne percute l’atmosphère. Or, ce type d’objet est censé entrer en collision avec la Terre une fois par décennie !

A ce jour, très peu d’objets ont été recensés. La NASA estime qu'il y a environ 20.000 astéroïdes et comètes dans notre Système Solaire qui représentent une menace potentielle. Seuls 6000 de ces géocroiseurs au diamètre supérieur à 150 m ont été caractérisés.

Quant aux astéroïdes plus petits, ceux de 10 à moins de 100 mètres de diamètre, leur détection est pour ainsi dire impossible avec les programmes de surveillance actuels. Très peu d’objets de 100 mètres sont catalogués.

Malgré la bonne volonté des agences spatiales, sans un effort financier important évalué à plusieurs milliards de dollars, il n’est pas raisonnable de penser que l’on soit capable de recenser tous les objets de 20 m potentiellement dangereux.

Un autre astéroïde de 7m a "frôlé" la Terre !

- Mars Direct 1 : première station humaine sur Mars en 2020

Inscrit dans la continuité du projet européen, Euro-Mars, Mars Direct 1 pourrait être envoyée vers la planète rouge en 2020.

Chaque partie gonflable correspond à :

- Un sas par lequel les spationautes communiquent avec l'extérieur

- Une serre pour procéder à des expériences

- Un laboratoire où les scientifiques pourront réaliser directement les premières analyses des échantillons récoltés sur place

Un garage est également prévu dans ce projet Mars Direct 1. Des quads serviront à la mobilité des spationautes sur Mars.

Climat

Climat, écologie, énergies

Alors que les incertitudes sont si grandes et que certains croient bon de nier le réchauffement, voire prétendent qu'on va vers une glaciation, nous serions partis pour un réchauffement de 6°C à la fin du siècle, ce qui est au-delà des scénarios les plus catastrophistes et signifierait plus de 10°C à notre latitude ! Bien sûr, cela ne serait pas l'extinction de l'espèce humaine puisqu'il y a déjà eu 6°C de plus en Antarctique il y a 128000 ans, mais quand même, il est vraiment irresponsable d'en minimiser les conséquences, d'autant qu'on aurait les moyens techniques de passer rapidement aux renouvelables et que le peak oil n'est plus très loin.

Alors que les incertitudes sont si grandes et que certains croient bon de nier le réchauffement, voire prétendent qu'on va vers une glaciation, nous serions partis pour un réchauffement de 6°C à la fin du siècle, ce qui est au-delà des scénarios les plus catastrophistes et signifierait plus de 10°C à notre latitude ! Bien sûr, cela ne serait pas l'extinction de l'espèce humaine puisqu'il y a déjà eu 6°C de plus en Antarctique il y a 128000 ans, mais quand même, il est vraiment irresponsable d'en minimiser les conséquences, d'autant qu'on aurait les moyens techniques de passer rapidement aux renouvelables et que le peak oil n'est plus très loin.

- Polémique sur la courbe en cross de hockey

On le sait depuis longtemps, la fameuse courbe en cross de kockey est fausse (je l'ai souligné plus d'une fois et répété en octobre). Il est incompréhensible que le GIEC la reproduise encore avec un retour de bâton considérable sur la réalité d'un réchauffement pourtant indubitable même s'il y a de très nombreuses incertitudes. En tout cas la certitude qu'il n'y aurait pas de réchauffement est encore plus fautive et complètement irresponsable étant donnés les risques. Aucune autre solution que de continuer les recherches...

Voir une présentation détaillée des mails.

- Une éruption volcanique inconnue responsable du refroidissement de 1809

En appliquant une nouvelle technique analytique très originale sur les retombées de sulfate d'origine volcanique dans les précipitations de neige en Antarctique et au Groenland, une équipe franco-américaine vient de démontrer que les basses températures de la décennie la plus froide des derniers 500 ans (1810-1819) résultaient de la succession, à quelques années d'intervalle, de deux éruptions volcaniques majeures.

Une partie de ce refroidissement a été attribué à l'énorme éruption du volcan Tambora en Indonésie, en 1815. De telles éruptions cataclysmiques refroidissent en effet la planète car elles déversent d'importantes quantités de poussières et surtout de dioxyde de soufre dans la stratosphère (au-dessus de 15 km d'altitude).

Cependant, si ce mécanisme permettait de justifier le coup de froid entre 1815 et 1819 par l'éruption du Tambora, il restait à expliquer le refroidissement terrestre observé à partir de 1810.

Au sein des couches de glace datant de 1809-1810, ils ont observé une anomalie particulière dans les rapports de concentration entre ces isotopes. Or cette forme d'anomalie isotopique sur le soufre du sulfate ne peut résulter que de réactions chimiques se produisant au sein de la stratosphère après une éruption volcanique. Ils ont ainsi pu démontrer qu'une éruption volcanique cataclysmique, inconnue à ce jour, s'est produite au début de l'année 1809, probablement au niveau des Tropiques, et qu'elle a affecté le climat de manière globale.

- Le dernier âge glaciaire est arrivé en 6 mois seulement !

Il y a 13 000 ans, il n'aurait fallu que quelques mois pour que l'Europe se couvre de glace !

- Une centrale osmotique ouvre en Norvège

Le premier prototype de centrale osmotique a été inauguré le 24 novembre 2009 en Norvège. Il exploitera le principe de la pression osmotique pour produire une énergie sans carbone et renouvelable en mélangeant de l’eau douce et de l’eau de mer.

En gros, l’osmose permet de « pomper » l’eau sans énergie pour remplir un barrage hydroélectrique.

La compagnie Statkraft a investi 100 millions de couronnes norvégiennes (120 millions d’euros) et construit ce prototype de centrale à Tofte, au sud-ouest d’Oslo.

Le prototype, d’une puissance de 10 kilowatts, testera la technologie et aidera à développer des membranes plus performantes pour produire une énergie propre et renouvelable compétitive. Les membranes actuelles ont un rendement inférieur à 1 watt / m² mais elles seront remplacées par d’autres au rendement de 2 à 3 W. L’objectif est d’aboutir à un rendement de 5 W. En 2015, une centrale opérationnelle de 25 MW devrait être construite. Pour chaque mégawatt, elle consommera un mètre cube d’eau douce et deux mètres cubes d’eau salée par seconde.

- Se servir du CO2 pour la géothermie

La centrale géothermique de Soultz-sous-Forêts en Alsace, en France, utilise des pompes à eau dans la roche fracturée pour extraire la chaleur et donc générer de l'électricité. Les ingénieurs cherchent à prouver que de telles centrales géothermiques pourraient générer 50 pour cent plus de chaleur par injection de dioxyde de carbone sous terre à la place.

Voir aussi Futura-Sciences.

On parle souvent de la pollution des voitures, mais moins de celles des grands navires. Les statistiques montrent pourtant que seulement 16 des plus grands navires dans le monde dégagent la même pollution au souffre que la totalité des voitures dans le monde ! La raison qui justifie cette statistique est l'utilisation par les moteurs de ces navires de fioul lourd. Ce carburant est très épais et visqueux car peu raffiné. Les plus grands de ces vaisseaux peuvent libérer 5000 tonnes de souffre par an.

On estime que 100 000 navires marchands sont en circulation dans les océans et cette part s'accroît chaque année avec les échanges mondiaux. Ce que dégage la combustion de ce carburant est très toxique pour la santé. Un expert de l'université de Delaware estime que cela provoque 64 000 morts (87 000 en 2012) par an dont 27 000 en Europe.

- L'uranium aussi pourrait venir à manquer...

Ce n'est pas nouveau, on sait que le nucléaire ne peut pas être la solution.

- Les Russes prêts au stockage sur orbite des déchets nucléaires

La Russie possède les technologies nécessaires au stockage sur orbite des matières irradiées et des déchets nucléaires, a estimé lundi dans un entretien à RIA Novosti Igor Khamits, chef du secteur projets du Groupe russe de constructions spatiales RKK Energia.

"Il n'y a là aucun problème technologique. On peut mettre ces matières sur orbite pour une centaine d'année, c'est faisable mais cela coûte cher", a indiqué l'expert.

Selon lui, "on peut choisir une orbite et l'utiliser exclusivement à cette fin".

Cela paraît bien fou...

Biologie

évolution, génétique, biodiversité, éthologie, anthropologie, neurologie

- De l'ARN formé spontanément dans l'eau à l'origine de la vie terrestre ?

L'adénosine monophosphate cyclique (3,5-cAMP) et la guanosine monophosphate cyclique (3,5-cGMP) sont des nucléotides cycliques très similaires à deux des quatre molécules portant l'information dans l’ADN et l’ARN, et qui sont elles aussi des nucléotides. Les chercheurs italiens ont chauffé un simple mélange de 3,5-cAMP et 3,5-cGMP dans de l’eau à des températures comprises entre 40°C et 90°C pour voir ce qui pouvait se passer.

Dans ces conditions de température rappelant celles qui régnaient peut-être dans les océans primitifs de l’archéen, ils ont alors vu apparaître au bout d’une durée de 200 heures environ des molécules d’ARN composées de 100 nucléotides ! Cette longueur est faible en comparaison d'un ARN messager actuel et les molécules ainsi formées ne portent que deux des quatre lettres que nous connaissons (le A de adénosine et le G de guanine). Il manque donc le C de cytosine et le U de uracile (remplacé par la thymine dans l'ADN).

On a eu confirmation aussi que les bases de l'ARN peuvent venir de l'espace. Par ailleurs, il semble de plus en plus probable que les traces controversées d'une météorite venant de Mars seraient d'origine biologique, et donc qu'il y aurait (eu?) de la vie sur Mars !

- Vidéo d'une protéine en action

C'est la protéine Rho des bactéries E. Coli qui produit des protéines à partir de l'ARN qu'elle "lit".

- La plus simple des bactéries étonnement complexe

La bactérie Mycoplasma pneumoniae n'a que 689 gènes mais avec seulement 8 gènes "switches'' elle fait preuve d'une étonnante adaptabilité.

Si en filtrant l’eau de mer, ils peuvent consommer des larves de méduse, jamais il n’avait été imaginé qu’ils puissent s’attaquer à une méduse adulte. Jusque-là, seuls les poissons, les tortues marines et les oiseaux de mer étaient connus pour se nourrir à l’occasion de méduses.

- Un parasite à la place de la langue d'un poisson

Ce parasite quasiment unique en son genre a une tactique des plus repoussantes. Il n'affecte cependant que les poissons.

Il s'agit d'un petit crustacé qui s'attaque à un poisson nommé Vivaneau Rose en passant par les branchies. Il se fixe ensuite à la base de la langue du poisson et va boire le sang de sa proie. Sa langue va alors s'atrophier progressivement, tomber mais le parasite va rester. Il va définitivement prendre la place de la langue en se nourrissant du mucus du poisson.

La petite chèvre Myotragus balearicus a vécu sur les îles Baléares, en Méditerranée, jusqu’à l’arrivée d’Homo sapiens. Ce modeste caprin présente une caractéristique unique chez les mammifères : du sang froid !

Longtemps, les scientifiques se sont demandés comment un mammifère, au métabolisme gourmand en énergie, avait pu survivre sur des îles aussi pauvres que celles des Baléares. Certes, pour réduire ses dépenses énergétiques la taille de Myotragus balearicus s’était réduite (45 cm de haut chez l’adulte), ainsi que celle de ses yeux (un tiers de leur taille initiale) et même celle de leur cerveau, qui n’avait que la moitié de la taille de celui des espèces de dimensions équivalentes.

Myotragus balearicus est allé plus loin en adoptant le métabolisme des reptiles, plus flexible et plus adapté aux milieux pauvres en énergie. Tandis que chez les endothermes (à sang chaud), l’organisme a besoin d’un minimum d’énergie en continu, chez les organismes à sang froid, les ectothermes, la croissance et le métabolisme s’adaptent à la disponibilité des ressources énergétique (chaleur, nourriture). En conséquence, la croissance des os alterne entre des phases d’accroissement et des pauses qui se traduisent par des stries de croissance parallèles dans les os.

Selon eux et d’après les caractéristiques squelettiques, Myotragus balearicus ne pouvait pas sauter, devait se déplacer lentement et prendre régulièrement des bains de soleil.

Ce mode de vie indolent fut possible pour cette chèvre naine car elle n’a eu aucun prédateur pendant les cinq millions d’années qu’elle a passées sur ces îles. Puis, l’homme a débarqué il y a 3.000 ans…

- La disparition des mammouths ne serait pas due à l'homme ?

Ils ont découvert que les populations de ces bêtes énormes, désignées par le nom de mégafaune, ont commencé à décliner plus de mille ans avant l'émergence du peuplement Clovis, du nom d’un célèbre site archéologique dans lequel ont été retrouvés des outils préhistoriques vieux d'environ 11 500–13 500 ans. Et 1000 également avant les changements à grande échelle observés dans la flore et l'augmentation des incendies.

Ainsi, ce ne sont pas les chasseurs du peuplement Clovis ou des changements de l'environnement qui ont conduit au déclin de la mégafaune en Amérique du Nord comme on le pensait auparavant, mais c’est au contraire la lente extinction de cette mégafaune entre 14 800 et 13 700 ans qui aurait entrainé les modifications de la végétation. Avec leur disparition les feuillus ont pu prospérer, n’étant plus goulument ingurgités. Peu après, l'accumulation de débris de bois a entraîné une augmentation spectaculaire de la prévalence des incendies de forêt.

On ne peut exclure cependant que l'arrivée des hommes ait accéléré leur disparition la chasse par le feu précipitant les animaux des falaises étant attestée ainsi que la disparition des grands animaux partout où l'homme s'est implanté.

- La Révolution Russe à cause de la reine Victoria ?

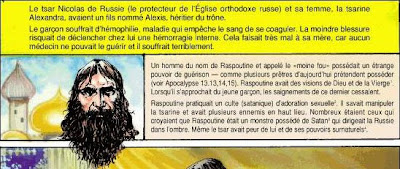

C'est juste pour rire mais la chaîne de causes est amusante que vient de révéler une étude génétique de l'héritier des Romanov qui était porteur d'une mutation responsable de son hémophilie et qui viendrait de la reine Victoria par sa petite-fille. Or, c'est à cause de cette hémophilie que Raspoutine a été appelé, participant à déconsidérer le pouvoir autocratique...

Comme on le soupçonnait déjà, toutes ces données confirment la version selon laquelle la mutation d'un gène - en l'occurrence, le F9 - s'est produite chez la souveraine britannique Victoria. Au sein de sa descendance, les hommes peuvent souffrir d'hémophilie, les femmes n'étant que les "conductrices" de cette affection récessive. Dans le cas des Romanov, la "conductrice" de cette maladie a été l'épouse du dernier tsar, Alix de Hesse-Darmstadt, petite-fille de la reine Victoria.

Rappelons que c'est pour combattre le mal dont souffrait son fils que la tsarine (devenue impératrice sous le nom d'Alexandra Fiodorovna Romanova) avait fait appel au "guérisseur" Raspoutine, dont les agissements avaient largement contribué à discréditer l'idée de la monarchie en Russie.

Santé

génétique, traitements, nutrition, hygiène

- Effet indirect des nanoparticules sur l'ADN

Charles Case et ses collègues ont mesuré l'effet de particules à base de cobalt et de chrome sur des cellules cibles (humaines), protégées par une membrane biologique constituée d'autres cellules. Cette barrière empêche le passage des particules de tailles nano ou micro (mille fois plus gros). Elle est censée modéliser, in vitro, des barrières naturelles comme celle du placenta ou la barrière sang/cerveau. Pourtant, malgré cette protection, les chercheurs ont bien identifié des lésions sur l'ADN à l'intérieur des cellules cibles.

Les chercheurs n'ont pas complètement déterminé le mécanisme mais ont identifié des cascades de réactions liées à ce phénomène. Le stress subit par les premières cellules de la barrière se répercute aux voisines jusqu'à l'émission d'une molécule, l'ATP, le carburant des cellules. C'est cet ATP, d'habitude bénéfique, qui en pénétrant dans les cellules pourtant protégées causerait des lésions sur l'ADN.

Un tel effet indirect est nouveau dans le domaine des nanotechnologies. Il est cependant connu pour décrire l'action de rayonnements ionisants qui affecte des cellules sans que celles-ci soit directement irradiées.

Les chercheurs eux-mêmes se gardent bien de toute extrapolation. Un effet biologique in vitro ne garantit pas son observation in vivo. Les cellules en situation réelle peuvent développer des modes de régulation qui annihilent cet effet. "Il est aujourd'hui purement spéculatif d'extrapoler ces observations au vivant. Comme ils le précisent, les auteurs ne prétendent pas que ce modèle représente une réplique du placenta humain".

Voir aussi Futura-Sciences.

- Les cellules souches peuvent être nuisibles

L'utilisation de cellules souche dans le domaine de la médecine régénérative n'est pas toujours bénéfique pour la santé humaine, et peut même s'avérer préjudiciable, d'après ce qu'a démontré un travail réalisé dans les universités de Grenade et de León. Les scientifiques ont démontré que la greffe de cellules mononucléaires humaines tirées du sang du cordon ombilical a un effet nocif sur les rats présentant une cirrhose hépatique.

Des résultats précédents, et d'autres en cours de publication, suggèrent que les deux premières protéines (la clusterine et CR1) interviennent, avec l'apoE, dans l'élimination du peptide bêta-amyloïde (PICALM est quant à elle impliquée dans le fonctionnement des synapses, les connexions entre neurones). Or, selon l'explication la plus commune de la maladie, l'accumulation du peptide bêta-amyloïde provoque l'une des lésions cérébrales caractéristiques : les plaques séniles. La forme tardive d'Alzheimer serait ainsi associée à une élimination insuffisante de cette molécule du cerveau, tandis que les formes héréditaires, plus précoces, seraient liées à sa surproduction.

- Les vertus anti-inflammatoires de l'huile de poisson

Des chercheurs de Boston, Londres et Los Angeles ont élucidé un mécanisme par lequel l'organisme combat les inflammations.

L'un des protagonistes de ce mécanisme est une molécule lipidique, la résolvine D2, que le corps synthétise à partir d'un acide gras oméga-3 dont les huiles de poisson sont particulièrement riches. Les résolvines et des molécules apparentées, les lipoxines, constituent une nouvelle famille de molécules impliquées dans la résorption de l'inflammation.

D'autre part, injectée dans une souris chez qui on a induit une septicémie bactérienne, la résolvine D2 diminue le nombre de bactéries présentes dans l'organisme en stimulant leur phagocytose par les macrophages, et réduit de façon spectaculaire la présence des médiateurs de l'inflammation.

Aujourd'hui, les traitements anti-inflammatoires présentent parfois certains effets indésirables car s'ils résorbent l'inflammation, ils affaiblissent en même temps le système immunitaire. La résolvine D2 fournira peut-être une alternative préservant les défenses immunitaires.

- Les allergies luttent contre certains cancers

Une publication qui conclut un long travail d'investigations sur de précédentes études vient de donner des nouveaux éléments de preuves comme quoi les allergies auraient un rôle protecteur contre certains types de cancers.

Les symptômes allergiques seraient en effet là pour repousser certaines particules potentiellement cancérigènes pour nos organismes. Il n'est donc pas évident de vouloir supprimer ces manifestations par des médicaments spécifiques. Seul l'asthme ne semble pas avoir d'effet protecteur.

On s'en doutait déjà, on ne peut avoir toutes les maladies à la fois, il y a des options qui s'excluent. On avait vu aussi que les rhumes pouvaient protéger des cancers en s'attaquant en priorité aux celules cancéreuses (tout comme la rougeole ou l'herpès?). Par ailleurs, et de façon plus classique, il se confirme que les rhumes protégeraient (relativement) de la grippe.

- Attaquer le cancer avec le système immunitaire

Il y a différentes stratégies "vaccinales" pour que le système immunitaire attaque les cellules cancéreuses. Cette fois, il s'agit d'implanter un disque en polymère imprégné de cytokines et qui mime l'ADN bactérien, ce qui a produit la régression de tumeurs chez des souris.

Il y a différentes stratégies "vaccinales" pour que le système immunitaire attaque les cellules cancéreuses. Cette fois, il s'agit d'implanter un disque en polymère imprégné de cytokines et qui mime l'ADN bactérien, ce qui a produit la régression de tumeurs chez des souris.

- La grossesse contre le cancer du sein

Les hormones produites pendant la grossesse induisent la synthèse d’une protéine qui pourrait bloquer le développement tumoral chez les femmes porteuses d’un cancer du sein. Grossesse et allaitement sont connus pour réduire le risque de ce cancer. Serait-ce là une explication ?

La protéine en question – l’alpha-foeto protéine ou AFP – est produite sous l’impulsion des hormones de la grossesse : œstrogènes, progestérone, gonadotrophines. L’équipe du Pr Herbert Jacobson, à Albany dans l’Etat de New York, a traité des rats – préalablement exposés à des substances carcinogènes – avec ces hormones. Œstrogènes et progestérone, œstrogènes seuls ou gonadotrophines seules ont permis d’obtenir une réduction de 30% à 50% de l’incidence des cancers du sein.

Des chercheurs de l'Université de Grenade ont découvert un gène suicide, dénommé 'gène E', qui induit la mort des cellules tumorales dérivées du cancer du sein, du poumon et du côlon, et en empêche la croissance. L’utilisation de ce nouveau gène pourrait permettre de réduire les puissants médicaments employés actuellement.

Les scientifiques de l'UGR ont utilisé le gène suicide dénommé E du bactériophage phiX174 pour induire la mort des cellules tumorales. Les chercheurs ont étudié diverses techniques dans le but de comprendre le mécanisme d'action du gène E. Leurs résultats indiquent que le gène E induit dans les cellules un phénomène d'apoptose (mort cellulaire programmée), probablement par lésion mitochondriale.

Ils suggèrent également la possibilité de réduire les concentrations d'agents chimiothérapiques utilisés actuellement. Ainsi, dans le cas cancer du poumon, les chercheurs ont obtenu un peu plus de 14% d'inhibition de croissance tumorale et une réduction de cent fois la dose de l'agent Paclitaxel (chimiothérapie) une fois le traitement combiné avec le gène E. Dans le cas du cancer du côlon, les résultats obtenus ont été similaires. Cependant, la donnée la plus importante concerne le cancer du sein, où la dose de l'agent chimiothérapique, la Doxorubicine, a pu être réduite cent fois, obtenant presque 21% d'inhibition de la prolifération tumorale.

- Le gène anti-cancer du rat-taupe

Alors que, à titre de comparaison, une souris ne vit pas plus de quatre ans, Heterocephalus glaber peut frôler la trentaine ! Comme si nous pouvions vivre jusqu'à 600 ans ! Non seulement, l'animal ne montre pas de signes de sénescence mais il est imperméable au cancer !

Le secret de cette résistance réside dans l'hypersensibilité d'un phénomène bien connu des biologistes cellulaires : l'« inhibition de contact ».

Ce mécanisme stoppe la prolifération cellulaire lorsque leur densité devient trop importante, permettant ainsi de réduire l'apparition de cellules cancéreuses au sein d'une masse cellulaire compacte trop stressée. Si elle est connue chez l'homme et la souris, l'inhibition de contact se révèle avoir une acuité sans égal chez le rat-taupe nu. A peine les cellules se touchent-elles que leurs divisions s'arrêtent, ont montré les chercheurs. En allant un peu plus loin, ils ont mis la main sur les deux protéines responsables de cette sensibilité extrême : p27kip1 et p16Ink4a. Selon Andrei Seluanov et ses collaborateurs, leur action combinée confère aux cellules du rat-taupe une inhibition de contact en deux temps largement plus efficace que celles de la souris ou de l'homme qui ne s'appuient que sur p27kip1.

- 7 voies étonnantes de recherche contre le cancer

1- Explosion au Laser

2- Laser sur cible dorée

3- Patch de diamant

4- Le nanorobot détecteur de tumeurs

5- Un agent secret nommé bactérie

6- Prévention génétique

7- Un venin de scorpion radioactif

- Diagnostic minute avec une goutte de sang

L'intérêt de cette puce d'IBM, c'est qu'elle ne comporte aucune partie mécanique fonctionnant uniquement par capillarité dans un microfluide. En déposant une goutte de sang on obtient un diagostic en 15 mn.

- Un vaccin contre la nicotine

GSK (GlaxoSmithKline) vient d'acheter à Nabi Pharmaceuticals le vaccin contre la nicotine qu'ils ont développé (NicVAX). L'efficacité serait de 90% !

- Des transistors biodégradables dans le corps humain

Des chercheurs de l'université de Standford ont mis au point des systèmes électroniques aptes à fonctionner dans une forte humidité... et biodégradables. La découverte ouvre de nombreuses perspectives thérapeutiques, notamment en médecine.

A terme, ce type de système permettrait d'effectuer des décharges programmées de médicaments ou de déclencher une capsule par le biais d'ondes pour délivrer une molécule thérapeutique. Une aide qui pourrait être précieuse dans le cadre de la chirurgie.

- Pendant 23 ans, on le croyait dans le coma, il était en fait paralysé

Après un grave accident de voiture en 1983, Rom Houbens est considéré par les médecins comme «un cas sans espoir». Pendant 23 ans, ce Belge âgé aujourd’hui de 46 ans était, pour son entourage, dans un coma profond.

En 2006, une nouvelle méthode permet des analyses plus poussées. On découvre alors que Rom Houbens était conscient depuis le début, seul son corps était paralysé. «J’ai crié mais on ne pouvait pas m’entendre».

Grâce à un ordinateur, il peut désormais communiquer avec son entourage, même s’il ne quittera probablement jamais l’hôpital. «Je n’oublierai jamais le jour où ils l’ont découvert, ma deuxième naissance», confie l’homme.

Le plus extraordinaire, c'est que cet homme a passé son temps à rêver à une vie meilleure et ne considère pas qu'il vaudrait mieux mourir dans son état !

- L'humanitude pour nos vieux !

Depuis trente ans, la « philosophie de l’Humanitude » montre son efficacité dans l'accompagnement de personnes atteintes de la maladie d'Alzheimer. Elle repose sur un ensemble de pratiques, de gestes, d'habitudes, de paroles...

Ce qui est effarant, c'est qu'on ait besoin d'en faire une théorie, mais c'est un progrès qu'on se préoccupe des rapports humains dans les rapports de soins, comme Dolto avait changé le rapport aux nourrissons ! C'est un progrès aussi qu'on ne parle pas "d'amour" mais de paroles, de gestes, de respect.

Technologie

biotechnologies, énergie, nanotechnologies, robotique, informatique

Une étape importante pour l'utilisation de nanotubes comme filins et comme fils électriques, avec sans doute moins de danger pour la santé ?

- Des transistors à base de nanotubes en production de masse

Une technique de fabrication simple permet de produire de façon efficace et rentable des transistors à base de nanotubes de carbone opérationnels au moins pour les écrans.

Voir dossier nanotechnologies.

- Solaire imprimé, efficacité 10% mais 1$/Watt

Les cellules solaires (en haut) ont été imprimés par des rouleaux avec de l'encre contenant des nanocristaux semi-conducteurs inorganiques (en bas). Les cellules ont été imprimées sur une feuille métallique souple qui sera recouverte d'une plaque de verre.

- Des cellules photovoltaïques en 3D

Des cellules photovoltaïques à base de sphères (ou de gouttes) permettent de mieux capter la lumière sans avoir à changer l'orientation des capteurs.

Il ne suffisait pas d'y penser. Au fil de la journée ou des mouvements de son support, une surface courbe récupère mieux l'énergie solaire qu'un plan. Encore faut-il trouver un moyen de créer des structures de petites tailles aux formes idéales. Une équipe américaine vient de le réussir en s'aidant... de gouttes d'eau.

Le circuit (un semi-conducteur avec une partie dopée positivement, p+, et une partie dopée négativement, n+) est gravé sur une galette de silicium (SOI wafer), par les techniques classiques de lithogravure, avec ses contacts électriques (Cr/Au, chrome et or). Très fin (ici 2 microns), le composant obtenu est dégagé par une attaque chimique (Etch undercuts), un procédé classique lui aussi, et on dépose une goutte d'eau. L'origami se referme alors comme prévu, en une sphère. En bas, le résultat. Des électrodes sont soudées et les courbes montrent l'intensité obtenue (mAmpères/cm2) en fonction de la tension (voltage). Le résultat est amélioré par la présence d'un réflecteur, sorte de cuvette réfléchissante dans laquelle on dépose cette sphère.

- Produire du carburant avec du soleil, du CO2 et de l'eau

On avait déjà parlé de cette piste qui prend forme même s'il y a encore des progrès à faire.

Ce prototype, connu sous le nom de "CR5", a été conçu par des chercheurs de Sandia afin de convertir le dioxyde de carbone en monoxyde de carbone, ou l'eau en hydrogène, en utilisant l'énergie solaire concentrée. Le monoxyde de carbone et l'hydrogène peuvent être combinées ensuite pour produire du syngas qu'on peut transformer en carburant. Le premier prototype, illustré ci-dessus, a démontré que le processus fonctionne, mais des efforts sont en cours pour le rendre plus efficace.

L'immense avion, réalisé par Bertrand Piccard et son équipe, qui, un jour, devrait réaliser le tour du monde avec zéro carburant, est sorti de son hangar.

Voir vidéo.

Beaucoup de trains électriques sont équipés de systèmes de freinage dynamique. Ce sont des dispositifs qui utilisent les moteurs comme des générateurs afin de ralentir le véhicule. Mitsubishi Denki a développé un système qui permet de stocker l'énergie ainsi libérée, à la fois à bord du train mais également dans des batteries disposées le long de la voie ferrée dont l'alimentation se fait via les caténaires.

Les batteries situées à terre peuvent restituer l'électricité via les caténaires ; celles embarquées à bord du train sont destinées au fonctionnement de celui-ci lorsqu'il circule sur des voies non électrifiées.

Mitsubishi et la compagnie JR East testent actuellement un train électrique, le NE (New Energy) Train, qui peut circuler indifféremment sur des lignes électrifiées ou non. Il est équipé de neuf batteries Li-ion de 600 V et 163 kWh chacune. Sa vitesse maximale est de 100 km/h et son autonomie de 50 km (distance calculée sans compter l'électricité consommée pendant l'arrêt en gare).

JR East étudie également un système qui permettrait de recharger les batteries en gare, même dans les zones où les lignes ne sont pas électrifiées.

Cela évoque les récents bus électriques qui se rechargent aux stations grâce à des supercondensateurs.

- De l'électricité à partir de la chaleur et de la résonance

Cela ressemble aux "cheminées solaires" tirant de l'énergie d'une colonne d'air chaud.

Ce dispositif provient de la recherche actuelle des chercheurs sur de petits réfrigérateurs thermoacoustiques.

Lorsque le dispositif reçoit de la chaleur depuis l'environnement, la chaleur s'accumule jusqu'à un certain « palier ». Ensuite, l'air se déplace dans le dispositif sous l'effet de la chaleur (phénomène de convection).

Cette convection d'air chaud dans le tube excite la fréquence de résonance (voir notre dossier sur la résonance ) de ce dernier et le fait littéralement « chanter » comme une sorte de flute.

Ces ondes sonores vont alors être dirigées vers un dispositif piezo-électrique qui transforme ces ondes de pression (une onde de sonore est une onde de pression) en électricité.

Pour les chercheurs, les dispositifs pourraient être utilisées d'ici deux ans comme alternative aux cellules photovoltaïques afin de convertir l'énergie du soleil en électricité.

Ce dispositif pourrait aussi être employé au refroidissement des ordinateurs portables et autres ordinateurs au fur et à mesure que la puissance croissante de leurs composants fait qu'ils chauffent de plus en plus.

- Nec invente la télécommande sans pile !

Grâce à l'effet piézoélectrique, pas besoin de piles pour cette télécommande, l'électricité étant fournie par les boutons eux-mêmes !

- Baisse de participation pour Wikipédia

Moins de membres actifs. Sur les trois premiers mois de 2009, la version anglaise de Wikipédia a perdu environ 49 000 contributeurs, contre 4 900 sur la même période l'an dernier. Le développement de l'encyclopédie a, semble-t-il, atteint une certain point de maturité : dans les langues les plus répandues, la plupart des sujets potentiels disposent déjà d'une page, ce qui pourrait expliquer le départ d'utilisateurs.

Moins de nouveaux utilisateurs. S'il y a moins de membres actifs, c'est aussi et surtout parce que le nombre de nouveaux éditeurs s'inscrivant sur le site diminue, et les nouveaux inscrits ont tendance à abandonner plus rapidement qu'auparavant. D'après une étude citée par le Wall Street Journal, cela s'explique en partie par la complexité des règles qui régissent aujourd'hui l'encyclopédie : les "nouveaux" enfreignent souvent des règles sans le savoir, et voient ainsi leur travail effacé.

L'encyclopédie évolue moins vite aujourd'hui qu'il y a trois ans, mais la croissance de son audience se poursuit à un rythme soutenu. D'après l'institut Comscore, l'ensemble des sites de la Fondation Wikipédia ont attiré en mars dernier 327 millions de visiteurs uniques, contre 301 millions le mois précédent et 272 millions six mois avant.

Je confirme que depuis sa normalisation, participer à Wikipédia devient bien plus difficile, confronté à l'absurdité de règles contradictoires et stérilisantes (voir la discussion sur la page Hegel).

- Google Chrome OS : la consécration des netbooks

C'est une véritable révolution et la consécration du modèle Google qui déporte programmes et données sur le réseau. Du coup, le démarrage ne prend que 11 secondes (avec l'authentification) mais l'essentiel est bien que le netbook devient un simple terminal, n'ayant besoin que d'une puissance restreinte (et donc accessible aux pays pauvres) en même temps que nos données deviennent accessibles de partout (on peut changer facilement de terminal, téléphone ou pc). Il est amusant de voir le modèle terminal-mainframe qu'on croyait dépassé par le micro-ordinateur revenir sous la forme certes très modifiée du cloud-computing où "l'ordinateur central" est éclaté entre une multitude de serveurs mais où tout se fait à travers le navigateur. Il faudra sans doute que ce nouveau système réintègre les potentialités du stockage et du traitement local mais il pourrait bien y avoir d'ici peu un véritable raz de marée qui signe la fin du modèle Microsoft. Ce n'est en rien une surprise puisque c'est l'aboutissement d'une stratégie commencée depuis longtemps de mise à disposition progressive de tous les outils nécessaires à un simple terminal de réseau et dont toute la puissance ne va se manifester que maintenant, ou plutôt dans 1 an car on n'en est pas encore à l'offre commerciale bien que des sites "pirates" permettent de le télécharger en toute légalité puisqu'il est open source...

Consulter ses courriels, éditer des textes et des tableurs, jouer, écouter de la musique, communiquer via sa messagerie instantanées, stocker des médias… Chrome OS centralise ces applications au sein du navigateur, cœur du système. Le tout est soutenu par la pléthore de services Google déployés ces dernières années en termes de cloud computing. En effet avec l’avènement de Chrome OS, de Google Documents à Google Wave, en passant par Google Agenda et GMail, tous ces services deviennent cohérents.

- Un nouveau protocole pour accélérer internet

Google aimerait accélérer le web avec une méthode plus efficace, et propose à cette fin le protocole SPDY (Speedy!).

L'idée principale est qu'au lieu d'ouvrir quelques connexions pour télécharger un par un les dizaines de fichiers (html, images, css, javascript, ...) qui constituent une page web, on ouvre un unique canal SSL ou tout est transféré sous forme compressée. On gagne ainsi le temps qu'il faudrait pour ouvrir chaque connexion, et les en-têtes sont limités au strict minimum afin que le transfert soit aussi léger que possible. On pourrait ainsi faire baisser le temps de téléchargement des pages jusqu'à 50%.

Par ailleurs, la nouvelle version, un peu plus performante, de Google (Caffeine) arrive ainsi que la traduction sous forme de synthèse vocale mais avec l'acquisition d'Admob et de Teracent, Google promet d'inonder nos téléphones de publicités ! Cette façon d'occuper tout le territoire fait penser au jeu de Go. C'est en tout cas un capitalisme très différent du capitalisme industriel où l'investissement vise à fidéliser l'utilisateur en le rendant dépendant par des services gratuits tout en empêchant des concurrents d'émerger, la concentration du capital servant à élever au maximum la barrière d'entrée, ce qui pourrait avoir un effet désastreux si aucune faute n'était commise laissant sa chance à un challenger improbable.

Payer les sites pour les indexer, ou payer pour qu'ils se retirent d'un moteur de recherche concurrent. La stratégie explosive de Microsoft et News Corp est une attaque directe contre le cœur du modèle économique de Google.

En rémunérant les éditeurs, Microsoft pourrait en effet inciter Google à se montrer lui aussi plus généreux envers les sites d'info. Or, la rentabilité de Google dépend en grande partie du "coût d'acquisition du trafic", c'est-à-dire du pourcentage des recettes publicitaires qu'il reverse aux sites web partenaires.

Inciter Google, en plus de ce partage des recettes, à rémunérer les sites pour les référencer, c'est détruire le modèle qui a fait la réussite du géant. L'efficacité de la stratégie de Microsoft dépendra du nombre d'éditeurs qui suivront l'exemple de News Corp… et du nombre d'internaute qui migreront vers Bing. Deux -très- grosses inconnues qui conditionneront le déclenchement de la guerre du référencement entre les deux moteurs de recherche.

La différence entre brouillage et cryptage est que le premier consiste à brouiller les données selon le principe de l'entropie de Shannon. L'entropie désigne l'incertitude sur les données transmises. Plus l'émetteur inclut de bruits parasites, ici des bits ajoutés, plus l'entropie est grande. Inversement, plus le récepteur reçoit des données plus il est à même de minorer cette entropie pour s'approcher des données originelles. La différence est qu'une donnée brouillée est indiscernable et illisible en temps réel mais pas inviolable une fois isolée, tandis qu'une donnée chiffrée est facilement repérable sur le réseau, mais demande des ressources colossales pour le décodage.

Ce n'est pas un véritable hologramme mais une image virtuelle projetée sur un film plastique avec un angle de 45° par rapport à la salle, pouvant être utilisé pour des conférences à distance, à condition que les prix baissent...

- Une nouvelle interface magnétique

Grâce à la détection des modifications de champs magnétiques on peut détecter de nouvelles actions (écraser, étirer, rouler, frotter, etc.), ce qui pourrait servir à sculpter des objets mais l'intérêt reste sujet à caution...

Dans le même genre douteux, il y a une commande par le souffle...

- Un kit de lecture pour les aveugles

Pour accomplir sa tâche, le système comprend un appareil photo numérique à 5 mégapixels autorisant une distance de 10 à 100 centimètres pour la prise de clichés, un disque dur SSD de 4 gigaoctets dont 2 alloués au stockage des données de l'utilisateur. En théorie, l'Intel Reader est capable de stocker 500.000 pages de texte pur pour une autonomie annoncée de 4 heures en restitution audio du texte.

Il s'annonce vraiment mobile avec ses 16,5 x 13,6 x 3,3 centimètres pour un poids de 650 grammes.

Une plateforme, la Intel Portable Capture Station (station d'aide à la capture des contenus), est prévue pour assister les déficients visuels dans la numérisation de leurs supports papiers.

L'Intel Reader vise en premier lieu l'aide aux personnes handicapées. Ainsi un étudiant dyslexique pourra numériser un document pour mieux le décortiquer en mot à mot ou vocalement. Un aveugle pourra consulter les pages de son journal fraîchement reçu. De la même manière, il n'aura plus à attendre la sortie d'un roman en Braille pour pouvoir en profiter.

- La traduction assistée par les lunettes

Ce système prend la forme d'une paire de lunettes surmontée d'un curieux appendice sur le côté droit. Lequel contient un système de micro-miroirs mobiles qui sont mus par des Mems qui s'occupent de balayer la rétine de l'utilisateur. Un boîtier relié aux lunettes génère l'image par fragments et la transmet par fibre optique.

L'utilisateur a l'impression de voir les images affichées à un mètre de distance sur une surface virtuelle de 41 cm². L'avantage du dispositif par rapport à des lunettes écran de type Vuzix est qu'il n'interfère pas avec l'environnement de l'utilisateur, puisque le tout est translucide.

C'est précisément au niveau de l'infrastructure de traitement et de la génération des applications et données que Nec intervient. Son projet TeleScouter complète les lunettes RID de Brother par des minis systèmes d'acquisition d'image et de son. Les données obtenues sont transmises au boîtier optique des lunettes, lui-même relié sans fil à un serveur de traitement. Ainsi le micro et les caméras sont les yeux et les oreilles de cet ordinateur central. En plus du RID, des écouteurs sont ajoutés aux lunettes.

Au-delà des commandes vocales, le micro peut permettre à une application du serveur de restituer une conversation sous la forme d'un texte, qui une fois traduit peut être affiché sur les lunettes RID.

Voir aussi Numerama.

- Reconstitution d'un film à partir de l'activité du cerveau

Des candidats regardaient d'abord diverses vidéos diffusées sur un écran. Les cerveaux de ces patients étaient analysés au moyen d'une visualisation par scanner IRM. Un programme informatique a ensuite relié les zones du cortex visuel qui s'activaient aux formes, couleurs et mouvements des vidéos qui passaient en même temps et en a tiré des schémas.

Ensuite, les patients regardaient un film et le programme tentait alors de reproduire ce qui se passait sur l'écran rien qu'à partir des zones du cerveau qui s'activaient! L'ordinateur est bien arrivé à reproduire le film même si les images restaient floues et sans détail ; par exemple, on ne pouvait pas reconnaître le visage d'une personne vue dans le film, mais on pouvait distinguer les formes du corps.

- Un panneau numérique adaptable

Ce n'est qu'une ébauche encore d'environnement matériel configurable.

Dans les placards à vêtements, on aura bientôt le choix entre une cravate qui ne se salit jamais, des chaussettes antibactériennes ou un T-shirt qui affiche un message lumineux. Et pour aller skier, ne pas oublier la veste naturellement réchauffante.

Il y a aussi des tissus électroniques et même des combinaisons antifatigue, antichoc, etc.

- Recyclage de l'eau et douche à "phyto-épuration" !

- Un robot pour jouer au ping pong

Comme on le voit sur la vidéo, il est loin d'être au point...

<- Revue des sciences précédente | Revue des sciences suivante ->

Les commentaires sont fermés.