Il est difficile de mesurer à quel point, bien au-delà de leur utilité immédiate, les modèles de langage génératifs comme ChatGPT vont bouleverser nos représentations du monde et donc le changer profondément, religions, idéologies, philosophies devenant instantanément obsolètes. En cela, on peut dire que l'IA va bien détruire les anciennes civilisations mais ce sera par la révélation (si déceptive) du fonctionnement de notre esprit. En effet, partout on répète à foison que ces intelligences artificielles n'ont rien à voir avec notre propre intelligence or il n'y a rien de plus faux.

Il est difficile de mesurer à quel point, bien au-delà de leur utilité immédiate, les modèles de langage génératifs comme ChatGPT vont bouleverser nos représentations du monde et donc le changer profondément, religions, idéologies, philosophies devenant instantanément obsolètes. En cela, on peut dire que l'IA va bien détruire les anciennes civilisations mais ce sera par la révélation (si déceptive) du fonctionnement de notre esprit. En effet, partout on répète à foison que ces intelligences artificielles n'ont rien à voir avec notre propre intelligence or il n'y a rien de plus faux.

Certes il est exact qu'elles n'ont aucune conscience ni même compréhension de ce qu'elles produisent et il est indéniable qu'il leur manque plusieurs dimensions de notre psychisme. Il y a d'abord l'absence des dimensions biographiques et morales (un long apprentissage par renforcement et la construction de récits de soi) qui constituent notre véritable conscience personnelle - qui est bien essentiellement une conscience morale impliquant une compréhension de sa situation - mais, de plus, comme on va le voir, il manque au simple niveau cognitif (pour peu de temps encore?) l'indispensable complémentarité entre intuition ou perception et raison (soulignée d'Aristote à Kant) y compris pour la production de langage, la fonction critique de l'intelligence, l'esprit qui dit non, modérant la crédulité et le conformisme de la pensée. Ce dualisme des processus utilisés, un peu comme les "réseaux adverses", est effectivement incontournable pour valider l'insertion de l'information reçue dans une base de connaissances fiable.

Sauf que ces vérifications sont beaucoup moins omniprésentes qu'on ne le suppose dans ce qu'on dit, la plupart du temps très semblable au traitement automatique des modèles génératifs de langage, qui reproduisent d'ailleurs tout autant la connerie humaine, ce qui a été dénoncé dès le début. La fiabilité de wikipédia avait été dénigrée de la même façon, non sans raisons mais sans que cela n'annule les apports considérables de l'encyclopédie (en progrès). Il ne s'agit pas de faire croire qu'on aurait avec ChatGPT une intelligence parfaite, seulement une intelligence au moins aussi imparfaite que la nôtre mais ayant accès à plus de sources. On peut considérer du reste la connerie comme l'inévitable conséquence d'un apprentissage qui n'est pas tiré de l'expérience mais de ce qu'on nous a dit depuis l'enfance, apprentissage forcément servile et dogmatique, lié de plus à nos appartenances, arrivant à nous faire croire au Père Noël. Pas étonnant que cette connerie se soit retrouvée dans les IA précédentes, reprenant toute la connerie humaine telle qu'elle s'exprime abondamment sur les réseaux sociaux - ce qui les avait disqualifiées. Il a donc fallu y remédier (partiellement) par des corrections programmées, pour être simplement utilisables, tout comme on ne peut se passer de modération dans les forums. Cela montre quand même qu'on est loin de l'idéal rêvé et que, comme toujours, il n'y aura pas que des conséquences positives à cette révolution cognitive qui n'est pas immunisée contre toute connerie ni contre son détournement vers des usages dangereux. Non, mais leurs performances remarquables tout autant que leurs faiblesses posent de nouvelles questions à notre compréhension de l'intelligence et de notre propre pensée, décidément devenue sans mystère et débarrassée de cette supériorité qui faisait notre orgueil.

Ce qu'on ne dit pas assez, en effet, voire pas du tout, c'est que l'IA et la neuro-imagerie progressent ensemble depuis l'utilisation des réseaux de neurones. Il vaudrait mieux faire savoir qu'on a ainsi avec ces modèles de langage un fonctionnement à peu près identique à celui du cerveau humain pour traiter le langage, basé de façon très surprenante sur la mémoire à court terme et la prédiction du mot suivant en fonction du mot précédent et du contexte, tout comme ChatGPT, procédure très simple mais qui se révèle étonnamment puissante. On le sait depuis octobre 2021 au moins et j'avais déjà souligné en avril 2022 l'importance de cette nouvelle convergence entre l'Intelligence Artificielle et le fonctionnement du cerveau, mais il faut avouer que cette découverte assez incroyable restait abstraite avant d'avoir pu la tester et avoir constaté les prouesses époustouflantes de ce mécanisme minimal (avant d'en éprouver toutes les limites malgré tout). Pour parler et répondre, il suffirait donc d'appliquer la règle la plus simple qui est de dire ce qui est la norme, le mot qu'on attend de nous, c'est-à-dire trouver le mot le plus probable à dire dans cette circonstance pour compléter les phrases et les conversations. [C'est un peu plus compliqué, il faut ajouter un certain nombre de "réglages fins", en fonction du contexte et de l'expérience, corrigeant des erreurs courantes mais le mécanisme reste bien , comme dans le cerveau, la prédiction du mot suivant]. En tout cas, comme toute découverte scientifique, ce n'est pas du tout une invention humaine, les sciences depuis Galilée contredisant systématiquement nos anciennes théories, déshumanisant notre savoir en l'universalisant, et ce truc qui semble miraculeux n'est encore une fois qu'une imitation du vivant et de ses processus d'apprentissage, consistant neurologiquement à prédire ce qui doit suivre pour comparer ensuite avec ce qui arrive vraiment (prédiction récompensée ou non par la dopamine).

On ne peut cacher que cela paraît un peu absurde (pas seulement à Chomsky), et pour tout dire assez difficile à admettre, mais c'est expérience faite que la nature du langage et de l'intelligence nous apparaissent comme résultant largement de ce simple mécanisme sans esprit, ni personnalité, ni intentionnalité, totale désubjectivation qui nous ramène en partie au moins à l'animal machine par un biais plus qu’inattendu. On en voit bien pourtant la pertinence pour rendre compte d'un déroulement de la pensée qui se fait souvent tout seul, automatiquement, comme un flux de paroles inarrêtable. Si les mots nous viennent si facilement quand on parle, sans avoir le temps d'y réfléchir ni beaucoup d'hésitations, c'est qu'on ne fait que continuer un discours, compléter des phrases, réciter sa leçon, rabâcher l'idéologie de son milieu ou ses propres obsessions. L'artiste en pleine "création" est comme habité d'une force extérieure implacable qu'il ne fait que suivre au mieux. Il devient clair que "ça parle" pour nous. La musique joue d'ailleurs sur cette prédiction logique (normalité) pour créer la surprise (transgression). On peut rapprocher enfin l'extraction probabiliste d'un corpus littéraire avec le souci qu'a l'écriture, pourtant plus réfléchie, de reproduire la bonne formule stéréotypée, quitte à la déformer. Ce "bon style" très conformiste ne fait que confirmer une fois de plus que nous ne faisons pas autrement dans nos échanges ou pensées spontanées - pas si éloigné du peuple, évoqué par Paulhan dans "Les fleurs de Tarbes", utilisant intensivement dictons, proverbes et formules toutes faites dans leurs échanges quotidiens. La créativité humaine supposée, pas seulement dans l'expression, se relève en fait très limitée, y compris dans les mouvements artistiques qui sont d'abord des modes soumises à l'imitation. Ce qu'on appelle le flux de la conscience, la si mystérieuse vie de l'âme, n'est pas si différent d'un chatbot étant fait le plus souvent de dialogues imaginaires déroulant leur argumentation à vide quand il ne s'agit pas de musique entêtante ou d'idées fixes se répétant en boucle dans ce qu'on appelle le "réseau par défaut" du cerveau. Rimbaud avait vraiment raison : "C'est faux de dire : Je pense : on devrait dire : On me pense. Je est un autre".

Certes, personne ne conteste que l'IA (actuelle) n'est pas une personne et n'a ni intention, ni opinions, ni intériorité mais c'est bien ce qui est étonnant et prouve justement qu'on n'en a pas besoin pour raconter des histoires et "se faire une opinion" à partir de celle des autres. Il n'est pas question de nier la différence entre l'homme et la machine, ni l'importance de l'intentionnalité qui reste déterminante mais son champ se rétrécit drastiquement dans le déploiement du langage appris, n'intervenant plus que marginalement (au départ, puis lors d'éventuelles corrections d'erreurs pour atteindre son objectif). Le fait que ça parle tout seul est d'ailleurs inséparable de la fonction d'apprentissage validée par ses prédictions. Ce qu'on sait depuis longtemps. Par exemple, en 1979 D. Ingvar déclarait que "en se fondant sur des expériences antérieures stockées en mémoire, le cerveau – l'esprit de tout individu – est automatiquement occupé à extrapoler les événements futurs". Et pourtant, la puissance de ce procédé n'avait pas été soupçonné avant, constituant le véritable chaînon manquant qui n'était pas du tout ce qu'on attendait ! Ce n'est pas juste un progrès de plus mais une rupture dans nos représentations de la pensée. Il faudra bien s'y faire mais cela devrait nous bouleverser beaucoup plus que l'étrangeté quantique car nous dévoilant tant de choses sur nous-mêmes, nos pensées automatiques, le langage et la communication, où l'identité, l'intentionnalité et la conscience ni même un "modèle du monde" ne sont requis la plupart du temps, parlant comme un perroquet, donnant plus ou moins bien la réplique, jouant son propre rôle et propageant avec aplomb les ragots les plus absurdes (fake news qu'on appelle "hallucinations" pour des IA). On comprend du coup que le savoir de son ignorance ne soit pas premier, exigeant réflexion : on dit d'abord ce qui se dit, ce qui nous passe par la tête et non pas ce qui vient de notre savoir effectif. Or, cette place de la rumeur ou de la transmission verbale a priori rend obsolète une bonne partie de la philosophie de l'esprit (et bien sûr des conceptions religieuses), y compris l'empirisme.

Il faut revenir sur le fait qu'il manque quand même la capacité de raisonnement logique à ces modèles de langage et ce n'est pas d'hier qu'on avait identifié dans la pensée l'influence du langage, du logos, sous la forme de la logique, ensemble de règles ou de calculs mieux effectués par une machine à calculer et les ordinateurs. Si, en 1854, George Boole a pu intituler son livre "Les lois de la pensée", il était quand même évident que cela ne couvrait pas l'essentiel de notre pensée ni de notre communication. C'est ce que simulent si bien au contraire les ChatBots grâce au traitement probabiliste des énoncés selon les mêmes principes que les réseaux de neurones utilisés dans la reconnaissance d'images ou la perception. Il est là aussi très surprenant que le mécanisme d'apprentissage autonome qui structure notre perception puisse s'appliquer tout autant à l'apprentissage du langage maternel, de sa grammaire comme de son vocabulaire, de ses expressions, citations (d'Homère, d'Aristote, de Shakespeare), langue qui évolue par son usage statistique. C'est étonnant car le langage est justement d'un tout autre ordre que la perception, sa mémoire procédurale étant opposée à la mémoire intuitive, pour autant cela n'empêche pas qu'elle utilise le même mécanisme probabiliste de validation après-coup de l'anticipation de la suite, que ce soit neurologiquement ou dans les programmes de traitement du langage. La pensée en roue libre se révèle être une sorte de perception interne de l'acquis préalable ou du sens commun (des sources) quand elle n'est pas occupée de logique (symbolique), de perception ou de vérification externe (correction d'erreurs). Il y a donc bien quelque chose de vrai à faire du langage et de la pensée l'expression d'un esprit collectif, d'une réalité extérieure immatérielle en même temps que de notre propre histoire, mais ce n'est qu'une composante, certes principale, un moment de la pensée soumis ensuite à la réflexion quand il le faut.

Aristote remarquait déjà que la donnée brute ne suffit pas et si la sensation (aisthesis) perçoit la réalité, elle doit passer par le langage, la raison, la réflexion, le syllogisme, pour atteindre la compréhension (kataleptikon), passer de l'induction à la déduction. Pour cela la connaissance sensible (animale) plus ou moins incertaine doit pouvoir la classer, la catégoriser et l'ordonner dans une suite de causes (récit). Le problème de l'intuition comme des réseaux de neurones du deep learning, c'est effectivement d'être des boîtes noires impénétrables. Pour rendre compte de ses décisions, il faut un autre réseau (generative adversarial network) testant ses résultats pour l'expliciter, en reconstruire les raisons. La seule façon d'avoir accès à son intériorité et pouvoir communiquer un savoir, c'est de passer par un langage commun et ses catégories (oppositions signifiantes qui divisent les signifiés), passer par la verbalisation et sa rationalisation qui joue comme un système adverse essayant de reconstruire la décision déjà prise par l'intuition, de la reproduire par un enchaînement de raisons explicites, de savoirs, d'abstractions, combinant le bottom-up intuitif avec le top-down analytique, logique indispensable pour valider les "intuitions" (ou idées préconçues de l'IA). Il faut pour Aristote la complémentarité de ces deux systèmes, celui de l'intuition intellectuelle (noesis) ou de la perception, et celui de la catégorisation (logos), systèmes qui se corrigent l'un l'autre mais visent le même objet ("τῆς δὲ ψυχῆς τὸ αἰσθητικὸν καὶ τὸ ἐπιστημονικὸν δυνάμει ταὐτά ἐστι, τὸ μὲν <τὸ> ἐπιστητὸν τὸ δὲ <τὸ> αἰσθητόν". Dans l'âme, le principe qui sent et le principe qui sait visent en puissance les mêmes objets : ici, l'objet qui est su, et là, l'objet qui est senti). Si cela reste vrai, il faut répéter que le résultat déjà obtenu par ChatGPT montre cependant qu'on peut s'en passer dans une bien plus large mesure qu'on ne pouvait le supposer pour un "animal rationnel", un Homo sapiens qui est tout autant un Homo demens !

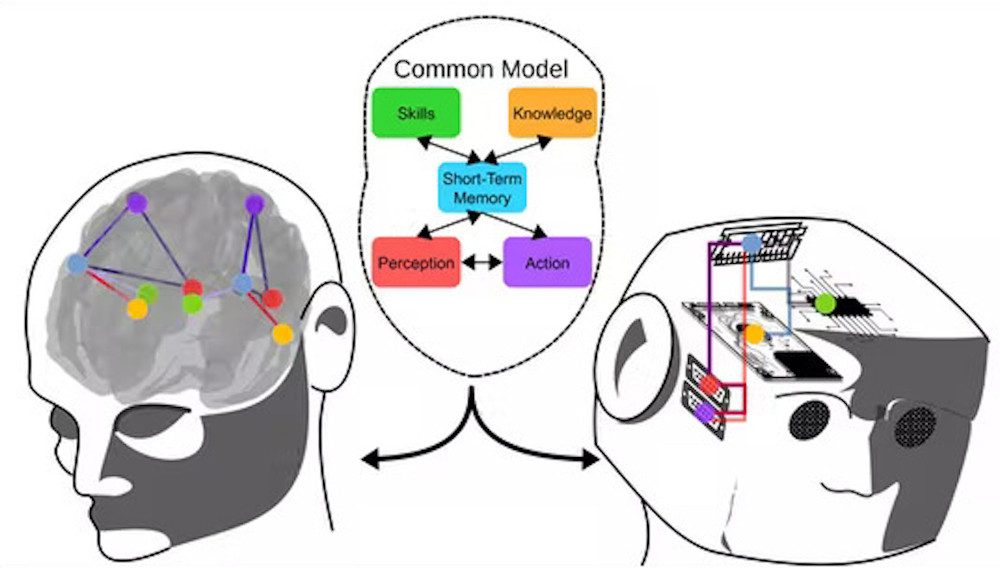

Ce dualisme, entre perception corporelle ou langagière (d'un vivant situé) et raison universelle communicable, implique que la pensée est diverse, divisée, et ne se réduit donc pas à la sensation mais il faut concevoir l'intelligence comme un appareil à plusieurs étages, plutôt que différentes parties séparées, comportant des fonctions multiples qui s'interpénètrent (intuition, imagination, mise en récit, abstraction, opinion, argumentation ou, pour Aristote, intellect patient, intellect agent, intellect pratique). Ce nouvel appareil psychique plus conforme au fonctionnement de notre cerveau devient explicite en étant reconstruit artificiellement (verum ipsum factum disait Vico), ce qui le rend difficilement réfutable par les spiritualistes (tout comme la vie artificielle). Bien sûr, on ne peut dire pour autant qu'on aurait tout compris de l'esprit, on n'est qu'au tout début d'une ère nouvelle où les progrès s'accélèrent, mais, ce qui est sûr, c'est que le mystère s'est dissipé, un peu comme pour l'origine de la vie qui ne fait plus grand mystère bien qu'on en ignore le détail et de nombreuses étapes.

C'est fâcheux pour tous les obscurantismes, il y a de quoi révolter tous ceux qui ont une haute opinion d'eux-mêmes, jusqu'à se croire fils de dieu, et cela ne devrait pas être sans effets bien que l'inertie idéologique soit considérable. La vitesse à laquelle cette révélation pénétrera les "esprits" est difficile à évaluer, notamment pour les "sous-développés" (car l'intelligence artificielle donne une objectivité cognitive au développement technologique). Tout ce qu'on peut dire, c'est que ce qui pouvait se compter en millénaires devrait avec les réseaux numériques et les progrès des intelligences artificielles avoir des effets beaucoup plus immédiats, l'avenir dira. A part ça, le désir de reconnaissance, désir de désir, reste aussi fort, la compétition fait toujours rage, instrument d'une évolution qui continue son oeuvre. Il y aura sans aucun doute toujours besoin de notre intervention, de notre travail, de notre activité anti-entropique ou sociale, mais il faudra s'y résoudre, notre humanité ne sera plus tant dans notre intelligence que dans nos besoins vitaux, écologiques, et notre rapport aux autres, conscience morale inchangée (puisque ce sont les lois de la parole et de la réciprocité) liée à notre histoire individuelle, à notre part de liberté (de choix) et au récit de soi, toutes choses qui manquent aux IA dématérialisées mais qui pourront peut-être plus tard s'incarner dans des robots mobiles ?

C'est peut-être cela qui va signer notre entrée dans le 3ème millénaire, que ça plaise ou non, le triomphe d'un progressisme scientifique, vérifié, qui n'est pas un choc des civilisations et de leurs mythes incompatibles, mais la réfutation de leurs histoires fantastiques (religieuses, culturelles, nationales). L'Occident n'est pas une nouvelle civilisation au même titre que les civilisations traditionnelles mais la réfutation de leurs traditions (patriarcales) au nom de la science. Cet Occident décadent et désenchanté n'est que le produit de la Science et du Droit universels qui gagnent tout autant les pays asiatiques alors que ni le mensonge ni l'erreur ni aucun mythe aussi grandiose soit-il ne sont universalisables. Tous les arriérés (y compris les "chrétiens") qui croient que leur monde existe toujours, sont prêts à toutes les extrémités pour revenir en arrière et s'opposer aux forces de progrès mais impossible de faire revivre le passé déjà mort et ses mythologies trompeuses, il nous faut entrer dans le troisième millénaire, celui de l'unification planétaire, de la transition écologique, des sciences, du droit (du féminisme) et du numérique, notamment donc de l'intelligence artificielle, qui transforment profondément le monde sans nous demander notre avis, transformant tout autant notre identité, nos conceptions de l'homme et de l'esprit, reléguant les civilisations précédentes et leurs traditions au folklore local.

Maintenant, sans un soulèvement de la jeunesse mondiale connectée (encore très improbable), la disparition des anciens repères peut mener au pire dans cette période intermédiaire où les empires ne veulent pas mourir ni les dictateurs se soumettre aux lois internationales ou à l'ONU, ni les croyants abandonner leurs chimères immémoriales et leurs persécutions des déviants, dans la panique injustifiée d'y perdre toute moralité. Ce n'est qu'un nouvel accroc à notre narcissisme, perdus dans l'immensité de l'univers qui se moque bien de nous. Si les risques n'étaient si plausibles, tout cela vaudrait un grand éclat de rire au nez de nos prétentions antérieures...

Tout à la joie de notre commun secret

Qui est de savoir en tout lieu

Qu'il n'est pas de mystère en ce monde

Et que toute chose vaut la peine d'être vécu.

Fernando Pessoa, L'enfant nouveau

Un article paru quelques jours après permet de préciser le rôle de l'intention (n'étant plus, comme on l'a vu, nécessaire à la parole) et de l'habitude (répétition) qui s'y substitue.

Effectivement, l'intentionalité de la phénoménologie ne suppose aucune intention consciente, seulement un regard qui vise son objet (ce que l'IA appelle focalisation sur les saillances ou les mots importants), une tension plus qu'une intention, ce pourquoi j'écris toujours, comme aux débuts de la phénoménologie, l'intentionalité de la phénoménologie avec un seul n alors que la véritable intentionnalité, consciente, est la même chose que la réflexivité puisque posant un objectif volontaire et corrigeant le tir pour l'atteindre, ce qui est tout autre chose que la constitution de l'objet ou le remplissement de la représentation par la vision effective.

Par contre, quand le comportement est répété, l'intentionnalité n'est plus requise, passant le relais à l'habitude devenue simple automatisme réflexe réagissant au feedback sans passer par la conscience, au même titre que l'intuition. On voit donc le jeu de ces deux processus, revenant toujours au mécanisme d'apprentissage des réseau de neurones qui n'est supervisé que ponctuellement, de façon discontinue, par la conscience langagière et sa rationalité.

https://theconversation.com/we-make-thousands-of-unconscious-decisions-every-day-heres-how-your-brain-copes-with-that-201379

Yann LeCun lance une nouvelle architecture appelée I-JEPA (Image Joint Embedding Predictive Architecture) qui, cette fois, construit un modèle interne du monde extérieur, se situant à un niveau d'abstraction supérieur et moins susceptible d'erreurs grossières.

https://intelligence-artificielle.developpez.com/actu/345580/I-JEPA-le-premier-modele-d-IA-base-sur-la-vision-de-Yann-LeCun-le-scientifique-en-chef-de-Meta-specialise-dans-l-IA-pour-une-IA-plus-proche-de-l-humain/