- La théorie de l'information

- La synchronisation des neurones

- Des hivers plus rigoureux

- L'illusion de la fin de l'histoire

- Réconcilier physique classique et quantique

- La gravitation comme phénomène émergent

- Des températures négatives

- Influence des cycles solaires sur le climat

- Une source naturelle de destruction de l'ozone

- Détruire les cirrus pour réduire l'effet de serre

- La fonte des glaces pourrait refroidir la mer et le climat

- Un lampadaire qui absorbe le CO2

- 21 exemples de maisons autonomes

- Le gène généreux

- La durée de vie en formule

- L'équilibre entre cancer et reproduction

- Différences entre chiens et loups

- Le gène des dominants

- La causalité fait partie intégrante de la vision

- Se protéger de la dégradation de l'ADN en vieillissant

- Des ADN à quadruple hélice dans certains cancers

- Le cannabis encouragerait à l'effort !

- Stress et dépression

- Liaison entre la violence et le plomb

- Un traitement contre l'herpès

- Une puce pour décrire les suspects avec leur ADN

- Photomaton fait des cabines ADN

- Un détecteur de mensonge par vidéo

<- Revue des sciences précédente | Revue des sciences suivante ->

Revues : Pour la Science - La Recherche Brèves : Physique - Climat - Biologie - Santé - Technologie

Malgré le réchauffement, nos hivers sont plus froids car la fonte de la banquise arctique change le régime des vents comme on le verra dans Pour la Science. C'est bien sûr un peu compliqué pour nos esprits qui n'aiment rien tant que le simplisme et jugent du long terme par leurs sensations immédiates, s'imaginant de plus tout le temps à la fin de l'histoire ! Plus que jamais, nos limitations cognitives, l'erreur et la bêtise restent bien le coeur de la science, sinon la tromperie. Ainsi, selon une évaluation à la louche, il n'y aurait que 14% d'études médicales douteuses, ce qui est déjà pas mal mais est contesté par beaucoup (des études plus concrètes ont montré que les 2/3 des expériences n'étaient pas reproductibles!). C'est bien à cause de tous ces égarements que seule l'expérimentation reproductible peut trancher dans les sciences expérimentales. Un autre piège serait de céder à l'illusion de l'unanimité à l'origine des décisions absurdes et qu'on trouve dans presque tous les mouvements politiques. "Pour tous ceux qui sont convaincus de la supériorité de la décision collective sur l’autocratie, le livre de Christian Morel vient rappeler que la démocratie n’est pas seulement une affaire de justice mais aussi d’intelligence". Or, justement, les sciences vont souvent contre les préjugés majoritaires, leur justesse n'étant pas décidée par vote démocratique. C'est sur quoi s’appuient d'ailleurs climato-sceptiques et théories du complot pour nous refiler leur pauvres certitudes. Se distinguer de l'opinion majoritaire n'est en rien la preuve qu'on serait dans le vrai et qu'on ne délirerait pas plutôt. Nos limites se manifestent aussi dans la véritable schizophrénie qu'on peut constater entre la reconnaissance par les gouvernants des dangers du réchauffement (avec toutes ses incertitudes) et l'encouragement à l'exploitation de tous les hydrocarbures sous toutes leurs formes ! Certains prédisent d'ailleurs l'éclatement de la bulle des gaz de schiste alors que la dernière mode est à l'exploitation du grisou ou gaz de houille, certes moins polluant mais qui reste une énergie fossile de plus qui finira dans l'atmosphère. Avec tout cela, les investissements mondiaux dans les énergies vertes chutent de 11 % en 2012. A cette allure, il faudra recourir sans aucun doute à des expédients comme la destruction des cirrus pour réduire l'effet de serre ! Dans les mauvaises nouvelles, on pourrait ajouter que, pour la première fois, l'espérance de vie pour les femmes diminue (un peu, de 0,2 ans). Rien qui puisse inciter à l'optimisme sauf de constater comme, malgré tout, les questions écologiques continuent à s'imposer et ne s'évaporent pas dans la finance. On est sur la mauvaise pente sans que ce soit la déroute totale encore. On ne peut exclure qu'on sorte d'un darwinisme primitif dont se réclamaient jusqu'ici les anglo-saxons mais qui commence à évoluer en donnant une plus grande place à la coopération et la sélection de groupe en même temps que se met en place l'ébauche de régulations globales contre les crises systémiques.

Prenant acte de la tendance à multiplier les interfaces numériques (commandes vocales, gestuelles, tactiles, etc.), Intel en propose une synthèse intégrée avec ce qu'ils appellent “perceptual computing”. En attendant Ubuntu, les premiers téléphones fonctionnant sous Firefox OS viennent de sortir (faisant le pari que le web et l'HTML5 remplaceront les applications). Il y a aussi une base de donnée du web en open source désormais pour qui voudrait concurrencer Google ou tester de nouveaux algorithmes. Ray Kurzweil, le théoricien de la singularité vient d'ailleurs d'être embauché par Google pour tirer le maximum de ces big data détenues par Google mais pour le mathématicien Samuel Arbesman, plus que les Big Data, nous devrions porter attention aux Long Data, aux données qui permettent d’avoir un large balayage historique. Pourquoi ? Parce qu’elles nous permettent non pas d’avoir un instantané, mais de voir les processus et interactions qui se déroulent au fil du temps. Ces outils peuvent constituer cependant des atteintes à la vie privée, tout comme on a dénoncé l'indiscrétion du Graph Search de Facebook. Parmi les joyeusetés qu'on nous annonce, il y a ces détecteurs de mensonge par vidéo qui pourraient se généraliser tout comme ces photomatons pour analyse de l'ADN. Sinon, le e-learning est sûrement la prochaine révolution, déjà effective dans l'apprentissage des langues (en 34 heures disent-ils) avec Duolingo, sans parler des cours en ligne des universités américaines, ce qui devrait impacter gravement les systèmes d'enseignement. C'est un peu l'équivalent de la deuxième vague de la robotique à laquelle on assiste, le retard de la France en ce domaine constituant un facteur important de notre perte de compétitivité (il faut rappeler cependant que le chômage est causé par la rigueur plus que par la technologie et que le papy boom va finir par arriver malgré le recul de l'âge de la retraite!). Enfin, si, comme on l'avait déjà annoncé, les drones doivent se multiplier aussi, il ne faudra pas s'étonner si les armées en perdent le monopole et qu'ils soient bientôt utilisés par les terroristes eux-mêmes...

Pour la Science no 424, L'information

- La théorie de l'information existe-telle ?, p18

Jérôme Segal

La théorie de l'information reste, à l'heure actuelle, un édifice inachevé et hétéroclite.

Une science de l'information est née dans les années 1940 de travaux réalisés dans trois domaines différents : la physique, la statistique et les télécommunications.

Elle a été appliquée à de nombreuses disciplines, notamment à la biologie où le besoin d'un renouveau, voire d'une refondation de la théorie, se fait aujourd'hui ressentir.

Le concept d'information, par sa généralité apparente, a séduit de nombreux penseurs, mais a aussi donné lieu à des interprétations abusives.

En physique, la notion d'information est apparue avec le démon de Maxwell supposé inverser l'entropie en séparant les atomes en fonction de leur vitesse. En statistique, il s'agit d'extraire l'information pertinente d'une masse de données (souci qu'on retrouvera dans la compression des données ou la cryptographie). Pour les télécommunications, l'information définit la bande passante et se distingue du bruit comme une redondance improbable (l'inverse là aussi de l'entropie).

La cybernétique est née de la deuxième guerre mondiale pour la correction de tir des défenses anti-aériennes en analogie avec les systèmes biologiques (boucles de rétroaction ou feedback, déjà connues en régulation thermodynamique avec les thermostats) et faisant pénétrer ainsi la notion d'information en biologie (ADN). Une des applications principales dans les communications en sera la correction d'erreurs (validant l'information reçue) qu'on retrouvera à la base des organismes vivants. Il est dommage que ne soit pas évoquée la théorie des système avec ses flux de matière, d'énergie et d'information, indissolublement liée à la cybernétique comme gouvernance pour atteindre ses fins (direction par objectifs).

L'article de Jérôme Segal ne nous apprendra rien ici, confirmant plutôt notre avance sur ces questions. Il a cependant raison de dénoncer l'inconsistance de certaines utilisations du concept d'information et de se focaliser sur le caractère anti-entropique de l'information comme de la cybernétique qui en procède, mettant bien le numérique en continuité du vivant à l'opposé de ses critiques superficielles.

Un encadré sur les dérives de la cybernétique se limite à citer le rôle du scientologue Ron Hubbard, de la secte Moon, voire des Raëliens mais prétend aussi qu'elle était devenue religion d'Etat en RDA après une époque de rejet. Pourtant les dérives de la cybernétique ont été bien au-delà, et d'abord critiquées par les cybernéticiens eux-mêmes avec les théories de l'auto-organisation (cybernétique de second ordre) qui mèneront également à des dérives dogmatiques, celles du néolibéralisme avec des marchés prétendus auto-régulés. La réflexion sur ces sujets est d'autant plus pauvre que ceux qui se sont institués les critiques de la cybernétique sont tombés dans une telle caricature (de Heidegger ou Anders à tant d'autres scrivailleurs) qu'ils ont réussi à faire presque disparaître le mot alors même que la chose se généralisait avec le "cyberspace".

J'en profite pour dire que sa thèse de doctorat qu'il avait mise en ligne avant d'en faire un livre (dont la couverture illustrait mon article "Pour une philosophie de l’information") m'a été très utile lorsque j'ai travaillé sur le concept d'information pour éclaircir une notion qui restait trop indéfinie, entre autres dans son utilisation par Jacques Robin. Le fait qu'il ait supprimé cet accès public si pratique avec l'illusion qu'ainsi il vendrait plus de livres, montre toute l'absurdité et les contradictions de ces logiques marchandes pour le partage des connaissances. Ce n'est pas que son contenu soit en quoi que ce soit indispensable, l'approche de Jérôme Segal restant très scolaire et ne s'élevant jamais au concept, mais s'il ne va pas plus loin que le résumé des thèses de chaque auteur et se contente d'en faire l'histoire, cela reste néanmoins d'autant plus utile que la plupart des livres dont il parle sont épuisés et paradoxalement inaccessibles à l'ère de l'information !

Pour ma part, je peux renvoyer à mon récent "Pour une philosophie de l’information" cité plus haut mais surtout, bien sûr, au livre Le monde de l'information (2004) qu'on peut compléter par "L'improbable miracle d'exister" (2002) qui l'a précédé et "De l’entropie à l’écologie".

Quelques autres de mes textes sur le sujet :

- Le concept d'information (2003)

- L'ère de l'information (2004)

- L'entropie, l'énergie et l'information (2004)

- Théorie de l'information, physique et biologie (2002)

- Information et finalité en biologie (2003)

- L'enjeu politique de la théorie de l'information (2002)

- Une nouvelle vie pour l'ADN ancien, p26

On est très loin de pouvoir cloner un mammouth mais on arrive à reconstituer quelques protéines d'animaux disparus à partir de fragments d'ADN et d'identifier leur fonction. Il ne s'agit pour l'instant que de quelques traits comme la couleur de la peau ou des poils et la structure de l'hémoglobine mais on peut déjà en comprendre le caractère adaptatif (contre le froid pour les mammouths laineux).

- Le langage des neurones, p50

La communication cérébrale repose sur une chronologie précise des signaux électriques transmis d'un neurone à l'autre.

La façon dont le cerveau extrait des informations de l'ensemble des signaux qui le parcourent est mal comprise. Cependant, avec d'autres scientifiques, nous avons récemment montré comment le cerveau tire parti de la chronologie précise des potentiels d'action pour coder l'information, ce qui permet de traiter des problèmes difficiles en un temps record. En effet, des assemblées de neurones synchrones transfèrent beaucoup plus efficacement l'information qu'une même cohorte de neurones désorganisés temporellement (mode asynchrone).

Les cellules ganglionnaires de la rétine, par exemple, sont sensibles à l'intensité lumineuse et répondent à une scène visuelle changeante en transmettant des potentiels d'action à diverses parties du cerveau. Chaque cellule ganglionnaire peut être activée par une caractéristique physique particulière d'un objet (par exemple, sa couleur ou son orientation). Lorsque plusieurs d'entre elles sont activées de façon quasi simultanée, le cerveau interprète cette simultanéité comme le signe de la détection d'un attribut particulier du même objet. Horace Barlow, de l'Université de Cambridge, qualifie ces activations simultanées de « coïncidences suspectes ».

Les neurones corticaux qui reçoivent les signaux d'entrée visuels ont aussi des interactions excitatrices et inhibitrices avec d'autres neurones corticaux. Un grand nombre de ces derniers, distants les uns des autres, s'activent spontanément et périodiquement, à des fréquences inférieures à 100 hertz. Cela permettrait de coordonner les multiples neurones responsables de la perception visuelle.

L'attention, facette essentielle de la cognition, serait aussi fondée sur des séquences de potentiels d'action synchronisés. Celles-ci renforceraient l'importance d'une perception ou d'un souvenir atteignant la conscience.

Outre l'attention, la mémoire dépendrait aussi de la synchronie des impulsions. Lors de l'enregistrement des souvenirs, la chronologie relative des potentiels d'action semble être aussi importante que la fréquence d'activation. En particulier, l'émission synchronisée de potentiels d'action dans le cortex renforce les synapses (c'est-à-dire augmente l'intensité de la réponse du neurone postsynaptique à un potentiel d'action), ce qui est essentiel pour la mémoire à long terme.

Il y a justement une nouvelle découverte mettant en évidence que ces communications utilisent différentes fréquences permettant de distinguer différents types d'information (de lieu ou de temps par exemple).

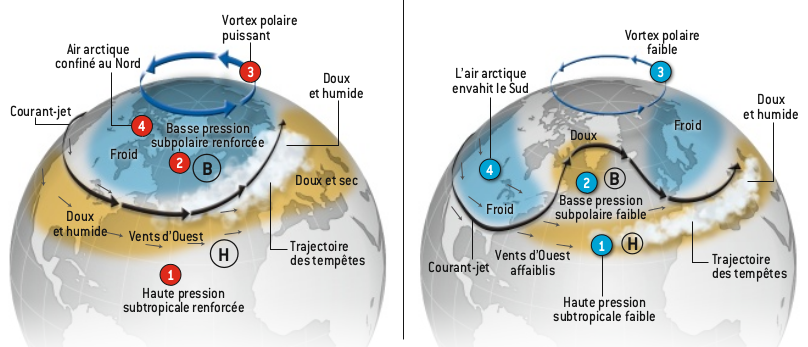

- Des hivers plus rigoureux, p62

Comment expliquer de tels épisodes de froid au cours d'une décennie 2002-2012 qui fut par ailleurs la plus chaude de ces 160 dernières années, depuis le début du suivi des températures globales ? Certains scientifiques semblent avoir trouvé une réponse surprenante avec un phénomène qui se déroule plusieurs mois avant l'hiver et dans une région différente de celle où sévissent les hivers rigoureux en question : les fontes record subies par la banquise de l'océan Arctique au cours de l'été précédent.

Les climatologues ont observé que ces hivers froids et neigeux pouvaient être associés à deux variations naturelles du climat qu'on nomme aujourd'hui l'oscillation arctique, OA, et l'oscillation nord-atlantique, NAO (pour North Atlantic Oscillation).

Une hausse de la pression atmosphérique arctique et une diminution du gradient de température favorisaient le développement de conditions OA et NAO négatives au cours de l'hiver. Cette situation affaiblirait le vortex polaire et le courant-jet, qui deviendraient moins efficaces pour empêcher les masses d'air arctique froides, avec leur teneur en eau élevée, de s'étendre vers les latitudes moyennes et d'y apporter des épisodes de froid intense et de chutes de neige importantes. De surcroît, un courant-jet affaibli présenterait une trajectoire plus ondulante, et pourrait ainsi enfermer certaines régions dans un régime froid pendant une durée importante. Combinés, ces motifs perturbés de circulation atmosphérique tendraient à provoquer des épisodes de froid hivernal plus fréquents et plus longs en Amérique du Nord et en Europe.

Pour l'hiver 2012-2013, les conditions semblent propices à des vagues de froid en Amérique du Nord et en Europe. La fonte record de la banquise arctique observée durant l'été 2012 devrait renforcer la probabilité que des masses d'air arctique froid envahissent les latitudes moyennes.

Il faut ajouter, comme on le verra plus bas, que la fonte des glaces refroidit la mer et donc les pays côtiers. Pour l'instant, le froid a été relativement modéré mais le mois de février est souvent le plus froid avec son Moscou-Paris !

- L'illusion de la fin de l'histoire, p12

Science&Vie a fait un zoom sur les "biais cognitif" selon Daniel Kahneman et sur lesquels nous reviendrons dans un article séparé mais parmi les limitations de notre pensée, il faut mettre l'impossibilité de penser notre propre évolution et de se projeter dans un avenir qui ne soit pas la réplique du présent.

Avez-vous beaucoup changé au cours des dix dernières années? Changerez-vous beaucoup lors des dix prochaines ? Selon Jordi Quoidbach, de l’Université Harvard, aux États-Unis, et ses collègues, vous répondrez le plus souvent oui à la première question, et non à la seconde – et ce quel que soit votre âge. En d’autres termes, on a toujours l’impression que sa personnalité, ses valeurs et ses goûts ont fini d’évoluer au moment présent, ce que les chercheurs qualifient « d’illusion de la fin de l’histoire ». Leur conclusion : on sous-estime systématiquement les changements à venir.

C'est à la fois évident et très important de se rendre compte qu'on se situe toujours à la fin de l'histoire (comme je le disais en introduction à un article sur un livre de Robert Bonnaud qui vient de mourir "nous devons toujours donner un sens à cette histoire, considérée comme finie, mettre en acte ce qu'elle nous enseigne. On a toujours une vision du monde, une compréhension de l'Etre, une clôture du sens commun avant toute possibilité de réflexion, de même que nous devons donner sens à chaque fin de phrase tout en sachant que ce sens sera de nouveau mis en cause par les phrases suivantes. On ne peut rester dans le suspens du sens"). Il est à chaque moment impossible de savoir comment la vie nous transformera et ce qu'on va apprendre qu'on ne sait pas encore. Ceci dit, avec le temps, la difficulté d'intégrer de nouvelles informations viendrait de la difficulté à se débarrasser de ses anciennes croyances.

- Comment Homo devint Faber, François Sigaul, p95

L’homme a fait l’outil, mais l’outil fait l’homme. L’auteur récemment disparu, anthropologue des techniques à l’ehess, livre sa réflexion sur le rôle de l’outil dans notre évolution, proposant d’abord de grandes catégories de techniques – les techniques à mains nues ou à mains outillées –, puis d’outils – les outils imitant la main ou originaux ; puis il discute de la notion de partage de l’attention entre fins et moyens qui caractérise l’emploi de l’outil par un homme, et de celle de partage de plaisir, qui a pu jouer un rôle essentiel dans notre évolution, en particulier sociale.

- Penser l'évolution, Hervé Le Guyader, p95

- Penser l'évolution, Hervé Le Guyader, p95

Cette quête de la nature du génotype et de ses relations au phénotype comme à l'environnement vient selon lui de culminer dans la mise en évidence précise d’une boucle autoréférente assurant la régulation de l’expression d’un gène bactérien, qui jouerait en biologie le rôle historique de l’atome d’hydrogène en physique.

- Les lieux des erreurs scientifiques, Girolamo Ramunni, p95

G. Ramunni estime que se tourner vers les erreurs du passé permet de se défaire d’une idéalisation de l’entreprise scientifique encore trop présente de nos jours. Comme il le montre dans de courts récits, l’analyse d’erreurs scientifiques permet de comprendre à quel point les savants sont ancrés dans une culture, une époque et parfois même un lieu.

G. Ramunni estime que se tourner vers les erreurs du passé permet de se défaire d’une idéalisation de l’entreprise scientifique encore trop présente de nos jours. Comme il le montre dans de courts récits, l’analyse d’erreurs scientifiques permet de comprendre à quel point les savants sont ancrés dans une culture, une époque et parfois même un lieu.

J'ajouterais bien que, ce qui fait de l'erreur l'objet même de l'attention, c'est l'informatique, aussi bien dans son versant programmation qu'utilisation, et qui atteint définitivement le narcissisme cognitif en faisant éprouver toutes les limites de notre rationalité, bien loin d'une supposée essence divine.

La Recherche no 472, Climat

Le dossier sur le climat est un peu décevant mais a l'avantage de remettre au premier plan la lutte contre le réchauffement climatique et notamment les émissions de méthane trop négligées (notamment avec les gaz de schistes dont on avait vu qu'ils dégageaient de grandes quantités de méthane dans l'atmosphère). On nous explique aussi que la modélisation du climat procède par un maillage tridimensionnel (de tailles variables) et le calcul de l'état de la planète par périodes de 30mn. La pause dans le réchauffement des 10 dernières années est expliquée par les éruptions volcaniques (notamment du Merapi en 2010), par la pollution asiatique (charbon), par un biais de calcul ne prenant pas assez en compte les pôles, par le phénomène El Nino (il faudrait plutôt parler d'oscillation océanique?), et, plus étonnant, les cycles solaires dont l'incidence est pourtant minime (seulement dans l'ultra-violet alors que des orages de rayons cosmiques pourraient avoir une influence significative quoique de courte durée mais suffisante pour avoir provoqué quelques famines).

On n'insiste pas assez cependant sur l'incertitude qui ne tient pas seulement à la difficulté de détermination d'une "sensibilité climatique" trop linéaire, l'amplitude des effets pouvant franchir un seuil et provoquer un emballement, mais qui tient avant tout à l'intervention de causes extérieures parmi lesquelles on doit compter en premier lieu l'ampleur de notre réaction. Seulement, le volcanisme qui ne dépend pas de nous pourrait tout autant changer radicalement la donne. Une chute d'astéroïde pourrait avoir un effet encore plus dévastateur mais on aurait les moyens de l'éviter cette fois ? L'hypothèse d'une réduction drastique de la population mondiale par un virus foudroyant n'est pas si improbable qu'on le croit, toutes les conditions de promiscuité et de mobilité étant réunies pour que les virus jouent leur rôle régulateur, ce qu'on pourrait d'ailleurs provoquer nous-mêmes avec les moyens de biotechnologies qui pourraient tout autant nous en sauver...

A signaler aussi un dossier sur le recyclage et l'économie circulaire (prenant en compte le recyclage dès la conception), les déchets étant considérés comme une source de richesse (pour récupérer le méthane de leur décomposition ou récupérer les métaux). Une étude de la fondation Ellen MacArthur prétend d'ailleurs que l'économie circulaire pourrait économiser 700 milliards de dollars sur les matériaux.

Enfin, assez étonnant, on apprend p24 qu'un rat rendu addict à la cocaïne transmettrait à sa descendance par épigénétique une certaine protection à l'addiction (ou ce serait de voir la déchéance du père servant de repoussoir qui guérit les jeunes ?). Cela pourrait être le même mécanisme épigénétique que pour la transmission du stress du père réduisant au silence certains gènes des spermatozoïdes.

Brèves et liens

Physique

cosmologie, astronomie, physique quantique, nanotechnologies

- Réconcilier physique classique et quantique ?

En fait, il s'agit d'abord de déterminer le socle commun de théories différentes, méthode pouvant mener à des découvertes et, dans le cas des théories physiques, il s'avère que la principale différence entre classique et quantique, c'est le caractère commutatif ou nom des opérations. Dans la physique classique l'ordre n'importe pas et peut être inversé, ce qui n'est pas le cas de la physique quantique.

- La flèche du temps serait locale

Les formules de la physique quantique impliquent une direction du temps (celle de la décohérence) qu'on identifie à la direction du temps de la thermodynamique mais les auteurs prétendent que ces directions temporelles ne seraient pas unifiées au niveau global et pourraient pointer dans des directions différentes. Dès lors, l'univers pourrait être symétrique au niveau global (d'un univers rebond).

Les formules de la physique quantique impliquent une direction du temps (celle de la décohérence) qu'on identifie à la direction du temps de la thermodynamique mais les auteurs prétendent que ces directions temporelles ne seraient pas unifiées au niveau global et pourraient pointer dans des directions différentes. Dès lors, l'univers pourrait être symétrique au niveau global (d'un univers rebond).

J'ai du mal à prendre au sérieux qu'il y aurait plusieurs temps. On avait vu au contraire le mois dernier que l'existence d'une seule dimension de temps semblait même la caractéristique principale de notre espace-temps, le nombre de dimensions d'espace étant plus fluctuant.

- Le refroidissement de l'univers conforme au Big Bang

Les ondes radio (lignes jaunes) provenant d'un quasar lointain passent à travers une galaxie où elles sont absorbées par des molécules dans un nuage de gaz froid. Les astronomes ont utilisé des radiotélescopes pour mesurer la température de l'univers il y a 7,2 milliards d'années, en détectant les signatures des molécules absorbant les ondes radio.

Après calcul, les astrophysiciens ont trouvé que voilà environ 7,2 milliards d'années, la température du rayonnement fossile était de 5,08 ± 0,10 K. C’est la mesure de température la plus précise à ce jour. On constate aussi que cela correspond remarquablement à la prédiction de la théorie du Big Bang.

- La gravitation émergerait comme la température des grands nombres

Verlinde fait une analogie avec la température. Tout le monde voit ce qu'est la température au niveau macroscopique : on peut la ressentir. Maintenant, si on se plonge dans le monde microscopique, il n'y a plus aucune notion fondamentale de température. Il s'agit d'une propriété qui résulte de l'interaction entre ces molécules. C'est une sorte d'énergie moyenne par molécule. Pour Verlinde, la gravitation serait du même tonneau. C'est quelque chose qui apparaîtrait lorsque vous mettez beaucoup d'objets ensemble dans une étude microscopique et cela surgirait des équations.

Verlinde pense qu'une autre approche jetterait un regard différent sur ces concepts d'énergie noire ou de matière sombre. On comprend la gravitation dans la plupart des situations locales, mais lorsque l'on regarde les choses à grande échelle (galaxies), il y a des choses que nos équations habituelles n'expliquent pas, que ce soit avec celles de Newton ou celles d'Einstein. Il n'y a aucune équation contemporaine qui explique ces comportements astronomiques.

- Matière noire et énergie noire viendraient de l'anti-gravité

Il n'est pas sûr que le concept d'anti-gravité ait un sens mais si on imagine une création de particules et anti-particules dans le vide, on pourrait expliquer matière noire et énergie noire par une hypothétique anti-gravité de l'anti-matière. Cette hypothèse pourrait se tester avec l'attraction de Pluton avec sa lune Eris, assez éloignés du soleil pour ne pas être trop perturbés par son attraction gravitationnelle.

Il n'est pas sûr que le concept d'anti-gravité ait un sens mais si on imagine une création de particules et anti-particules dans le vide, on pourrait expliquer matière noire et énergie noire par une hypothétique anti-gravité de l'anti-matière. Cette hypothèse pourrait se tester avec l'attraction de Pluton avec sa lune Eris, assez éloignés du soleil pour ne pas être trop perturbés par son attraction gravitationnelle.

Pour d'autres, tout s'expliquerait par les gravitinos (prévus par les théories de supersymétries que rien n'a confirmé jusqu'ici, pas plus que l'existence des gravitons). Les mathématiques semblent assez convaincantes.

- Détecter les "murs de matière noire"

La matière noire, dont on ne sait rien, pourrait s'être figée en "murs" (pourquoi pas des planètes?) que nous traverserions périodiquement mais impossibles à détecter pour l'instant car leur effet très faible (gravitationnel et peut-être avec la force nucléaire faible) ne peut être distingué du bruit de fond. Une solution serait de disposer de 5 détecteurs disséminés sur toute la Terre pour mettre en évidence une variation synchrone.

- Un programme pour détourner les astéroïdes

Le concept est d'envoyer un astronef de 300 kg lancé à des milliers de km/h et espérer que l'impact soit suffisant pour modifier l'orbite de manière significative. Cela explique le choix d'un astéroïde binaire : un petit astéroïde qui orbite autour d'un plus gros. Le nom du gros morceau est 65803 Didymos et fait 800 mètres de long. Il serait donc potentiellement dangereux pour nous si sa trajectoire croisait celle de la Terre. Pour information, l'astéroïde supposé de l'évènement de Tugunska en 1908 faisait une centaine de mètres de long a priori. Le petit astéroïde fait lui 150 mètres de long.

- Plus de chance de trouver la vie sur des lunes que des planètes

La plupart des planètes étant trop grosses et gazeuses, il y a plus de chance de trouver la vie sur des grosses lunes.

- Des températures négatives plus chaudes que l'infini avec des atomes ultrafroids

Laurent Sacco fait de gros efforts pour nous expliquer cette étrange entropie négative se caractérisant par le fait que sa chaleur ne se communique pas à une source plus froide mais que celle-ci se refroidit encore au contact de cette chaleur...

Il existe cependant une autre façon d’obtenir une notion de température sans la relier directement aux mouvements de particules. En effet, la formulation mathématique des principes de la thermodynamique montre que l’inverse de la température T d’un système physique est défini par la pente de la courbe de son entropie S en fonction de son énergie interne U.

Si l’on met en contact un réservoir de chaleur à une température négative avec un autre, par exemple une bouteille d’hélium liquide, la chaleur va s’écouler du premier réservoir vers le second, donc des températures négatives vers les positives.

Voir aussi Sciences et Avenir et techno-science qui précisent que l'exploit serait d'avoir un plus grand nombre de particules rapides que de particules lentes (un "distribution de Boltzmann inversée").

- Transformer la chaleur en son

En réduisant la fréquence de l'agitation thermique, on pourrait manipuler la chaleur comme le son, la rendre directionnelle ou la transformer en électricité.

- Un revêtement qui déforme la perception

Au lieu de viser une invisibilité encore trop imparfaite et coûteuse, ce méta-matériau donne une image déformée d'un objet, pouvant transformer ainsi une pomme en banane !

La lumière est diffusée symétriquement sur les deux côtés de la pomme -on peut dire que cela produit deux "fantômes" de banane, un de chaque côté de la pomme. Cette technique ne supprime pas la perception de la pomme mais elle la déforme.

- Le plus petit moteur dont on puisse contrôler le sens de rotation

De seulement 2 nanomètres de diamètre, le rotor de ce moteur est mis en mouvement grâce aux électrons délivrés par la pointe d'un microscope à effet tunnel.

Le nano-moteur est composé de trois parties. La première constitue le stator du moteur qui permet de l'accrocher à une surface d'or. Au bout de celui-ci, se trouve un atome métallique, du ruthénium, qui joue le rôle de rotule sur laquelle vient se fixer le rotor moléculaire. Ce dernier est constitué de cinq pales dont une a été volontairement raccourcie pour suivre le sens de rotation du rotor. Au total, seulement 200 atomes constituent le moteur. Pas moins de 15 étapes ont été nécessaires pour la synthèse de cette molécule complexe. Sa conception et synthèse ont demandé près de 10 ans d'efforts aux chercheurs du CEMES.

En plaçant la molécule à une température de –268,5°C (4,6°C au-dessus du zéro absolu) sur la surface d'or, les chercheurs sont parvenus à déclencher le mouvement pas à pas du rotor et à en contrôler le sens de rotation. Pour cela, ils lui ont délivré des électrons grâce à la pointe d'un microscope à effet tunnel qui sert à la fois d'instrument d'observation et de source d'énergie. Le sens de rotation dépend de la pale du rotor où est positionnée l'extrémité de la pointe du microscope. La précision dans le pointage doit être de l'ordre du dixième de nanomètre.

Voir aussi Futura-Sciences. Cependant, les meilleurs nano-moteurs sont des enzymes pouvant être fabriquées dans des bactéries.

- Faire des catalyseurs sur mesure

Les nanotechnologies permettraient de concevoir et fabriquer des catalyseurs plus efficaces en ajustant leur composition et leur taille.

- Des nanoparticules de silicium qui produisent de l'hydrogène

Sans avoir besoin de lumière, de chaleur ou d'électricité, ces nanoparticules réagissent à l'eau pour donner de l'acide silicique avec un dégagement rapide d'hydrogène, ce qui en ferait une sorte de pile à hydrogène.

- Des cristaux obtenus par auto-assemblage

Ou plutôt, c'est l'application de champs électro-magnétiques à partir de 4 électrodes qui permet de manipuler ces particules colloïdales de taille micrométrique.

Une fois la taille de cristaux désirée atteinte, les forces d'attraction des particules stabilisent la structure. Une composante importante de ce travail est l'utilisation d'un ordinateur basé servant de système de rétroaction visuel en temps réel pour ajuster dynamiquement courant alternatif et courant continu pour automatiser le processus d'assemblage.

Il y a aussi un auto-assemblage de nanoparticules de silicium en micro-câbles de silicium pouvant remplacer avantageusement des fibres optiques.

Des molécules de graphène attachés à des atomes de zinc pourraient servir de bits numérique, multipliant par 1000 la densité de l'information.

- Lire des qubits sans les détruire

C'est un gel oscillant qui se reconstitue si on le coupe mais surtout réagit à la lumière ou à certains produits chimiques en se déplaçant.

C'est un gel oscillant qui se reconstitue si on le coupe mais surtout réagit à la lumière ou à certains produits chimiques en se déplaçant.

Il y a aussi des molécules intelligentes qui changent de forme en présence d'un stimuli externe, ce qui pourrait en faire des nano-commutateurs.

- Obligation de déclarer les nanoparticules sur le site R-nano.fr

Une réglementation oblige à compter du 1er janvier 2013, pour l'ensemble des fabricants, distributeurs ou importateurs de déclarer les usages de substances à l'état nanoparticulaire ainsi que les quantités annuelles produites, importées et distribuées sur le territoire français. Cette déclaration est annuelle et sera réalisée par voie électronique sur un site Internet dédié et sécurisé: https://www.r-nano.fr.

Climat

Climat, énergies, écologie

- Influence des cycles solaires sur le climat

Durant les pics d'activité solaire, l'étoile émet 10 fois plus d'ultraviolets qu'en moyenne. Les émissions dans cette bande spectrale en particulier peuvent fortement affecter la chimie et la température de l'atmosphère.

La couche d'ozone stratosphérique protège la surface terrestre des rayons ultraviolets (ou UV), dangereux pour tout être vivant de notre planète. Les particules énergétiques du Soleil créent des oxydes d'azote qui, émis en masse durant les pics d'activité solaire, peuvent réduire le taux d'ozone de quelques %. Ainsi, lorsque le soleil traverse un pic d'activité, plus de rayons UV atteignent la surface de la Terre et réchauffent l'atmosphère.

Durant un pic d'activité solaire, il se dessine dans le Pacifique une configuration similaire à la phase La Niña du cycle Enso. On trouve un refroidissement de près de 1 °C dans le Pacifique équatorial oriental. En outre, des précipitations accrues sont observées au niveau de la zone de convergence intertropicale (ZCIT), et de la zone de convergence du Pacifique sud (SPCZ). Les signaux du cycle solaire sont tellement forts dans le Pacifique que certains se demandent s'il existe quelque chose dans cette région qui amplifie les signaux de l'activité solaire !

En outre, le rapport stipule que l'effet des variations de l'énergie solaire se manifeste dans des changements de la circulation atmosphérique générale plutôt que sur la température directement.

- Une source naturelle de destruction de l'ozone

À partir d’expériences en laboratoire, ils ont découvert que la réaction dans l’océan faisait intervenir l’ion iodure (I-) et l’ozone, expliquant ainsi 75 % des émissions d’oxyde d'iode à l’interface air-mer, sur l’océan Atlantique. Cette réaction révèle une importante rétroaction négative pour l’ozone. En effet, plus il y a d’ozone, plus les halogènes gazeux se forment pour le détruire.

Le mécanisme de libération d'iode dans l'atmosphère est particulièrement important sur les océans tropicaux, où les mesures montrent qu'il y a plus d'ions iodure disponibles dans l'eau de mer pour réagir avec l'ozone. En outre, le phénomène est plus rapide dans l'eau chaude. La rétroaction négative agit très probablement comme un processus dépolluant sur les villes côtières, détruisant l’ozone troposphérique émis en zone urbaine.

- Détruire les cirrus pour réduire l'effet de serre

Du triiodure de bismuth permettrait de cristalliser ces nuages de haute altitude, les faisant précipiter. Il en faudrait 140 tonnes par an mais si on en met trop, l'effet s'inverse...

L'effet des nuages reste le plus incertain dans les modèles climatiques mais le fait qu'ils puissent reconstituer l'évolution passé du climat me laisse penser que leur effet n'est pas significatif sur le long terme dans une météo changeante, sauf éventuellement les cirrus. Même si agir sur la couverture nuageuse est assez éphémère, et pour autant que le procédé soit fiable ce qui semble rien moins que sûr pour l'instant, cela nous donnerait un moyen de contrôler la température globale en temps réel. Bien sûr il vaudrait mieux ne pas en avoir besoin et prendre au sérieux l'objectif de réduction de nos émissions, mais c'est un fait qu'elles augmentent encore et qu'on semble vouloir brûler jusqu'à la dernière goutte d'hydrocarbure trouvée dans les roches comme au fond des mers.

- En -130 000 le Groenland était 4°C à 8°C plus chaud

Pour autant et de manière surprenante, l'altitude de la calotte, au voisinage de NEEM, n'a baissé que de quelques centaines de mètres sous le niveau actuel. En effet, au début de la période interglaciaire, il y a environ 128 000 ans, elle était 200 mètres plus élevée que le niveau actuel, puis l'épaisseur de la calotte a diminué à un rythme d'en moyenne 6 cm par an. Ensuite, il y a près de 122 000 ans, l'altitude de la surface était environ 130 mètres sous le niveau actuel. L'épaisseur de la calotte est alors restée stable (autour de 2 400 mètres) jusqu'au début de la dernière glaciation, il y a près de 115 000 ans. La calotte du Groenland n'a donc pu contribuer que de 2 mètres aux 4 à 8 mètres de la montée du niveau marin caractéristique de l'Eemien.

Par ailleurs, les chercheurs estiment que le volume de la calotte du Groenland a diminué d'environ 25% en 6 000 ans durant l'Eemien.

Les durées en jeu amènent à relativiser des catastrophes qu'on aura le temps de voir venir.

- La fonte des glaces diminue la réverbération du rayonnement solaire

En Arctique, la glace fond, rajeunit et s’affine. Par conséquent, le rayonnement solaire est moins réfléchi vers l’atmosphère. Des chercheurs viennent de quantifier la part de rayonnement absorbée par la glace plus fine et donc la part de l’énergie transmise sous la banquise.

- La fonte des glaces pourrait refroidir la mer et le climat

Cela pourrait produire aussi des tempêtes hivernales plus fortes.

- La suie participerait 2 fois plus qu'on croyait au réchauffement

La suie aurait un impact deux fois plus important que prévu sur le changement climatique. Son pouvoir de réchauffement serait même supérieur à celui du méthane.

Conséquence directe, les émissions de suie deviendraient le second facteur anthropique agissant le plus sur le réchauffement climatique, juste derrière l’indétrônable CO2. Le méthane a donc été relégué à la troisième place de ce podium. L’impact du carbone noir sur notre climat serait comparable, selon les nouveaux chiffres, à 66 % de celui du gaz carbonique. À noter toutefois que les chercheurs ont tenu compte des effets de toutes les substances émises dans l’atmosphère par un mode de combustion précis (l’utilisation de charbon libère par exemple des sulfures, qui participent quant à eux au refroidissement de notre planète).

Il existe une différence notable entre le CO2 et la suie. Le premier persiste plusieurs décennies dans l’atmosphère, tandis que la seconde n’y subsiste pas plus de 7 à 10 jours. Par conséquent, de nouvelles politiques visant à réduire la libération atmosphérique massive de particules carbonées pourraient avoir des résultats conséquents et surtout rapides sur notre climat. Selon Piers Forster de l’université de Leeds, nous pourrions gagner une vingtaine d’années de répit dans la lutte contre les changements climatiques en cours.

- Les zones urbaines réchauffent l'atmosphère de 1°C

En zone urbaine, le surplus d’émission de chaleur, lié à l’activité humaine, provoque un réchauffement atmosphérique local. Une étude réalisée par le Scripps Institution of Oceanography suggère que les effets locaux altèrent la circulation générale et réchauffent l’atmosphère globale, de près de 1 °C en hiver.

- Les rivières menacées de salinisation

La salinisation des rivières est en train de devenir un problème écologique qui affecte presque toutes les régions du monde. Des eaux de rivières plus salées dérèglent l’équilibre biologique de l’écosystème et menace la santé humaine.

- Des supraconducteurs triplent la production des éoliennes

- Des cellules solaires multicouches d'un rendement de plus de 50%

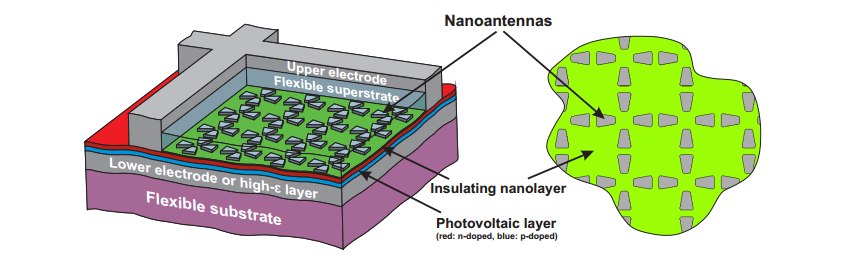

- Des nano-antennes pour piéger la lumière

- Des cellules solaires avec du silicium noir

Le silicium noir réduit à 1% la réflection de la lumière.

- Les cellules souples CIGS deviennent compétitives

C'est en utilisant de l'indium que les performances ont été boostées mais il y a déjà des tensions sur l'indium...

- Des cellules d'un rendement de 70%!

Cette structure exotique de silicium appelée BC8 et comparable au diamant génère de multiples paires trous-électron sous l'influence de la lumière visible (et pas seulement les ultraviolets comme d'autres nanoparticules) avec un rendement de 42% qui peut aller jusqu'à 70% avec concentration de la lumière.

Cette structure exotique de silicium appelée BC8 et comparable au diamant génère de multiples paires trous-électron sous l'influence de la lumière visible (et pas seulement les ultraviolets comme d'autres nanoparticules) avec un rendement de 42% qui peut aller jusqu'à 70% avec concentration de la lumière.

- Le rendement du photovoltaïque supérieur au biofuel

- Une île artificielle (STEP) pour stocker l'énergie

Les autorités belges envisagent de construire un atoll énergétique en mer du Nord. Ce concept innovant repose sur le principe bien connu des stations de transfert d’énergie par pompage.

- Un nouveau design réduirait de 50% la consommation des avions

- Des mini-muscles artificiels produisent de l'électricité

Des chercheurs ont créé des films de polymères spécifiques qui répondent à l'humidité de leur environnement et produisent de l'énergie électrique qui peut être stockées par de petits générateurs.

Ces films de polymère agissent comme des déclencheurs, ou des muscles artificiels, qui s'étendent lorsqu'ils absorbent la lumière et se contractent quand ils la rendent. Ce comportement, qui rappelle la contraction musculaire rapide, fait que les films gonflent et se rétractent continuellement lorsqu'ils sont placés sur une surface humide.

Si les films sont recouverts d'un polymère piézoélectrique, ou qui produit de l'électricité à partir de la pression et du stress, des bouffées électriques sont produites à environ 0,3 hertz, avec un voltage de pointe de 1,0 volt.

- Des batteries au zinc imprimables, ultrafines, souples et bon marché

Issue d'une technique d’impression sur un support en polymère souple, la batterie au zinc mise au point par Imprint Energy est souple et n'est pas plus épaisse que deux cheveux superposés. Elle a également l’avantage d’être très bon marché et non polluante.

En remplaçant le lithium par du zinc, les avantages sont certains. Le lithium habituellement employé reste un matériau coûteux dont les ressources sont limitées. Il nécessite aussi d’être encapsulé car il réagit assez mal au contact de l’eau ou de l’air, ce qui n’est pas le cas du zinc. Lorsque la batterie n’est plus utilisable, le lithium est également très polluant.

On parle d'un coût inférieur à 25 centimes. Contrairement aux batteries souples au lithium, celle au zinc peut être utilisé sans enveloppe isolante, ce qui permet d’exploiter les atouts que lui confère sa finesse.

En revanche, pour le moment, elle n’est capable de délivrer qu’une faible puissance, inférieure à 30 milliampères-heures (mAh), pouvant remplacer les piles-boutons actuelles mais pas d'alimenter des appareils plus gourmands.

- Un lampadaire qui absorbe le CO2

Ce tube fluorescent situé à mi-chemin entre le lampadaire et l’aquarium renferme des micro-algues qui se nourrissent de CO2 et qui rejettent de l’oxygène. L’ingénieur qui a participé à la création des premières fermes marines méditerranéennes dans les années 1980 est désormais persuadé d’avoir trouvé la solution miracle permettant de réaliser une compensation carbone suffisamment efficace pour lutter contre le réchauffement climatique. Un lampadaire d’un volume de 1,5 mètres cubes peut effectivement filtrer et piéger une tonne de CO2 par an, ce qui équivaut à la quantité qu’absorbent 150 à 200 arbres sur la même période.

« Si on en avait partout, l’effet sur le CO2 serait massif. Ca serait plus puissant que les forêts. »

- Récupérer de l'eau avec du coton

JUSQU'A 340% de son poids ! C’est la quantité d’eau que peut récupérer un coton mis au point par des chercheurs.

Pour obtenir ce taux d’absorption, les chercheurs ont enduit de la fibre de coton avec un polymère PNIPAAm qui modifie ses propriétés. A basse température, le coton a une structure semblable à une éponge à l'échelle microscopique et peut absorber l’eau présente dans la brume. En revanche, dès que la température augmente, le matériau devient hydrophobe. Au-dessus de 34°C, sa structure forme une couche complètement fermée. Dans l’intervalle, il libère toute l’eau qu’il a absorbée.

Grâce à cette propriété, ce coton PNIPAAm pourrait être utilisé pour fournir de l'eau dans les zones désertiques ou les régions montagneuses, où l'air est souvent brumeux la nuit.

Les chercheurs envisagent également des applications totalement différentes, comme des tentes de camping qui recueillent l'eau la nuit, ou des vêtements de sport absorbant la transpiration.

Voir aussi Futura-Sciences.

- Il n'y a pas d'intérêt écologique à cesser l'élevage industriel

"Toute mesure destinée à améliorer le bien-être de l'animal a des conséquences économiques et il faut l'assumer", répond le chercheur en illustrant son propos à l'aide de l'exemple suivant: le Québec produit chaque année 165 millions de poulets qui disposent chacun d'une zone d'environ 27 centimètres de côté; si nous augmentions cette zone de 20 %, l'industrie avicole aurait besoin d'une surface de 402 000 mètres carrés de plus, ce qui nécessiterait 140 kilomètres carrés de terrain supplémentaires pour construire ces bâtiments.

Si on laissait vivre ces poulets huit jours de plus, il faudrait un ajout de 14,7 millions de kilos de grains pour les nourrir, ce qui demanderait une augmentation de 31 kilomètres carrés de terres consacrées à la culture de ces grains. Le transport de cette nourriture nécessiterait 38 000 litres d'essence. Cette longévité accrue du poulet entraînerait par ailleurs la production de 377 600 kilos de plus d'azote dus aux déjections animales.

- Le blé et le colza sont des puits à carbone

A l'opposé du maïs et du tournesol.

- Un antibactérien dans les savons et lessives dangereux après traitement chloré

Connu pour être irritant et perturber le système hormonal, le triclosan, un antibactérien est pourtant utilisé dans un grand nombre de produits cosmétiques, lessives, savons et dentifrices.

Ce n’est pas directement le triclosan qui est nocif pour l’environnement. Les eaux usées sont traitées au chlore avant d’être rejetées dans les lacs, et c’est la combinaison des deux qui pose problème. Une fois exposés au Soleil, les dérivés formés du chlore et du triclosan créent à leur tour des polychlorodibenzo-p-dioxines (PCDD). Ces dernières sont hautement toxiques pour la faune et la flore.

- Les nanotubes de carbone appauvrissent l'activité microbienne des sols

- 21 exemples de maisons autonomes

Biologie

évolution, génétique, éthologie, anthropologie, neurologie

- Le gène généreux

Pour un darwinisme coopératif, Joan Roughgarden

Les explications en termes de sélection sexuelle s’inspirent du paradigme du « gène égoïste » où dans la nature tout ne serait que conflit, égoïsme, profit. Contre cette image d’une guerre des sexes généralisée, Roughgarden propose une alternative qu’elle appelle « sélection sociale », mettant en avant le travail d’équipe et la coopération entre les partenaires.

Darwin a commis une erreur dès le départ en mettant l'accent sur la quantité d'accouplements et non sur la quantité de descendants élevés avec succès. Dans le système de sélection sociale, la sélection naturelle résulte des différences dans le succès à maximiser la production des petits.

Je trouve cette dernière citation, tirée de Sciences et Avenir, p98, assez juste et j'ai toujours trouvé absurde l'idée du gène égoïste tout comme celle d'une évolution réduite à l'individu. Il ne s'agit pas de trop gommer pour autant, comme l'auteure le fait, ni la sélection sexuelle impliquant les communications, ni les phénomènes de rivalité entre espèces ou entre mâles, comme s'il n'y avait que de la coopération, mais il s'agit plutôt d'avoir un point de vue plus global faisant notamment intervenir les équilibres écologiques (où les virus ont un rôle régulateur). Ainsi le fait que des prédateurs défendent leur territoire est un facteur d'équilibre écologique et donc de durabilité qui ne se comprend pas au niveau de l'individu mais seulement du temps long par rapport à des prédateurs nomades.

La durée de vie semble finalement bien corrélée à la taille en moyenne.

En bref, si vous êtes un petit animal, vous vivrez moins longtemps a priori qu'un grand. Ainsi, une algue vit moins longtemps qu'un séquoia et les éléphants vivront plus longtemps qu'une souris. Cela vous le savez a priori déjà. La surprise qui fut celle des chiffres est qu'il existe maintenant une formule mathématique qui, avec la taille (masse plus exactement) en abscisse, vous donne (avec une certaine variation, mais pas trop) la durée de vie en ordonnée.

La formule prend ainsi la masse d'une plante ou d'un animal et l'on retrouve son métabolisme basal comme égal à la masse à la puisse 3 / 4.

La brève suivante illustre cet équilibre à partir du cancer.

- L'équilibre entre cancer et reproduction

Plus un animal est gros, plus il possède de cellules. Logiquement, on pourrait penser que plus il y a de cellules dans un organisme, plus il y a de risques de contracter un cancer. Pourtant, on constate le phénomène inverse. Cette contradiction, nommée paradoxe de Peto, vient d’être expliquée par un modèle mathématique.

Leur simulation, décrite dans Evolutionary Applications, prend en considération 100 stratégies possibles de mutations génétiques afin de déterminer celles qui seraient les plus fréquemment maintenues après 4.000 générations. Les gènes étudiés sont de deux types : les proto-oncogènes, qui après une mutation risquent d’induire le cancer, et les gènes suppresseurs de tumeurs (GST), qui préservent de la maladie et qui deviennent en général inactifs après deux altérations de leur séquence. Pour qu’une tumeur se forme, les auteurs ont considéré que les premiers devaient être actifs et les seconds inactifs. Leur modèle montre que les gènes réagissent très différemment selon le poids.

Par exemple, l’activation des proto-oncogènes semble diminuer si la taille des animaux augmente. À l’inverse, même s’ils favorisent la survie, les GST deviennent trop coûteux pour les espèces de petit ou moyen gabarit, car les répercussions sont trop importantes sur la reproduction.

Selon les résultats de cette étude, pour un certain nombre d’espèces, il est plus avantageux d’un point de vue évolutif de compter davantage de morts à cause du cancer que de développer des mécanismes pour s’en protéger. C’est ainsi que pourrait s’expliquer le paradoxe de Peto.

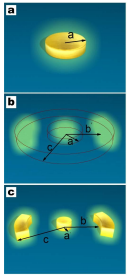

- Cartes 3D de l'orientation des lipides dans des tissus biologiques

Une méthode non invasive permettant d'observer in situ comment sont orientés les assemblages de lipides dans les tissus biologiques vient d'être mise au point par les physiciens du Laboratoire d'optique et biosciences (CNRS / Inserm / École polytechnique). Elle ne nécessite ni préparation, ni marqueur. Ces travaux devraient permettre de détecter et caractériser certaines pathologies associées à des désorganisations moléculaires au niveau de la peau ou du tissu nerveux.

On a étudié aussi la façon dont les membranes se construisent.

- Expliquer les mauvais repliements de protéine par la fièvre ?

Un programme qui tente de rendre compte du repliement des protéines par le principe de "frustration minimale" a permis de comprendre le rôle des fièvres dans les mauvais repliements. Si les fièvres peuvent aider à lutter contre le cancer, elles pourraient donner des maladies à prion comme Alzheimer ou Parkinson ?

- Les poissons ne seraient pas sensibles à la douleur

Du moins la douleur serait "inconsciente", plutôt de l'ordre du réflexe, et de nature différente de la nôtre impliquant le néocortex. Il est certain que notre douleur est d'un autre ordre, de là à nier toute conscience, il y a un gouffre ! Non seulement parce qu'un poisson peut montrer des signes de détresse mais parce que cela rendrait la douleur inutile et le poisson incapable d'apprentissage (ce à quoi sert la douleur).

D'ailleurs, une autre étude établit au contraire que les crabes ressentiraient la douleur...

- Des blocs de gènes déterminent les différents caractères des fourmis

- Le bousier s'oriente avec la Voie lactée

Des chercheurs avaient remarqué quelque chose de curieux avec le bousier. Après avoir constitué sa précieuse boule, l'insecte monte dessus et semble réaliser une danse de célébration. Il n'en est rien : l'insecte tourne dans tous les sens pour bien réaliser son orientation par rapport au ciel. Les yeux situés sur la partie dorsale de l'insecte sont capables de détecter la polarisation de la lumière, soit le plan selon lequel la lumière vibre.

Les chercheurs ont placé une espèce de bousier dans différents environnements avec différents « ciels » (avec lune, sans lune, avec nuages, avec certaines étoiles ou toute la Voie lactée, etc.) pour réaliser que la lune et les nuages gênent dans l'appréciation de la ligne droite. C'est la Voie lactée qui donne la réponse à cet insecte et c'est la première fois que l'on trouve un insecte qui se guide grâce aux étoiles.

Voir aussi Pour la Science et Futura-Sciences. C'est étonnant car, ici au moins, les bousiers se déplacent de jour...

Ces salamandres tachetées possèdent des algues symbiotiques photosynthétiques.

- Le mammifère africain ancêtre de la vache des mers

Autant l'origine des cétacés est bien connue des scientifiques - ces mammifères seraient nés sur le sous-continent indien au début de l'ère tertiaire avant de rejoindre le milieu aquatique -, autant celle des siréniens ressemblait à une page blanche jusqu'à très récemment. Cette famille de mammifères marins, aussi appelés vaches de mer car ils sont herbivores, comprend les lamantins et les dugongs. "A la fin des années 90, les biologistes moléculaires ont formulé l'hypothèse que les siréniens, comme les éléphants ou les damans, appartenaient à un même groupe de mammifères né en Afrique et baptisé "afrothères"" raconte Julien Benoit. Problème: les plus vieux fossiles de siréniens connus provenaient de Jamaïque... La découverte d'un os pétreux dans un gisement tunisien du Djebel Chambi, relayée dans PLoS One du 16 janvier, vient ajouter un argument de poids en faveur de l'hypothèse africaine.

- Des cachalots adoptent un dauphin infirme

Un groupe de cachalots a adopté un dauphin ! Victime d’une importante malformation au dos, ce petit cétacé s’est probablement associé aux cachalots car ils nagent lentement. De leur côté, pourquoi ont-ils accepté ce dauphin ?

Parmi les belles histoires figure en bonne place celle, célèbre, d’Owen et Mzee. Le premier, un bébé hippopotame orphelin après un tsunami dans l’océan Indien, avait été adopté par Mzee, une tortue géante. Les deux sont devenus inséparables.

- Cerveau humain versus cerveau de dauphin

- L'émergence de la paternité chez les babouins

Mais plus étonnant encore, l’étude a montré que ce sont les juvéniles et non les pères qui maintiennent le lien. Les petits se tournent vers leur géniteur le plus souvent lorsque la mère est absente. Car souvent dans ces cas, d’autres babouins tournent autour des juvéniles. Les pères fournissent donc une image de protecteur au petit.

- Le chien diffère du loup par la digestion de l'amidon

La première comparaison des génomes complets de loups et de chiens a trouvé 36 segments qui diffèrent nettement. Outre les différences dans les gènes liés au développement du cerveau, ils ont découvert trois gènes chez les chiens qui sont essentiels pour la digestion de l'amidon permettant d'étendre leur régime alimentaire carnivore ancestral.

Des essais en laboratoire ont montré que les chiens seraient 5 fois plus à l’aise que le loup pour la digestion de l’amidon, que l’on retrouve dans le blé et le riz, des aliments riches en glucides. On retrouve un effet génétique similaire chez les humains : les Américains du Nord (ou Européens) ainsi que les Japonais ont plus de copies du gène que certaines tribus d’Afrique (Mbutis) qui mangent peu de céréales.

C’est l’agriculture qui a induit ces changements. Cette découverte supporte l’idée que les humains et les loups ont commencé à se « fréquenter » de plus en plus lorsque les humains ont arrêté d’être nomades, se sont installés et ont développé des pratiques agricoles.

Il y a donc une différence avec les premiers chiens domestiqués qui ont changé en même temps que nous. Certains pensent que cette évolution pourrait être beaucoup plus récente. Il y a d'autres différences, qui dateraient sans doute d'avant l'agriculture : en premier lieu l'aboiement et, ce qui est unique dans le règne animal, la capacité de comprendre la désignation (ainsi que les intentions de leur maître). Il y aurait aussi une boîte crânienne plus petite.

Le chiot, quant à lui, prend son temps. Il commence sa période critique de socialisation à la quatrième semaine, il découvre le monde avec l’odorat et l’ouïe et développe la vue durant la période critique. Il est donc beaucoup plus enclin à s’adapter à son environnement extérieur. « À la deuxième semaine, une portée de chiots ne sait toujours pas marcher, commente Kathryn Lord, mais les loups sont déjà en train d’explorer en reniflant. »

"La différence peut ne pas être dans le gène lui-même, mais lorsque le gène est activé. Les données aident à expliquer pourquoi, si vous voulez socialiser un chien avec un Homme, vous n'avez besoin que de 90 minutes pour mettre en place une relation entre eux, entre les âges de quatre et huit semaines. Après cela, un chien n’aura pas peur des humains ou de toute autre chose qui lui a été présentée".

On s'apprête aussi à capturer des astéroïdes pour leur minerais...

- Le gène des dominants découvert : rs4950

Une étude américaine est la toute première à identifier une séquence d'ADN qui concerne la tendance de certains individus à « prendre les commandes ». Le génotype se nomme rs4950. Il serait transmis aux générations suivantes.

Cela justifierait les dynasties mais ne rend pas compte de l'émergence de nouveaux chefs venus de nulle part. En tout cas, si la corrélation est vraiment significative, on n'évitera pas les tests génétiques pour les postes de direction !

- Une sculpture d'ivoire de 26 000 ans

- Il y a 4000 ans, une migration de l'Inde vers l'Australie

Une vague d'immigration aurait peuplé l'île entre l'arrivée des premiers humains et la colonisation européenne.

Les auteurs de l'étude expliquent que ces immigrants auraient aussi apporté certains outils de pierre de petite taille appelés microlithe ainsi que le dingo, un chien sauvage trouvé en Australie.

Cette analyse génétique révèle également une origine commune des populations aborigène d'Australie, de Nouvelle Guinée et des Mamanwa, un groupe Negritos des Philippines qui remonte de 35.000 à 45.000 ans.

Durant cette période, l'Australie et la Nouvelle Guinée ne formait qu'un seul bloc géographique appelé Sahul.

- La causalité fait partie intégrante de la vision

Quelle structure cérébrale est impliquée dans la compréhension visuelle de la causalité ? Aucune: c'est notre système visuel et non un mécanisme cognitif complexe qui nous permet de comprendre qu'un objet bouge à cause d'un autre objet (par exemple lorsqu'une boule de billard se déplace parce qu'une autre boule de billard l'a poussée).

- L'apprentissage du langage commencerait 10 semaines avant la naissance

- Transformer un neurone d'un type dans un autre ''in vivo''

Grâce au facteur de transcription Fezf2, des neurones connectant les 2 hémisphères d'une souris ont été transformés en neurones moteurs cortico-spinaux.

Santé

génétique, traitements, nutrition, hygiène

- Se protéger de la dégradation de l'ADN en vieillissant

Ce serait le mécanisme de protection de l'ADN contre les (retro)transposons (recopies sauvages de bouts d'ADN piégés normalement par l'hétérochromatine) qui deviendrait déficient avec l'âge (ce qui pourrait expliquer les études montrant qu'on en avait plus que les chimpanzés - moins âgés ?). Un des traitements développés contre le SIDA permettrait justement d'inhiber la recopie de ces rétrotransposons pour ralentir le vieillissement.

Par ailleurs on pourrait restaurer la production de cellules souches du sang par le gène SIRT3 connu pour son effet antioxydant.

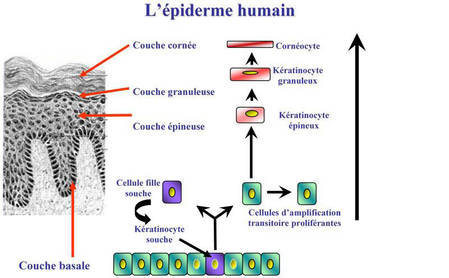

- Le manque de protéine CD98hc cause le vieillissement de la peau

« Cd98hc apparaît nécessaire au renouvellement rapide et efficace de l'épiderme. La baisse de son expression, constatée in vivo chez la souris âgée, confirme son rôle dans le maintien des tissus, le cycle du follicule pileux et la cicatrisation, perturbés avec l'âge, affirme Chloé Féral. Le statut du transporteur CD98hc in vivo pourrait être un indicateur de la capacité de la peau à se régénérer ».

Voir aussi Futura-Sciences.

- Des ADN à quadruple hélice dans certains cancers

Ce serait 4 guanine qui forment un carré, phénomène se produisant surtout avant la division de la cellule à la fois dans les chromosomes et les télomères.

Voir aussi R&Dmag et Futura-Sciences.

- Un détecteur de cellules cancéreuses

Le dispositif consiste en une sonde prenant la forme d’une aiguille de type « vaccin », mais à l'intérieur de laquelle est glissée une fibre optique. Elle est reliée à un boîtier laser (voir illustration ci-contre.) « On travaille sous-guidage échographique, précise Florian Chatellier. On envoie de la lumière laser aux cellules, qui renvoient alors leur propre lumière toujours via la fibre optique. On la récupère et on l'analyse. » Le dispositif, appelé Probea, se connecte simplement à un ordinateur, où le spécialiste observe sur écran comment les tissus éclairés diffusent la lumière. Et n'est pas exclusivement dédié au cancer du sein.

- La bactérie de la lèpre, productrice de cellules souches

C’est du jamais vu dans la nature : alors qu’ils cherchaient à comprendre comment la bactérie Mycobacterium leprae, responsable de la lèpre, se répandait dans l’organisme, des scientifiques écossais ont compris qu’elle reprogrammait des cellules nerveuses en cellules souches afin d’intégrer ensuite n’importe quel tissu adulte. Une découverte qui devrait ouvrir de belles perspectives thérapeutiques.

- Une piqûre à la place de la trithérapie

Le vaccin en test cible la protéine Tat (transactivating). Selon le Dr Isabelle Ravaux, les personnes infectées par le VIH possèdent une protéine Tat produite par le VIH. Cette protéine intervient dans les mécanismes de réplication du virus ainsi qu'au niveau extracellulaire en "trompant" le système immunitaire. Elle va empêcher les cellules tueuses de se lancer à l'attaque du VIH mais agit aussi sur les lymphocytes B en réduisant la production d'anticorps contre le VIH. En neutralisant la protéine Tat chez une personne séropositive, les chercheurs visent à restaurer son immunité et bloquer le développement de la maladie. Pour cela, il faut pouvoir déclencher une production d'anticorps anti-Tat suffisante.

L'objectif de ce vaccin est de remplacer la trithérapie, traitement très lourd, par une simple piqûre, au moins pendant plusieurs mois. Il n'est donc pas encore question de faire disparaitre définitivement le VIH, mais il s'agit d'une avancée majeure.

Voir aussi Futura-Sciences.

- Un vaccin préventif et thérapeutique contre la maladie d’Alzheimer ?

Testée sur des souris, une molécule nommée MPL a stimulé le système immunitaire des rongeurs qui a détruit 80 % des plaques séniles impliquées dans la démence. Le tout avec très peu d’effets secondaires, un contraste fort avec les anciennes tentatives.

On explore aussi l'oxygène pour réveiller les neurones déficients.

- La dégradation de la mémoire liée au manque de sommeil

Le manque de sommeil profonde aurait pour conséquence de confiner la mémoire dans l'hippocampe chez les sujets âgés, empêchant son stockage à long terme dans le reste du cerveau.

Le manque de sommeil profonde aurait pour conséquence de confiner la mémoire dans l'hippocampe chez les sujets âgés, empêchant son stockage à long terme dans le reste du cerveau.

Voir aussi Techno-Sciences.

- Les tomates sont des médicaments

Une pillule, l'Ateronon, contenant du lycopène qu'on trouve dans les tomates protègerait des AVC, des crises cardiaques et de certains cancers en diminuant l'inflammation (augmentant la sensibilité au NO). Cela pourrait être une alternative aux statines.

Par ailleurs, prendre des anti-oxydants favoriserait le cancer car les cellules cancéreuses survivent en produisant beaucoup d'anti-oxydants.

- La bière contre le diabète ?

En fait, c'est plutôt un composant du houblon donnant son amertume à la bière, l'humulone, qui pourrait traiter le diabète et certains cancers en diminuant l'inflammation.

- Combattre l’obésité avec une pompe aspirant le contenu de l’estomac ?

Cette petite pompe nichée dans l’estomac va être dépendante d’un périphérique externe, qui va aspirer la nourriture fraîchement ingurgitée. En somme, il serait question de pouvoir manger sans se priver, assuré qu’une partie des calories absorbées seront aspirées. Et bien sûr, pour que la nourriture soit évacuée, il va falloir laisser apparaître une petite valve sur son ventre.

Ces tests effectués aux Etats Unis font état de la perte de 20 kg en moyenne la première année.

Depuis quelque temps maintenant, des scientifiques ont aussi remarqué que le sildénafil, le principe actif du Viagra, détenait d’autres pouvoirs dont l’humanité pourrait profiter. Des souris à qui l’on en administrait régulièrement gardaient la ligne malgré un régime hypercalorique qui aurait dû les rendre obèses.

Le médicament a été administré sept jours durant à des souris. Les chercheurs se sont alors rendu compte que les adipocytes blancs – ceux qui stockent la graisse – se transformaient en adipocytes beiges. Ces derniers n’accumulent pas les lipides, mais les brûlent de manière à fournir de la chaleur. Ils font donc fondre le gras quand les cellules adipeuses blanches l’accumulent.

L’étude met en évidence un autre point intéressant. Ces adipocytes blancs, en s’enrichissant en lipides, prennent du volume et sécrètent des hormones qui induisent la réaction inflammatoire. Ce processus est derrière les maladies chroniques liées à l’excès de graisse, et peut mener à des troubles cardiovasculaires (crise cardiaque, AVC) aussi bien qu’au cancer ou qu’au diabète de type 2.

- Lien entre le gène de l'hyperactivité et la longévité

Plus on a de copies du gène DRD4 (jusqu'à 7), plus on est actif et plus on vit vieux (grâce à l'activité).

- Le cannabis encouragerait à l'effort !

Ce n'est pas l'avis général mais il s'agit plutôt ici du rôle des récepteurs de cannabinoïdes CB1, lors de la réalisation d'un exercice physique.

Ces chercheurs ont montré chez la souris que la localisation de ce récepteur dans une aire cérébrale associée aux systèmes de motivation et de récompense, contrôle le temps pendant lequel un individu se livre à un exercice physique volontaire.

"L'incapacité à ressentir du plaisir lors de l'activité physique, souvent citée comme une cause de non adhésion partielle ou totale à un programme d'exercice physique, indique que la biologie du système nerveux est bel et bien en jeu".

Les données mettant en avant des interactions entre le système endocannabinoïde, la cible du delta9-tétrahydrocannabinol (le principe actif du cannabis), et l'exercice physique, ne datent pas d'aujourd'hui. En effet, cela fait 10 ans que l'on sait qu'une session d'exercice physique active le système endocannabinoïde chez le sportif entraîné, mais le rôle exact de ce système lors de l'exercice physique est resté longtemps inconnu. Il y a 3 ans, la même équipe de recherche bordelaise a observé que des souris mutantes n'ayant plus de récepteur aux cannabinoïdes du type CB1, le principal récepteur du système endocannabinoïde dans le cerveau, couraient moins longtemps et sur de plus courtes distances que leurs congénères sains quand on leur donnait la possibilité d'utiliser une roue d'exercice. L'étude publiée ce mois-ci dans Biological Psychiatry tente de comprendre "comment", "où" et "pourquoi" l'absence de ce récepteur CB1 diminue partiellement (de 20 à 30 %) les performances d'exercice volontaire chez des souris ayant accès à une roue d'exercice 3 heures par jour.

Ils ont tout d'abord montré que le récepteur CB1 contrôlant les performances de course est situé sur des terminaisons de neurones GABAergiques. Ils ont ensuite démontré que ce récepteur est localisé dans l'aire tegmentale ventrale (cf. schéma ci-dessous), une région cérébrale impliquée dans les processus motivationnels liés à la récompense, qu'elle soit naturelle (prise alimentaire, sexe) ou associée à la consommation de substances psychoactives.

Au début et pendant toute la durée de l'exercice physique, le récepteur CB1 est constamment stimulé par les endocannabinoïdes, des molécules lipidiques qui activent naturellement ce récepteur en réponse à de nombreux stimuli plaisants (récompenses) ou déplaisants (stress). La stimulation du récepteur CB1 par les endocannabinoïdes pendant l'exercice physique provoque une inhibition de la libération de GABA, un neurotransmetteur inhibiteur qui contrôle l'activité des neurones à dopamine associés aux processus de motivation et de récompense. De cette stimulation du récepteur CB1 résulte une "inhibition d'inhibition", c'est à-dire une activation des neurones dopaminergiques de l'aire tegmentale ventrale. La stimulation du récepteur CB1 est donc un prérequis pour que l'exercice se prolonge, et ce, en procurant à l'organisme la motivation nécessaire.

"Au-delà des endorphines, il nous faut donc maintenant considérer les endocannabinoïdes comme un autre médiateur potentiel des effets positifs de l'exercice physique sur notre humeur".

Le lien entre stress et dépression est discuté depuis longtemps avec plusieurs théories impliquant le cortisol, la saturation des récepteurs des neurotransmetteurs ou le déficit de production des neurones. Ce serait bien le cortisol qui serait le facteur déclenchant et c'est le mécanisme privilégié des anti-dépresseurs (inhibition de la recapture des neurotransmetteurs) qui est en cause, ne prenant pas le mal à la racine et négligeant trop la voie dopaminergique.

L'un des mécanismes impliqués dans l'apparition de la dépression causée par le stress vient d'être révélé chez la souris par des chercheurs du CNRS, de l'Inserm et de l'UPMC. Ils ont déterminé le rôle du récepteur de la corticostérone, l'hormone du stress, dans la modification à long terme des comportements induits par un stress chronique. Chez des souris subissant des agressions répétées, ce récepteur participe à la mise en place d'une aversion sociale en contrôlant la libération de dopamine, un messager chimique clef. Si ce récepteur est bloqué, les animaux deviennent "résilients": bien qu'anxieux, ils surmontent le traumatisme et ne fuient plus le contact avec leurs congénères.

Les chercheurs ont reproduit l'expérience, mais cette fois-ci avec diverses lignées de souris chez lesquelles le récepteur de la corticostérone était absent dans certaines populations de neurones. Ils ont ainsi découvert que les souris dépourvues de ce récepteur dans les neurones sensibles à la dopamine, ne développaient pas d'aversion sociale. Bien qu'anxieuses suite aux attaques répétées, elles ne fuyaient pas pour autant le contact avec leurs congénères. Ces rongeurs étaient donc plus "résilients", c'est-à-dire plus résistants au stress.

En réponse à une agression, on observe toujours une libération de dopamine. Or, les scientifiques ont remarqué que, chez les souris dépourvues du récepteur de la corticostérone dans les neurones sensibles à la dopamine, cette libération était fortement diminuée. Chez une souris normale, les neurones sensibles à la dopamine contrôlent donc, par un mécanisme de feed back, la libération de ce neurotransmetteur. Pour montrer que cette libération de dopamine cause le développement de l'aversion sociale, les chercheurs ont bloqué l'activité des neurones producteurs de dopamine. Résultat: chez les souris agressées, l'intérêt pour leurs congénères était restauré. L'activité dopaminergique est donc cruciale pour l'apparition d'une aversion sociale.

Voir aussi Pour la Science et Futura-Sciences.

- Liaison entre la violence et le plomb

General Motors avait en effet développé dans les années 20 (1920) un additif pour l’essence, afin d’éviter un phénomène que l’on appelle le « cliquetis ». Cet additif, nommé Tétraéthylplomb a été généralisé au monde entier rapidement.

Dans les années 70, les pots catalytiques étaient incompatibles avec l’essence au plomb. Les associations de lutte pour l’environnement ont aussi fait pression sur les gouvernements, car des études avaient montré que le plomb conduisait à des maladies congénitales. Ainsi, dans les années 80 est apparu le « sans-plomb » alors que le super était taxé plus lourdement. Aux États-Unis, le « super » a été interdit sur les routes en 1996.

Pour des toxicologues de l'université de Tulane, la combustion de pétrole dopé au plomb est derrière le pic de crimes violents durant les années 80 et 90. La forte réduction d'essence au plomb durant les années 80 a fait que les crimes violents ont baissé.

Une étude réalisée par un chercheur de Pittsburgh en 1996 avait montré que les enfants qui avaient de forts niveaux de plomb étaient bien plus susceptibles de montrer un comportement agressif par rapport à ceux qui avaient des niveaux normaux.

Il n’y a pas si longtemps que cela, on a attribué à la sévère politique du maire de l’époque de New York, Rudy Giuliani (le « tolérance zéro » qui avait tant impressionné Sarkozy un peu plus tard) les résultats impressionnants de chute des crimes : 75 % de moins entre les années 90 et 2010 ! Le souci avec cette conclusion est que les taux de crimes ont baissé dans les autres villes de la même manière alors qu’il n’y avait pas de « Giuliani » : -70 % à Dallas, -74 % à Newark et -79 % à Los Angeles.

Corrélation n'est pas causalité puisqu'on peut mettre aussi en rapport la baisse de criminalité avec la baisse de l'utilisation d'Internet Explorer ! Une autre étude montre que le cerveau des psychopathes violents présenterait moins de matière grise dans le cortex préfrontal antérieur et dans des zones des lobes temporaux (Liées au système limbique, les zones en question jouent un rôle dans l'empathie, le raisonnement moral et les mécanismes d'inhibition comme le sentiment de culpabilité).

- Le bisphénol A serait nocif pour le coeur et les reins

Alors que la France vient de voter l’interdiction du bisphénol A dans les contenants alimentaires d’ici 2015, la résine révèle encore de nouveaux dangers. Les jeunes, qui présentent les taux les plus élevés, auraient plus de risques de développer des problèmes rénaux ou cardiaques.

Chez ceux qui présentaient les niveaux de BPA les plus élevés, les auteurs ont observé un ratio albumine/créatinine plus important. Or, ce dernier est un marqueur potentiel de troubles rénaux et de maladies coronariennes (les artères coronaires étant celles alimentant le cœur en énergie). Par ailleurs, ils ont également montré que le bisphénol A augmentait le stress oxydatif au niveau des cellules.

Il réduirait aussi la production de testostérone (ce qui pourrait favoriser la sclérose en plaque) mais un substitut (le Bisphenol S) serait encore plus dangereux (voir aussi Futura-Sciences).

- Un traitement contre l'herpès

Le virus de l'herpès est la plupart du temps dormant (il serait d'ailleurs plutôt bénéfique quand on est jeune, boostant le système immunitaire, et plus dangereux quand on vieillit) mais il échappe aux traitements. Un inhibiteur de l'enzyme qui le protège permettrait enfin de l'éradiquer.