- La nouvelle théorie de Lee Smolin : l'espace des moments

- La gravité n'est pas une émergence entropique

- La Lune aurait absorbé une autre lune

- Les Chinois veulent détourner Apophis de la Terre

- Une ceinture d'antiprotons autour de la Terre

- Une cape d'invisibilité pour la lumière visible

- Influence des rayons cosmiques sur la formation des nuages

- Une prolongation du courant du Labrador en eau profonde

- Une machine à fabriquer de l'eau

- Confirmation du monde ARN à l'origine de la vie

- Les mêmes contraintes conduisent aux mêmes évolutions

- De l'importance de la biodiversité

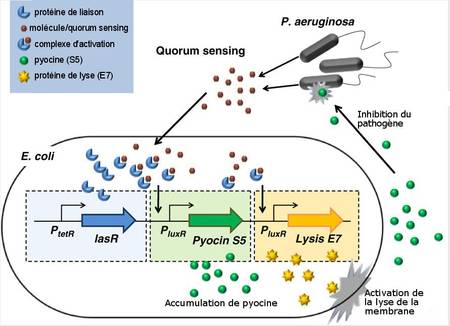

- La communication universelle entre bactéries

- Un robot-abeille parle aux abeilles

- L'évolution à l'envers : un alligator dans un oeuf de poule

- Homo Erectus faisait cuire ses aliments

- Le vieillissement s'arrête à 90 ans

- Vaginale "et" clitoridienne

- Vous n'avez plus que 12 ans à vivre

- Une pilule contre les coups de soleil

- L'Ecstasy contre le cancer

- Nicotine contre Parkinson

- Le sel aggrave le déclin cognitif

- Du sang neuf pour un cerveau neuf

- Un test de paternité pendant la grossesse

- Une mousse stable 6 mois jusqu'à 60°C

- Graver ses DVD dans la pierre

- Utiliser les interférences pour accélérer les communications sans fil

- Passer les vitesses du vélo par la pensée

<- Revue des sciences précédente | Revue des sciences suivante ->

Revues : Pour la Science - La Recherche - Sciences et Avenir

Brèves : Physique - Climat - Biologie - Santé - Technologie

La loi de l'information veut qu'on ne se répète pas mais ce n'est pas parce qu'on arrête d'en parler que le Japon est sortie d'affaire, la caractéristique du nucléaire étant sa durée déraisonnable. C'est donc sans doute pour longtemps qu'il y aura encore des pluies radioactives sur le Japon. Le mois d'août est normalement un mois creux pour l'information mais il y a quand même encore bien trop de nouvelles scientifiques pour un seul homme, pas de pause de ce côté. Ce n'est pas tous les jours non plus qu'on assiste à la naissance d'une nouvelle théorie physique très prometteuse comme celle dite des espaces de moments ou espaces de phases, défendue par Lee Smolin et dont l'originalité est de faire de l'énergie une dimension spatiale (une nouvelle profondeur), ce qui semble de plus entrer en résonance avec les octonions qu'on avait vu le mois dernier. Par contre on peut s'amuser de voir les physiciens transformer en information une absence d'information et de s'enthousiasmer qu'on serait proche de la découverte du boson de Higgs du fait même qu'il ne reste qu'un petit intervalle où il pourrait se cacher alors même qu'il brille surtout par son absence !

La crise qui traîne en durée elle aussi manifeste à quel point le monde est désormais unifié même s'il ne le sait pas assez et que chacun voudrait se replier sur soi, ses intérêts, ses préjugés, son histoire. Il y a toujours un décalage dans la prise de conscience qui résiste d'abord à la nouveauté. D'ailleurs, un des paradoxes de l'ère du numérique et de l'économie de la connaissance, paradoxe bien connu dans les sciences, c'est de devoir favoriser la créativité alors que par définition on continue à la rejeter et mener la vie dure aux créateurs qui restent forcément des marginaux jusqu'à ce que leurs idées aient fait leurs preuves. Si la crise est imputable de façon très classique au cycle de Kondratieff, c'est-à-dire à la bulle de crédit et la crise de la dette précédant un retour de l'inflation, le numérique y intervient massivement, notamment par la rapidité d'ordres automatiques et les réseaux globaux pas seulement financiers, si ce n'est par la propagation de rumeurs. Ce sont souvent maintenant des robots qui répondent à des robots, et lorsqu'on laisse des robots parler entre eux, on entend surtout les lacunes de leur concepteur. Un nouveau venu pourrait jouer un rôle imprévu. En effet, Bitcoin, le système sécurisé et anonyme d'échange d'argent peer to peer (sans frais ni intermédiaire bancaire) connaît un succès croissant et pourrait, à plus long terme servir de monnaie globale (notamment en cas d'effondrement du dollar) sauf qu'il est déjà parasité par la spéculation... Même une monnaie virtuelle a besoin d'une régulation et d'un pilotage réactif pour être viable. On peut être dubitatif aussi devant le projet d'IBM de simuler le monde grâce à des data center gigantesques même si cela peut donner quelques résultats. Il est beaucoup plus certain qu'on entre dans le monde de la cyberguerre qui reprend de vieilles techniques d'espionnage comme l'infiltration mais le manuel de Kevin G. Coleman : The Cyber Commander’s eHandbook (téléchargeable sur l’internet) dresse la liste de 40 types d’offensives et on pourrait être attaqués dans tous les appareillages numériques :

Le N°39, c’est le piratage informatique des automobiles. Une voiture est bourrée de puces contrôlant le système de freinage, la transmission, le moteur, en fait absolument tout. Prenez le contrôle de ces systèmes et vous contrôlez de fait le véhicule, et vous pouvez l’accidenter à votre guise. Vous n’y croyez pas ? Des chercheurs de l’université Rutgers ont piraté l’année dernière les puces d’une voiture se déplaçant à 100 km à l’heure à l’aide d’un système WiFi utilisé pour vérifier la pression des pneus.

En même temps que le contrôle des Etats sur le réseau s'étend en prenant modèle sur les dictatures, il devient plus facile de devenir hacker avec un logiciel pour pirates :

La guerre des brevets aussi continue à faire rage dont l'absurdité apparaît sur ce schéma où tout le monde fait des procès à tout le monde :

Pour la Science no 407, Vivre dans un monde quantique

- Vivre dans un monde quantique, p22

- Vivre dans un monde quantique, p22

La théorie quantique ne concerne pas seulement les électrons et les atomes. Elle s'applique aussi à plus grande échelle : aux oiseaux, aux plantes, voire aux humains.

Article très décevant sur les conséquences macroscopiques des propriétés quantiques comme l'intrication et qui nous refait le coup du chat de Schrödinger en voulant nous faire croire qu'il pourrait y avoir superposition d'un chat mort et d'un chat vivant, voire que cet état pourrait être réversible, alors qu'on nous parle en fait simplement du mécanisme quantique permettant aux oiseaux de percevoir l'inclinaison du champ magnétique terrestre, le seul côté intéressant étant d'arriver à préserver l'intrication d'électrons 100 microsecondes alors qu'on arrive pour l'instant qu'à 50 microsecondes ! Il y a pourtant bien d'autres expériences récentes qui tentent de préserver les propriétés quantiques à un niveau où ils deviennent visibles. De là à prétendre qu'il n'y aurait pas de séparation entre physique quantique et physique classique...

Selon son idée, inspirée des travaux de Klaus Schulten, de l'Université de l'Illinois, la rétine d'un œil d'oiseau contiendrait une molécule où deux électrons forment une paire intriquée de spin total nul.

Dans le modèle théorique de T. Ritz, quand cette molécule absorbe un photon de lumière visible, les électrons reçoivent assez d'énergie pour se séparer et devenir ainsi sensibles au champ magnétique terrestre. Si le champ magnétique est incliné, il affecte différemment les deux électrons, créant un déséquilibre qui modifie la réaction chimique subie par la molécule. Des mécanismes chimiques traduisent cette différence en impulsion nerveuse, que le cerveau de l'oiseau transforme en une image du champ magnétique terrestre. L'oiseau est ainsi doté d'un dispositif d'orientation macroscopique, qui ne relève pas de la physique classique.

L'article se termine par l'hypothèse faisant de la gravitation un phénomène émergent et qui vient juste d'être réfutée, notamment par la mesure de la force de gravitation sur des neutrons. Il est plus raisonnable de penser que le phénomène de décohérence, c'est-à-dire d'interactions, serait à l'origine du monde classique par ses propriétés d'organisation collective.

La relativité générale suppose que les objets ont des positions bien définies et ne sont jamais à plus d'un endroit à la fois, ce qui est en contradiction avec la physique quantique. (...) L'espace-temps classique émergerait de l'intrication quantique par le processus de décohérence.

Une autre possibilité, plus intéressante encore, serait que la gravitation ne soit pas une force en elle-même, mais le bruit résiduel de l'action des autres forces de l'Univers engendré par le caractère flou des phénomènes quantiques. Cette idée de « gravitation induite » remonte aux années 1960 et au physicien et dissident soviétique Andreï Sakharov. Si elle devait se révéler pertinente, alors non seulement la gravitation y perdrait son statut de force fondamentale, mais aussi tous les efforts accomplis pour la « quantifier » seraient vains. Au niveau quantique, la gravitation ne pourrait même pas exister.

- Le désordre intrinsèque des protéines, p56

Selon les fonctions qu'elles accomplissent dans les cellules, les protéines présentent une conformation rigide ou, au contraire, très flexible. Les biologistes commencent à étudier le rôle des protéines « intrinsèquement désordonnées » dans diverses maladies.

On assimilait jusqu'ici les protéines à des machines et donc à des structures rigides dont les fonctions dépendaient d'un repliement spécifique (site catalyseur, clé, pompe, etc.). On apprend ici que les protéines ne sont pas des machines mais sont bien vivantes comportant une part d'aléatoire qui leur apporte une flexibilité indispensable. Un grand nombre de protéines "intrinsèquement désordonnées" sont faites pour s'envelopper sur d'autres protéines, à partir d'un point d'ancrage, ou pour les inhiber, on ne peut dire qu'elles soient vraiment "fonctionnelles" mais elles sont réactives et il est intéressant de constater que même dans les protéines "rigides", des parties sont laissées plus informes, procurant plus de flexibilité.

Les exemples évoqués jusqu'à présent sont des protéines qui se replient – soit sur elles-mêmes, soit autour d'autres protéines – lorsqu'elles accomplissent leur fonction (voir l'encadré page 60). Mais le désordre est souvent une partie intégrante du fonctionnement d'une protéine. Parfois, une région non structurée agit comme un minuteur contrôlant le moment auquel deux sites de liaison se rencontrent : si la région non structurée est longue, les deux sites de liaison passent plus de temps à se chercher que lorsque la région non structurée est courte, car la probabilité de « rencontre » des deux sites est inférieure. Dans certains cas, le fait d'être déstructurée permet à une protéine particulière de se faufiler à travers la membrane cellulaire. De telles protéines non structurées apparaissent dans les axones des neurones, où elles forment des structures protégeant l'axone en occupant le volume aux alentours et en empêchant les enzymes de destruction d'approcher.

Cela permet de mieux comprendre l'origine de la vie et des maladies comme Alzheimer ou Parkinson où des protéines déstructurées se mettent à former des agrégats.

Dans les machines moléculaires anciennes (du point de vue évolutif), qui sont constituées d'assemblages d'arn et de protéines, presque toutes ces protéines sont partiellement ou entièrement déstructurées quand elles ne sont pas liées à leurs arn « partenaires ». Ces anciens complexes hybrides (complexes ribonucléoprotéiques) comprennent le splicéosome et le ribosome.

Dans cette théorie d'un « monde à arn », une difficulté majeure tient au fait que l'arn se replie difficilement dans sa forme active et reste souvent figé dans des conformations inactives. Dans les cellules actuelles, des protéines dites chaperonnes assurent un repliement correct de l'arn et d'autres le stabilisent dans sa conformation active. Ces deux types de protéines n'ont pas de structure stable avant de se lier à l'arn. Leur apparition aurait ainsi permis de résoudre l'épineux problème du repliement de l'arn.

Les acides aminés hydrophobes, volumineux, qui poussent une protéine à se replier, seraient apparus tardivement, et donc les protéines constituées des premiers acides aminés devaient très probablement rester dépliées quand elles étaient seules. Si ces hypothèses sur l'évolution du code génétique sont correctes, alors les premières protéines apparues sur Terre se repliaient mal ou pas du tout. Les acides aminés apparus ultérieurement ont manifestement permis aux protéines de se structurer. Elles ont alors acquis des sites enzymatiques actifs de type clé-serrure et, dès lors, ont assuré les fonctions remplies par les arn dans les cellules pendant des millions d'années.

- Des insectes pour guérir, p36

Depuis 5 000 ans, les insectes sont utilisés en médecine traditionnelle. En étudiant leurs principes actifs, des biochimistes mettent au point de nouvelles molécules thérapeutiques.

Ainsi, les blattes sont utilisées en Chine, en Thaïlande, en Grèce et au Burkina Faso comme antibiotique contre les otites, ou en Russie et dans le monde arabe comme diurétique ; les nids de guêpes sont (ou étaient) réputés pour leurs effets anticancéreux (Chine et Europe), antibiotique (Chine, Cameroun, Mali, Zambie), analgésique (Chine, France, Libéria, Mozambique) et anti-inflammatoire (Chine, Brésil) ; des fourmis ont été prescrites pour leur effet analgésique, en particulier contre l'arthrite et les rhumatismes (France, Russie, Afrique du Sud, Mexique, Brésil, Australie), ou leur effet neurotonique (Chine, France, Maroc), voire pour suturer les plaies avec leurs mandibules (Inde, Turquie, Mexique) ; les miels sont connus depuis longtemps sur tous les continents pour leur effet antibiotique et pour faciliter la cicatrisation, et le venin d'abeille soulage l'arthrite et les rhumatismes, tant en Corée qu'en Europe, au Soudan ou au Brésil.

Moins de 0,5 pour cent des arthropodes terrestres ont été étudiés, mettant déjà en évidence des molécules pharmacologiquement actives variées : le potentiel de découverte de nouvelles molécules est élevé. Avec 1 600 familles, un million d’espèces connues et plus de quatre millions restant à découvrir, les arthropodes terrestres représentent le plus gros réservoir inexploré de médicaments.

Ce n'est pas la raison pour laquelle il faudrait préserver la biodiversité mais cela y participe car, quoiqu'on dise, les substances naturelles sont souvent supérieures aux substances artificielles (pas toujours) ayant bénéficié de millions d'années de mise au point et d'expérience.

- La langue façonne la pensée, p30

Les langues que nous parlons modifient notre façon de percevoir le monde et nos capacités cognitives.

Il ne fait aucun doute que le langage façonne la pensée, comme j'ai essayé d'en rendre compte dans "un homme de parole", très au-delà de ce qu'examine cet article ne s'attachant qu'aux spécificités culturelles alors que la narration donne corps aux mythes, entre autres, et nous sépare radicalement des animaux (après la cuisson). Reste qu'il est intéressant de constater que certaines langues ne connaissent pas la gauche ou la droite ne se repérant que par rapports aux points cardinaux mais ce n'est pas la langue en tant que telle, seulement la sédimentation d'une culture dans une langue particulière manifestant cependant à quel point on pense avec la langue. Pierre Pica souligne que le langage peut modifier surtout nos conceptions du nombre, de l'espace et du temps, ce qui devrait intéresser la physique, mais l'article insiste avec raison sur la construction du genre également (il faudrait ajouter le tu et le vous). Cependant, si on peut lier une langue à des façons de penser, une vision du monde (l'esprit d'un peuple), ce n'est qu'à être le résultat d'une histoire singulière plus qu'une essence originaire car toute langue reste traduisible dans une autre langue et les sciences sont universelles. Il est donc difficile de distinguer ce qui relève du langage ou de l'idéologie, de la culture ou des modes de vies qui vont avec (les Esquimaux perçoivent des nuances de neige pour lesquels nous n'avons pas de mots et on avait vu le mois dernier comme la perception des couleurs était influencée par les mots). Il ne suffit pas d'être bilingue pour changer ses façons de penser même si beaucoup de bilingues avouent penser différemment d'une langue à l'autre. L'auteur de l'article montre que les préjugés changent en fonction de la langue employée !

Bien que tout ceci soit assez mince, son intérêt, c'est de montrer que le langage structure la pensée, ce que le structuralisme avait déjà bien mis en évidence, que la pensée dépend de sa matérialisation dans des mots et des discours constitués. On le sait bien lorsqu'on écrit et qu'on cherche le mot juste sans lequel la pensée ne trouve pas d'expression et reste dans la confusion, n'ayant pas de véritable existence, alors qu'on ne sait ce qu'on pense qu'à s'entendre parler ou relire sa phrase. Il ne faut voir là ni relativisme ni subjectivisme ou vision du monde arbitraire mais plutôt un matérialisme des mots (matérialisation de l'immatériel) et la fonction pratique du langage aussi bien que sa dépendance à l'histoire, c'est-à-dire à l'expérience du réel et les traces laissées dans la mémoire de la langue. La réalité est certes construite, avec toutes sortes de limitations cognitives, mais par des processus bien réels.

Chaque langue apporte sa « trousse à outils » cognitive et renferme la connaissance et la vision du monde développées au cours de plusieurs milliers d’années dans une culture. Elle contient une façon de percevoir le monde, de l’appréhender et de lui donner une signification, et représente un guide que les ancêtres ont développé et perfectionné. Les recherches sur la façon dont les langues parlées modèlent la pensée permettent aux scientifiques de découvrir comment l’homme crée la connaissance et construit la réalité.

Pour Mark Changizi, ce qui fait la difficulté pour un ordinateur de comprendre le langage serait que celui-ci provient de processus perceptifs (pour les sons) et biologiques (pour leur combinaison). Cela rejoint les intuitions de René Thom qui voyait dans la structure de la phrase l'analogue de la prédation et renforce la liaison originelle entre le corps et l'esprit (ce qui ne veut pas dire que l'esprit se réduit au corps). De même, la musique serait liée aux mouvements du corps, pas seulement le rythme. Cela n'explique pas ce qui différencie les tons majeurs des tons mineurs ou les accords parfaits des accords dissonants, qui sont des propriétés objectives, mais a l'intérêt de souligner la place du corps dans le langage comme dans la musique.

Pour Mark Changizi, ce qui fait la difficulté pour un ordinateur de comprendre le langage serait que celui-ci provient de processus perceptifs (pour les sons) et biologiques (pour leur combinaison). Cela rejoint les intuitions de René Thom qui voyait dans la structure de la phrase l'analogue de la prédation et renforce la liaison originelle entre le corps et l'esprit (ce qui ne veut pas dire que l'esprit se réduit au corps). De même, la musique serait liée aux mouvements du corps, pas seulement le rythme. Cela n'explique pas ce qui différencie les tons majeurs des tons mineurs ou les accords parfaits des accords dissonants, qui sont des propriétés objectives, mais a l'intérêt de souligner la place du corps dans le langage comme dans la musique.

- Les débuts de la culture en Europe, p42

Ce qui est fascinant dans les articles sur la préhistoire, c'est qu'on nous raconte à chaque fois une autre histoire, pas tout à fait la même bien que ce ne soit pas tout à fait une autre. C'est ce qu'on préfère depuis qu'on est gamin pour s'endormir le soir !

Ce qui est fascinant dans les articles sur la préhistoire, c'est qu'on nous raconte à chaque fois une autre histoire, pas tout à fait la même bien que ce ne soit pas tout à fait une autre. C'est ce qu'on préfère depuis qu'on est gamin pour s'endormir le soir !

On avait parlé le mois dernier de traces de culture gravettienne plus ancienne qu'on ne croyait et qui semble se confondre avec l'arrivée de l'homme moderne. Là on se situe encore un peu avant, peut-être 40 000 ans, dans le Jura souabe avec des hommes modernes, encore à l'Aurignacien (comme la grotte Chauvet) mais en progrès rapide.

Ces découvertes suggèrent qu'au début du Paléolithique supérieur, toute une série d'innovations culturelles et techniques se sont produites dans le Jura souabe. Apparemment, le phénomène n'a pas d'équivalent au cours de la période culturelle précédente : il semble que le Jura souabe ait été l'un des foyers d'innovation du Paléolithique supérieur à l'origine de la modernité culturelle : un langage complexe, un système de croyances, un système de liens sociaux et économiques.

Les bijoux, les figurines et les instruments de musique que façonnent les membres de telles sociétés attestent de leur aptitude à se représenter la réalité à l'aide de concepts (des représentations mentales d'aspects de la réalité) associés à des symboles tels que des suites de sons (mots, airs de musique), des signes graphiques, des gestes, des statues, etc. Tout cela forme ce que l'on nomme la pensée symbolique.

Les objets symbolisant un aspect de la réalité (figurines) ou façonnés pour produire des symboles, par exemple sonores (instruments de musique), sont des manifestations de la modernité culturelle. Selon les indices disponibles de nos jours, ils apparaissent pour la première fois à l'arrivée des Homo sapiens en Europe, il y a quelque 40 000 ans.

Depuis l'Eurasie, ces traces de modernité culturelle passent par le Proche-Orient, il y a environ 100 000 ans, puis peuvent être suivies en Afrique jusque vers 80 000 ans (les plus anciens fossiles d'hommes modernes datent de quelque 200 000 ans).

Pour autant, entre 40 000 et 35 000 ans avant notre ère, peu de temps après l'arrivée des premiers hommes anatomiquement modernes en Europe, les figurines et les instruments de musique faisaient incontestablement partie du fonds culturel européen.

La place de la musique se manifeste notamment avec des flûtes taillées dans l'ivoire et témoignant d'une maîtrise parfaite. Neandertal ne serait donc pas du tout de la fête contrairement à ce que prétend La Recherche et d'autres tentatives récentes de l'identifier à nous.

Les découvertes du Jura souabe indiquent que l'homme anatomiquement moderne de l'époque aurignacienne avait développé une diversité culturelle comparable à celle des sociétés ultérieures. Les Néandertaliens qui, au Paléolithique moyen, occupaient la plus grande partie de l'Europe ne sont pas allés aussi loin. C'est pourquoi nous pensons que la présence de nos ancêtres de l'âge de pierre a poussé les Néandertaliens, peu nombreux, vers l'extinction, non seulement parce que Homo sapiens fabriquait des armes et des outils plus performants, mais aussi parce que le langage symbolique, attesté par les bijoux, figurines et instruments de musique qu'il employait, lui procurait nombre d'avantages. C'est la modernité culturelle qui est à l'origine du succès démographique de l'homme anatomiquement moderne pendant l'Aurignacien.

- Plongés dans le noir par un virus informatique ?, p72

Ce n'est que l'un des articles du mois sur la cyberguerre qui se focalise plutôt sur la mise hors service du réseau électrique (très exposé déjà aux éruptions solaires).

- Le principe de Peter, p82

La différence entre un texte humoristique et des travaux universitaires sérieux est parfois mince. Le principe de Peter est l'exemple même d'une loi dont le statut reste incertain.

Cela fait longtemps que je prends au sérieux ce qui se présentait pourtant comme un gag, faisant figurer le principe de Peter dans mon Prêt-à-penser (1993). En effet, il faut rendre compte des limites des organisations hiérarchiques et de leur bureaucratisation, ce qui explique pourquoi "tout va toujours mal", ce qui n'est pas rien !

Ici, Jean-Paul Delahaye montre que si "dans une hiérarchie, toute personne finit par atteindre son niveau d’incompétence", cela serait imputable à 2 causes : d'une part au phénomène de régression vers la moyenne (plus on monte moins on est exceptionnel), d'autre part à l'effet cliquet (une fois arrivé à son niveau d'incompétence, on est inamovible). Pour l'effet cliquet la meilleure méthode serait celle de l'armée : limiter le temps à chaque échelon (cela n'empêche pas l'armée de promouvoir des incompétents notoires en temps de paix). Pour la régression vers la moyenne, le plus efficace serait le tirage au sort.

Dans notre cas, le côté inattendu des conclusions a valu le prix Ig Nobel à l’étude italienne sur le principe de Peter qui prouve que des promotions décidées au hasard ne seraient pas absurdes dans certaines organisations hiérarchiques.

Aujourd’hui, dans de nombreux pays, les jurés des grands procès sont choisis au hasard, et il n’est pas absurde de soutenir qu’il faut faire jouer au hasard un rôle plus grand dans le choix des responsables de l’exécutif politique. Cela éviterait que le pouvoir ne soit accaparé par une classe politicienne inamovible de gens représentant assez mal l’intérêt collectif et d’accord entre eux pour éviter les réformes opposées à leurs intérêts.

En fait, l'étude italienne concluait que c'était le choix des plus mauvais pour les postes de direction qui maximisait l'efficacité globale (conformément à la régression vers la moyenne) mais avec des hypothèses absurdes.

Signalons deux autres maximes qui sont proches du principe de Peter sans reposer sur les mêmes mécanismes :

Quand un dispositif fonctionne bien, on l'utilise au-delà de ce pour quoi il était prévu, et cela jusqu'à ce qu'il ne fonctionne plus (William Corcoran, spécialiste sureté nucléaire).

C'est ce qu'on retrouve dans l'idéologie trop généralisante et dans les paradigmes scientifiques, entre autres...

Un logiciel informatique qui donne satisfaction tend à se développer et à se perfectionner jusqu'au point où plus personne n'en maîtrise la complexité... et le fonctionnement.

Cette fois, on se confronte à l'effondrement des systèmes artificiels trop complexes et devenus trop fragiles alors que les systèmes vivants sont d'autant plus robustes qu'ils sont complexes. Le point commun à toutes ces maximes, c'est qu'à continuer dans une direction, on rencontre une limite ou l'on assiste à un retournement, principe de la dialectique qui disqualifie toute position dogmatique et tout principe trop absolu.

La Recherche no 455, Un nouveau monde quantique

Dossier décevant où la "théorie de l'information" n'est que la maîtrise de la cryptographie quantique et de l'intrication comme preuve de la mécanique quantique. Le seul article intéressant est celui d'Alexei Grinbaum (La limite d'un étrange lien à distance, p52) mais difficilement compréhensible d'autant qu'il n'est pas expliqué comment "la borne de Tsirelson" est calculée. On apprend simplement que si les inégalités de Bell impliquent que la somme des corrélations quantiques soit supérieure à 2, sa valeur ne pourrait dépasser 2 x racine de 2 (environ 2,8284).

Dossier décevant où la "théorie de l'information" n'est que la maîtrise de la cryptographie quantique et de l'intrication comme preuve de la mécanique quantique. Le seul article intéressant est celui d'Alexei Grinbaum (La limite d'un étrange lien à distance, p52) mais difficilement compréhensible d'autant qu'il n'est pas expliqué comment "la borne de Tsirelson" est calculée. On apprend simplement que si les inégalités de Bell impliquent que la somme des corrélations quantiques soit supérieure à 2, sa valeur ne pourrait dépasser 2 x racine de 2 (environ 2,8284).

On démontre que, si les ressources cachées dans la boîte noire obéissaient à la physique classique, qui est entièrement locale, cette formule ne donnerait jamais un résultat supérieur à 2. En mécanique quantique, on dépasse cette limite. Mais pourquoi doit-on s'arrêter à la borne de Tsirelson ? Rien n'oblige a priori que la somme de quatre nombres, chacun entre +1 et -1, ne soit jamais supérieur à 2 racine de 2. Pourquoi ne pourrait-on pas obtenir la valeur 4. La valeur maximale ?

Une des explication donnée reformule les relations d'incertitude sous leur forme entropique qui mettraient une limite à la non-localité mais le fait que les mesures expérimentales ne dépassent pas 2,7252 pourrait indiquer que la non-localité serait un peu plus restreinte que ne le suppose la théorie quantique actuelle. Par contre, le recours à une sorte de théorie de l'information pour justifier une limite à la non-localité n'est guère convaincant, plutôt de l'ordre de la pétition de principe, tout au plus d'une démonstration par l'absurde.

- L'optogénétique, méthode de l'année 2010, p8

On en parle régulièrement depuis le mois d'avril de cet étonnant contrôle génétique par la lumière mais cette fois ce sont des cellules modifiées qui ont été mises dans des capsules transparentes de 400 micromètres et implantées sous la peau avant d'activer leur production de protéine par l'exposition à une lumière bleue, ce qui pourrait servir à contrôler la production de substances médicamenteuses bien qu'on soit encore loin de pouvoir transposer l'expérience des souris aux hommes.

On en parle régulièrement depuis le mois d'avril de cet étonnant contrôle génétique par la lumière mais cette fois ce sont des cellules modifiées qui ont été mises dans des capsules transparentes de 400 micromètres et implantées sous la peau avant d'activer leur production de protéine par l'exposition à une lumière bleue, ce qui pourrait servir à contrôler la production de substances médicamenteuses bien qu'on soit encore loin de pouvoir transposer l'expérience des souris aux hommes.

- Un quasar lointain éclaire les débuts de l'univers, p12

Ce qui est fascinant, c'est la prétention de reconstruire avec si peu un état si ancien de l'univers, le pire, c'est que c'est peut-être vrai mais la base semble quand même fragile puiqu'on suppose qu'après une phase opaque, où la combinaison de particules chargées les avait transformé en hydrogène neutre (opaque), leur effondrement gravitationnel en étoiles aurait produit un rayonnement formant des bulles transparentes à la lumière. Or le quasar (rayonnement d'un trou noir supermassif) observé, âgé de 12,9 milliards d'années quand l'univers n'avait que 770 millions d'années, présente des pics d'intensité qui sont interprétés comme le passage de la lumière du quasar à travers ces bulles transparentes, jusqu'à calculer qu'il y aurait eu à l'époque 10% d'hydrogène neutre opaque et 90% hydrogène ionisé et d'hélium transparents...

Ce qui est fascinant, c'est la prétention de reconstruire avec si peu un état si ancien de l'univers, le pire, c'est que c'est peut-être vrai mais la base semble quand même fragile puiqu'on suppose qu'après une phase opaque, où la combinaison de particules chargées les avait transformé en hydrogène neutre (opaque), leur effondrement gravitationnel en étoiles aurait produit un rayonnement formant des bulles transparentes à la lumière. Or le quasar (rayonnement d'un trou noir supermassif) observé, âgé de 12,9 milliards d'années quand l'univers n'avait que 770 millions d'années, présente des pics d'intensité qui sont interprétés comme le passage de la lumière du quasar à travers ces bulles transparentes, jusqu'à calculer qu'il y aurait eu à l'époque 10% d'hydrogène neutre opaque et 90% hydrogène ionisé et d'hélium transparents...

- Des canettes de soda pour créer une "superlentille" sonore, p15

C'est plus qu'anecdotique mais démontre que la recherche sur les métamatériaux n'est pas cantonnée aux nanotechnologies.

- L'ADN maternel contrôle le développement de l'embryon, p22

Cela ne concerne pour l'instant que les plantes à reproduction sexué où c'est l'ADN maternel qui prend en charge les premières divisions cellulaires des 2 ou 3 premiers jours en inhibant par des ARNs non codants l'ADN du mâle avant de le désinhiber au stade des 64 cellules qui détermine déjà l'organisation fondamentale de la plante. On ne sait si ça s'applique aux animaux et à l'homme mais cela pourrait expliquer que le chromosome Y se soit délesté d'une partie de ses gènes ?

- L'aurignacien neandertalien ?, p25

Leur interprétation semble un peu rapide de la découverte dont on avait parlé le mois dernier d'une concomitance en Ukraine, il y a 40 000 ans, des hommes modernes et de la culture gravettienne : c'est que la culture précédente, l'aurignacien, serait celle de neandertal, prétendent-ils, ce qui le rapprocherait un peu plus de nous mais n'est pas du tout ce qu'on a vu dans Pour la Science !

- Les disques durs pollués à 90%, p32

Les disques durs de nos ordinateurs ou des serveurs sont encombrés de fichiers inutiles, résidus d'installations ou fichiers temporaires qui ne sont jamais utilisés. C'est inévitable dès lors que la complexité du système et le nombre de fichiers empêche qu'on puisse avoir un contrôle total sur ses fichiers (qu'on sache lesquels sont inutiles). On est quand même étonné des chiffres (qui doivent être très variables) de 20% de fichiers représentant 98% de l'espace disque utilisé. On est plus étonné encore d'apprendre que la solution d'effacer les fichiers inutiles d'un serveur ne serait pas souhaitable à cause de la consommation d'énergie que cela représenterait sur un gros centre serveur !

Les disques durs de nos ordinateurs ou des serveurs sont encombrés de fichiers inutiles, résidus d'installations ou fichiers temporaires qui ne sont jamais utilisés. C'est inévitable dès lors que la complexité du système et le nombre de fichiers empêche qu'on puisse avoir un contrôle total sur ses fichiers (qu'on sache lesquels sont inutiles). On est quand même étonné des chiffres (qui doivent être très variables) de 20% de fichiers représentant 98% de l'espace disque utilisé. On est plus étonné encore d'apprendre que la solution d'effacer les fichiers inutiles d'un serveur ne serait pas souhaitable à cause de la consommation d'énergie que cela représenterait sur un gros centre serveur !

- La cyberguerre, p62

Comme on l'a vu, les Etats s'organisent et préparent leurs moyens de guerre mais pour combattre les botnets (réseaux d'ordinateurs infectés pour le spam ou les virus) le meilleur moyen serait de les infiltrer en jouant la taupe pour les tromper, comme quoi le jeu n'a pas changé du chat et de la souris...

Sciences et Avenir no 775, La vérité sur le bio

Le dossier sur le Bio, p46, est une défense de ses avantages mais, surtout depuis Fukushima, Sciences et Avenir a viré complètement écolo et anti-nucléaire, notamment sa directrice de rédaction Dominique Leglu qui aborde p74 la question du démantèlement des centrales nucléaires et de son chiffrage sous-estimé.

On peut conseiller aux "sceptiques" l'article p8 expliquant l'effondrement des Twin Towers qui ne convaincra pas les complotistes mais qui dissipe les zones d'ombres qui restaient sur le comportement des bâtiments. Cela n'empêche pas que le rôle de la CIA n'est pas clair dans cette affaire qui aurait pu être évitée si la CIA avait informé le FBI.

On peut conseiller aux "sceptiques" l'article p8 expliquant l'effondrement des Twin Towers qui ne convaincra pas les complotistes mais qui dissipe les zones d'ombres qui restaient sur le comportement des bâtiments. Cela n'empêche pas que le rôle de la CIA n'est pas clair dans cette affaire qui aurait pu être évitée si la CIA avait informé le FBI.

L'explosion d'AZF garde aussi ses zones d'ombre (p13), le scenario retenu officiellement étant possible mais peu assuré (il y avait tout de même bien des produits potentiellement explosifs).

On apprend aussi, p32, que 46 000 personnes se sont installées chaque année, entre 1999 et 2006, dans des zones inondables d'Île-de-France !

Le buzz du mois, p94, c'est la sortie du livre Bons baisers des bonobos de Vanessa Woods.

Brèves et liens

Physique

cosmologie, astronomie, physique quantique

- La nouvelle théorie de Lee Smolin : l'espace des moments

Cette théorie semble utiliser les octonions dont on parlait le mois dernier, en tout cas elle suppose 8 dimensions. On avait vu que pour représenter 3 dimensions il y avait besoin de 4 coordonnées et j'avais suggéré que pour 4 on pouvait en avoir besoin de 8. Or l'originalité de la théorie de Lee Smolin, c'est de déterminer un "momemtum space" où l'énergie constitue une dimension en soi, une nouvelle profondeur (un peu comme l'expansion pour les quaternions?). Cette reprise d'une théorie de Born (Born reciprocity) implique une courbure de l'espace des moments en fonction de l'énergie, ce qui impliquerait une relativité de la localisation des objets qui ne seraient pas à la même place selon le point de vue et l'énergie.

- Le temps n'aurait pas de fin

Je signale cette théorie car elle est d'Alan Guth mais c'est un peu du délire, ne serait-ce que du fait de se situer dans l'hypothèse folle du multivers où toutes les probabilités se produiraient. Cela n'est intéressant que comme symptôme de l'état de notre ignorance et de ce que permettent les équations. De quoi aussi évoquer Hegel et surtout Kojève, pour qui le temps doit avoir une fin, comme un livre se termine par un point final, ou toute phrase nous donnant le dernier mot. L'analogie fait penser qu'un temps qui se termine ne serait que le début d'un autre temps comme une phrase appelle une autre phrase et tous les livres définitifs n'empêchent pas l'inflation constante de livres...

Rien à voir avec le principe de Peter pour ce qui est seulement la probabilité d'être dans la moyenne. C'est une réflexion (sans mathématique) sur l'inflation et de supposés multivers qui seraient toujours en inflation et pourraient provoquer des collisions avec le nôtre. Le principe de médiocrité n'est qu'une hypothèse privilégiant le fait que notre situation correspondrait à une moyenne au lieu d'en faire une exception au nom du principe anthropique. Pour qu'un univers soit créé à partir du vide, il faut que son énergie totale soit nulle, le positif égalant le négatif et l'énergie créée étant équilibreé par la gravitation considérée comme une énergie négative (on a l'impression que l'énergie est comptée 2 fois, 1 fois comme énergie électromagnétique et une fois comme masse gravitationnelle ?). Il nous prédit qu'on serait avalé par une bulle d'univers en inflation à énergie négative nous précipitant dans un Big Crunch et pouvant arriver à tout moment. Tous cela est très spéculatif et basé sur rien, l'inflation elle-même étant plus que contestable, ce qu'on avait vu le mois dernier...

Rien à voir avec le principe de Peter pour ce qui est seulement la probabilité d'être dans la moyenne. C'est une réflexion (sans mathématique) sur l'inflation et de supposés multivers qui seraient toujours en inflation et pourraient provoquer des collisions avec le nôtre. Le principe de médiocrité n'est qu'une hypothèse privilégiant le fait que notre situation correspondrait à une moyenne au lieu d'en faire une exception au nom du principe anthropique. Pour qu'un univers soit créé à partir du vide, il faut que son énergie totale soit nulle, le positif égalant le négatif et l'énergie créée étant équilibreé par la gravitation considérée comme une énergie négative (on a l'impression que l'énergie est comptée 2 fois, 1 fois comme énergie électromagnétique et une fois comme masse gravitationnelle ?). Il nous prédit qu'on serait avalé par une bulle d'univers en inflation à énergie négative nous précipitant dans un Big Crunch et pouvant arriver à tout moment. Tous cela est très spéculatif et basé sur rien, l'inflation elle-même étant plus que contestable, ce qu'on avait vu le mois dernier...

- La gravité n'est pas une émergence entropique

En 2010, Erik Verlinde avait émis l'hypothèse que la gravité (et l'inertie) ne serait pas une force comparable à la force électromagnétique mais un simple effet entropique et statistique, seulement l'étude de la gravité sur les neutrons dément cette interprétation (que j'avais critiquée).

- La matière noire, un effet inertiel de la relativité générale ?

Dans un espace non-Euclidien, il n'y a pas équivalence entre la masse gravitationnelle et inertielle, la masse inertielle apparaît augmentée de la courbure de l'espace-temps d'une valeur correspondant à celle de la matière noire supposée.

- L'évaporation des trous noirs manifesterait des dimensions supplémentaires

Si la théorie des cordes a raison, l'existence de dimensions supplémentaires devrait accélérer l'évaporation supposée des trous noirs, ce qui pourrait se détecter par la perte de force gravitationnelle sensible dans l'éloignement d'étoiles en orbite autour du trou noir.

Tout ceci reste très spéculatif mais ouvre la voie à une vérification de la théorie des cordes qui ne passe plus par un accélérateur mais par l'observation de phénomènes cosmiques qui sont inaccessibles à l'expérience, voie du futur sans doute.

- Des trous noirs entourés de nuages de poussière

L'émission de rayons X repérée dans une partie des quasars a un pic dont l'énergie équivaut à celle des rayons X balayant l'Univers dans son ensemble. Les astrophysiciens peuvent conclure que ces rayons sont émis par nombre de trous noirs, dissimulés par des nuages.

On vient d'ailleurs d'observer des rayons X attestant d'une étoile avalée par un trou noir et produisant un jet relativiste caractéristique (qui reste mystérieux pour moi) à 99,5% de la vitesse de la lumière. L'intéressant, c'est que le phénomène dure plusieurs mois alors qu'on imaginerait que ce soit beaucoup plus rapide.

Voir aussi Futura-Sciences.

Cette planète, située à 4000 années-lumière de la Terre, orbite autour d’un pulsar, une toute petite étoile à neutrons tournant très vite sur elle-même. Elle en fait le tour très rapidement (en 2h10 min) et se situerait seulement à 600 000 Km de son étoile, soit même pas le rayon du Soleil.

La planète est elle aussi assez petit, environ cinq fois le diamètre de la Terre, mais en revanche à une masse qui avoisine celle de Jupiter. Les astronomes pensent qu’elle est le reliquat d’une étoile, une naine blanche, dont la majorité de la matière a été aspirée par le pulsar.

«Ce qui reste est composé de carbone et d'oxygène » a déclaré le Dr Michael Keith (CSIRO), l'un des membres de l'équipe de recherche. La densité de cette planète signifie que ce matériau est certainement sous forme cristalline : en clair, elle majoritairement composé de diamant.

- Explosion d'une supernova à 21 millions d'années lumière

L'explosion devrait être visible, quoique difficilement, début septembre. Il y aurait même une deuxième supernova de l'été.

- Les neutrons deviennent carrés dans les étoiles à neutron

D’après les calculs des deux chercheurs, dans des étoiles à neutrons très massives, comme c’est le cas avec PSR J1614-2230, et donc dans certains pulsars et magnétars, la pression devient si grande que les neutrons se déforment pour devenir une sorte d’empilement de cubes. Ce serait un peu comme ont tendance à le faire des oranges empilées et tassées fortement.

Cela se produirait lorsque la densité de la matière nucléaire dans une étoile à neutrons atteindrait les 1015 g/cm3. En prenant cette forme de cube, le volume individuel des neutrons diminuerait de 24 %.

- Eruption solaire, la plus puissante en cinq ans

Premières images d’une tempête solaire autour de... par sciencesetavenir

Des chercheurs ont identifié de nouvelles marques à la surface de Mars qui pourraient correspondre à des traces d’eau liquide.

Mais cela pourrait être de la lave plutôt.

- La Lune aurait absorbé une autre lune

Il fut un temps où la Terre avait deux lunes. Les deux faces de la Lune sont très différentes, notamment l'épaisseur du manteau, ce qui pourrait venir du fait qu'après la collision ayant arraché un morceau de Terre, plusieurs lunes se seraient formées avant de fusionner.

Les 2 lunes auraient été produites par la collision entre la Terre et une plus petite planète, Théia, genre de collision qu'on observe ailleurs.

- La Lune plus jeune qu'on ne croyait

Cette nouvelle datation résulte de l’analyse d'isotopes de plomb et de néodyme trouvés dans un échantillon d'anorthosite, la plus vieille roche de la croûte lunaire (FAN, ferroan anorthosite). Cette roche s'étant révélée significativement plus jeune que les estimations précédentes, les scientifiques ramènent aujourd’hui l’âge de la Lune à 4,36 milliards d'années, quelque 20 millions d’années après la formation du Système solaire, estimée à 4,568 milliards d’années.

- Des réacteurs nucléaires compacts pour la Lune et Mars

Les réacteurs nucléaires compacts pourraient devenir la source d'énergie principale pour les bases scientifiques spatiales lunaires et martiennes, ont déclaré lundi des chercheurs américains.

Notre réacteur ressemble à une petite valise qui mesure 30 cm x 15 cm. Cette "valise" nucléaire produira environ 40 kW d'électricité sur la Lune, une quantité suffisante pour huit maisons sur la Terre".

- Jouer au billard pour détourner des astéroïdes

C'est un programme européen appelé Don Quichotte, pour nous protéger d'un astéroïde fonçant sur nous !

- Les Chinois veulent détourner Apophis de la Terre

Voir aussi physorg.

- Une ceinture d'antiprotons autour de la Terre

Les rayons cosmiques produisent des anti-protons comme dans les accélérateurs. La plupart sont annihilés mais une partie reste piégée par le champ magnétique terrestre formant une ceinture d'anti-protons autour de la Terre.

- L'expansion de la Terre n'est pas la cause de la dérive des continents

L’idée que la dérive des continents n’est pas causée par la convection mantellique mais par une croissance continue de la taille de la Terre vient de recevoir une nouvelle réfutation par un groupe de géophysiciens américains, français et hollandais. La variation moyenne annuelle est si faible qu’elle peut être statistiquement considérée comme nulle.

Dans les années 1950, cette théorie n’est pas absurde car des physiciens du calibre des fondateurs de la physique quantique, à savoir Paul Dirac et Pascual Jordan, spéculaient sur une variation séculaire des constantes de la physique, en particulier celle de la gravitation. Une lente variation de la constante de Newton, modifiant l’intensité de l’interaction gravitationnelle entre deux masses fixes, pouvait fort bien conduire à une augmentation constante de la taille de la Terre, entraînant la fracturation d’un continent primitif, la Pangée de Wegner, comme le montre l’animation.

Le résultat est tombé. Le rayon moyen de la Terre ne change pas à une incertitude de mesure de 0,2 millimètre par an.

- Le boson de Higgs brille par son absence

L'annonce du mois dernier était bien prématurée, les données prouveraient au contraire l'absence du boson de Higgs aux énergies testées, la probabilité qu'il n'existe pas se renforce bien qu'il reste des niveaux d'énergie à tester, aux limites de ce que peut faire le LHC qui a pourtant été construit pour cela ! J'ai toujours trouvé cette hypothèse arbitraire et d'ailleurs il n'y aurait rien de plus décevant que de le découvrir, son absence obligeant à reconsidérer la détermination de la masse, c'est-à-dire la portée des interactions qui pourrait dépendre du bruit notamment ou plus simplement de l'énergie (de la longueur d'onde).

Pour les tenants de la supersymétrie, la masse du Higgs devrait se situer dans la partie qui reste à explorer, proche de la masse des bosons W et Z, sauf que, pour l'instant les résultats du LHC ne semblent pas confirmer la supersymétrie...

- Compter les photons un à un et garder leur nombre

L’équipe de Serge Haroche, Michel Brune et Jean-Michel Raimond a mis au point une cavité composée de deux miroirs supraconducteurs, refroidis à une température approchant le zéro absolu (–273°C). Les photons rebondissent contre ces parois ultra-réfléchissantes au lieu d’être absorbés. Pour réaliser des mesures sur les photons piégés sans interagir avec eux, les chercheurs utilisent des atomes bien spécifiques qui n’absorbent pas l’énergie du photon. En revanche en passant dans la cavité ils sont modifiés au contact du photon et fournissent ainsi de précieuses informations sur sa présence.

Avec ce système de "lecture non destructive" des modifications d'état d'un seul atome, non seulement on peut compter les photons avec précision mais on peut en garder le nombre avec une boucle de rétroaction permettant de rajouter les photons manquants qui se seraient échappés, un équivalent du thermostat ou de la correction d'erreur qui devrait permettre de nouvelles expérimentations (ou calculs quantiques).

Voir aussi Techno-Science.

- Un cristal de skyrmions magnétique

Tony Skyrme cherchait à mieux comprendre la nature des nucléons et des forces nucléaires fortes. On savait déjà que les protons et les neutrons étaient des fermions de spin demi-entier et qu’ils échangeaient des sortes de photons, le fameux boson de Yukawa de spin entier, le pion.

À première vue, l’idée semble absurde. Comment obtenir des particules de spin ½ à partir d’états composites de particules de spin nul ?

C’est là qu’intervient le caractère non linéaire de l’équation. De même que dans un fluide, lui aussi décrit par une équation non linéaire (celle de Navier Stokes), il peut se former des tourbillons stables avec un moment cinétique, on pouvait considérer protons et neutrons comme des sortes de tourbillons dans un fluide de pions. Ces configurations, qui rappellent celles des solitons, sont aujourd’hui appelées des skyrmions.

Dans le cas présent, l’élément du cristal de Skyrme en deux dimensions n’est formé que de quinze atomes et, surtout, l’ordre magnétique apparaît spontanément sans l’intervention d’un champ magnétique extérieur.

- Rendre le vide supraconducteur avec un champ magnétique

Le fait que le vide se comporte comme des métamatériaux devrait avoir eu des conséquences sur la lumière des origines.

- Transformer des métaux en métamatériaux avec un champ magnétique

Des chercheurs autrichiens annoncent que même les métaux communs peuvent avoir un indice de réfraction négatif, s’ils sont placés dans un champ magnétique.

« Nous soumettons le métal à un fort champ magnétique et en l’irradiant avec précision avec de la lumière à une longueur d’onde correcte nous obtenons une réfraction négative » explique Andreï Pimenov, dans la revue EPL. Le chercheur utilise un rayonnement micro-onde projeté sur des feuilles de métal très fines. En raison des effets de résonance magnétique sur le métal, la lumière est pliée de façon drastique à la surface du métal.

- Une cape d'invisibilité pour la lumière visible

On savait rendre invisible des objets aux micro-ondes notamment mais cette fois, c'est bien l'invisibilité à la lumière qu'on obtiendrait grâce à un guide d'onde en nitrure de silicium sur un substrat nanoporeux d'oxyde de silicium qui a un index de réfraction très bas (n<1.25). Le résultat est obtenu par gravure des trous de différentes tailles dans la couche de nitrure. Le dispositif produit une invisibilité à large bande dans le spectre visible avec de faibles pertes.

- Changer le bore d'acide en base

Le Français Guy Bertrand, vient de réaliser ce qui semblait impossible : obtenir d’un composé acide qu’il se comporte comme une base.

Le nouveau borane obtenu possède une paire d'électrons supplémentaire sur l'atome de bore, il se comporte donc comme s'il présentait un excès d'électrons, c'est-à-dire comme une base au sens de Lewis. Pour le moment, les auteurs ignorent les réactions qui pourraient être catalysées par ce borane mais ce devrait être dans le domaine de la catalyse organométallique et organique, probablement au moins pour la fabrication de médicaments.

- Des transistors en diamant pour résister à la radioactivité

« Quand j'ai pris connaissance des problèmes à la centrale de Fukushima après le tsunami japonais, j'ai réalisé que les circuits en nanodiamants seraient parfaits pour les systèmes de sécurité électroniques dans les réacteurs nucléaires. Ils ne seraient pas affectés par les niveaux de radiation élevés ou les températures élevées créées par les explosions ».

On comprend tout l’intérêt des travaux menés depuis des années par Jimmy Davidson à l’université Vanderbilt concernant des composants électroniques avec des nanodiamants. Bien plus résistants aux radiations ionisantes, ils peuvent fonctionner à des températures de plusieurs centaines de degrés au-dessus et au-dessous de 0 °C.

Les chercheurs ont mis au point une technique permettant de déposer des films de nanodiamant à partir de vapeurs d’hydrogène et de méthane. Des composants électroniques peuvent ainsi être générés à des coûts dérisoires et moins d’un carat de diamant se retrouve sous la forme d’un milliard de ces composants.

Ce sont des nouvelles molécules avec des électrons qui restent isolés et qui seraient capables d'absorber et de restituer 2 photons à la fois.

Ce sont des nouvelles molécules avec des électrons qui restent isolés et qui seraient capables d'absorber et de restituer 2 photons à la fois.

"Les électrons qui gravitent autour des atomes ont tendance à 'communiquer' deux par deux, c'est ainsi que naissent les liaisons chimiques. Certaines molécules (diradicalaires) comportent également des électrons isolés, ce qui leur confère des propriétés inhabituelles. Ces électrons non appariés ne restent en effet pas totalement inactifs et c'est leur 'communication' particulière, sur laquelle on peut influer, qui génère des propriétés précises".

Une telle capacité d'absorption lumineuse, grâce à son caractère non-linéaire, laisse entrevoir des applications en optoélectronique. Elle permettrait notamment de miniaturiser certains matériaux ou d'en augmenter les performances. Par exemple, le laser d'une tête de lecture de dvd "à deux photons" serait capable de lire quatre fois plus d'informations qu'un autre, de taille égale, mais "à un photon".

Climat

Climat, écologie, énergies

- Influence des rayons cosmiques sur la formation des nuages

Les premiers résultats, publiés par Nature, de l'expérience CLOUD menée au Cern (dont on parlait en juin), apportent enfin des éléments précis sur l'impact des rayons cosmiques sur la formation des aérosols - de potentielles 'graines' de nuages. Un élément clef pour le climat.

Les ions augmentent le taux de nucléation des aérosols. Cependant, cet impact est plus fort à 15 km d’altitude que dans les couches basses de l’atmosphère. A environ un kilomètre de la surface de la Terre, les trois composants habituels de la nucléation ne suffisent pas pour produire la quantité d’aérosols observée dans le monde réel, expliquent les chercheurs. Même la présence d’ions ne rétablit pas la balance. D’autres éléments entrent donc en jeu, notamment des composants organiques capables de stabiliser la nucléation. Quantifier le rôle de ces ‘contaminants’, d’origine naturelle ou anthropique, est le prochain travail de l’expérience CLOUD.

D’après l’hypothèse du Danois Henrik Svensmark (Institut national spatial de Copenhague), la couverture nuageuse est liée à l’intensité du rayonnement cosmique, qui lui-même dépend de l’activité solaire (le champ magnétique solaire protégeant la terre des rayons cosmiques).

Les résultats de CLOUD ne permettent pas de tirer des conclusions sur la formation des nuages, l’expérience n’observant que la nucléation des aérosols. «Rien ne dit que dans l’atmosphère la majeure partie de la nucléation vienne de la présence d’ions, analyse de son côté Paolo Laj. S’ajoute ensuite le problème de l’évolution de ces particules pendant plusieurs jours». La nucléation n’est qu’une étape dans le processus de condensation qui permet la formation de gouttelettes puis de nuages.

Voir aussi Futura-Sciences.

Voir aussi Futura-Sciences.

En clair, si les chercheurs ont bien montré que les rayons cosmiques favorisaient l’apparition d’aérosols (d’un facteur 10) à partir d’un mélange de vapeur d’eau, d’ammoniac et d’acide sulfurique à des altitudes de plus de 5 km, avec des températures inférieures à -25 °C, ils n’ont observé qu’une faible production pour les couches de l’atmosphère plus basses, en contradiction avec ce que l’on pensait.

Pour certains, cela prouverait que le réchauffement ne serait pas dû au CO2, ce qui est absurde. Par contre cela pourrait expliquer à la fois l'optimum du Moyen-Âge et le petit âge glaciaire limités à l'Europe à cause de changements du régime des vents liés aux rayons cosmiques (et donc aux tâches solaires) mais toute conclusion est prématurée en l'état actuel de nos connaissances, y compris le fait qui reste probable qu'on entre dans un minimum de Maunder car on vient d'observer le retour de quelques tâches solaires.

- Les éruptions volcaniques plus que le charbon chinois

On avait expliqué le ralentissement du réchauffement par l'augmentation du soufre stratosphérique attribué au charbon chinois alors qu'il viendrait plutôt, et comme toujours, de l'activité volcanique, même sans éruptions spectaculaires. Ce qui confirme qu'on est entré dans une phase plus active du volcanisme et de la tectonique des plaques.

Pour déterminer précisément l'origine et estimer l'ampleur de cette augmentation des aérosols stratosphériques au cours de la dernière décennie, des équipes de chercheurs (2) ont analysé les séries de données de concentrations d'aérosols acquises par plusieurs missions spatiales (3). Ces chercheurs ont montré que leur augmentation observée par satellite entre 2000 et 2010 était largement due à de fréquentes mais petites éruptions volcaniques injectant du dioxyde de soufre dans la basse stratosphère des régions tropicales et qu'elle s'élevait en moyenne à 5-7 % par an.

Ils ont montré que l'augmentation moyenne de la concentration des aérosols dans la stratosphère durant la dernière décennie avait induit un forçage radiatif sur ces dix dernières années d'environ - 0.1 W/m2. Or, un tel refroidissement est tout à fait significatif au regard du réchauffement induit durant la même période par l'augmentation moyenne de 0.5 % par an de la concentration du dioxyde de carbone dans l'atmosphère et estimé à + 0.3 W/m2. La présence de ces aérosols durant la dernière décennie semble donc avoir eu pour effet de diminuer la température au sol de 0.07 °C, par rapport à ce qu'elle aurait dû être en 2010.

- Le NO2 renforce le réchauffement

Le sol peut, sous l'effet couplé d'un incendie et d'une augmentation de la teneur en dioxyde de carbone, relâcher beaucoup plus d'oxyde nitreux, un puissant gaz à effet de serre, que sous l'effet des deux phénomènes pris séparément.

Le feu a stimulé la production par le sol d'un puissant gaz à effet de serre, l'oxyde nitreux (N2O), et ce durant au moins les trois années suivant la perturbation. De manière surprenante, les traitements simulant les conditions climatiques "futures", en particulier l'augmentation de la teneur en CO2 et des apports azotés, ont amplifié les effets du feu sur les émissions de ce gaz à effet de serre. Ainsi, les parcelles brûlées ont vu leurs émissions doubler, tandis que les parcelles brûlées et par ailleurs soumise à un niveau élevé en CO2 et en azote ont vu leurs émissions multiplier par six. Cette réponse est due à une stimulation de l'activité de microorganismes du sol (les microorganismes dénitrifiants) qui sont capables de respirer le nitrate dans le sol (tout comme nous respirons l'oxygène dans l'air) et, ce faisant, produisent du N2O.

- Gaz à effet de serre en hausse de 3,9% aux États-Unis

- Une prolongation du courant du Labrador en eau profonde

Un nouveau courant marin vient d’être identifié entre l’Islande et le Groenland. Froid et profond, il déverse de l’eau polaire dans l’Atlantique nord et participe ainsi à la grande boucle qui permet les échanges de chaleur entre tropiques et Arctique. Une nouvelle expédition vient de partir pour en identifier la source et comprendre en quoi le réchauffement climatique peut affecter son cours.

- La fonte de l'Arctique ne serait pas si inquiétante...

Sur la durée étudiée, les résultats font apparaître quatre grandes phases où le climat a varié. La fin de la déglaciation est nettement suivie il y a 8.500 ans par une phase plus chaude appelée « optimum climatique de l’Holocène ». Les caractéristiques de l'orbite terrestre (excentricité, obliquité, précession) étaient telles que l’hémisphère nord recevait 8 % de chaleur de plus que de nos jours. Cela explique en partie des températures arctiques (et non pas globales), alors entre 2 et 4 °C supérieures aux actuelles. À cette époque, la limite de fonte estivale de la banquise était à une latitude de 83 °N, près de 1.000 km au nord de sa position actuelle. Avec ces données, la taille de la surface englacée toute l’année calculée par simulation semble avoir atteint alors à peine 50 % du minimum record de 2007. À partir d’il y a 6.000 ans, l’englacement augmente à nouveau jusqu’à un maximum il y a 2.500 ans. Puis le climat reste globalement frais durant une dernière phase caractérisée par des modifications rapides de la provenance de la glace.

Une partie de la période plus chaude appelée « optimum climatique médiéval » est nettement marquée entre 1100 et 1400 de notre ère, ainsi que le « petit âge glaciaire », plus froid, après 1400.

Svend Funder fait remarquer que le point de non-retour de la banquise au-delà duquel elle ne se reconstitue pas n’a pas été atteint avec des surfaces englacées moitié moindres que lors du minimum de 2007. Les conséquences d’un réchauffement limité semblent donc peut-être plus réversibles que prévu. Reste à savoir si le réchauffement sera limité…

On s'attend quand même à une diminution record des glaces et ce n'est bien sûr pas aujourd'hui le problème mais son aggravation dans les années à venir.

- Migrations climatiques : 17km par décennie

Avec en moyenne 17 km d’avancée par décennie (soit plus de 20 cm par heure vers le nord dans l’hémisphère nord), cette migration vers les hautes latitudes serait trois fois plus rapide que prévue !

En quittant les moyennes et en regardant en détail les données, les chercheurs ont été surpris de constater que tous les groupes (oiseaux, végétaux, insectes ou mammifères) ont un déplacement similaire. Les écosystèmes migrent. En revanche, à l’échelle de l’espèce, les mouvements peuvent être contradictoires. En vingt ans, un petit passereau, la bouscarle de cetti (Cettia cetti) s’est par exemple déplacé de 150 km vers le nord, pendant que le bruant zizi (Emberiza cirlus) descendait de 120 km. La réaction de chaque taxon dépend de ses exigences et capacités d’acclimatation à un nouvel environnement.

- El Niño favoriserait les conflits armés

C'est une corrélation statistique assez nette sans véritable explication.

- Un fleuve souterrain sous l'Amazone

Des scientifiques brésiliens ont découvert un fleuve souterrain qui coule sous l'Amazone, à 4.000 mètres de profondeur.

Grâce à cette découverte les chercheurs ont conclu que "la région amazonienne possède deux systèmes d'écoulement d'eau : le drainage fluvial à la surface qui forme l'Amazone et le flux des eaux souterraines à travers des couches sédimentaires profondes", qui forme le fleuve baptisé "Hamza".

"Il est probable que l'écoulement de ce fleuve souterrain d'eau douce soit responsable de la faible salinité de la mer dans la région de l'embouchure de l'Amazone".

Sciences et Avenir conteste cette présentation :

Une rivière souterraine coule-t-elle sous l'Amazone, l'immense fleuve brésilien? Pas exactement, même si des chercheurs affirment avoir découvert un important système hydrologique.

Cependant ce flot n’est pas une rivière ou un fleuve à proprement parler –malgré le terme de «fleuve souterrain» employé par les chercheurs eux-mêmes pour présenter leurs travaux- mais plutôt un écoulement d’eau à travers un milieu poreux.

- Fertiliser l'océan avec du fer pour absorber le CO2

Des expériences décevantes avaient montré qu'il ne servait à rien de fertiliser l'océan avec du fer, notamment par manque d'autres nutriments mais l'histoire du climat semble prouver le contraire les périodes froides se caractérisant par de plus grandes quantités de fer, ce qui suggère de reprendre les expériences sur une plus large échelle (cependant, il ne semble pas que ce soit réversible?).

Des expériences décevantes avaient montré qu'il ne servait à rien de fertiliser l'océan avec du fer, notamment par manque d'autres nutriments mais l'histoire du climat semble prouver le contraire les périodes froides se caractérisant par de plus grandes quantités de fer, ce qui suggère de reprendre les expériences sur une plus large échelle (cependant, il ne semble pas que ce soit réversible?).

- La Nasa parie sur l'hydrogène métallique

- Stocker la chaleur solaire dans du sel fondu

- Une verrière photovoltaïque qui garde la fraîcheur

L'appareil est constitué d'une matrice de lentilles en verre qui concentrent la lumière solaire directe sur étroites, bandes opaques de cellules photovoltaïques en arséniure de gallium et de germanium.

- Un solvant plus efficace pour récupérer le pétrole des sables bitumineux

On n'échappera donc pas à leur exploitation et à la prolongation déraisonnable de l'ère du pétrole.

- Transformer le sucre en butane

- Convertir l'énergie des pieds en électricité

Des niveaux de puissance beaucoup plus élevées qu'avec le piézoélectrique pourraient être produits avec des flux microscopiques de gouttelettes de métal semblable au mercure (Galinstan). Un tel dispositif d'électro-mouillage "inversé" dans les chaussures produirait jusqu'à 10 watts (il suffirait d'une prise usb dans la chaussure pour alimenter un mobile).

Des niveaux de puissance beaucoup plus élevées qu'avec le piézoélectrique pourraient être produits avec des flux microscopiques de gouttelettes de métal semblable au mercure (Galinstan). Un tel dispositif d'électro-mouillage "inversé" dans les chaussures produirait jusqu'à 10 watts (il suffirait d'une prise usb dans la chaussure pour alimenter un mobile).

Voir aussi Technology Review.

- Les data centers de moins en moins énergivores

Entre 2000 et 2005, les data centers mondiaux ont vu leurs dépenses énergétiques exploser. L’expansion de l’Internet et l’informatisation de la société devaient aboutir à un doublement de leur consommation de 2005 à 2010. Or le phénomène s’est ralenti sur cette période (56% d’augmentation).

L’émergence de technologies informatiques et la virtualisation des serveurs (Cloud) ont contribué à la diminution de leur nombre et de ce fait à la baisse de consommation énergétique.

Google serait responsable de moins de 1% de l’électricité utilisée par l’ensemble des Datas centers. Au niveau mondial, la consommation de la firme est également minime, elle ne représente que 0.1% de l’utilisation totale d’électricité. Google étant plus que discret ces dépenses, ces données restent des suppositions extrapolées à partir des informations de l’entreprise.

- En Dordogne, on roule à la graisse de canard !

Contrairement aux agrocarburants de première génération, la valorisation des déchets gras ne concurrence pas les cultures destinées à l'alimentation humaine.

Ce sont ainsi près de 1.500 tonnes de déchets gras qui pourraient être valorisés chaque année dans le département, de quoi produire environ un million de litres de biodiesel. Pour réaliser la transformation, Jules Charmoy a sa recette : « dans un estérificateur, on chauffe la graisse à 120° pour éliminer l'eau. On réduit ensuite à 65°, on met de l'alcool et de l'hydroxyde de potassium. On agite pendant une heure, on laisse décanter : au fond, la glycérine se forme avec, au-dessus, le biodiesel ».

Même avec l'accord des douanes, le mélange final dans le réservoir ne doit pas dépasser 30 % de carburant « maison » pour 70 % provenant d’un produit pétrolier classique.

L'intérêt n'est à l'évidence pas d'ordre économique quand le coût de production atteint 1,11 euro le litre contre 0,92 centime pour le gasoil agricole. Pour eux, l’important est de montrer qu’il est possible de transformer certains déchets en ressources locales et de produire un agrocarburant qui ne cause pas de nouveaux problèmes écologiques.

- Dans 6 mois, de la viande de laboratoire

On avait parlé de la possibilité de produire des steaks synthétiques en cultivant des cellules animales au lieu de tuer des animaux, la commercialisation pourrait être assez rapide. Si le goût n'est pas trop mauvais, ce serait une bonne nouvelle pour l'écologie car la viande rouge nécessité trop de ressources.

Voir aussi The Telegraph qui précise que le premier steak synthétique aura tout de même un prix de revient supérieur à £200,000 !

Futura-Sciences apporte ces précisions sur le bilan écologique attendu :

- une réduction de la consommation d'énergie de 45 % ;

- une réduction des émissions de gaz à effet de serre de 96 % ;

- une réduction de la superficie qui doit être utilisée de 99 % ;

- une réduction de la consommation d'eau de 96 %.

- Faire pleuvoir avec des lasers

Lorsque l'air est humide, des lasers pourraient déclencher la pluie en créant de l'acide nitrique. On pourrait aussi utiliser les lasers pour empêcher la pluie...

- Une machine à fabriquer de l'eau

Baptisée "The Drought Master", cette machine aspire l'air humide pour le condenser, puis laisse repartir le gaz pour ne retenir au final seulement l'eau, qui est ensuite filtrée pour être prête à boire. "Cette eau ne provient pas du sol mais uniquement de l'air" explique Terry LeBleu. "Nous avons des océans d'eau à notre disposition dans l'air, tout ce qu'il y a faire c'est de parvenir à la capturer", poursuit-il.

Afin de parvenir à fabriquer de l'eau avec ce système ingénieux, il faut brancher le Drought Master sur une prise secteur et attendre simplement que la machine fasse le reste! Elle peut ainsi produire cinq à sept litres d'eau claire par jour, tout à fait propre à la consommation. Elle ne contient ni métaux comme le zinc ou le cuivre, ni de bactéries. Terry LeBleu affirme même que la compagnie chargée d'analyser la qualité de son eau a pu la comparer à de l'eau distillée stérilisée.

- Dépolluer l'eau en produisant de l'électricité

.gif)

Des chercheurs chinois ont justement réussi un pas dans le sens du traitement « utile », puisqu'il produit de l'électricité. Il s'agit d'une sorte de pile à combustible photo-catalytique. L'énergie lumineuse dégrade la matière organique et génère au passage des électrons qui passent à travers la cathode : l'électricité est ainsi créée. Leur procédé utilise de plus la lumière naturelle plutôt que des UV.

Par contre les usines biologiques de traitement de l'eau rejettent trop de protoxyde d'azote.

En moyenne, environ 60 % des poissons vivant en aval de l’usine présentaient à la fois des caractères sexuels mâles et femelles, contre 5 % en amont.

- Un maïs OGM cible d'un insecte auquel il devait résister

Un insecte vorace que combattent depuis longtemps les cultivateurs de maïs en Amérique du Nord se régale d'une variété répandue d'OGM conçue pour aider à éradiquer cette chrysomèle.

Après des années d'échecs, une entreprise américaine teste cette technique qui fait craindre de nouveaux risques de prolifération.

Biologie

évolution, génétique, biodiversité, éthologie, anthropologie, neurologie

- Les composants de la vie viennent bien de l'espace

Dans ces nouveaux travaux, les chercheurs de la Nasa ont analysé des échantillons de douze météorites riches en carbone, dont neuf qui ont été récupérées en Antarctique. Ils ont constaté la présence d'adénine et de guanine, qui forment l’ADN.

Ce n'est qu'une confirmation de ce qu'on savait au moins depuis 2007 (confirmé déjà en 2008), renforçant l'hypothèse de la "panspermie" ou plutôt que les composants de la vie sont les mêmes partout dans l'univers car, s'il est possible que des bactéries aient traversé l'espace, il est plus probable que la vie se recrée à chaque fois à partir des mêmes bases ou presque. Si la création de la vie est locale, il peut y avoir des variations dans ses constituants mais dans une gamme limitée. On a l'illustration encore une fois qu'il ne suffit pas d'avoir un esprit critique, "ouvert" à la diversité des formes de vie pour avoir raison. La vie est d'une diversité infinie mais ses constituants sont à peu près toujours les mêmes, permettant justement cette diversité.

S'il est important de trouver de l'adénine dans les météorites, c'est que sa synthèse est très difficile et ne paraît pas pouvoir être spontanée alors que c'est une molécule clé, intervenant dans l'ADN et l'ARN mais aussi dans l'ATP fournissant l'énergie de la cellule. On a trouvé d'autres éléments comme des acides aminés dans des météorites mais une partie a dû être synthétisée sur place. A partir de là, des ARNs ont pu se constituer, jusqu'à former des ribosomes qu'on retrouve dans toutes les cellules aussi et donc peut-être sur les autres planètes ?

Voir aussi Futura-Sciences.

- Confirmation du monde ARN à l'origine de la vie

Il semble de plus en plus probable que ce soient bien des ARN autocatalytiques qui soient à l'origine de la vie bien qu'il soit très difficile de synthétiser l'ARN et qu'il a peut-être été précédé de précurseurs plus faciles à produire (TNA, PNA ou ANA), notamment avec du phosphate. Il se pourrait aussi que cela se soit produit dans la glace où l'ARN est plus stable.

Il semble de plus en plus probable que ce soient bien des ARN autocatalytiques qui soient à l'origine de la vie bien qu'il soit très difficile de synthétiser l'ARN et qu'il a peut-être été précédé de précurseurs plus faciles à produire (TNA, PNA ou ANA), notamment avec du phosphate. Il se pourrait aussi que cela se soit produit dans la glace où l'ARN est plus stable.

- De l'importance des ARN non codants

Chez l'Homme par exemple, les gènes codants ne représentent que 2% du génome, laissant un immense réservoir de séquences dont le rôle n'a encore jamais été caractérisé avec certitude.

Le développement des techniques de séquençage à très haut-débit a par la suite dévoilé que la quasi-totalité du génome est transcrite de manière pervasive, générant de multiples familles d'ARNs non-codants de taille variée, dont l'immense potentiel régulateur reste à découvrir. De récentes études ont montré que certains de ces ARNs non-codants jouent un rôle clé dans la carcinogénèse, en tant que suppresseurs de tumeur ou oncogènes.

L'équipe d'Antonin Morillon du laboratoire Dynamique de l'information génétique: bases fondamentales et cancer a été l'une des premières à avoir décrit, chez la levure bourgeonnante Saccharomyces cerevisiae, la régulation épigénétique exercée par deux grands ARNs non-codants instables impliqués dans le contrôle de la prolifération des transposons et de l'expression de gènes.

En effet, Plus de 1 600 ARNs non-codants y ont été identifiés, augmentant d'environ 30% la connaissance globale des gènes de la levure. Ces ARNs ont été appelés "Xrn1-sensitive unstable transcripts (XUTs)", du fait de leur capacité à être dégradés essentiellement par la nucléase cytoplasmique Xrn1. Les chercheurs ont également prouvé que ces ARNs sont transcrits en anti-sens des gènes et peuvent, dans certains cas, en contrôler l'expression via un mécanisme faisant intervenir une histone méthyle transférase.

Voir aussi Technoly Review sur le rôle des grands ARNs non codants, appelés lincARNs, dans le développement de l'embryon et ci-dessus.

- La vie la plus ancienne sur les plages ?

Ce sont seulement les plus anciennes traces de vie qu'on connaît (3,43 milliards d'années!) qui seraient très semblables à des bactéries avec des coques en silice qu'on trouve actuellement en couches noires sous les surfaces de sable fin mais l'environnement était très différent à l'époque, notamment par l'absence d'oxygène remplacé par le soufre. Ce qui est intéressant, c'est surtout de trouver un véritable fossile vivant qui semble très proche de ces bactéries originelles, bien qu'il ait dû forcément évoluer depuis ces temps reculés mais cela ne veut pas dire qu'il était le premier organisme vivant ni que la vie serait née sur une plage.

Voir aussi Sciences et Avenir. Futura-Sciences est beaucoup plus critique.

- Les mêmes contraintes conduisent aux mêmes évolutions

Les vers du genre Caenorhabditis – ainsi que de nombreux nématodes – ont un cycle de vie un peu particulier. Au stade larvaire, ils sont capables de détecter s’ils vont devoir lutter pour accéder aux ressources alimentaires, à l’image du quorum sensing chez les bactéries, grâce à des phéromones envoyées par leurs congénères. Si ceux-ci sont en nombre important ou si les ressources sont faibles, ils vont se plonger dans un état larvaire spécial, appelé larve dauer, qu’ils peuvent garder plusieurs mois et pendant lequel grand nombre de leurs fonctions se bloquent, réduisant à peu de chose leur consommation d’énergie. Ils peuvent ensuite revenir à la forme adulte quand l’environnement est moins hostile ou moins concurrentiel.

Mais les scientifiques ont observé que certaines populations de Caenorhabditis elegans faisaient fi des signaux envoyés et passaient directement au stade adulte. En effet, cela peut leur conférer un avantage, puisque malgré la forte densité, les ressources alimentaires en laboratoire sont toujours suffisantes.

Les scientifiques ont découvert que cette adaptation était le fruit de la perte de deux gènes responsables de la synthèse et du fonctionnement d’un récepteur aux phéromones émises par les vers.

Ils ont découvert que pour C. briggsae aussi, la perte d’un gène conférait cette capacité et en le comparant aux deux gènes perdus par C. elegans, ils se sont rendu compte qu’ils étaient le fruit de l’évolution d’un gène commun appartenant à leur ancêtre. En conclusion, alors qu’une centaine de gènes sont responsables du déclenchement du stade dauer, c’est le même gène qui a été modifié chez ces deux espèces.

Ce n'est pas une loi générale, seulement une probabilité mais qui rejoint les phénomènes de convergence pour montrer que le rôle du hasard n'est pas si grand ou plutôt qu'il n'a qu'une fonction variationnelle d'exploration des possibles mais que les formes du vivant et la logique de l'évolution sont presque entièrement déterministes, à partir du résultat, du réel, des contraintes effectives, de l'environnement, ce qui confirme aussi que la vie ailleurs ne serait pas si différente...

- De l'importance de la biodiversité