- L'imprimerie nanométrique

- Le solaire : toujours plus

- Le CyCab, une voiture sans conducteur

- Google rend possible l'impression de livres épuisés

<- Revue des sciences précédente | Revue des sciences suivante ->

Revues : Pour la Science - La Recherche - Sciences et Avenir - Science&Vie

Brèves : Physique - Climat - Biologie - Santé - Technologie

Le fait que la faiblesse actuelle du soleil nous expose aux rayonnements cosmiques me semble ne pas être pris assez en compte, en particulier pour les équipements électroniques mais les risques ont beau être faibles, ils pourraient aller bien au-delà ! A part ça, rien de bien nouveau ce mois-ci même s'il y a comme toujours quelques bons articles mais ni la spécialisation des hémisphères cérébraux, ni le rôle du hasard en biologie ne sont des découvertes. Reste qu'il est amusant de savoir qu'on ne réagirait pas de la même façon à une agression venant de la droite ou de la gauche ! Ce qui semble le plus novateur, le fait que l'antimatière pourrait "antigraviter", est une hypothèse audacieuse mais bien peu probable, alors qu'il y a de plus en plus d'arguments pour la supersymétrie. Par contre, on peut s'inquiéter de la prolifération nucléaire avec des centrales nucléaires flottantes ! Les migrations humaines reconstituées avec la génétique confirment notre histoire qui semble commencer il y a 60 000 ans en Afrique de l'Est mais il n'y a pas que Néandertal qui a disparu devant cette nouvelle espèce, c'est aussi le cas des anciennes populations devant les premiers agriculteurs... Qu'on trouve de l'eau sur Mars et même sur la Lune rend un peu plus probable de nouvelles migrations interplanétaires. Sinon, à peine on parle d'imprimantes capables d'imprimer des livres en 5mn que Google propose l'impression de livres épuisés mais Asus, l'inventeur des Netbooks eeepc, réinvente à la fois l'eBook et le portable. La poudre de verre pourrait démocratiser aussi l'impression 3D. On peut se réjouir enfin que la question du recyclage et de la consommation des appareils numériques commence à être prise en compte, l'arrivée des écrans LED faisant partie des bonnes nouvelles avec les progrès constants du solaire. Les voitures sans conducteurs, qui viennent devant chez vous quand on les appelle, semblent plus problématiques mais des expériences commencent ! On n'est pas tiré d'affaire pour autant car si nous entrons incontestablement dans l'ère de la transition énergétique, la fin de l'ère du pétrole (et du charbon) n'est pas pour demain. Dans l'immédiat ce sera surtout l'ère de l'énergie chère sans que cela ne puisse empêcher de dépasser les 2°C, voire les 4°C, et un emballement climatique. Le plus absurde, c'est qu'on va à la catastrophe alors qu'on aurait les moyens économiques et techniques de l'éviter. Ce qui manque, ce sont les moyens intellectuels, politiques et sociaux. Le maillon faible, c'est le facteur humain, plus précisément notre intelligence collective et notre existence en tant que société.

Pour la Science no 384, Nager dans l'espace-temps

- Dématérialiser les biens de consommation, p20

Dominique BOURG

En vendant l'usage des biens plutôt que les biens eux-mêmes, l'industrie réduirait les quantités de matières et d'énergie utilisées. Une nouvelle ère pour nos modes de consommation ?

Schématiquement, trois façons de dématérialiser la production ont été expérimentées à petite échelle : l'écoconception, l'écologie industrielle et l'économie de fonctionnalité.

L'écoconception vise à limiter l'impact environnemental des produits à chaque étape de leur cycle de vie : fabrication, distribution, utilisation, valorisation ultime. Les produits doivent être conçus pour être économes en matières premières et en énergie, de longue durée de vie, biodégradables ou recyclables, et doivent prendre en compte des normes sanitaires strictes.

La deuxième approche est l'écologie industrielle. Différentes entreprises d'un même site, ou « écoparc », échangent des matériaux et de l'énergie, et chaque maillon de la chaîne y trouve un intérêt.

La troisième façon de dématérialiser la production est l'économie de fonctionnalité : on substitue à la vente d'un bien celle de sa fonction, c'est-à-dire du service rendu.

Ce système suscite une dématérialisation de deux façons. Compte tenu du partage de chaque véhicule par plusieurs adhérents, le nombre de voitures nécessaires pour une même distance parcourue est inférieur à ce qu'il serait si chaque utilisateur était propriétaire de sa voiture. En outre, chaque abonné est incité à n'y recourir qu'en cas de besoin réel.

La vente de l'usage des biens s'applique aussi aux relations d'entreprise à entreprise. Ainsi, depuis 2002, le fabricant de pneumatiques Michelin offre aux entreprises de poids lourds un service de location de pneus, facturé au kilomètre.

La Société Michelin a annoncé que de nouveaux pneus, conçus pour durer plus longtemps, seront commercialisés prochainement, exclusivement au kilomètre. De tels objets coûtent plus cher, et trouvent donc plus difficilement des acquéreurs à l'unité.

Rien de nouveau, mais bon à rappeler...

- Quand le cerveau a perdu sa symétrie, p32

Chez l'homme, chaque hémisphère cérébral accomplit des tâches précises ; cette latéralisation ne serait pas propre à l'être humain et serait apparue il y a 500 millions d'années chez les premiers vertébrés.

Ce qu'on avait pris pour une caractéristique humaine serait en fait presque universellement partagée ! Alors qu'on avait pensé que cette division du travail était causée par le langage, elle éclaire au contraire son apparition à partir de la mastication !

La production des syllabes résulterait d’une évolution du comportement routinier de mastication, contrôlé par la moitié gauche du cerveau depuis le début de l’évolution des mammifères il y a 200 millions d’années.

Nous pensons que l’hémisphère gauche du cerveau des vertébrés contrôlait initialement des comportements bien établis associés à des conditions ordinaires et familières. Au contraire, l’hémisphère droit, le siège de la vigilance émotionnelle, était spécialisé pour détecter les stimulus environnementaux inattendus et réagir de façon pertinente.

Une des conséquences les plus amusantes, c'est qu'on ne réagirait pas de la même façon à ce qui vient de la droite ou de la gauche !

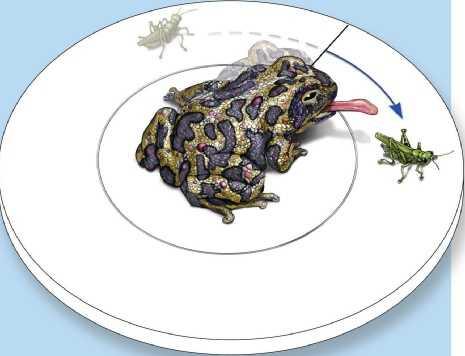

Certains animaux ont tendance à ne manger une proie que si elle est située à leur droite, c'est-à-dire sous contrôle de l'hémisphère gauche.

Conformément à notre hypothèse, les poissons, les amphibiens, les oiseaux et les mammifères présentent tous une réaction d’évitement des prédateurs qui est plus importante lorsqu’ils voient ces derniers dans la partie gauche de leur champ visuel (correspondant à l’hémisphère cérébral droit) plutôt que dans leur champ visuel droit.

Le serpent placé à droite du crapaud n'engendre aucune réaction alors que le serpent placé à gauche le fait fuir.

Même en l’absence de danger, de nombreux vertébrés gardent un œil gauche attentif à un éventuel prédateur.

C'est d'ailleurs pour cela qu'il est nécessaire qu'il y ait quand même des gauchers, pour tromper l'ennemi, bien que la prévalence des droitiers (de l'hémisphère gauche donc) semble presque universelle, surtout pour les animaux sociaux, favorisant la prévisibilité des réactions.

Chez l’homme, ces comportements primitifs d’évitement et de méfiance se sont transformés en un panel d’émotions négatives. Au XIXe siècle, les médecins avaient déjà noté que les patients se plaignaient plus souvent de paralysie des membres du côté gauche que du côté droit lors de crises d’hystérie. Quelques données suggèrent que l’hémisphère droit contrôle les pleurs et les cris de l’homme – par opposition aux vocalises émotionnellement neutres gérées par l’hémisphère gauche. En outre, on a plus de risques d’être déprimé après une lésion de l’hémisphère gauche que de l’hémisphère droit. Et dans les états de dépression chronique, l’hémisphère droit est plus actif que le gauche.

Les premiers vertébrés devaient aussi réagir vite face à d'autres membres de leur propre espèce. Chez les poissons et les oiseaux, l'hémisphère droit leur permet de reconnaître leurs compagnons et il contrôle le comportement social. Chez l'homme, le rôle de l'hémisphère droit dans la perception des visages pourrait provenir de cette capacité des vertébrés à reconnaître d'autres individus de leur espèce.

Chez les êtres humains, l'hémisphère droit traite une scène dans son ensemble, plutôt que de se focaliser sur un nombre limité de détails. Cette capacité lui permet d'analyser des relations spatiales. Les faits mémorisés par l'hémisphère droit tendent à être organisés et rappelés comme des configurations globales. Au contraire, l'hémisphère gauche s'intéresse aux aspects locaux de son environnement.

En général, les hommes ouvrent aussi davantage le côté droit de leur bouche lorsqu’ils parlent (car le côté droit du visage est plus activé par l’hémisphère gauche).

- Une folie mathématique, p86

Jean-Paul DELAHAYE

Qu'on puisse démontrer que (presque) tout est prévisible est inquiétant, et devrait faire douter de certains axiomes qui, sous des dehors innocents, produisent de graves absurdités.

Ce résultat final n’est-il pas dément ? L’axiome du choix permet, sauf de manière négligeable, de prédire une tranche du futur, en n’utilisant qu’une tranche finie du passé et cela même si l’univers n’est qu’une suite totalement désordonnée d’états se succédant sans la moindre règle.

Il est évident que connaître le passé est inutile dans un univers aléatoire sans aucune loi! Pourtant ici c’est utile, et cela permet de connaître presque parfaitement le futur!

Comment survivre – mathématiquement – à cette folie, assimilable à la lecture d’une boule de cristal, qui semble nous dire que d'un point de vue mathématique, la prédiction est toujours possible... et qu’il n’est même pas nécessaire d'identifier des structures intelligibles dans le monde, ni même la moindre régularité dans la succession des états du passé ?

Plusieurs stratégies de défense sont envisageables pour retrouver le sommeil. Nous en présentons une petite liste sans chercher à trancher la question qui semble exiger de délicates précautions et qui, à n'en pas douter, suscitera de nombreux commentaires.

■ Renoncer à l'infini ou au moins à certains de ses usages.

■ Renoncer à la théorie des ensembles ou aux mathématiques.

■ Renoncer seulement à l'axiome du choix.

■ Arguer que les ensembles d'erreurs dans nos paradoxes sont tels, que ces erreurs rendent sans intérêt les prédictions du joueur temporel.

■ Arguer que les états possibles du monde que nous exigeons de modéliser comme élément d'un ensemble fixé ne sont pas réductibles ainsi.

■ Évoquer la relativité générale ou la mécanique quantique.

Ces extraordinaires nouveaux paradoxes montrent que la théorie habituelle des ensembles est un outil général, commode, mais parfois déraisonnable pour représenter le monde et notre situation dans le monde. Il faut se méfier des représentations mathématiques qui utilisent sans retenue l'infini non constructif, dont l'axiome du choix n'est qu'un aspect.

L’axiome du choix dans sa forme la plus simple affirme l’évidence suivante : si un ensemble d’ensembles non vides et deux à deux disjoints est fixé, par exemple E=

0,1, 2, 3, ...}, {a, b}, {P Q, R, alors il existe au moins un ensemble C ayant un élément commun avec chaque ensemble de E, ici, par exemple, C = {276, a, R}. L’ensemble C est obtenu en choisissant un élément dans chaque ensemble de E, d’où le nom de l’axiome.

Cette capacité déraisonnable de prédiction mathématique évoque la modélisation financière, dont Ivar Ekeland montre les limites dans un autre article (p19), mais aussi le fait qu'en prévoyant que le temps de demain sera le même que celui d'aujourd'hui on a toujours la plus grande chance d'avoir raison, ce qui n'empêche pas le temps de changer et d'être le changement même...

Il faut rendre hommage ici à Jean-Paul Delahaye dont je ne comprends pas souvent les articles mais qui arrive à nous initier un peu quand même aux questions mathématiques dans leur actualité et leurs enjeux.

La Recherche no 434, Le hasard au coeur de la vie

Ce n'est pas vraiment nouveau pour nous, puisque ce sont les thèses de Jean-Jacques Kupiec qui sont enfin reconnues ici mais s'il est primordial de comprendre que l'ordre biologique est basé sur un désordre sous-jacent, ce qui est beaucoup plus robuste qu'un ordre qui serait dérangé par une infime déviation, il me semble qu'on rate l'essentiel à ne pas voir que cet ordre procède de l'information comme finalité dirigée vers l'extérieur, attracteur canalisant les dynamiques locales en se réglant sur l'effet, sur l'extérieur, sur les sens.

Ce n'est pas vraiment nouveau pour nous, puisque ce sont les thèses de Jean-Jacques Kupiec qui sont enfin reconnues ici mais s'il est primordial de comprendre que l'ordre biologique est basé sur un désordre sous-jacent, ce qui est beaucoup plus robuste qu'un ordre qui serait dérangé par une infime déviation, il me semble qu'on rate l'essentiel à ne pas voir que cet ordre procède de l'information comme finalité dirigée vers l'extérieur, attracteur canalisant les dynamiques locales en se réglant sur l'effet, sur l'extérieur, sur les sens.

C'est donc assez différent du rapport entre fluctuations quantiques et stabilité macroscopique, même si c'est aussi par effet de masse que la programmation génétique pouvait apparaître mécanique, mais lorsqu'on a pu observer les cellules individuellement, la variabilité est apparue flagrante.

C'est assez différent aussi de la "sélection naturelle" dès lors qu'on est dans un organisme et donc soumis à des régulations, plus près de la sélection artificielle (ce que Jean-Jacques Kupiec appelle l'hétéro-organisation pour l'opposer à l'auto-organisation), et donc finalement extrêmement déterministe malgré l'impression trompeuse d'à peu près.

C'est assez différent aussi de la "sélection naturelle" dès lors qu'on est dans un organisme et donc soumis à des régulations, plus près de la sélection artificielle (ce que Jean-Jacques Kupiec appelle l'hétéro-organisation pour l'opposer à l'auto-organisation), et donc finalement extrêmement déterministe malgré l'impression trompeuse d'à peu près.

En fait le hasard joue un rôle à tous les niveaux et notamment dans le fonctionnement du cerveau, ce qui n'empêche pas que la vie soit une création de l'ordre à partir de l'ordre (et non pas de l'ordre à partir du désordre) mais qui lui permet d'être à la fois reproduction et évolution, le hasard jouant un rôle d'exploration et d'ajustement qui est la dynamique de la vie elle-même dans sa confrontation au milieu. On est loin de "la fin du déterminisme en biologie" (p40) !

Par contre, c'est un argument supplémentaire pour la théorie métabolique du cancer, qui serait causé par un déséquilibre des tissus et de la sélection darwinienne plus que par des mutations génétiques, l'inflammation pouvant être le facteur déterminant, mais il y a sans doute plusieurs sortes de cancers dont certains purement génétiques, d'autres à virus...

Sciences et Avenir no 752, Manger sain

- Un centrale nucléaire flottante !, p82

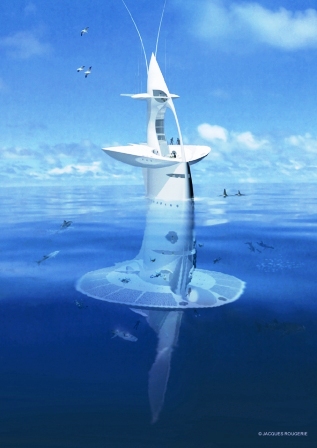

Construire une centrale nucléaire de poche, flottante et capable de vous suivre partout où vous en avez besoin pour distribuer son énergie... Le pari paraît fou ! Il est pourtant en train de se réaliser depuis mai sur les chantiers navals russes de Baltiski Savod, à Saint-Pétersbourg. Baptisée Academic Lomonosov, cette centrale nucléaire, première du genre, se compose d'une barge d'acier de 144 mètres de long et 30 de large, sur laquelle seront installés deux réacteurs compacts à eau pressurisée KLT-40S - des réacteurs sûrs, que l'on trouve d'ordinaire sur les brise-glace et les sous- marins. Les promoteurs du projet aiment à rappeler que l'un de ces réacteurs équipait le Koursk , de sous-marin nucléaire qui sombra en mer de Barents, en août 2000. Une explosion ravagea le bâtiment, mais le réacteur demeura en état de marche. Une fois achevée, l'installation sera remorquée jusqu'à sa destination finale, où elle sera stabilisée sur des pilotis, éventuellement protégée par une digue et branchée au réseau électrique local. Certes, les deux réacteurs ? - d'une puissance électrique de 35 mégawatts chacun - sont 10 à 15 fois moins puissants qu'une centrale nucléaire classique; mais ils seraient suffisants pour alimenter en énergie une ville de 200 000 habitants pendant une durée d'exploitation de quarante ans.

- «L'Etat doit défendre le pluralisme moral»

Entretien avec Ruwen Ogien

La gestation pour autrui, tout comme les relations homosexuelles entre adultes consentants ou l'usage personnel de stupéfiants sont sanctionnés par la loi dans de nombreux pays. Mais où sont les victimes ? Où sont les personnes physiques, concrètes, qui subissent des dommages «contre leur gré» ? On peut se demander aussi : «Où est le crime ?», puisqu'il n'y a pas de victimes.

Comme il protège et défend le pluralisme religieux, l'Etat doit protéger et défendre le pluralisme moral c'est-à-dire le droit de chacun de vivre selon ses convictions morales profondes, dans la mesure où elles ne causent pas de torts aux autres.

Que pensez-vous du bilan des Etats généraux de la bioéthique qui se sont achevés en juillet ?

Ce débat public n'a été ni ouvert ni démocratique. Aucune personnalité étrangère n'a été convoquée, ni aucune des principales personnes concernées (couples infertiles qui ont fait ou voulu faire appel à des mères porteuses par exemple...) Ce qui va rester, c'est un mélange de dogmatisme (un seul modèle familial est possible), de paternalisme (seuls les «experts» en éthique ont la parole) et de chauvinisme (les «Anglo-Saxons» sont des barbares). On ne pouvait faire pire.

Science&Vie no 1105, Antimatière

De quoi est fait l'Univers ? De matière ordinaire et, selon la théorie actuelle, de matière noire et d'énergie noire.....dont nul ne sait rien ! Et s'il s'agissait plutôt d'antimatière ? Car elle permet de réécrire l'histoire du cosmos sans déroger à ses lois et, cette fois, sans nulle zone d'ombre. Reste à vérifier qu'elle antigravite bien...

On est partagé entre l'incrédulité et l'admiration car toute une série de mystères seraient résolus d'un coup : l'absence incompréhensible d'antimatière supposant une violation de parité problématique mais c'est aussi l'improbable inflation, la matière noire et l'énergie noire qui deviendraient inutiles et ceci sans faire intervenir aucune particule exotique, puisque l'antimatière est fabriquée depuis longtemps dans les accélérateurs. Le seul hic, mais il est de taille, c'est de supposer une antigravité assez difficile à concevoir, les atomes d'antimatière étant supposés se repousser, au contraire de la matière qui s'agglutine (on pourrait peut-être faire alors de ce point de vue un parallèle entres bosons et matière, comme entre fermions et antimatière?). Ce n'est pourtant pas si incompatible avec la relativité générale qu'on peut le penser à première vue puisqu'une solution des trous noirs débouchant sur des fontaines blanches suppose cette antigravité en même temps que la matière se transforme en antimatière. De quoi au moins tester le comportement gravitationnel de l'antimatière, ce qui n'avait jamais été fait...

Un résultat de ce mois-ci semble plaider cependant plutôt pour une modification de la loi de Newton car la matière noire semble liée à la matière visible !

« Nous avons découvert une étroite corrélation entre la densité de matière visible et la taille du halo de matière noire. Ces deux quantités sont liées de manière à ce que la force gravitationnelle engendrée par la matière visible soit toujours la même au rayon caractéristique du halo de matière noire »

D’autres astrophysiciens remettent en cause l’existence de la matière noire. Selon eux, Einstein et Newton se sont fourrés le doigt dans l’œil et la gravité est plus importante à l’échelle galactique que ce qu’ils avaient prévu. « Dans ce cas, il serait logique que la force supplémentaire qu'on attribue généralement à la matière noire soit intimement liée à la distribution de matière visible, puisque la matière visible en serait alors l'unique source ».

Sinon, un article (p76) met en cause l'objectif de limitation du réchauffement à 2°C qu'il vaudrait certes mieux réduire à 1.5°C, sauf qu'on ne voit pas comment on arrivera à moins de 2°C et qu'à partir de cette température, comme on passe le maximum depuis la dernière glaciation, on risque un emballement fatal !

Sinon, un article (p76) met en cause l'objectif de limitation du réchauffement à 2°C qu'il vaudrait certes mieux réduire à 1.5°C, sauf qu'on ne voit pas comment on arrivera à moins de 2°C et qu'à partir de cette température, comme on passe le maximum depuis la dernière glaciation, on risque un emballement fatal !

L'article (p98) sur l'homme de Florès est intéressant en ce qu'il ne serait pas impossible que ce soit finalement un australopithèque, ou un homo très archaïque, à la frontière entre les deux. Il devait en exister ailleurs et l'on se prend à rêver à la rencontre des hommes avec ces petits hobbits velus !

J'ai été étonné aussi du fait que Philippe Marlière (p154) ne croit pas qu'il puisse y avoir de la vie ailleurs, sa complexité étant trop improbable, ce qui n'est pas la position la plus commune actuellement chez les biologistes, comme Christian de Duve, qui pensent au contraire que la vie est automatique quand les conditions sont remplies. La complexité est cumulative et s'il est impensable qu'un haut niveau de complexité surgisse tel quel (ce que soutiennent pourtant les partisans de l'auto-organisation), il en est tout autrement après le travail de millions d'années (certains pensent qu'il suffit même de beaucoup moins pour arriver à la cellule bactérienne, ce qui n'est pas mon avis les 2 milliards d'années séparant les premières cellules bactériennes des cellules à noyaux donnant la mesure du temps nécessaire qui est effectivement fonction de la complexité et de l'improbabilité).

J'ai été étonné aussi du fait que Philippe Marlière (p154) ne croit pas qu'il puisse y avoir de la vie ailleurs, sa complexité étant trop improbable, ce qui n'est pas la position la plus commune actuellement chez les biologistes, comme Christian de Duve, qui pensent au contraire que la vie est automatique quand les conditions sont remplies. La complexité est cumulative et s'il est impensable qu'un haut niveau de complexité surgisse tel quel (ce que soutiennent pourtant les partisans de l'auto-organisation), il en est tout autrement après le travail de millions d'années (certains pensent qu'il suffit même de beaucoup moins pour arriver à la cellule bactérienne, ce qui n'est pas mon avis les 2 milliards d'années séparant les premières cellules bactériennes des cellules à noyaux donnant la mesure du temps nécessaire qui est effectivement fonction de la complexité et de l'improbabilité).

Un inventeur souffre d'une sorte d'infirmité productive qui l'empêche de s'ajuster à la pensée des autres et l'oblige à tout faire lui-même (...) Il s'agit d'une quête insatiable, une forme de trouble obsessionnel.

Il est toujours bon de rappeler que les inventeurs, les créatifs, les génies, ne sont pas de gentils garçons bien éduqués mais portent une part de folie, preuves vivantes des bénéfices de la diversité sur la normalisation. Il n'y a pas de méthode pour être créatif car c'est une question de désir plus que d'aptitude et ce n'est pas un désir d'être créatif, mais plutôt une exigence obsessionnelle ainsi qu'un défi de l'autorité souvent. Le résultat peut être délirant ou impraticable mais comme pour l'évolution, il suffit d'un succès sur de nombreux échecs, loi statistique incompatible avec l'évaluation individuelle et la volonté de contrôle !

Brèves et liens

Physique

cosmologie, astronomie, physique quantique

- Des signes de la supersymétrie dans les mésons B ?

Une réaction très étudiée au KEKB, celle de la désintégration d'un méson B en paires de leptons (électron ou muon) et un méson K* excité formé d'un quark étrange (s) et d'un antiquark u.

Plus de 800 millions d’événements avec production de paires de méson B et antiméson B ont déjà été enregistrés et une analyse des produits de désintégrations des mésons B en paires de leptons (électron ou muons) avec un méson K excité, K*, semble échapper aux prédictions du modèle standard lorsque l’on considère une quantité définie comme l’asymétrie avant-arrière.

Les observations de Belle montrent que les réactions avec paires de particules émises selon une droite penchée vers l’avant ou vers l’arrière du faisceau de mésons B initiale ne sont pas les mêmes avec un taux non prédit par le modèle standard mais qui pourrait s’expliquer avec la supersymétrie. C’est encourageant mais le nombre d’événements enregistrés lié spécifiquement à cet effet rarissime est encore trop faible pour que l’on puisse en tirer une preuve convaincante en faveur de la supersymétrie.

- La flêche du temps vient de la perte d'information quantique

Le deuxième principe de la thermodynamique impliquant une flêche du temps serait relié au phénomène de décohérence et de perte d'information (d'un système organisé à un système désordoné) pourtant considéré comme impossible par les physiciens quantiques... Cependant, si les équations quantiques sont réversibles, elles ne laissent aucune trace.

Le deuxième principe de la thermodynamique impliquant une flêche du temps serait relié au phénomène de décohérence et de perte d'information (d'un système organisé à un système désordoné) pourtant considéré comme impossible par les physiciens quantiques... Cependant, si les équations quantiques sont réversibles, elles ne laissent aucune trace.

Rien de bien neuf puisque je disais déjà en 2004 :

De même, si le phénomène de "décohérence" qui implique une perte d'information à chaque interaction au niveau quantique peut être considéré comme son fondement physique, on ne peut y réduire l'entropie dont le caractère statistique et macroscopique reste essentiel, témoignant de sa dimension subjective, "anthropique" (tout comme le concept d'information).

- Un monopôle magnétique observé pour la première fois

Pour parvenir à réaliser la prédiction de Dirac, deux équipes indépendantes, qui viennent de publier leurs résultats dans Science, ont utilisé des techniques assez semblables. Toutes deux ont étudié grâce à des flux de neutrons le comportement de matériaux solides artificiels appelés "glace de spin". Dans ces cristaux, des petits aimants individuels (appelés moments magnétiques) se disposent comme les atomes d'hydrogène dans la glace, aux sommets de pyramides à quatre faces. Ces moments peuvent pointer vers le centre du tétraèdre ou vers l'extérieur. Or parmi toutes les configurations possibles certaines peuvent donner naissance à des monopôles. C'est en tous cas ce qu'ont constaté les chercheurs.

L'une des équipes a appliqué un fort champ magnétique extérieur à la glace pour forcer les moments à s'orienter dans un sens, puis a observé le retour à la normal grâce aux neutrons. Elle a alors constaté que le système se remplit de sortes de longues chaînes magnétiques dont les tétraèdres forment les maillons et à l'extrémité desquelles se trouvent isolés les fameux monopôles.

Les glaces de spin pourraient servir de modèles pour comprendre les "vrais" monopôles. Ceux-ci sont aussi activement recherchés dans l'Univers ou dans les accélérateurs de particules car ils pourraient être de bons candidats dans certaines théories d'unification des différentes forces de la nature.

- La première puce quantique à photons a factorisé un nombre

Factoriser un nombre à l’aide d’un ordinateur quantique n’est pas nouveau. Effectuer cette opération à l’aide de photons non plus... Ce qui l’est, c’est de le faire avec un dispositif semblable à des puces électroniques.

O’Brien et ses collègues sont maintenant allés beaucoup plus loin car ce sont des centaines de portes CNOT utilisant des photons qui ont été miniaturisées et occupent maintenant une puce en silicium d’un millimètre de côté. Sur cette dernière se trouvent ainsi plusieurs guides d’ondes pour les photons dont la taille ne dépasse pas le micron. C’est ainsi que 4 photons ont suffi pour obtenir des qubits d’informations et qu’un calcul reproduisant l’algorithme de Shor a pu être réalisé.

- Superposition quantique d'un virus

Ce n'est qu'un projet encore mais la perspective de le faire avec un animal "vivant" (bien qu'inerte) comme les tardigrades est fascinante et l'article de Laurent Sacco est comme toujours intéressant, notamment la comparaison de la décohérence avec un crayon qui tient sur sa pointe, comparaison habituellement destinée à illustrer une brisure de symétrie (on raconte aussi l'histoire de la serviette de table dont le côté est indéterminé avant que le premier convive ne choisisse la sienne à droite ou à gauche, déterminant ainsi le bon côté pour tous).

Ce n'est qu'un projet encore mais la perspective de le faire avec un animal "vivant" (bien qu'inerte) comme les tardigrades est fascinante et l'article de Laurent Sacco est comme toujours intéressant, notamment la comparaison de la décohérence avec un crayon qui tient sur sa pointe, comparaison habituellement destinée à illustrer une brisure de symétrie (on raconte aussi l'histoire de la serviette de table dont le côté est indéterminé avant que le premier convive ne choisisse la sienne à droite ou à gauche, déterminant ainsi le bon côté pour tous).

La simple influence de l’environnement physique macroscopique extérieur à un système quantique provoque le passage d’un objet du monde quantique au monde classique en le perturbant légèrement.

Spontanément, le chat de Schrödinger simultanément mort et vivant bascule dans un seul état à la manière d’un crayon en équilibre sur une pointe fine. Dans cette métaphore, aucun vide suffisamment poussé ne pourrait être réalisé, de sorte qu’il y a toujours un mouvement d’air ou de quelques molécules qui finit par entraîner la chute du crayon.

La théorie de la décohérence devait subir une confirmation spectaculaire avec les travaux de Serge Haroche et ses collègues en 1996. A l’époque ,des atomes de Rydberg avaient été utilisés mais tout récemment, ce sont des photons qui ont permis de montrer que là encore, la théorie de la décohérence était opérationnelle.

Le protocole de l’expérience décrit par les chercheurs est le suivant. On commence par placer des virus dans une cavité sous vide. Ce sont des objets chauds, ce qui veut dire que le temps de décohérence, ou pour reprendre l’image du crayon, le temps pendant lequel celui-ci restera en équilibre, est très très court. Pour voir les effets de superposition des états, il faut donc abaisser la température des virus, qui est liée à leur agitation, très similaire à celle d’un gaz de particules.

Le temps de décohérence peut alors devenir beaucoup plus long. Un autre rayon laser est ensuite utilisé pour mettre le virus dans un état de superposition de deux positions différentes simultanément. On est alors dans une situation identique à celle du chat de Schrödinger, à la fois mort et vivant.

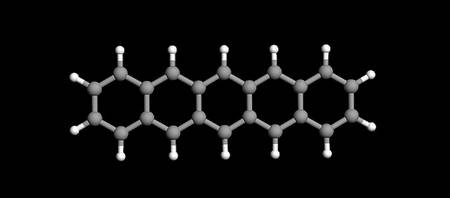

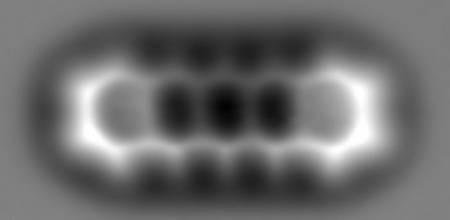

- Première observation d'une molécule au microscope

Ils sont parvenus à s’affranchir des obstacles limitant la résolution que l’on pouvait atteindre avec un microscope à force atomique (AFP pour Atomic Force Microscopy en anglais). Ce microscope est une variante du microscope à effet tunnel inventé par Gerd Binnig et Heinrich Rohrer en 1981.

Mais lorsque la pointe se rapproche trop pour augmenter la résolution, les forces deviennent en principe trop grandes.

Par hasard, Leo Gross et ses collègues se sont aperçus qu’une molécule de monoxyde de carbone (CO) installée à la pointe du microscope permettait de surmonter ces obstacles et d’obtenir un gain de résolution lors de l’observation de molécules. En effet, la molécule de CO est particulièrement stable, bien comprise, et, entre la pointe et les objets atomiques ou moléculaires à étudier, des forces plus faibles apparaissent.

Les chercheurs ont pu tester leur découverte sur une molécule de pentacène (C22H14) formée de la fusion de 5 molécules de benzène et dont la longueur est de 1,4 nanomètre environ. Ils ont observé les atomes d’hydrogène et de carbone individuellement ainsi que l’ensemble de la structure.

Les conditions imposées ne sont cependant pas simples... L'expérience a eu lieu dans l’ultravide à des températures de l’ordre de –268°C et il a fallu observer la molécule pendant 20 heures pour acquérir un volume de données suffisant.

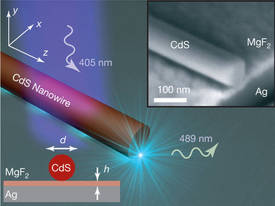

- Un laser grand comme une molécule !

Des chercheurs de l’université de Berkeley, en Californie, ont créé le plus petit laser à semi-conducteurs au monde. Emettant dans le domaine du visible, il est plus petit qu’une protéine !

Ils ont réalisé un nanocâble en sulfure de cadmium, mille fois plus fin qu’un cheveu, qu’ils ont couplé à une surface en argent.

Les deux éléments sont séparés par un isolant dont la taille est de 5 nanomètres seulement et c’est à ce niveau qu’un effet laser produisant de la lumière visible devient réalisable. C’est une performance étonnante car l’isolant est plus petit qu’une protéine et il permet de stocker des ondes lumineuses dans un volume dont la taille est 20 fois inférieure à celle de leur longueur d’onde. L’espoir des chercheurs avec ce nouveau nanolaser est de pouvoir créer des dispositifs pour sonder, manipuler et caractériser plus efficacement des molécules d’ADN et surtout de créer des dispositifs analogues aux circuits électroniques mais basés non plus sur des courants d’électrons mais des faisceaux de photons.

L'atonie actuelle du soleil nous prive de son bouclier et nous expose à beaucoup plus de radiations ce qui n'est pas sans danger pour les satellites, les hommes, les systèmes électroniques, les mémoires numériques... Certes le champ magnétique terrestre nous en protège normalement mais il est lui aussi de plus en plus faible, le rayonnement résiduel devant augmenter en proportion sans doute. Le risque me semble surtout d'une bouffée de rayons gamma. C'est donc une bonne chose que l'expérience de détection des rayons cosmiques qui sera installée le 10 octobre sur la tour Montparnasse :

A chaque détection par cet instrument, un rayon laser sera émis entre le sommet de la Tour Montparnasse et l'Observatoire de Paris.

Voir Futura-Sciences.

Des chercheurs de la Nasa ont observé pour la première fois sur Mars de la glace très pure sous la surface du sol, dans des cratères récemment formés par des impacts de météorites, à mi distance entre le pôle nord et l'équateur de la planète.

La glace mise au jour par l'impact de météorites et observée par la caméra à haute définition du MRO s'est rapidement évaporée car 200 jours après avoir été détectée pour la première fois elle avait complètement disparu.

La glace est une relique d'un climat martien plus humide remontant peut-être seulement à quelques milliers d'années.

On peut voir les clichés sur Techno-Science. Il y aurait aussi une sorte de rosée sur la Lune mais bien moins facilement récupérable.

Climat

Climat, écologie, énergies

- Nouveau rapport d’étape du GIEC

Le « Climate Change Science Compendium 2009 » publié par le GIEC fait le point sur les plus récentes connaissances scientifiques et observations sur le changement climatique. L’augmentation des émissions de CO2 dépasse à l’heure actuelle les scénarios les plus pessimistes que le GIEC avait établies, passant d’une croissance annuelle de 1,1% entre 1990 et 1999 à 3,5% entre 2000 et 2007. Les prévisions sur l’ampleur du réchauffement et de ses conséquences sont toutes revues à la hausse. Les scientifiques s’attendent désormais une élévation de la température moyenne comprise entre 1,4 °C et 4,3°C. Le rapport souligne en particulier le recul généralisé des glaciers, et ses conséquences à terme sur la ressource en eau pour un sixième de la population de la terre ; des sécheresses plus fortes en Australie, Afrique du Nord et au sud de l’Europe ; une élévation du niveau des mers désormais estimée entre 0,5 et 1,4 mètres contre 18 à 64 cm précédemment.

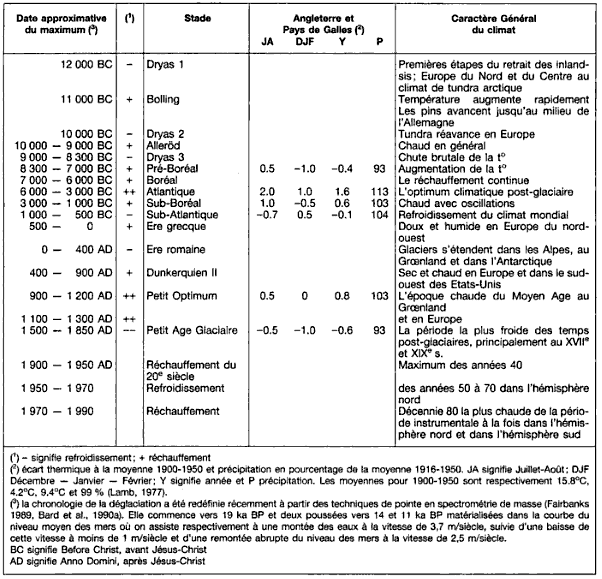

La situation pourrait être pire à cause des dégagements de méthane mais la courbe des températures ne semble pas juste, en tout cas pour l'Europe qui a connu des températures supérieures à celles de maintenant vers 900. De plus, la corrélation devrait faire apparaître un décalage entre CO2 et températures. Il reste beaucoup d'inconnues, dont le ralentissement solaire actuel ainsi que la récession qui pourraient aider s'ils duraient, mais les risques sont démesurés. Le danger de dépasser les 4°C reste en effet bien réel et absolument catastrophique pouvant mener bien au-delà par emballement du climat qui menace dès lors qu'on dépasse les 2°C de l'optimum post-glaciaire !

- L'hypothèse extrême : 4°C en 2060 !

Une nouvelle étude du Met Office du Royaume Uni, réalisée en prenant en compte le niveau d’émission actuel de CO2 - supérieur à celui du scénario le plus pessimiste du GIEC - ainsi que les boucles de rétroactions climatiques, conclut que le réchauffement pourrait atteindre 4°C entre 2060 ou 2070, si rien n’est fait pour réduire rapidement les émissions.

Une température moyenne de 4°C pourrait s’accompagner localement de variations bien plus élevées : le réchauffement en Arctique et en Afrique de l’ouest et du sud pourrait atteindre jusqu’à 10°C.

Les gens vont dire que c’est un scénario extrême, et il s’agit d’un scénario extrême, mais c’est aussi un scénario plausible.

M. Betts a déclaré qu’il « est important de souligner que ce n’est pas un scénario catastrophe. Nous avons le temps d’arrêter cela si nous réduisons rapidement nos émissions de gaz à effet de serre. »

La limitation du réchauffement de la planète à 2°C ne pourra être obtenue qu’avec de nouvelles technologies permettant de capturer les gaz à effet de serre dans l’atmosphère.

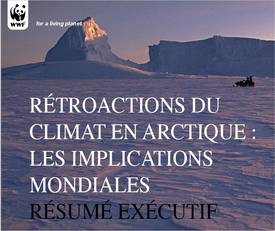

- WWF : Les rétroactions du climat en Arctique

A trois mois du sommet de Copenhague, le WWF publie une compilation de plusieurs études sur le milieu arctique, dont l'analyse est des plus catastrophistes. Le rapport retient les pires scénarios et évoque une élévation de un mètre du niveau des mers à la fin du siècle.

Le réchauffement de la région arctique est plus important que dans le reste de la planète. Cette différence n'est pas un phénomène local mais un paramètre important du réchauffement global de l'atmosphère terrestre. La régression des glaciers du Groenland et de la banquise arctique (deux fois plus rapide que la moyenne mondiale) induit même un cercle vicieux (ce qui qui est connu depuis longtemps) puisque la fonte accélérée des glaces réduit l'albédo (la réflexion de la lumière solaire) et donc augmente le réchauffement du sol ou de la mer qu'elle recouvrait. De plus, le méthane (puissant gaz à effet de serre) et le gaz carbonique (CO2) piégés dans les sols gelés (pergélisols) sont libérés au dégel.

Le rapport annonce en effet une élévation de la surface de l'océan mondial atteignant un mètre en 2100, alors que le Giec, dans son rapport de 2007, s'en tient à une fourchette de 18 à 59 centimètres (le rapport 2001 retenait 9 à 88 centimètres).

- L'orbite planétaire n'explique pas le réchauffement

L'image montre l’évolution de l’inclinaison de l’axe de la Terre depuis 2000 ans : bien qu’au moment du solstice d’été la Terre soit plus loin du Soleil au 20ème siècle qu’il y a 2000 ans, les étés sont plus chauds en Arctique.

Depuis le début de notre ère jusqu’au milieu du 19ème siècle, l’Arctique a connu une longue tendance au refroidissement, avec une baisse de 0.2°C par millénaire. C’était le petit âge de glace, expliqué par une légère modification de l’inclinaison de l’axe de rotation de la Terre qui a réduit l’ensoleillement de l’Arctique pendant l’été. Cette période glaciaire a pris fin vers 1850. Au milieu du 20ème siècle, les températures estivales de l’Arctique étaient 0,7°C plus élevées que ce qu’elles auraient été si la tendance au refroidissement avait continué. Ce ‘gain’ est de 1,4°C à la fin du 20ème siècle.

Pourtant l’inclinaison de l’axe terrestre n’a pas changé et a même persisté au cours du 20ème siècle, soulignent les chercheurs. Une preuve supplémentaire de l’influence des activités humaines sur le climat de l’Arctique et de la grande sensibilité de ce continent aux changements.

Cette analyse passe un peu vite sur le caractère cyclique de certains régimes des vents ainsi que sur des effets retards qui ne sont pas imputables à l'homme mais il n'empêche qu'on devrait plutôt avoir un refroidissement et que le réchauffement est en grande partie dû à l'accumulation année après année de co2 excédentaire.

Voir aussi ContreInfo.

- Les glaces du Groenland face au réchauffement: les leçons du passé

La fonte partielle de l'immense calotte de glace recouvrant le Groenland est désormais un sujet d'inquiétude majeure pour le futur en raison du réchauffement climatique. La fonte en totalité de cette calotte conduirait le niveau des mers à s'élever en moyenne de 7 mètres.

Une équipe de glaciologues danois, canadiens, français et russes vient de reconstituer l'histoire du climat et des altitudes de surface de la calotte groenlandaise au cours de l'Holocène, la période relativement chaude que connaît la planète depuis environ 11 000 ans. Leur étude montre qu'entre - 7 000 et - 10 000 ans, le Groenland a connu une température maximale supérieure d'environ 2°C à la température actuelle. Ces conditions chaudes étaient accompagnées d'une diminution de l'altitude de surface des régions côtières de la calotte de plusieurs centaines de mètres (entre 600 et 200 mètres pour les sites étudiés).

Voir aussi Les eaux chaudes de l’Atlantique accélèrent la fonte des glaciers du Groenland et Les scientifiques « surpris » par l’ampleur de la perte de volume des glaciers côtiers de l’Antarctique.

- Impacts du changement climatique en France

Je n'accorde pas beaucoup de crédit à ces projections qui sont très aléatoires...

La nécessité de ne pas dépasser les 2° oblige à tenter ce qu'ils appellent le plan B, mais qui ne remplace pas la réduction des gaz à effet de serre, en premier lieu en voilant le soleil avec du soufre et des miroirs mais le méthane ira peut-être plus vite que nous...

Voir aussi Géo-ingénierie, le pari faustien (Counter Punch).

- Il suffirait de planter des forêts dans les déserts...

Si une irrigation à grande échelle maintenait de vastes forêts dans le Sahara et dans le désert australien, la température de ces régions chuterait de plusieurs degrés et ces arbres absorberaient presque autant de carbone que l'humanité en produit aujourd'hui.

Sur le papier, l'idée est simple. De l'eau de mer désalinisée dans d'immenses installations serait amenée en grandes quantités vers le Sahara ou au cœur du désert australien pour irriguer les terres et y faire pousser des arbres.

Pour l'irrigation, les chercheurs imaginent d'utiliser des canalisations en plastique, enterrées, pour éviter l'évaporation. Pour les essences à planter, il n'y aurait que l'embarras du choix. Ornstein cite Eucalyptus grandis, le Grand eucalyptus, un arbre pouvant atteindre cinquante mètres de hauteur.

Selon les auteurs de cette étude, les modèles climatiques indiquent que les régions passant du désert à la forêt verraient la température descendre de 4 à 8°C. Cette couverture végétale génèrerait des nuages et l'apport de pluies, entre 700 et 1.200 millimètres par an disent les chercheurs.

D'après leurs estimations, si une grande partie du Sahara et du désert australien était ainsi boisée, les arbres absorberaient huit milliards de tonnes de carbone par an, soit presque autant qu'en rejettent la combustion des combustibles fossiles et la déforestation.

- Le premier système de recaptage du CO2

- La Chine veut négocier sur la base de l’« émission accumulée historique par habitant »

Il faut parvenir à une identité de vue mondiale quant à ce problème et faire en sorte que la répartition du droit à l’émission soit basée sur le principe de l’« émission accumulée historique par habitant » tout en établissant un compte sur le droit d’émission international, en encouragent l’utilisation de divers moyens susceptibles de réduire les émissions carboniques, en l’incorporant dans le compte de calcul de chacun des pays et de promouvoir activement la transaction de répartition du droit à l’émission sous diverses et différentes formes.

Liu Shijin a indiqué que les émissions carboniques chinoises atteindront leur point culminant entre 2030 et 2040.

- La Chine peut se passer de centrales à charbons grâce à l'éolien

Les Chinois envisagent de produire leur électricité par des grands champs d'éoliennes, concurrentiels par rapport aux centrales nucléaires ou à charbon. Le plus gros obstacle, c'est l'état du réseau qui doit être modernisé. Hélas, la Chine restera "longtemps" encore dépendante du charbon, qui lui fournit aujourd'hui 70% de son énergie !

- La Chine construira la plus grande centrale solaire du monde

Les Chinois ne misent pas seulement sur l'éolien mais aussi sur le solaire, bien que moins compétitif pour l'instant. La question du réseau serait moins cruciale pour un solaire décentralisé mais se pose aussi pour les centrales solaires :

Les Chinois ne misent pas seulement sur l'éolien mais aussi sur le solaire, bien que moins compétitif pour l'instant. La question du réseau serait moins cruciale pour un solaire décentralisé mais se pose aussi pour les centrales solaires :

La Chine construira à l'horizon 2019 dans le nord du pays la plus grande station solaire du monde, a annoncé lundi l'agence Sina.

Le site sera érigé en Mongolie intérieure avec l'aide de compagnies américaines. Sa capacité devrait atteindre 2 GW, ce qui est 30 fois plus que les plus puissantes centrales actuelles.

Ce projet s'ajoute à ceux dont nous parlions en juillet. Actuellement, c'est le solaire thermique qui est le plus développé mais la production photovoltaïque décentralisée semble curieusement absente !

- Le Japon projette de construire une centrale solaire spatiale

Objectif: placer vers 2030 un engin en orbite géostationnaire (à 36.000 kilomètres de la Terre), équipé de nombreux panneaux solaires.

Ces éléments photovoltaïques, à l'instar de ceux employés au sol, convertiront l'énergie des rayons du soleil en électricité, avec une capacité annuelle cinq à dix fois supérieure à aire identique.

Ce courant électrique sera à son tour transformé en flux énergétique transmis par faisceau laser ou micro-ondes jusqu'à la Terre où il sera capté par une gigantesque antenne parabolique dédiée, et retransformé en électricité.

Plusieurs étapes sont prévues avant l'entrée en exploitation d'un tel système à partir des années 2030, selon les plans actuels.

D'abord, "un satellite de démonstration destiné à l'expérimentation de la transmission par micro-ondes devrait être placé en orbite basse par la fusée japonaise" dans les toute prochaines années, explique un des responsables du projet à la Jaxa, Tatsuhito Fujita.

Puis, il s'agira de vérifier la faisabilité d'un assemblage robotisé dans l'espace (en co-orbite avec la Station spatiale internationale, ISS) des éléments constitutifs d'une large structure photovoltaïque flexible d'une puissance de 10 mégawatts (MW). Ceci est prévu aux alentours de 2020.

Ensuite, un prototype d'une puissance de 250 MW sera placé en orbite géostationnaire. Il servira à tester l'ensemble du dispositif et à évaluer sa compétitivité sur le plan financier.

Voir aussi Futura-Sciences.

- Vers une période de transition cahotique

La période de transition entre énergies fossiles et renouvelables s’annonce agitée, avertit Michael T. Klare. Faute d’une conversion massive et rapide aux énergies nouvelles - qui paraît aujourd’hui peu vraisemblable - nos sociétés en seront réduites à compter de plus en plus sur des gisements « extrêmes », coûteux à exploiter, difficiles d’accès, certains situés dans des zones dangereuses, d’autres extrêmement polluants, dévastateurs pour l’environnement, et qui feront l’objet pour la plupart d’une compétition internationale acharnée, source de tensions géopolitiques.

- La production pétrolière va commencer à décliner dans les 5 ans

M. Hirsch estime qu’entre 10 et 20 ans seront nécessaires pour effectuer les transformations des infrastructures, équipements, processus et modes de vie qui seront requises avec la raréfaction du pétrole. Après plusieurs années passées à étudier ce dossier, il estime aujourd’hui que nous disposons de moins de cinq ans avant que la production pétrolière mondiale ne commence à décliner, provoquant à coup sûr une récession de grande ampleur.

Voir aussi Le méga champ pétrolier koweitien de Burgan (1,4 mb/j) n’a plus que 10 ans environ à vivre. La production mondiale de brut décline de 6,7% par an. Les problèmes pourraient même commencer dans 2 ou 3 ans (tout dépend de la reprise). C'est malgré tout très lié au prix du pétrole (aux investissements), façon de dire que la consommation d'hydrocarbures est appelée à diminuer et qu'il faut que les prix augmentent. Plus on attend, plus le choc sera brutal. Tout ce qui accélère le passage aux renouvelables est à encourager mais l'augmentation du prix du pétrole est un des éléments qui fait prédire une rechute brutale de l'économie. Signalons aussi la campagne surréaliste des pétroliers américains qui veulent persuader le public que le co2 c'est bon pour les plantes et donc bon pour la planète !

- La production alimentaire devra augmenter de 70% d’ici à 2050

Selon un rapport diffusé aujourd’hui par la FAO, l’agriculture mondiale doit relever des défis de taille : augmenter la production alimentaire de 70% pour nourrir 2,3 milliards de personnes de plus d’ici à 2050, intensifier la lutte contre la pauvreté et la faim, utiliser plus efficacement les ressources naturelles qui s’amenuisent et s’adapter au changement climatique.

La population mondiale, selon les dernières projections des Nations Unies, doit passer de 6,8 milliards à 9,1 milliards en 2050, soit un tiers de bouches de plus à nourrir qu’il n’y en a aujourd’hui.

Le gros de la croissance démographique se produira dans les pays en développement. C’est en Afrique subsaharienne, que le taux de croissance sera le plus fort (+108%, soit 910 millions de personnes).

Bien que l’augmentation de la production alimentaire sera obtenue à 90% de rendements plus élevés et de l’accroissement de l’intensité culturale, les terres arables devront augmenter d’environ 120 millions d’hectares dans les pays en développement, principalement en Afrique subsaharienne et en Amérique latine.

Les terres arables exploitées dans les pays développés diminueront de quelque 50 millions d’hectares, bien que cela pourrait être modifié par la demande sur les biocarburants.

Globalement, les disponibilités de ressources en terre sont suffisantes pour nourrir la future population mondiale. Toutefois, la FAO avertit que dans leur grande partie les terres disponibles ne conviennent que pour un nombre restreint de cultures, pas nécessairement les cultures fortement demandées, et ces terres sont concentrées dans peu de pays.

Biologie

évolution, génétique, biodiversité, éthologie, anthropologie, neurologie

- Origines de la vie: le point sur les enzymes ancestrales

L’hypothèse la plus populaire sur les origines de la vie, dite "autotrophique", postule que le métabolisme primordial s’est développé sur des surfaces minérales composées de fer et de soufre dans des conditions réductrices. Ainsi, des réactions mettant en jeu des sulfures de fer auraient généré de l'hydrogène, qui se serait combiné avec le dioxyde de carbone présent dans l'atmosphère pour former des molécules organiques. Lors du développement de la terre, il y a entre 4,6 et 3,5 milliards d’années, l’atmosphère était probablement riche en gaz tels que l’H2, le CO et le CO2, et les océans, très chauds par endroits, étaient relativement riches en ions métalliques tels que le Fe2+ et le Ni2+. Les organismes photosynthétiques n’apparaissant que vers 2,2 milliards d’années, le biotope de l’époque devait prospérer en absence d’oxygène et indépendamment de l’énergie solaire. On pense actuellement que les premiers organismes utilisaient l’H2 comme source d’énergie et le CO2 comme source de carbone.

Certains organismes actuels sont capables de survivre dans ces conditions, essentiellement grâce à l’énergie obtenue à partir des métalloenzymes. Que sait-on aujourd’hui de la structure, de la complexité et du mécanisme d’action de ces enzymes ? Structurée autour de 6 parties, la revue aborde sous différents angles les connaissances sur la structure et la synthèse de ces enzymes:

- Origine de la chlorophylle et de l'hémoglobine à partir du sel

Les chercheurs ont reproduit ces dépôts de sel, ou tout du moins ceux dont on pense qu’ils existaient à cette époque où l’océan lui-même devait être riche en molécules organiques, notamment des acides aminés.

Pour cela, ils ont mélangé de la DL-alanine, des chlorures de sodium, de calcium, et de potassium avec de l’eau puis ils ont évaporé le mélange pour obtenir une croûte blanchâtre. Ensuite, le tout a mijoté à des températures de l’ordre de 350°C dans une atmosphère d’azote et de gaz carbonique. C’est typiquement les conditions auxquelles on doit s’attendre à proximité de flots de laves en environnement marin dans une atmosphère où l’oxygène n’existait pas encore.

De façon surprenante, le composé obtenu, qui aurait dû se sublimer à ces températures, est stable. L’alanine et le calcium forment une liaison relativement forte et les chercheurs ont constaté qu'elle permettait la formation de pyrroles et d’hèmes. Les pyrroles sont particulièrement intéressants car ils sont à la base des réactions conduisant à la formation de la chlorophylle. Quant aux hèmes, ils se retrouvent, comme leur nom le laisse deviner, dans l’hémoglobine.

Une fleur calédonienne a eu la semaine dernière les honneurs de la rubrique Science du New York Times. Endémique à la Nouvelle-Calédonie, Amborella trichopoda n’est même pas rare, nullement menacée, mais elle est vieille, très vieille : 135 millions d’années, ce qui en fait la plante actuelle la plus proche des plantes à fleurs des origines. Un fossile vivant.

- 3 gènes humains issus de l'ADN poubelle

Evidemment on appelle ADN poubelle ce qui ne code pas de protéines, ce qui ne veut pas dire qu'il n'a aucune fonction, soit en produisant des ARN, soit en contrôlant l'expression des protéines mais on croyait qu'il était impossible de se transformer en gène fonctionnel, le niveau de complexité requis empêchant que des mutations au hasard soient viables (mais seulement des modifications de l'expression des gènes et de leur combinatoire) !

Les 3 nouveaux gènes (CLLU1, C22orf45 and DNAH10OS) nous sont en tout cas spécifiques, ne se trouvant dans aucune autre espèce (il y aurait sans doute 15 nouveaux gènes en tout par rapport aux chimpanzés). Le plus probable quand même reste que ce soient d'anciens gènes inactivés qui ont été rendus de nouveau opérationnels ?

- Le plus vieux dinosaure à bec

Oiseau primitif ou dinosaure à plumes? Le statut d’un petit théropode découvert en Chine a été révisé. Suite à la découverte d’un nouveau spécimen fossilisé, mieux conservé, d’Anchiornis huxleyi, des paléontologues chinois affirment qu’il s’agit bien d’un dinosaure du Jurassique et non d’un animal faisant la transition entre dinosaures et oiseaux.

En effet, selon Xing Xu, de l’Académie chinoise des sciences, ce spécimen d’Anchiornis huxleyi est âgé de 155 millions d’années, ce qui fait de lui le plus ancien dinosaure à bec connu à ce jour. Il bat de 5 millions d’années l’Archaeopteryx et de 30 millions d’années le Microraptor, petit dinosaure à plumes.

Une nouvelle espèce de rats géants a été découvert en Nouvelle Guinée dans la jungle de la papouasie. C'est un rat qui non seulement approche le mètre mais qui n'a pas peur des humains...

C'est une équipe de la BBC qui l'a découvert en filmant un documentaire pour l'émission "Lost Land of the Volcano".

- Du nouveau sur la chute de Neandertal

On commence a avoir une assez bonne compréhension des facteurs ayant mené à l'extinction de l'homme de Neandertal. Ces facteurs sont multiples mais comprennent l'hostilité des autres hommes et même le cannibalisme. Ce n'est certes pas la seule raison mais plus fondamentalement des populations plus clairsemées, à la diversité moindre, avec un taux de reproduction inférieur ainsi qu'une alimentation moins diversifiée, entièrement dépendante des grands mammifères, qui seront décimés autant par le climat que par l'homme, et sans doute incapables de se nourrir comme lui des produits de la mer. Si ces causes indirectes ont pesé, la disparition totale semble attribuable à l'agression par les hommes comme on le disait déjà dans l'émergence de l'humanité. Précisons que le cannibalisme des homo sapiens ne se limitait pas à Neandertal mais aussi bien à notre propre espèce ! Une espèce s'efface devant une autre plus adaptable mais plus agressive aussi, ce qui a pu se reproduire, voir ci-après, avec l'arrivée des premiers cultivateurs...

On commence a avoir une assez bonne compréhension des facteurs ayant mené à l'extinction de l'homme de Neandertal. Ces facteurs sont multiples mais comprennent l'hostilité des autres hommes et même le cannibalisme. Ce n'est certes pas la seule raison mais plus fondamentalement des populations plus clairsemées, à la diversité moindre, avec un taux de reproduction inférieur ainsi qu'une alimentation moins diversifiée, entièrement dépendante des grands mammifères, qui seront décimés autant par le climat que par l'homme, et sans doute incapables de se nourrir comme lui des produits de la mer. Si ces causes indirectes ont pesé, la disparition totale semble attribuable à l'agression par les hommes comme on le disait déjà dans l'émergence de l'humanité. Précisons que le cannibalisme des homo sapiens ne se limitait pas à Neandertal mais aussi bien à notre propre espèce ! Une espèce s'efface devant une autre plus adaptable mais plus agressive aussi, ce qui a pu se reproduire, voir ci-après, avec l'arrivée des premiers cultivateurs...

"Surprenants, nos résultats suggèrent que les néandertaliens ont été en contact avec les premiers représentant des hommes modernes ; et ces derniers semblent avoir rapporté des corps de néandertaliens dans leur caverne pour les manger...".

Au final, les chercheuses ont pu établir l'existence des trois sous-groupes dans la population néandertalienne (un occidental, un méditerranéen et un oriental). Elles suggèrent même l'existence d'un quatrième en Asie occidentale. Les petites variations génétiques de ces différents groupes seraient dues à une microévolution induite par l'environnement où chacun des groupes vivait. L'existence d'une telle subdivision génétique, avec peu de migrations entre les sous-groupes, pourrait avoir fragilisé les néandertaliens et favorisé leur extinction lorsque chaque population s'est vue soumise à une concurrence – parfois violente – avec l'Homo sapiens.

- Les anciens européens ont disparus devant les cultivateurs

Apparue il y a un peu plus de 10.000 ans dans l’actuel Moyen-Orient, l’agriculture s’est peu à peu diffusée en Europe centrale, puis vers l’Est et l’Ouest du continent il y a environ 7.500 ans. Deux hypothèses majeures s’opposent sur les origines de cette agriculture : celle d’une diffusion de la culture et celle de l’arrivée de migrants apportant leur savoir-faire avec eux.

D’après Bramanti et ses collègues, il y a peu de similitudes entre l’ADNmt des anciens chasseurs-cueilleurs et celui des premiers cultivateurs. Ces derniers seraient donc des migrants venus en Europe qui ne se sont pas mélangés à la population existante, du moins pas dans un premier temps. Cela conforterait l’hypothèse d’une diffusion de l’agriculture par les migrants venus d’Orient. D’autres études génétiques, comme celle portant sur la domestication du cochon, vont dans ce sens.

D'une certaine façon, il y a eu disparition des chasseurs-cueilleurs comme il y a eu disparition de Néandertal. Le niveau technique serait donc un critère suffisant, sans aucun cannibalisme cette fois sans doute mais des sacrifices humains peut-être ?

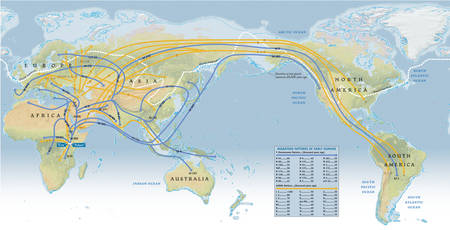

- Genographic retrace l'histoire de l'Homme

Cliquer sur l'image pour l'agrandir. Schéma des grandes migrations humaines depuis l'aube de l'humanité, parties d'Afrique de l'est, et obtenu par l'étude des chromosomes Y (lignes bleues) et de l'ADN mitochondrial (en jaune). Selon ce schéma, hormis les chasseurs-cueilleurs d'Afrique australe (les San), toute l'humanité descend d'un même groupe ayant quitté l'est de l'Afrique il y a 60.000 ans, là où ont dû vivre une « Eve africaine » et un « Adam africain ». L'Asie du sud est atteinte il y a environ 50.000 ans. Entre 40.000 et 35.000 ans, des hommes s'aventurent jusqu'en Sibérie... en pleine époque glaciaire. Entre 20.000 et 15.000 ans, Homo sapiens fait son apparition sur le continent américain en profitant d'un passage entre Sibérie et Alaska, permis par la baisse du niveau de la mer.

La trace génétique, expliquent les auteurs, remonte la piste de l'aventure humaine jusqu'à 60.000 ans en arrière, quelque part au nord-est de l'Afrique, là où se trouverait le berceau de l'humanité. Des changements climatiques obligent alors les humains à bouger. Après un climat humide dans ce qui est aujourd'hui le Sahara, la sécheresse rend le centre de l'Afrique peu confortable. Certains sont partis vers l'est et ont traversé la Mer Rouge. D'autres avaient pris la poudre d'escampette bien avant, il y a 100.000 ans, et poussé vers le sud du continent africain. Spencer Wells affirme en avoir retrouvé leur descendance chez les actuels chasseurs-cueilleurs du sud de l'Afrique, que l'on appelle les San (et qui se reconnaissent notamment aux claquements faisant partie des sons de leur langage).

Les migrants, eux, ont peuplé l'Inde puis toute l'Asie. A la faveur d'une baisse du niveau de la mer, ils se sont installés en Indonésie et jusqu'en Australie. D'autres ont poursuivi la route vers l'est, de génération en génération, et ont atteint l'Amérique du nord, tandis que d'autres peuples migraient vers l'ouest et parvenaient en Europe où ils rencontraient un cousin, l'homme de Néandertal.

Paradoxalement, cette étude met en évidence que les Indiens partagent tous l’héritage de deux grands ‘familles’ ancestrales et en même temps que la population est morcelée en groupes qui ont évolué séparément, en se mélangeant peu.

De 40 à 70% du patrimoine génétique des Indiens est un mélange de deux grands groupes. Le premier, originaire du Nord, est apparenté aux Eurasiens (Europe, Asie Centrale, Proche-Orient) ; l’autre, originaire du Sud, n’est relié à aucun autre groupe de population, en Asie ou ailleurs. La part de la lignée nordique est plus importante chez les Indiens qui parlent une langue indo-européenne (hindi, sanskrit, bengali, ourdou, etc..) et dans les castes supérieures, notent les chercheurs.

Les seuls Indiens à ne pas posséder cette lignée sont les habitants des îles Andaman, archipel de l’océan Indien, qui descendent uniquement de l’autre lignée ancestrale.

Sans surprise, on retrouve les populations indiennes autochtones, sans doute apparentés aux sumériens (civilisation d'Harappa), et les indo-européens qui ont envahi l'Inde vers -4000.

- Des spermatozoïdes trop performants !

Normalement dès qu’un spermatozoïde féconde l’œuf cela déclenche des réponses biologiques qui empêchent les autres spermatozoïdes d’entrer en contact avec l’œuf. Ce blocus est nécessaire, car un second spermatozoïde rentrant dans l’œuf causerait sa destruction. Ce phénomène est appelé polyspermie.

Cependant les spermatozoïdes sont devenus tellement efficaces que le temps que ce blocage se mette en place, il n’est pas rare qu’un deuxième gamète mâle arrive jusqu’à l’œuf mettant ainsi fin à la fécondation.

Le corps des femmes, aussi, a développé des défenses contre la polyspermie. «Pour éviter les conséquences fatales de la polyspermie, l’appareil génital féminin a évolué pour devenir un formidable obstacle au sperme», affirme le Dr Hasson. Une toute petite amélioration de l'efficacité du sperme mâle est compensée par une réponse du système reproducteur femelle. «Cela alimente une course aux armements entre les sexes qui induit cette baisse de la fertilité», conclut-il.

Santé

génétique, traitements, nutrition, hygiène

- La Chine sort le premier vaccin contre la grippe A

Un vaccin chinois, déjà au point, vient d'être autorisé à la vente dans son pays d'origine. Contrairement aux produits en cours d'étude en Occident, ce vaccin ne nécessite qu'une seule dose.

Panflu.1 serait ainsi le premier vaccin contre H1N1 à dose unique, contrairement à la majorité de ceux produits par les géants occidentaux de l’industrie pharmaceutique, qui, en effet, travaillent sur des vaccins à deux doses.

- Une puce implanté dans le corps pour détecter le virus H1N1

La société Verichip brevète une micropuce implantable dans le corps humain et capable de détecter le virus H1N1 (Seeking Alpha).

- Le premier vaccin contre le Sida qui fait plus de bien que de mal

Rien d'extraordinaire mais c'est encourageant quand même par rapport aux échecs précédents...

- Des nanodiamants pour la thérapie génique

Une nouvelle voie très prometteuse vient d’être trouvée par Dean Ho de la Northwestern University. Avec ses collègues, il avait déjà remarqué que des nanodiamants pouvaient facilement être recouverts de molécules actives qu’ils pouvaient ensuite libérer de façon très efficace dans un organisme. De plus, ces nanodiamants ont une bonne biocompatibilité. Ainsi, lui et ses collègues ont obtenu récemment d’excellents résultats avec des nanodiamants porteurs d’insuline pour accélérer la guérison de brûlures ou de blessures. Les nanodiamants traités peuvent en effet libérer cette hormone au niveau des tissus endommagés de façon contrôlée et idéale pour un maximum d’efficacité. La même conclusion avait été atteinte avec des nanodiamants recouverts de doxorubicine, une substance employée en chimiothérapie contre le cancer.

Les chercheurs se sont donc demandés si des nanodiamants pouvaient aussi être recouverts de PEI800 et s'ils pouvaient alors facilement pénétrer dans des cellules.

Non seulement les nanodiamants ont bien pénétré dans les cellules mais l’efficacité s’est révélée 70 fois supérieure à celle du PEI800, tout en conservant une excellente biocompatibilité. Comme la fabrication de ces nanodiamants est facile et peut donc devenir industrielle, les chercheurs placent de grands espoirs dans leur découverte.

- La salive de tique pourrait guérir du cancer

La tique, cet animal peu apprécié des hommes, est connue pour les maladies infectieuses qu'elle transmet et pour les allergies qu'elle provoque. Sa salive a la particularité d'augmenter les phénomènes inflammatoires. On entend d'ailleurs souvent des spécialistes qui déconseillent d'utiliser de l'éther pour la retirer de la peau car la tique, une fois anesthésiée, a la fâcheuse habitude de régurgiter de la salive.

Mais depuis quelques jours, cette salive est plutôt bien vue au brésil: des chercheurs de l'Institut Butantan de Sao Paulo ont découvert que celle-ci contiendrait une photoprotéine capable de guérir plusieurs cancers (cancers du pancréas, du foie, ou de la peau). Baptisée "Facteur X actif", cette protéine serait en effet en mesure de s'attaquer aux cellules cancéreuses tout en épargnant les cellules saines.

Après avoir reproduit artificiellement cette protéine dans des cuves à levure (car jusque là l'extraction se faisait en plaçant une paille sous la tête de l'animal), ils l'ont testée sur des souris atteintes de cancers de la peau. Le résultat obtenu est impressionnant: dans le cas d'un animal traité quotidiennement pendant une durée de 14 jours, la tumeur a arrêté de se développer et s'est même stoppée. Dans le cas d'un animal traité pendant 42 jours consécutifs, la tumeur a totalement disparu. La salive s'est attaquée uniquement aux cellules cancéreuses.

- Un traitement précoce ralentirait le Parkinson

Un médicament habituellement prescrit pour atténuer les symptômes de la maladie de Parkinson ralentit aussi la progression du handicap lié à cette affection neurologique, à condition d'être administré plus tôt.

Il montre que la rasagiline ne se contente pas de lutter contre les symptômes, mais freine aussi leur progression, selon les auteurs qui ont mesuré cette différence à l'aide de tests.

"Il faudrait peut être faire évoluer, à la lumière de ces résultats, les recommandations officielles (européennes et autres) qui incitent actuellement à attendre que les symptômes deviennent suffisamment gênants (raideur, lenteur, tremblement) pour traiter les patients".

Les auteurs eux-mêmes reconnaissent cependant qu’avec la plus forte dose de rasagiline (2 mg au lieu de 1mg), ils n’observent pas cet avantage du traitement précoce…

Voir aussi Techno-Science. La rasagiline est commercialisée sous le nom d'Azilect®. Rappelons qu'il y a aussi les pistes du clioquinol et de l'isradipine (ICAZ®).

- Alzheimer : l'inflammation plus que les plaques responsables (angl.)

Les gènes impliqués dans la prédisposition à la maladie suggèrent que l'inflammation, le cholestérol et l'irrigation sanguine seraient les véritables causes. Le taux de TNF-alpha serait un bon indicateur de la gravité de l'Alzheimer et de sa mortalité. Cela semble rejoindre les bienfaits des anti-inflammatoires ou de l'ICAZ® sur la maladie.

Les gènes impliqués dans la prédisposition à la maladie suggèrent que l'inflammation, le cholestérol et l'irrigation sanguine seraient les véritables causes. Le taux de TNF-alpha serait un bon indicateur de la gravité de l'Alzheimer et de sa mortalité. Cela semble rejoindre les bienfaits des anti-inflammatoires ou de l'ICAZ® sur la maladie.

Pour la Science met en cause la préséniline :

Ces travaux détaillent en outre le fonctionnement de la préséniline au sein des synapses : normalement, cette molécule assure la libération d'un important neuromédiateur d'un neurone à l'autre, le glutamate. Il s'ensuit une libération des réserves de calcium intracellulaire dans le neurone cible, ce qui participe à la stabilisation de la synapse et à la « mémorisation » de l'information. La préséniline absente, ce mécanisme est entravé.

Cette découverte montre qu'un défaut de transmission de l'information dans les zones cérébrales de la mémorisation est peut-être la cause de la maladie d'Alzheimer chez certains patients. Une alternative aux pistes les plus fréquemment explorées, mettant en cause des fibrilles entravant le fonctionnement des neurones, et les plaques amyloïdes qui les compriment.

On avance aussi vers un vaccin.

- Cannabis : les causes de l'amnésie

Selon Giovanni Marsicano, l'un des auteurs de l'étude, les expériences réalisées à Barcelone et à Bordeaux ont permis d'identifier dans l'hippocampe à la fois la classe des neurones (utilisant le neuromédiateur nommé GABA) où se manifestent les phénomènes amnésiques dus au cannabis et une molécule (mTOR) qui, activée par les récepteurs cannabinoïdes, perturbe la synthèse des protéines.

- Better world: Legalise drugs (New Scientist)

New Scientist publie une défense de la légalisation des drogues devant l'inefficacité et la contre-productivité même de la prohibition (tout comme pour la prohibition de l'alcool).

New Scientist publie une défense de la légalisation des drogues devant l'inefficacité et la contre-productivité même de la prohibition (tout comme pour la prohibition de l'alcool).

"Loin de nous protéger, nous et nos enfants, la guerre aux drogues rend le monde beaucoup plus dangereux".

C'est aussi ce que préconise Ruwen Ogien (voir plus haut) dans son livre "La vie, la mort, l'Etat" où il plaide pour une bioéthique minimaliste acceptant le pluralisme moral, ainsi que le livre de Tom Feiling qui fait grand bruit par sa défense de la légalisation de la cocaïne, La machine à bonbons : comment la cocaïne s’est emparée du monde, où il dénonce les méthodes utilisées dans la lutte anti-drogue, qu’il estime « brutales, corrompues, racistes, inefficaces ». Et accuse les artisans de cette politique, « irrationnelle et hystérique ». Car l’essentiel est là : pour Feiling, la prohibition de la cocaïne est « inapplicable et contre-productive ».

- Choisir le bon anti-dépresseur grâce à l'EEG

Un des problèmes principaux des anti-dépresseurs est de choisir le bon ! Un Electro-EncéphaloGramme pourrait aider...

Technologie

biotechnologies, énergie, nanotechnologies, robotique, informatique

La nanolithographie permet d'imprimer par pression des motifs plus petits que par lithographie optique mais restait très difficile car il fallait positionner de nombreuses fois un petit tampon alors que vient d'être mis au point un rouleau capable d'imprimer en continu de grandes longueur à la vitesse d'1m par minute réduisant drastiquement les coûts et permettant l'industrialisation.

La résolution de 50 nanomètres par 6 pouces ne serait pas assez bonne pour des circuits intégrés (ce qui paraît étonnant) mais elle pourrait bénéficier aux dispositifs optiques entre autres.

- Une poudre pour cicatriser les circuits électroniques !

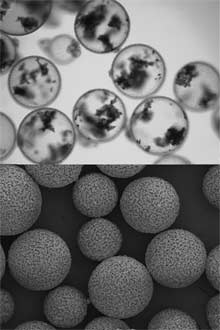

Des capsules microscopiques contenant des nanotubes de carbone peuvent rétablir instantanément un contact électrique interrompu par une crique dans le conducteur. Cette réparation presque automatique pourrait être particulièrement utile sur les contacts d'une batterie lithium-ion, où un court-circuit provoque parfois une fâcheuse combustion.

Les capsules sont brisées mécaniquement... en secouant l'appareillage. L'équipe a déterminé que la taille idéale des capsules est comprise entre 280 et 350 nanomètres. Plus petites, elles sont trop solides pour être rompues. Plus grandes, elles sont trop fragiles.

Une fois les nanotubes de carbone libérés, ils viennent d'eux-mêmes s'appliquer sur les extrémités des conducteurs et l'ensemble de cet écheveau forme un fil de fortune qui, comme l'a mesuré l'équipe, rétablit le passage du courant. Avec un tel matériau recouvrant les connecteurs de la batterie d'un ordinateur ou d'un mobile, il suffirait donc, à la vue d'un témoin d'alarme, de secouer vigoureusement l'appareil pour réparer la connexion !

- Des nanotubes doublent l'efficacité du photovoltaïque

C'est principalement en réduisant la dissipation en chaleur, un 2ème électron étant émis quand les cellules photovoltaïques actuelles convertissent l'énergie excédentaire en chaleur.

- Du photovoltaïque sur aluminium

- Du photovoltaïque sur aluminium

Nanosolar lance une nouvelle gamme de panneaux solaires à base de CIGS (copper, indium, gallium, selenium) imprimés sur des feuilles d'aluminium. Moitier moins efficaces que le silicium, le prix en serait assez inférieur pour compenser largement la perte de performance. La production industrielle commence, en Allemagne.

- Combiner solaire thermique et charbon

L'idée est d'utiliser le solaire thermique (concentrant la chaleur du soleil sur un liquide pour produire de l'électricité avec de la vapeur) pour utiliser moins de charbon dans les centrales électriques au charbon, ce qui s'avérerait très économique.

- Inauguration de la plus grande centrale solaire à collecteurs d'Europe

C'est plutôt une technologie dépassée, en tout cas pas la plus performante et qui avait été abandonné par EDF (centrale Thémis près de Font-Romeu dans les Pyrénées-Orientales), mais il faut faire feu de tout bois !

C'est plutôt une technologie dépassée, en tout cas pas la plus performante et qui avait été abandonné par EDF (centrale Thémis près de Font-Romeu dans les Pyrénées-Orientales), mais il faut faire feu de tout bois !

- Des ballons dans le ciel pour créer de l'énergie

Le projet de Cool Earth Solar, une start-up de la Silicon Valley, ambitionne de créer des « fermes de ballons » flottant à une dizaine de mètres du sol. Gonflés à l'helium, ils seraient recouverts du film CIGS et permettraient de capter le soleil plus largement.

Pour les 9 autres "inventions qui peuvent révolutionner l'écologie", il y a surtout le solaire et l'énergie intelligente mais aussi de fausses solutions comme le fer dans l'océan pour absorber le CO2. On sait que ça ne marche pas !

- Une batterie faite de sel et de cellulose

Des chercheurs suédois ont mis au point une batterie non polluante fonctionnant au sel et à la cellulose. Une batterie qui pourrait dans un proche avenir remplacer les batteries au lithium des capteurs sans fils, des implants médicaux, des étiquettes Rfid par exemple...

Les chercheurs indiquent avoir ainsi atteint une charge électrique de 600 milli-ampères (mA) par centimètre carré. Au total, ces batteries en papier pourraient offrir, selon les auteurs, une charge de 25 à 33 mAh (mA.heure) par gramme, ce qui les rend commercialement intéressantes.

De plus elles se rechargent très vite et ne contiennent pas de matériaux dangereux pour la santé ou l'environnement, comme les métaux lourds des batteries traditionnelles. Elles pourraient constituer des moyens de stockage d'énergie « propres, légers et bon marché », qui pourraient prendre place dans des vêtements ou des emballages, par exemple, mais aussi, ajoutent-ils, « extensibles ».

L'une des possibilités imaginables, en effet, serait la réalisation de batteries de très grandes tailles, pourquoi pas de plusieurs mètres carrés, qui pourraient à faible coût fournir une puissance électrique conséquente.

- Les prototypes Renault de voiture électrique

La Zoé ZE est une petite polyvalente d’un peu plus 4m de long. Dotée d’un moteur de 53 kW (75ch), elle pèse (1400 Kg) et peut atteindre 140 km/h. Son autonomie atteint 160 km.

La TwizyZE transporte deux personnes en tandem dans un habitacle entièrement vitrée. Equipée d’un petit moteur de 15kw, c'est-à-dire l’équivalent de 20ch, la Twizy ZE peut monter jusqu’à 75km/h. Cette performance tient en grande partie d’un poids contenu de 420 Kg, soit 40% de moins qu’une Smart Fortwo de première génération. L’autonomie de cette petite "puce" est de 100 km.