- Les organismes de l'espace

- Un chimpanzé capable (coupable?) de préméditation

- La part génétique du cerveau

- Le viagra responsable d'une épidémie de Sida chez les vieux

- C'est le sucre qui fait vieillir

- Trop de viande rouge tue !

- Une explication génétique de la schizophrénie

- Observer les protéines en action

- Une batterie rechargée en quelques secondes

- Plus de 60 % des Terriens possèdent désormais un portable

- Cacher son IP à Hadopi

<- Revue des sciences précédente | Revue des sciences suivante ->

Revues : Pour la Science - Sciences et Avenir - La Recherche

Brèves : Physique - Climat - Biologie - Santé - Technologie

Antarès ou Alpha Scorpii est une étoile binaire de la constellation du Scorpion. Antarès A est une géante rouge en fin de vie située à plus de 600 années-lumière de la Terre et 7 fois plus grande que le Soleil. (L'Univers fantastique de Ron Miller)

Je ne sais ce qu'il faut penser de l'APN qu'on voudrait substituer à l'ADN ou l'ARN pour une biologie synthétique encore très hypothétique, au moins très prématurée dans l'état actuel de nos connaissances, mais la meilleure histoire du mois, c'est certainement celle du chimpanzé qui prépare ses tas de cailloux à l'avance pour les lancer sur les visiteurs du zoo, plus étonnant encore que d'admettre qu'ils éduquent leurs petits, montrant à quel point nous sommes proches. Il ne leur manque vraiment que la parole ! D'ailleurs, pour l'homme lui-même le fonctionnement du cerveau se révèle plus dépendant de la génétique qu'on ne le pensait avant, sans que cela influe tellement sur le résultat, en particulier sur le langage que nous avons en partage. En Physique, le Fermilab est à l'honneur, en attendant que le LHC redémarre, avec 2 découvertes importantes au moins. Sinon il semble que l'amélioration des batteries soit un fait acquis, attendu depuis longtemps, mais on a du mal à croire que déjà 60% de Terriens possèdent un mobile, leur généralisation dans les pays pauvres dépourvus d'infrastructures étant le signe qu'on ne reviendra certes pas en arrière (et que le pc du futur sera certainement un mobile relié par wifi au clavier et à l'écran). Pour le reste, je ne sais si je vais continuer cette revue des sciences un peu trop prenante pour pas grand chose même si c'était une expérience intéressante. S'il m'avait paru indispensable de suivre notamment les nouvelles du climat, étant données les incertitudes qui restaient, il est devenu parfaitement inutile d'égrener les nouvelles catastrophiques mois après mois d'autant qu'avec la fin de l'épisode La Nińa, on risque de connaître le même enfer que l'Australie. Il y avait des raisons d'être sceptique, il n'y a plus que les fous pour s'enferrer dans leur négationnisme même si notre ignorance reste immense et qu'il faut mobiliser toute notre science pour s'en sortir. Bien sûr, au cas où il y aurait une véritable bonne nouvelle, un retournement imprévu, il faudrait le claironner sur tous les toits mais c'est devenu à peu près impossible (même si les prochaines années devaient être un petit peu plus froides que les années les plus chaudes). Dans les autres domaines aussi, il y a beaucoup de répétitions, on nous promet tous les mois de nous guérir de tous les maux mais il y a aussi des surprises à attendre et quelques progrès décisifs, on verra bien...

Pour la Science no 378, Bricoler la vie

- Individualisme et bien social, p17

Ivar Ekeland

Pour les problèmes simples, l'analyse mathématique montre qu'il y a une solution optimisant les gains de tous. Mais pas pour l'économie mondiale, où le problème est trop compliqué.

La façon dont les individus forment et révisent leurs anticipations reste un des points aveugles de la théorie économique.

Il y a un idéalisme à penser que les anticipations des agents seraient aléatoires ou déterminantes alors qu'elles s'expliquent par des causes objectives (et notamment des cycles générationnels mais surtout des informations reçues).

- Une nouvelle molécule de la vie, p26

L'acide peptidonucléique ou APN est un hybride de protéine et d'ADN qui n'existe dans aucune forme de vie. Ses propriétés étonnantes en font un premier maillon possible d'une vie artificielle...

Certains scientifiques s'intéressent à cette molécule, analogue à l'acide nucléique, qui imite les caractéristiques de stockage d'informations de l'adn et de l'arn, mais elle est construite sur un squelette protéique, plus simple et plus solide que les squelettes des acides nucléiques formés de sucres et de phosphates.

En combinant des propriétés d'acides nucléiques et de protéines, les apn permettraient de stocker des informations, à l'instar de l'adn, et seraient la machinerie catalytique – capable de favoriser des réactions chimiques – d'une cellule artificielle, à l'image des enzymes des cellules naturelles. Cette éventuelle double capacité, associée aux autres propriétés des apn, a suscité l'intérêt des scientifiques cherchant à créer une vie artificielle.

À plusieurs égards, l'arn devance cependant l'apn à ce jeu. Les exemples d'arn catalytiques naturels et synthétiques abondent. En revanche, des molécules d'apn catalytiques sont encore à découvrir.

Steen Rasmussen, du Laboratoire américain de Los Alamos au Nouveau-Mexique, et Liaohai Chen, du Laboratoire américain d'Argonne, ont suggéré une conception de protocellule primitive fondée sur des apn. La paroi de la protocellule s'autoassemble à partir de molécules tensio-actives ; son enveloppe est donc une surface membranaire lipidique. L'apn, outre des bases sur un squelette peptidique, présente une modification qui le rend lipophile (il a une affinité pour les lipides) : il s'incruste dans la membrane lipidique. En outre, de petits apn s'apparient avec l'apn de la protocellule pour former un brin complémentaire. Une molécule photosensible alimente la production de nouvelles molécules tensioactives qui augmentent la taille de la cellule. La protocellule se divise par fission naturelle quand elle atteint une taille suffisante et l'évolution se poursuit jusqu'à l'obtention de la séquence d'apn la plus efficace pour convertir l'énergie lumineuse en lipides et en apn.

Stanley Miller a montré il y a plus de 50 ans que des acides aminés peuvent se former dans des conditions supposées simuler celles de la Terre primitive ; en 2000, il a identifié des précurseurs d'apn dans ses expériences reproduisant l'environnement initial de la Terre. On a aussi montré que les informations génétiques présentes dans un oligomère d'apn peuvent se transférer par copie chimique à un autre oligomère d'apn ou à une molécule d'arn, des processus nécessaires à un monde à apn, puis à un monde transitoire d'apn/arn. Mais de l'aveu général, il y a encore un fossé entre ces observations et la construction d'un monde pré-arn. Pour que l'hypothèse tienne debout, les scientifiques doivent découvrir des molécules d'apn présentant une activité catalytique.

- L'empathie ne se réduit pas aux neurones miroirs

Nicolas Danziger, de l'Hôpital de la Pitié-Salpêtrière, a réalisé des expériences qui montrent qu'il faut aussi, vraisemblablement, un intense travail mental de représentation et d'imagination de « ce que l'autre ressent », qui va bien au-delà qu'un simple mimétisme automatique reposant sur les neurones miroirs.

Deviner ce que ressent l'autre, c'est finalement ce que chacun de nous fait dans la vie quotidienne, plutôt que de reproduire en miroir l'expérience subjective d'autrui. C'est bien grâce à cela que l'on peut prendre en compte des souffrances que l'on n'a pas vécues soi-même. Accepter l'autre, c'est peut-être essayer de comprendre ce qu'il vit, tout en sachant qu'on ne ressentira jamais vraiment la même chose.

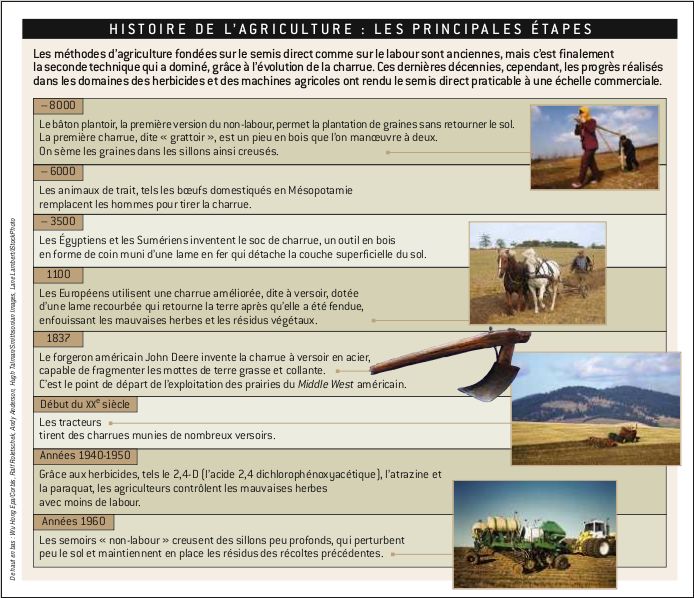

Le labour est une des premières causes de la dégradation des terres agricoles – l'un des problèmes environnementaux les plus graves – dégradation qui constitue une menace sur la production alimentaire et la subsistance du monde rural, en particulier dans les régions pauvres et densément peuplées des pays en développement. Peut-on se passer du labour ? Oui, grâce à deux techniques : le semis direct et le travail sans labour. La première méthode consiste à laisser les résidus de récolte sur les champs après la moisson, où ils constituent un paillis qui protège le sol de l'érosion et améliore la fertilité du sol. Dans la seconde, un travail superficiel du sol précède le semis (les résidus sont partiellement enfouis). Les agriculteurs utilisent des semoirs spécialement conçus qui pénètrent à travers les résidus végétaux jusqu'au sol non dégradé, où les graines peuvent germer et croître pour la nouvelle récolte.

Les techniques de semis direct créent des sillons de deux à huit centimètres de profondeur, où l'on sème : la terre n'est pas retournée et la perturbation du sol est minimale.

Cette technique offre de nombreux avantages. Elle est moins coûteuse, elle préserve un bon niveau de matières organiques à la surface du sol, elle limite l'érosion hydrique et elle favorise le stockage de carbone dans le sol. Ainsi, dans l'essai de travail du sol sur une longue durée, en place depuis les années 1970 à la station de Boigneville, dans l'Essonne, l'augmentation de carbone stocké après 28 ans sans labour est de 13 pour cent, soit quelque cinq tonnes par hectare (voir l'encadré page 74).

En France, les techniques sans labour représentent environ 30 pour cent des blés et près de 40 pour cent des colzas, mais la répartition sur le territoire est variable. Par exemple, plus de 50 pour cent des blés semés sans labour le sont dans la région Midi-Pyrénées et moins de cinq pour cent le sont en Bretagne.

Le semis direct s'inscrit dans un nouveau contexte agricole où la production de nourriture pour satisfaire la population mondiale n'est pas suffisante : les agriculteurs doivent également préserver les ressources naturelles. Le semis direct est une méthode qui peut les aider. S'il suppose des défis à relever et des compromis à faire, dans certaines parties du monde les cultivateurs abandonnent peu à peu leurs charrues.

Même si le matériel pour les semis en non-labour est parfois coûteux (certains semoirs valent plus de 75 000 euros), les avantages pour les cultivateurs restent importants. Avec ces gains de temps et d'argent, les agriculteurs peuvent être plus compétitifs sur de plus petites exploitations, ou ils peuvent s'agrandir et cultiver plus d'hectares, doublant parfois la superficie de leurs terres en utilisant le même matériel et en fournissant la même quantité de travail.

Brèves et liens

Physique

cosmologie, astronomie, physique quantique

C'est toute une conception des quarks comme ontologiquement inséparables qui s'écroule.

C'est toute une conception des quarks comme ontologiquement inséparables qui s'écroule.

Fait rarissime: une particule élémentaire, le quark top, a été observée seule et non par paire à l’issue d’une collision provoquée dans un accélérateur de particules.

Ils ont réussi à observer un événement qui se produit seulement au cours d’une collision sur 20 milliards entre protons et antiprotons. Ce fait rare est l’apparition d’un quark top seul plutôt qu’une paire de quarks top.

Les quarks sont liés entre eux par une force particulière appelée l’interaction forte, qui n’agit qu’au cœur des noyaux des atomes. Les expériences visant à créer des quarks top impliquaient donc cette interaction forte et conduisaient à la production de paires de quarks. Pour obtenir un quark top isolé, il fallait faire intervenir une autre force, l’interaction faible (qui agit elle aussi dans les noyaux atomiques).

Voir aussi Futura-Sciences.

- Découverte d'un nouveau méson

Ils viennent d’identifier un méson provenant de la désintégration de méson B+ et d’une masse de 4.140 MeV et, selon l’usage, la nouvelle particule Y a été baptisée méson Y(4140) et vient d’être ajoutée à la longue liste des hadrons et résonances hadroniques connus.

Même si le fait que cette particule serve d’intermédiaire entre un méson B+ et des mésons J/psi suggère qu’elle contient une paire de quark-antiquark charmés, elle ne se comporte pas selon les règles habituelles de la QCD.

Pour certains théoriciens, il pourrait s’agir d’un état hybride, avec deux quarks et un gluon.

- Limites pour la masse du boson de Higgs

A noter que les données du Fermilab ont également établi que la masse du boson de Higgs devrait se situer entre 170 et 185 GeV/c2, soit, plus probablement, entre 114 et 160 GeV/c2. On y voit une avancée vers sa détection, voire une preuve de la supersymétrie alors que ce n'est pour l'instant rien de plus qu'un constat de son inexistence à ces énergies !

- Traitement statistique de la théorie des cordes

La théorie des cordes est confrontée à la multitude de ses versions (voir le paysage cosmique). L'abord statistique est prometteur qui dégage des constantes entre les différentes distributions aléatoires de certains paramètres.

Ce groupe de chercheurs a développé des outils de calcul des probabilités adaptés à la résolution de certains problèmes d’évaluation de valeurs moyennes pour les paramètres du modèle standard dans l’hypothèse d’un multivers, avec certaines valeurs déterminées uniquement par les lois du hasard.

A leur plus grande surprise, leurs calculs ont montré une corrélation entre la masse des quarks et les valeurs des paramètres de la matrice CKM dans le cas où les valeurs des masses des quarks sont fixés aléatoirement dans le multivers par une loi de probabilité gaussienne. Mieux, ils trouvent une valeur très proche de ce qu’on appelle le paramètre de Jarlskog caractérisant l’amplitude de la violation CP contenue dans la matrice CKM. Dans beaucoup d’univers poches, on peut donc s’attendre à observer une valeur similaire s'ils ont raison.

- Peut-on vérifier l'effet EPR à l'oeil nu ?

Le paradoxe EPR est devenu mondialement célèbre depuis les expériences d’Alain Aspect en 1982. Depuis lors, des expériences d’optique quantique de plus en plus raffinées sondent les mystères du monde quantique. Nicolas Gisin, qui s'est illustré dans l'étude de ce paradoxe, propose aujourd’hui de le rendre directement perceptible à notre échelle. De quoi explorer les frontières entre les mondes classique et quantique et même la conscience humaine...

L'expérience de pensée proposée par Nicolas Gisin et ses collègues. Un photon d'une paire de photons intriqués est quasiment cloné pour produire une onde électromagnétique macroscopique passant à travers un dispositif. L'onde est réfléchie en deux parties qui traversent deux filtres. Selon son état, polarisée verticalement ou horizontalement, elle traversera ou ne traversera pas l'un des filtres et sera observée à l'œil nu par l'un des deux observateurs humains.

Si un des observateurs humains trouve un état de polarisation verticale pour l’onde macroscopique, il peut alors prédire que la polarisation de ce photon est horizontale et inversement. Il peut donc constater directement ou presque à l’œil nu l’effet d’intrication quantique et voir qu’effectivement la mesure de l’état quantique d’une partie d’un système intriqué se répercute sur l’autre.

J'ai toujours touvé complètement délirante la fonction donnée dans cet article à la conscience dans l'effondrement de la fonction d'onde, alors que c'est l'interaction qui réduit les probabilités et que le monde classique résulte des probabilités et de la loi des grands nombres procurant leur stabilité aux objets malgré les fluctuations quantiques... Une expérience de ce mois montre d'ailleurs qu'on peut immobiliser des photons rien qu'en faisant des mesures à intervalles de 0.2 secondes, rien à voir avec la conscience de l'observateur.

- L'hypothèse de Penrose d'une conscience quantique réfutée

La croyance que la conscience serait un phénomène quantique est toute aussi délirante, se trompant complètement sur le fonctionnement de l'apprentissage et du choix rationnel ou émotionnel, tout cela pour sauver une notion de libre-arbitre arbsurde héritée de la religion. En tout cas, le mécanisme imaginé par Penrose vient d'être réfuté.

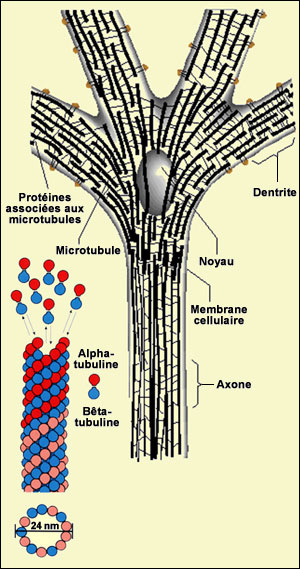

Penrose et Hamerhoff ont alors émis l’hypothèse que, dans les neurones, à l’intérieur des structures appelées microtubules, des condensats de Fröhlich pouvaient se former. La magie quantique, et plus précisément le phénomène d’intrication et les processus de traitement de l’information que l’on attribue à des ordinateurs quantiques, pourraient donc intervenir de cette manière dans le fonctionnement du cerveau jusqu'à faire émerger la conscience d’un « je » doué d’un libre arbitre.

Un groupe de chercheurs australiens travaillant dans les universités de Sydney et du Queensland vient de publier un article sur ce problème. Ils sont parvenus à déterminer la température de formation d’un condensat cohérent de Fröhlich : au moins 100 millions de kelvins ! Une telle température qui ne régne même pas au cœur du Soleil ne peut en aucun cas exister dans le cerveau.

- La fusion froide, le retour (bis)

Lorsque, le 23 mars 1989, Pons et Fleishman ont annoncé avoir réussi à produire des réactions de fusion avec une simple expérience d’électrolyse, utilisant de l’eau lourde et une électrode en palladium, beaucoup sont restés sceptiques. On le serait à moins...

La possibilité de réaliser la fusion froide en laboratoire allait depuis lors hanter l’esprit de plusieurs chercheurs. La communauté scientifique ne fut cependant pas convaincue. La situation pourrait changer après une retentissante annonce au congrès de la Société Américaine de Chimie.

Pour la présentation de résultats inattendus, Pamela Mosier-Boss a choisi le 273ième congrès de la Société Américaine de Chimie, qui s’est tenu à Salt Lake City (Utah), là même où Fleishman et Pons avaient lancé leur annonce tonitruante il y a vingt ans un même 23 mars. Elle annonce qu’elle et ses collègues ont enfin des preuves convaincantes que les traces observées dans le CR-39 sont bien celles laissées par des neutrons produits par une réaction de fusion froide, dans un dispositif constitué d’électrodes plongées dans une solution de chlorure de palladium PdCl2 dissous dans de l’eau lourde D2O (D étant du deutérium, un isotope de l’hydrogène avec un proton et un neutron).

- Observation de l'effondrement d'une étoile

En 2005, une supernova est observée dans NGC 266. En fouillant dans les archives de Hubble, on trouve une zone occupée par ce qui semblait être une étoile massive mais la résolution est mauvaise. Grâce à l'optique adaptative, la supernova est clairement observée avec le télescope Keck. En 2007, et avec une meilleure résolution, Hubble confirme qu'une étoile a complétement disparu, imposant l'idée qu'un trou noir s'est formé par effondrement d'une LBV d'au moins 50 masses solaires.

C’est donc avec surprise que les scientifiques, en réexaminant les premières photographies prises de la surface de la sonde par elle-même afin de juger de son état, ont découvert sur les jambes d’atterrissage ce qui semble bien être des gouttelettes d’eau.

L’hypothèse la plus vraisemblable fait appel au perchlorate. En juillet 2008, les premiers échantillons martiens analysés par le laboratoire de chimie humide embarqué (MECA), par microscopie optique ainsi que par des mesures électrochimiques et de conductivité électrique, avaient révélé que le sol contenait des traces de perchlorate.

Or, ce perchlorate martien possède des caractéristiques intéressantes. Dissous dans l’eau, il lui permet de demeurer liquide, et cela jusqu’à 70 degrés Celsius au-dessous de zéro. Si la sonde s’est réellement posée sur une plaque de glace (ses rétrofusées fonctionnent à l’hydrazine pure), celle-ci a pu être liquéfiée en surface et éclabousser la structure.

Cette découverte posthume (la sonde a maintenant cessé de fonctionner) apporte un argument de plus à l’hypothèse de la possibilité d’une vie martienne. Car si le perchlorate s’avère toxique pour les formes de vie terrestres, rien n’indique qu’une biologie étrangère doive obéir aux mêmes règles.

Climat

Climat, écologie, énergies

- L’acidité des océans va atteindre un niveau ayant provoqué des extinctions de masse

Les scientifiques réunis à Copenhague en préparation au sommet sur le climat qui s’y tiendra en décembre prochain avertissent que si rien n’est fait, l’acidification des océans due aux émission de CO2 va atteindre un niveau « dangereux », jamais observé depuis 65 millions d’années. L’étude de la géologie montre que par le passé une acidité comparable avait provoqué des extinctions de masse dans la vie marine.

Le rapport indique que les scientifiques « estiment que le taux futur d’acidification à la surface des océans et la pression environnementale sur le milieu marin des organismes utilisant la calcification sera très probablement sans précédent depuis 65 millions d’années. » Les chercheurs ajoutent que la situation dans les eaux profonde est l’objet d’une préoccupation encore plus forte.

Les chercheurs ont comparé le taux d’acidification actuel avec celui d’une augmentation gigantesque des gaz à effet de serre ayant eu lieu durant la préhistoire et dont les géologues savent qu’elle a provoqué une forte extinction des espèces vivant en eau profonde.

- L'océan Pacifique Tropical Ouest se réchauffe et se dessale

Dans le Pacifique Tropical Ouest, les températures de surface de la mer dépassent les 28°C sur une profondeur d'une centaine de mètres. Cette "Warm Pool" constitue l'une des sources chaudes de la machine thermodynamique de notre globe. Elle joue aussi un rôle fondamental dans le développement d'événements El Nino aux forts impacts climatiques et socio-économiques à l'échelle planétaire. Or, les océanographes du LEGOS, en collaboration avec ceux de la NOAA et de l'Université de Miami, viennent de montrer que, depuis 1955, cette Warm Pool s'est réchauffée, considérablement étendue et dessalée, une baisse de salinité qui pourrait être due à une intensification des précipitations dans la région.

- L'importance des sols dans le changement climatique

Un nouveau rapport publié par la Commission souligne le rôle crucial que les sols peuvent jouer dans l'atténuation du changement climatique. Les sols renferment environ deux fois plus de carbone que l'atmosphère, et trois fois plus que la végétation.

On estime que les sols européens contiennent 73 à 79 milliards de tonnes de carbone. Près de la moitié de ce carbone est fixé dans les tourbières de Suède, de Finlande, du Royaume-Uni et d'Irlande. Les sols jouent un rôle décisif dans le changement climatique, puisque même une perte infime de 0,1 % du carbone des sols européens dans l'atmosphère équivaudrait, en termes d'émissions de carbone, à la mise en circulation de 100 millions de voitures supplémentaires sur nos routes - soit une augmentation de 50 % environ du parc automobile existant. Inversement, aux prix actuels, une augmentation équivalente de la quantité de carbone contenue dans les sols représenterait un gain de quelque 200 millions EUR.

L'occupation des sols influe considérablement sur les réserves de carbone de ces derniers. La plupart des sols européens accumulent du carbone: les sols couverts d'herbages et de forêts servent de puits et peuvent piéger jusqu'à 100 millions de tonnes de carbone par an; les sols couverts de champs cultivés, en revanche, sont des émetteurs nets, et dégagent entre 10 et 40 millions de tonnes de carbone chaque année.

- Plusieurs causes à l'extinction du Permien-Trias

Il y a 250 millions d’années la biosphère a connu ce qui semble être sa plus importante crise, celle de la frontière Permien-Trias. Mais s’agissait-il d’une seule catastrophe ? Un groupe de géologues vient de remettre en cause sa chronologie. L’unique couche servant de repère, celle du bassin du Karoo en Afrique du Sud, serait en fait multiple...

On passe en revue les différentes hypothèses mais il semble pourtant bien admis que la raison principale d'une telle extinction, c'est le maximum thermique atteint en assez peu de temps, peut-être déclenché par le volcanisme intense de cette période dégageant de grandes quantité de CO2 puis en faisant fondre les méthanes marins, tout ce qui pourrait arriver si on ne fait rien (il y a aussi l'hypothèse que tout cela aurait dégagé un gaz mortel, le sulfure d'hydrogène). On ne peut dire que ces hypothèses soient nouvelles (voir une vidéo de 2007), ce qui est nouveau c'est qu'il y a bien eu au moins 2 temps bien différenciés, sinon 3.

Cette conclusion apporte de l’eau au moulin de ceux qui pensent que plusieurs extinctions sont survenues en quelques millions d’années tout au plus. En fait, il n’y a pas encore de véritable consensus et plusieurs théories s’affrontent pour expliquer cette crise biologique majeure.

Une des explications est celle d’un événement volcanique important. Il s’agit des gigantesques épanchements volcaniques des trapps de Sibérie. D'une épaisseur de 3.700 mètres, les couches de laves s’y sont déposées en moins d'un million d'années et sur une superficie estimée à trois millions de kilomètres carrés. Curieusement d’ailleurs, d’autres épanchements avaient eu lieu huit millions d’années plus tôt en Chine, dans la région d’Emeishan. On peut donc soutenir qu’il y a eu au moins deux extinctions importantes liées à ces trapps.

Une autre hypothèse est que le réchauffement causé par l’injection de CO2 dans l’atmosphère par les trapps de Sibérie, en augmentant de plusieurs degrés la température de la planète, a provoqué la libération massive du méthane contenu dans les clathrates. Le méthane est un gaz a effet de serre puissant et au final, la température moyenne de la planète se serait élevée de 8 à 10°C !

- New York menacée par la montée du niveau des mers

La côte Est des États-Unis est très vulnérable à la montée du niveau des mers engendrée par le réchauffement climatique, selon une nouvelle étude publiée aujourd’hui par la revue Nature Geosciences. Le long de cette côte densément peuplée, économiquement très importante, le niveau de la mer risque d’augmenter presque deux fois plus vite que la moyenne planétaire au cours du 21ème siècle, d’après les calculs de Jianjun Yin (Université de Floride) et de ses collègues.

La majeure partie de la métropole de New York se trouve à seulement 40 centimètres au-dessus du niveau de la mer, certaines parties de Manhattan ne s’élevant qu’à 12,5 cm. La région est donc particulièrement exposée aux changements.

Avec le réchauffement des eaux de surface, la circulation méridienne de l’océan atlantique nord va se ralentir, expliquent les chercheurs, et cela contribue largement à la montée du niveau de la mer sur la côte nord-est des États-Unis.

- Le niveau des océans pourrait monter de plus d’un mètre

La montée du niveau des océans pourrait être bien supérieure à ce qui était prévu jusqu’alors et atteindre au moins 1m à la fin du siècle, mettant en péril les millions de personnes qui vivent dans les régions littorales de faible altitude.

« La mobilisation massive des scientifiques s’explique par un sentiment d’urgence, mais aussi un sentiment de frustration ».

Biologie

évolution, génétique, biodiversité, éthologie, anthropologie, neurologie

- Les briques de la vie venues de l'espace

Ce n'est qu'une confirmation de ce qui était déjà établi : les composants des acides aminés sont venus de l'espace (glycine, isovaline, purines, pyrimidines). Le fait que les formes "gauches" soient les seules présentes dans les protéines, preuve d'une origine unique de la vie, viendrait aussi de l'espace où ces formes domineraient à cause d'une longue exposition à des ultraviolets polarisés ou des rayons X et d'un champ magnétique.

Dans deux météorites célèbres, celle d'Orgueil et celle de Murchison, une équipe de la Nasa a découvert parmi les acides aminés présents un excès de la forme dite gauche. Ce déséquilibre rappelle puissamment une caractéristique énigmatique de ces molécules qui forment les protéines de la vie terrestre, uniquement composées de formes gauches.

Rappelons que le fait que les composants de la vie viennent de l'espace plaide pour l'unité de la vie dans tout l'univers, vies extra-terrestres qui devraient avoir à peu près les mêmes bases partout (même si la probabilité d'une vie évoluée soit proche de zéro étant donné le temps qu'il faut à l'abri de catastrophes cosmiques).

- Des organismes extrêmophiles sur Mars ?

Le volcan martien Olympus Mons est le plus grand du Système Solaire. Il pourrait abriter des thermophiles, un type d'organisme extrêmophile se développant dans les sources chaudes ! C'est du moins la conclusion d'une équipe de scientifiques de l'Université Rice.

- A 40 kilomètres d'altitude, des bactéries inconnues sur Terre...

Une expérience indienne menée dans la stratosphère a ramené au sol trois espèces de bactéries totalement inconnues. Particulièrement résistantes aux rayons ultraviolets, elles ne vivent peut-être que là-haut...

- Reconstitution d'un prédateur du Cambrien

Malgré sa taille modeste –une dizaine de centimètres- Hurdia victoria était en son temps un redoutable prédateur. Des chercheurs suédois et canadiens ont enfin achevé la reconstitution de cet animal emblématique de la faune du Cambrien, datant de -500 à -540 millions d’années.

Cet animal marin, au corps recouvert d’une carapace en trois parties, était doté d’une mâchoire circulaire pourvue d’une riche dentition. Membre de la famille des Anomalocarididae, Hurdia appartient aux premières branches d’un groupe aujourd’hui très important : les arthropodes. Il comprend les crustacés, les insectes, les arachnides ou encore les mille-pattes.

La carapace d’Hurdia, dont une partie forme une extension devant sa tête, au-delà du corps même de l’animal, étonne les paléontologues, car elle ne protège pas des tissus mous, contrairement aux carapaces des arthropodes actuels.

- Tous les dinosaures avaient des plumes ?

Si tous les dinosaures avaient des plumes, c'est sans doute au début pure décoration mais cela s'est surtout avéré indispensable à la régulation thermique dans le passage du sang froid au sang chaud, expliquant leur résistance à la grande extinction du Permien-Trias (il y a 250 millions d'années), de même que leur capacité à supporter une baisse drastique de l'oxygène de l'air. Ces 2 caractéritique (régulation thermique et meilleure respiration étant partagées par les ancètres des mammifères ayant réussi à survivre à ces conditions extrêmes). On a bien ici une évolution déterministe vers l'adaptation aux changements extrêmes même si les plumes étaient au début le pur fruit du hasard.

Si tous les dinosaures avaient des plumes, c'est sans doute au début pure décoration mais cela s'est surtout avéré indispensable à la régulation thermique dans le passage du sang froid au sang chaud, expliquant leur résistance à la grande extinction du Permien-Trias (il y a 250 millions d'années), de même que leur capacité à supporter une baisse drastique de l'oxygène de l'air. Ces 2 caractéritique (régulation thermique et meilleure respiration étant partagées par les ancètres des mammifères ayant réussi à survivre à ces conditions extrêmes). On a bien ici une évolution déterministe vers l'adaptation aux changements extrêmes même si les plumes étaient au début le pur fruit du hasard.

Curieusement ce sont les dinosaures à bassin de lézard qui sont considérés comme les lointains ancêtres des oiseaux. C’est d’ailleurs chez les seuls théropodes que des indices indiquaient la présence de plumes comme revêtement cutané.

Toutefois, un article publié aujourd’hui dans la revue Nature annonce la découverte de plumes dans un autre grand groupe de dinosaures appartenant aux ornithischien. Ce qui suggère que l'origine des plumes pourrait dater de l'apparition des dinosaures, il y a plus de 200 millions d'années.

Voir aussi Futura-Sciences.

- Plus de mâles quand les couleurs sont différentes

Les chercheurs ont observé la reproduction de 200 diamants de Gould (100 mâles et 100 femelles). C’est ainsi qu’ils ont constaté qu’il y avait 82% de mâles en moyenne dans la couvée lorsque les deux parents n’avaient pas la même couleur.

De fait, les rejetons issus de deux parents différents ont moins de chance de survie à cause des incompatibilités génétiques entre les deux variétés, précisent les chercheurs. Le taux de mortalité est plus élevé chez les femelles.

Afin de vérifier le rôle actif des femelles pour éviter ces problèmes, les chercheurs ont sortis leurs pinceaux. Modifiant la couleur de certains mâles, ils ont fait en sorte que des femelles s’accouplent avec un partenaire différent en pensant qu’il avait la même couleur qu’elles. Dans ces cas-là, le ratio mâle/femelle était équilibré mais le taux de mortalité était élevé chez les rejetons femelles.

Tel un plongeur malhabile balloté par le courant, un curieux poisson de l’archipel des Moluques, en Indonésie, nage en heurtant les coraux qui l’entourent. Ce n’est pas le seul trait surprenant de cet Histiophryne psychedelica.

Le psychédélique poisson d’Ambon a la capacité de se déplacer en rebondissant, protégé par un corps gélatineux et plusieurs épaisseurs de peau pour éviter de se couper sur le corail. Le poisson recourbe sa queue pour s’arrondir comme une balle. Cependant les spécimens adultes préfèrent se déplacer en utilisant leurs nageoires comme des pattes, moins aléatoire que la nage rebondissante.

- Une raie géante découverte en Thaïlande

- Un cerveau de 300 millions d'années

Un lointain cousin des raies et des requins vieux de 300 millions d’années vient de livrer son cerveau à la science moderne…. Il s’agit du plus vieux cerveau fossile jamais découvert.

Le cerveau d’un petit poisson cartilagineux qui vivait il y a 300 millions d’années est parvenu jusqu’à nous grâce à des conditions de fossilisation exceptionnelles et grâce aux techniques d’imagerie les plus performantes. Des chercheurs français et américains ont en effet découvert sur un fossile de poisson d’une cinquantaine de centimètres, exhumé au Kansas, que les tissus mous de son cerveau avaient été conservés en trois dimensions, alors que la plupart des spécimens sont aplatis.

Ce cerveau à la structure symétrique ne mesure que 1,5 mm sur 7 mm. La partie consacrée à la vision est très développée, alors que celle consacrée à l’audition est très réduite.

- Un chimpanzé capable (coupable?) de préméditation

C'est une nouvelle extraordinaire car elle rapproche le chimpanzé des premières techniques de défense humaine permettant de tenir à distance les prédateurs. On a ainsi déjà constaté que les premiers hommes faisaient des stocks de galets qu'ils ramenaient d'une rivière voisine. On avait vu aussi comme un petit chimpanzé s'intégrait assez bien à une famille humaine. Il ne leur manque vraiment que la parole !

C'est une nouvelle extraordinaire car elle rapproche le chimpanzé des premières techniques de défense humaine permettant de tenir à distance les prédateurs. On a ainsi déjà constaté que les premiers hommes faisaient des stocks de galets qu'ils ramenaient d'une rivière voisine. On avait vu aussi comme un petit chimpanzé s'intégrait assez bien à une famille humaine. Il ne leur manque vraiment que la parole !

L’observation d’un chimpanzé mâle -jetant des pierres sur les visiteurs d’un zoo- révèle que cet animal serait capable de planifier longtemps à l’avance ses actions en fonction de son environnement.

Depuis 1997, les gardiens du zoo de Furuvik (Suède) ont observé un chimpanzé au comportement bien étrange. Le matin, ce primate collecte calmement des pierres qu’il accumule en tas. Il va même plus loin en y ajoutant des morceaux de béton qu’il façonne en forme de disques. Lorsque les visiteurs affluent en nombre durant l’après-midi, le singe montre un grand état d’excitation et commence à jeter ses projectiles en direction des visiteurs. Ce comportement se produit uniquement lors de la saison d’ouverture du zoo.

- Des macaques qui enseignent l’hygiène dentaire à leurs petits

Là aussi c'est fascinant même s'il est incroyable qu'on puisse nier que les mammifères éduquent leur progéniture. Il suffit de voir une chatte montrer à ses petits comment passer une chatière par exemple. La différence avec l'homme ne serait encore une fois que de degrés s'il n'y avait le langage.

Au Japon, des macaques ont été surpris alors qu’ils se nettoyaient les dents à l’aide de cheveux humains utilisés comme du fil dentaire. Mieux : ils semblent enseigner cette technique à leur progéniture.

Neuf animaux adultes, tous des femelles, avaient alors pour habitude de grimper sur la tête des visiteuses, non pour mendier de la nourriture, mais pour arracher quelques cheveux qu’ils emportaient. Ils les utilisaient ensuite comme s’il s’agissait de fil dentaire pour se nettoyer les dents le plus consciencieusement du monde.

Les animaux partent à la recherche des cheveux environ 30 minutes après leur repas.

En présence d'un plus jeune, la différence de comportement de l’adulte est frappante et démontre une volonté d’enseignement de la mère à son petit. Les femelles modifiaient leurs gestes, les rendant plus amples, y mettant plus d’insistance et intercalant de plus longues pauses entre eux. Les actions elles-mêmes étaient exagérées afin de mieux en détailler le déroulement à leurs jeunes, dont l’âge s’échelonnait alors de 6 mois à 13 mois.

En tout, les macaques observés passaient environ deux fois plus de temps à se passer le fil dentaire improvisé lorsque les jeunes étaient présents, alors que l’action se réduisait à un bref nettoyage en temps normal…

- La part génétique du cerveau

Le cerveau est par nature l'organe le plus plastique du corps où l'acquis prime sur l'inné puisqu'il est dédié à la perception et l'apprentissage, à cette seconde nature qu'est l'habitude. On ne peut malgré tout ignorer sa part génétique qui va plus loin que ce qu'on imaginait puisque les véritables jumeaux auraient des cerveaux plus semblables que les faux dans leurs modes de raisonnement et les zones du cerveau utilisées. Il faut souligner malgré tout que si les fonctionnements sont différents, cela ne change pas fondamentalement le résultat et pas du tout les règles de la logique.

Le cerveau est par nature l'organe le plus plastique du corps où l'acquis prime sur l'inné puisqu'il est dédié à la perception et l'apprentissage, à cette seconde nature qu'est l'habitude. On ne peut malgré tout ignorer sa part génétique qui va plus loin que ce qu'on imaginait puisque les véritables jumeaux auraient des cerveaux plus semblables que les faux dans leurs modes de raisonnement et les zones du cerveau utilisées. Il faut souligner malgré tout que si les fonctionnements sont différents, cela ne change pas fondamentalement le résultat et pas du tout les règles de la logique.

En comparant les patterns d'activité cérébrale entre des jumeaux et leurs frères durant ce type d'exercice, les chercheurs ont découvert que certaines régions de leur cerveau n'entraient pas systématiquement en action chez tous les individus. Ces disparités s'avèrent corrélées à des différences génétiques, ce qui pourrait aider à mieux comprendre le rôle joué par les gènes lorsque la "pensée" varie chez deux individus confrontés au même type de réflexion.

- Pas de conscience sans coopération

Expérience assez intéressante quoique relativement prévisible et dont la conclusion de l'article qu'il n'y aurait pas de centre de la conscience pourrait être en partie erronée. En effet, on constate que la conscience mobilise tout le cerveau, état qui met en éveil tous les centres du cerveau et totalise les informations pour en déduire un comportement conscient. Il faut bien qu'il y ait un endroit où la totalisation ait lieu et se matérialise en décision consciente (de tout le corps) après vérification de toutes les données même s'il est certain que ce centre de décision n'est rien sans tout le reste du cerveau dont il n'est que l'aboutissement (un peu comme la convergence des revendications aboutit à une manifestation unitaire pour modifier la conscience collective et les décisions politiques). En tout cas, on peut y voir une confirmation de la conscience comme question, manque d'information et retour au réel, une façon de reconstruire la situation à partir des perceptions quand un événement nous a fait perdre le fil et bouleverse la situation antérieure. Notre autonomie de pensée se manifeste par notre ignorance, le fait de ne pas savoir quoi faire avant analyse personnelle de la question au moyens de toutes les informations disponibles.

Expérience assez intéressante quoique relativement prévisible et dont la conclusion de l'article qu'il n'y aurait pas de centre de la conscience pourrait être en partie erronée. En effet, on constate que la conscience mobilise tout le cerveau, état qui met en éveil tous les centres du cerveau et totalise les informations pour en déduire un comportement conscient. Il faut bien qu'il y ait un endroit où la totalisation ait lieu et se matérialise en décision consciente (de tout le corps) après vérification de toutes les données même s'il est certain que ce centre de décision n'est rien sans tout le reste du cerveau dont il n'est que l'aboutissement (un peu comme la convergence des revendications aboutit à une manifestation unitaire pour modifier la conscience collective et les décisions politiques). En tout cas, on peut y voir une confirmation de la conscience comme question, manque d'information et retour au réel, une façon de reconstruire la situation à partir des perceptions quand un événement nous a fait perdre le fil et bouleverse la situation antérieure. Notre autonomie de pensée se manifeste par notre ignorance, le fait de ne pas savoir quoi faire avant analyse personnelle de la question au moyens de toutes les informations disponibles.

Lors de la perception inconsciente d’un mot, l’activité électrique du cerveau s’arrête en moyenne au bout de 300 millisecondes, ont observé Stanislas Dehaene, Lionel Naccache et leurs collègues. L’accès à la conscience entraîne lui une mobilisation plus longue du cerveau et se traduit par la convergence de plusieurs aires cérébrales distantes. Il s’agit d’une «coopération cérébrale intense» écrivent les chercheurs, qui ont isolé quatre marqueurs spécifiques de cet accès à la conscience.

- Réactions identitaires des groupes

Gustave Le Bon et Freud avaient déjà analysé la psychologie des foules sans faire appel à la neurologie mais, il y a de quoi justifier mon aversion de la parole publique, d'autant plus qu'il faut limiter son propos à 3 ou 4 points sans digressions alors qu'il y aurait tant à dire...

En face à face avec un individu, "on parle à son cortex", c'est-à-dire que l'on "cérébralise", on rationalise, on utilise une logique point par point. Tandis que face à un groupe, il faut "parler à sa moelle épinière", soit ce qui fédère le groupe, les valeurs de l'entreprise, par exemple. "Dès que l'on constitue un groupe de plus de 4 ou 5 personnes, l'instinct grégaire prend le dessus et l'individu se dissout dans le groupe, en proportion de sa taille et perd son sens critique"

"Face à un grand groupe, il faut activer la valeur du groupe sur le plan identitaire. Que ce soit l'identité de l'entreprise, du métier, de ce qui constitue le groupe : face à un groupe de policiers, il faudra parler de la défense du citoyen, par exemple", indique le psychologue. Il faut principalement s'attacher aux éléments fédérateurs de façon à établir une connivence entre chaque participant, pour que tous se sentent concernés.

Pour cela, il ne faut pas hésiter à travailler le langage émotionnel, via des images. "La métaphore touche l'irrationnel et parle ainsi à l'inconscient du groupe".

- Des bébés de 3 jours marchent sur un tapis roulant virtuel !

48 bébés de trois jours ont été placés en réalité visuelle virtuelle. Ils étaient maintenus en position érigée au-dessus d'une surface horizontale sur laquelle étaient projetés différents environnements visuels. Les scientifiques ont exposé les nourrissons à un damier noir et blanc avançant vers les bébés, simulant une marche vers l'avant. Les chercheurs ont observé que ce tapis roulant virtuel déclenchait un nombre de pas en l'air, identique à une marche sur le sol. En comparaison, le nombre de pas était inférieur pour un damier statique ou une roue tournante de triangles noirs sur fond blanc.

En démontrant que le déplacement visuel de l'environnement peut, non seulement déclencher une réaction de marche, mais également moduler les paramètres de cette marche dès la naissance, les chercheurs ont démontré que le couplage entre vision et locomotion est beaucoup plus fonctionnel que ce qui n'a jamais été soupçonné.

Cette marche néonatale dite primitive n'est pas un simple réflexe tactile, car elle peut être réglée par l'environnement visuel du nouveau-né, en l'absence de tout contact avec le sol.

Ce n'est pas la première fois qu'on en parle (souvenir pas encore effacé!). En fait, cette fois, c'est simplement qu'en inhibant un facteur de transcription (CREB), on bloquerait la mémorisation de souvenirs, mais là, ils détruisent carrément les neurones de l'amygdale latérale de souris exprimant ce facteur spécifique...

- La mère de Cléopâtre était africaine

Cléopâtre VII, reine d'Egypte et héritière de la dynastie ptolémaïque, d'origine macédonienne, avait bien du sang africain, affirme la BBC dans un documentaire qui sera diffusé le 23 mars. Des analyses des restes de sa soeur, Arsinoé, retrouvés en Turquie, ont montré qu'elle possédait un squelette africain. Ce qui concernerait donc également sa soeur.

Ce sont tout de même des conclusions hâtives car les deux soeurs pourraient ne pas avoir le même père.

- De belles images au microscope

Santé

génétique, traitements, nutrition, hygiène

- Le viagra responsable d'une épidémie de Sida chez les vieux ?

Il ressort des rares études que le nombre de nouveaux cas déclarés entre quarante cinq et soixante cinq ans est en augmentation constante ces dernières années. Ainsi, dans la Région européenne de l’OMS, 8% des cas signalés en 2005 appartenaient à ce groupe d’âge tandis qu’aux États-Unis 11% des nouveaux séropositifs enregistrés en 2006 étaient des sujets âgés.

Ces résultats sont inquiétants car chez le sujet âgé l’infection à VIH évolue rapidement vers le sida. Par exemple, l’espérance de vie est supérieure à 13 ans chez les individus contaminés entre 5 et 14 ans mais elle n’est que de quatre ans chez ceux contaminés à 65 ans ou plus. La baisse de l’immunité avec l’âge explique sans doute cette accélération du processus pathologique.

Pourquoi chez les sujets âgés le taux de contamination est-il ainsi en augmentation ? L’un des coupables désignés par l’OMS serait le…viagra !

- C'est le sucre qui fait vieillir

Ce n'est même pas la consommation mais la détection de sucre dans le sang qui accélère le processus de vieillissement comme si notre ADN régulait la durée de vie des plus agés en fonction de leur prélèvement sur les ressources : seuls les plus frugaux pourraient survivre longtemps. C'est cohérent avec les autres maladies du vieillissement, liées en général à l'inflammation, que sont les diabète de type 2, la résistance à l'insuline et l'intolérance au glucose.

Ce n'est même pas la consommation mais la détection de sucre dans le sang qui accélère le processus de vieillissement comme si notre ADN régulait la durée de vie des plus agés en fonction de leur prélèvement sur les ressources : seuls les plus frugaux pourraient survivre longtemps. C'est cohérent avec les autres maladies du vieillissement, liées en général à l'inflammation, que sont les diabète de type 2, la résistance à l'insuline et l'intolérance au glucose.

Nous savions que la réduction de l'apport en calories, du fait par exemple de la réduction de la quantité de sucre ingéré, pouvait prolonger la durée de vie. Selon une nouvelle étude menée par des chercheurs de l'Université de Montréal, dont les résultats sont publiés dans la revue PLoS Genetics, c'est la capacité des cellules à détecter la présence du sucre qui intervient dans ce phénomène plutôt que son utilisation.

Les cellules de levure desquelles on a retiré le gène d'un détecteur du sucre glucose vivent aussi longtemps que celles ayant un régime faible en glucose. En d'autres termes, la durée de vie de la cellule ne dépend pas de son alimentation, mais plutôt de la détection de la nourriture dont elle dispose.

- C'est l'eau oxygénée qui blanchit les cheveux

C'est une accumulation massive de peroxyde d’hydrogène qui provoque le grisonnement des cheveux. Ce produit, plus connu sous le nom d’eau oxygénée (H202), est par exemple utilisé (à faible concentration par les coiffeurs) pour décolorer poils et cheveux. Toutes nos cellules ciliées fabriquent un peu de peroxyde d'hydrogène, mais en vieillissant, cette production augmente.

Un phénomène similaire pourrait se produire au niveau cutané, il serait responsable du vitiligo une maladie qui se caractérise par l’apparition de tâches blanches sur la peau.

- Cancer de la prostate : le dépistage réduit la mortalité de 20%

La question était très controversée, pas mal de médecins prétendant qu'il ne servait à rien de faire un dépistage systématique du cancer de la prostate dont l'évolution est très lente, constituant simplement une augmentation inutile des coûts. Ces arguments ne tiennent plus.

La plus vase étude portant sur l’intérêt du dépistage du cancer prostatique se solde par un verdict sans appel. Les résultats publiés dans le New England Journal of Medicine ne souffrent en effet aucune contestation, et plaident en faveur du dépistage.

Le cancer de la prostate est le cancer le plus fréquent et la deuxième cause de mortalité par cancers chez l’homme. Mais c’est aussi la première après 50 ans.

Pourtant, une prise en charge précoce permettrait de guérir 95 % de ces cancers ! D’où l’importance de ces nouvelles données, qui devraient conforter les partisans d’un dépistage organisé. Récemment, une étude montrait qu'un simple test urinaire pourrait suffire à dépister le cancer de la prostate.

- Pollution : les particules fines sont nocives même à faible dose

Alors que l'on craint aujourd'hui les « pics de pollution », une longue étude démontre que leur impact sanitaire est réel mais faible. En revanche, la pollution de tous les jours, même lorsqu'elle semble réduite, est la principale responsable des effets sur la santé.

« Ce sont les expositions fréquentes, à des niveaux modérés de pollution, qui sont responsables de l’essentiel de l’impact sanitaire, et non les pics de pollution ». Voilà en substance la conclusion de l’Agence française de Sécurité sanitaire de l’Environnement et du Travail (Afsset)

Les pics de pollution ne sont responsables que de 3% des effets négatifs sur notre santé. Les 97% restant sont en fait « attribuables à des niveaux de pollution modérés (moins de 50 microgrammes/m3 NDLR), mais fréquents ».

Partant, « la réduction des émissions (de particules) doit passer avant le dispositif d’information et d’alerte sur les pics » insiste l’Afsset, d’autant plus que l’Agence n’a pas observé « un seuil de concentration en particules en deçà duquel aucun effet sanitaire ne serait constaté »…

Pour réduire les émissions de particules pas de miracles, il faut s’attaquer à la source : la combustion du bois, du charbon, du fioul. Dans les zones urbaines, les « transports qui contribuent de manière importante à la pollution ».

Selon une étude américaine, la consommation de viande rouge ou transformée augmente de façon globale le risque de décès, toutes causes confondues.

Les résultats font état d’une augmentation du risque de décès chez les personnes qui consomment le plus de viande rouge. Cette mortalité accrue est causée par une légère augmentation du nombre de décès par cancers ou maladies cardiovasculaires, principalement. Elle persiste même quand les données sont modérées avec d’autres facteurs épidémiologiques tels que le tabagisme, l’obésité, la consommation de fruits et légumes ou la pratique d’une activité sportive.

Il y avait un risque accru de 31% pour la mortalité totale chez les hommes et 36% chez les femmes. En revanche, une comparaison entre le cinquième des participants qui ont mangé le plus de viande blanche et les 20% en ayant consommé le moins montre que le premier groupe présentait un risque de décès légèrement moindre.

Il ne faut pas en faire trop, ce n'est pas si dangereux que ça mais quand même, d'autant plus que la viande rouge n'est pas soutenable écologiquement, les poulets notamment étant de bien meilleurs pourvoyeurs de protéines tout en étant bénéfiques pour la santé. Il ne s'agit donc pas de se priver de viande, pas même de viande rouge en petite quantité car elles fournissent du fer, mais de préférer poissons et oiseaux aux mammifères plus susceptibles d'interférer avec nos propres systèmes de régulation.

- Une explication génétique de la schizophrénie

Des chercheurs du Picower Institute for Learning and Memory au MIT viennent de publier dans la revue Cell un article portant sur un gène nommé DISC1, l’acronyme anglais de disrupted in schizophrenia 1. Li-Huei Tsai, professeur de neurosciences au département des sciences cognitives et du cerveau du MIT, et ses collègues, y expliquent avoir découvert un lien entre ce gène et une enzyme du nom de GSK3B (en français glycogène synthétase kinase 3 bêta). Ces chercheurs ont démontré pour la première fois que Disc1 inhibe directement l'activité de cette enzyme du cerveau. Or, le chlorure de lithium, qui est prescrit pour la schizophrénie et les troubles bipolaires, agit également sur le GSK3B. On savait depuis le début des années 1990 que le gène Disc1 était probablement impliqué dans certains cas de schizophrénie car il était présent dans une famille écossaise où cette affection est fréquente.

On sait que ce gène influence la croissance des neurones dans le cerveau en développement et favorise un placement correct des neurones dans le système nerveux. Mais en travaillant avec des souris, les neurobiologistes viennent de montrer que Disc1 régule la croissance des cellules souches neurales, leur division, le moment où elles doivent devenir de nouveaux neurones et comment ils doivent se connecter.

Tsai et ses collègues ont montré qu'empêcher l’expression du gène Disc1 arrête la division des cellules souches neurales ainsi que leur transformation en neurones. Mieux, l'élimination de ce gène dans les cellules souches neurales de souris adultes déclenche des symptômes similaires à la schizophrénie, comme l’hyperactivité. Or, en donnant à ces souris un inhibiteur de l’enzyme GSK3B, les troubles disparaissent.

Il semble donc clair que Disc1, en contrôlant l’activité de GSK3B, régule bien l’équilibre entre le renouvellement des cellules souches neurales et leur transformation en neurones, ce qui à son tour influe sur les circuits nerveux à l’origine de la schizophrénie, au moins dans certains cas.

Technologie

biotechnologies, énergie, nanotechnologies, robotique, informatique

- Observer les protéines en action

En réduisant les temps d'analyse des données nanométriques de plusieurs minutes à une seconde, il devient possible de comprendre comment marchent les nanomachines biologiques que sont les protéines. C'est un pas important pour les nanotechnologies autant que pour la biologie car il est probable qu'on aura intérêt à imiter les machines naturelles plutôt que d'en construire des artificielles (tout au plus devra-t-on sans doute réduire la part de l'aléatoire).

Cette nouvelle approche devrait permettre d'ouvrir l'accès à des informations cinétiques sur les mécanismes de repliement ou d'auto-organisation de ces assemblages biomoléculaires. De plus, elle constitue une avancée importante pour observer en temps réel le fonctionnement des nanomachines biologiques telles que les chaperonnes, protéasomes, peptidases ou moteurs moléculaires.

- Une protéine transportant l'oxygène

C'est d'abord un exploit technologique de design des protéines. Que cela puisse servir de sang artificiel comme l'article le présente est plus douteux. Il y a déjà eu des échecs retentissants sur ce plan, il faut attendre les tests in vivo mais il y aura sûrement une utilité à cette protéine inaugurant les protéines "nano-machines" artificielles.

C'est d'abord un exploit technologique de design des protéines. Que cela puisse servir de sang artificiel comme l'article le présente est plus douteux. Il y a déjà eu des échecs retentissants sur ce plan, il faut attendre les tests in vivo mais il y aura sûrement une utilité à cette protéine inaugurant les protéines "nano-machines" artificielles.

- Des centrales hydroélectriques pompées urbaines

Principe de la centrale hydroélectrique pompée souterraine urbaine proposée par Pierre Couture. Elle permet de stocker l'énergie et réguler les variations des énergies renouvelables, entre autres, et constitue un élément incontournable des réseaux électriques de demain.

La solution la plus utilisée présentement pour le stockage à grande échelle de l’énergie est la centrale hydroélectrique pompée. Dans sa version traditionnelle, il s’agit de deux réservoirs d’eau situés l’un plus haut que l’autre, reliés ensemble par une galerie souterraine où se trouve une turbine qui peut fonctionner dans les deux sens. Pendant les périodes de faible demande d’électricité (la nuit par exemple) le moteur-générateur électrique couplé à la turbine pompe l’eau du réservoir inférieur vers le réservoir supérieur. Aux périodes de forte demande, on laisse couler l’eau du réservoir supérieur vers le réservoir inférieur, ce qui entraîne la turbine et génère de l’électricité. On appelle également ces installations des centrales à pompage-turbinage. Dans une centrale bien conçue, l’aller-retour de l’eau entre les deux réservoirs entraîne une perte d’environ 20% de l’énergie stockée.

Mais, pour réguler les fluctuations journalières de l’énergie éolienne et solaire, ou pour réguler les variations de la demande au fil de la journée, on n’a pas besoin de stocker plus de 25% environ de l’énergie produite. La régulation entraîne donc une perte de seulement 5% de l’énergie totale produite.

Ce paquebot de luxe n'a pas grand chose d'écolo malgré ses voiles, mais ça fait une belle image...

- Eclairage : les LED arrivent

Après s’être discrètement introduites dans la signalisation et les feux de nos véhicules, les LED se préparent à s’imposer en ville et dans nos foyers.

Avec une durée de vie moyenne de 50.000 heures, les LED sont cinq fois plus durables que les ampoules basse consommation traditionnelles, dont elles ne consomment que 20% de l’énergie. Le coût de revient horaire face aux ampoules à incandescence en devient presque négligeable avec 0,04%, d’autant que les dispositifs à LED équivaut à présent aux meilleures lampes fluocompactes.

- Une batterie rechargée en quelques secondes

La batterie d’un téléphone portable rechargée en 10 secondes, celles d’une voiture hybride en 5 minutes…

En modélisant le trajet des ions entre les deux électrodes, Ceder et Kang ont constaté que l’on pouvait théoriquement atteindre de très grandes vitesses, à condition de tracer des autoroutes pour les ions. Les deux chercheurs ont donc modifié la structure de la cathode en phosphate de fer et de lithium afin que les ions trouvent plus facilement leur route et circulent plus vite.

Leur prototype de batterie se charge en 10 à 20 secondes contre six minutes pour une batterie de la même taille avec une électrode classique. Dans la mesure où ils ont amélioré un matériau déjà commercialisé, leur trouvaille devrait trouver rapidement des débouchés à grande échelle.

Il y a d'autres batteries qui affichent des performances proches désormais, en particulier la batterie SCiB de Toshiba (Super Charge ion Battery). Des supercondensateurs à base de nanotubes de carbone semblent l'avenir mais cette technologie est plus simple et moins coûteuse. En tout cas, on a enfin des batteries performantes alors que les batteries étaient le point faible jusqu'ici, une véritable honte pour la science limitant fortement l'énergie solaire notamment.

- Plus de 60 % des Terriens possèdent désormais un portable

Selon un rapport de l’ONU repris par “The Guardian”, plus de 60 % des Terriens possèdent désormais un portable. Un chiffre qui a notamment explosé durant les trente derniers mois… et modifié considérablement les modes de vie dans les pays émergents.

Ce sont, au total, plus de 4,1 milliards de comptes qui sont activés, soit huit ou neuf fois plus que le nombre de lignes de téléphone fixe. L'accélération a été particulièrement impressionnante depuis une trentaine de mois : mi-2006, 40 % de la population mondiale possédait un portable. Cette croissance folle – une moitié d'utilisateurs en plus ! – trouve sa source du côté des pays en voie de développement, et plus généralement des continents dits émergents.

- Un curieux mobile à écran 3D

Au Japon, Hitachi vient de présenter le Wooo Keitai H001, un mobile arborant un bouton marqué 3D, qui permet d'afficher – certaines – images avec un effet de relief.

L'écran (3,1 pouces de diagonale, 845 x 480 pixels) peut en effet créer deux images qui seront visibles selon des angles différents, chacune par un seul des deux yeux.

Le système n'est compatible qu'avec les photos et les vidéos reçues par le service 1seg, utilisé par KDDI pour diffuser des programmes vers les mobiles.

- Virtual cocoon : un ordinateur pour voir, entendre et sentir

La maquette a été présentée lors d'une conférence, Pioneer 09, qui vient de se tenir à Londres. Elle montre un écran panoramique inclus dans une visière à rabattre devant les yeux. L'utilisateur doit aussi s'enfoncer dans les narines le double embout d'une canule nasale, qui diffusera des produits odorants. C'est l'équipe d'Alan Chalmers, de l'université de Warwick, qui travaille actuellement sur la réalisation d'un système capable d'émettre des odeurs sur commande. Le casque sera complété par un système tactile, par exemple inclus dans des gants, et pourquoi pas d'un distributeur de saveurs dans la bouche.

Les nouveautés à venir comme ce Touch-book à 400€ dont le clavier peut se détacher. Il y a aussi un PC qui ne consomme rien en veille. Une multiprise à 30€ est faite pour débrancher quand on n'es pas là mais " il faut bouger pour ne pas se faire couper son écran en regardant un film" ! Pour le reste on en a déjà parlé avant. Signalons aussi le netbook eCafé 9 pouces à 299€, la version 8 pouces avec Linux étant même à 199€ !

- La consommation électrique des télévisions et appareils numériques

Article très intéressant qui fait le point sur la consommation grandissante des télévisions mais aussi des boitiers ADSL ou des décodeurs TNT qui ne sont pas du tout optimisés de ce point de vue. Il y a de gros progrès à faire mais on constate que cette nouvelle consommation se fait au détriment d'autres activités consommatrices d'énergie et n'augmente pas la consommation globale, au contraire. Le terme employé TIC est un peu trompeur étant donnée que ce sont les téléviseurs plasma qui sont les plus gros consommateurs.

Les « technologies de l'information et de la communication », c'est-à-dire les appareils informatiques, audiovisuels et de téléphonie, brûlent actuellement 13% de l'énergie totale consommée en France. Un chiffre en augmentation rapide. Mais elles représentent aussi une source d'économie possible et une réduction importante d'émissions de gaz à effet de serre.

La plus grosse part (16,5 TWh/an) est due aux téléviseurs et aux magnétoscopes (regroupés dans l'étude). Les ordinateurs personnels, avec leurs périphériques, atteignent 7 TWh, soit nettement moins que les postes de travail professionnels (11 TWh/an) mais davantage que les serveurs (4 TWh/an).

L'algorithme s'essaie au sémantique en élargissant le champ de recherche par ajout de mots clés associés et en analysant les expressions de plus de trois mots clés.

Dans cette veine, on attend avec impatience, en principe au mois de mai, la merveille des merveilles, baptisée Wolfram Alpha, créée par Stephen Wolfram (le père du logiciel Mathematica). Selon les informations qui ont filtré, à une question posée, cet outil renverra une ou plusieurs réponses plutôt que des liens vers des pages Web.

- Encarta, Microsoft jette l'éponge

Trop dure la concurrence de Wikipédia... Face à l'hégémonie de l'encyclopédie gratuite, Microsoft décide que son service payant, Encarta, ne correspond plus au marché actuel. En octobre, ce sera fini...

Le site The Pirate Bay lance la version bêta d’un service d’échange payant basé sur une liaison VPN afin d’abriter ses utilisateurs des regards indiscrets.

Ce nouveau dispositif, dont le nom parodie la loi suédoise Ipred, sera basé sur une liaison VPN (Virtual Private Network), ou RPV (Réseau Privé Virtuel). Celle-ci fonctionne sur le principe du tunneling, soit une encapsulation de données d'un protocole réseau dans un autre. Ainsi par exemple, considérant que le réseau Internet actuel se base encore presque entièrement sur le protocole IPv4 (32 bits, ou 4,2 milliards d’adresses possibles) alors que son successeur, le IPv6 (128 bits, soit 3,4 x 1038 adresses possibles), il est possible de relier entre elles deux machines IPv4 par l’intermédiaire d’un tunnel en IPv6 sous une forme chiffrée par un algorithme décidé par les deux interlocuteurs lors de l’établissement de la liaison. Seuls les ordinateurs de part et d’autre du tunnel ont alors accès en clair à ces données, qui échappent à toute tentative de détection par les fournisseurs d’accès.

Simple à mettre en œuvre, ce procédé est utilisé depuis longtemps par l’entreprise et de nombreux organismes. Il est, de surcroît, peu coûteux...

En cours d’expérimentation par 500 bêta-testeurs suédois, Ipredator sera un service payant, proposé sur abonnement pour 5 euros par mois. Seconde ironie, cette somme correspond exactement au montant forfaitaire suggéré pour la licence globale, supposée compenser la perte en matière de droits d’auteur dans le cadre de la dépénalisation du téléchargement de fichiers envisagée...

Sur leur site, les concepteurs d’Ipredator affirment que l’organisation ne conservera aucune donnée de trafic, rendant inutile une éventuelle saisie ou confiscation de leurs serveurs en espérant identifier les utilisateurs du réseau, dont, de toute façon, les adresses IP n’apparaîtront pas.

- Tirer les leçons des échecs technologiques

Les échecs nous éclairent sur les limites du déterminisme de la technique et la valeur de l'usage.

Que peut-on apprendre des prédictions qui ne se sont pas réalisées ? Patrick J. Gyger, directeur de la Maison d’ailleurs, le Musée de la science-fiction, de l’utopie et des voyages extraordinaires sis à Yverdon-les-Bains en Suisse, et le chercheur Nicolas Nova, nous proposaient en ouverture de la 4e édition de Lift, la conférence européenne sur les questions que posent les nouvelles technologies, un détour par les échecs de l’informatique et de la science-fiction pour mieux comprendre notre avenir.

Dès 1921, de nombreux prototypes de voitures-avions ont existé et volé, comme l’explique Gyger dans son livre sur les Voitures volantes. Bien d’autres objets ont connu des destins similaires, comme les montres-téléphones, la cybernétique, la robotique ou les vidéophones…

Il y a de nombreux facteurs qui expliquent les échecs du vidéophone, notamment techniques : mais cela n’empêche pas qu’en 2008, certains constructeurs continuent de nous proposer ce type de produits, toujours sans grands succès. Les frigos intelligents sont également un autre exemple de ce type de produits qui a échoué à toucher le grand public pour lequel il était destiné. Pour Nicolas Nova, c’est également le cas des services de localisation qui permettent de savoir où sont nos amis (du TapTap du Xerox Parc inventé en 1993 à Google Latitude, le service de géolocalisation de Google). Cela fait 20 ans qu’on cherche des applications à ces outils, sans véritables succès. Les gens ont du mal à se servir des outils de localisation collective, notamment pour des raisons qui sont liées au respect de la vie privée.

- Prix de l'inventeur européen de l'année 2009: les nominations

- John Daugman (Royaume-Uni) lequel a utilisé les spécificités de l'oeil humain pour élaborer une procédure de reconnaissance intrinsèquement sûre qui a accru la sûreté dans le monde entier ;

- Brian Druker (États-Unis) et Jürg Zimmermann (Suisse) pour un nouveau médicament contre la leucémie myéloïde chronique;

- Fiona Fairhurst (Royaume-Uni) qui a révolutionné la natation sportive en créant son maillot de bain «fastskin» inspiré de la peau de requin;

- Adolf Goetzberger (Allemagne) qui est souvent considéré comme à l'origine de l'utilisation commerciale de l'énergie solaire;

- Maria-Regina Kula (Allemagne) pour l'utilisation d'un enzyme comme catalyseur dans des méthodes écologiques de production de médicaments et de substances chimiques;

- Bartolomej Janek (Slovaquie) pour un mécanisme réducteur qui établit de nouvelles normes en matière de robotique;

- Hendrikus Meijer et Huibert den Hartog (Pays-Bas) pour un nouveau fourneau permettant de produire de la fonte brute en utilisant très peu d'énergie;

- Joseph LeMer (France) pour un nouveau type d'échangeur thermique consommant peu d'énergie;

- Raoul Parienti (France) pour son assistant de lecture «Top Braille» destiné aux non-voyants;

- Marion Rudy (catégorie des non-Européens, États-Unis) pour un système d'amortissement des chocs destiné aux chaussures de sport;

- Shoichi Sasaki (catégorie des non-Européens, Japon), sans lequel il n'existerait pas de véhicules à moteur hybride équipé de puissantes batteries longue durée sur le marché;

- Yiquing Zhou (catégorie des non-Européens, Chine) dont l'agent végétal est considéré comme le remède le plus efficace dans la lutte contre la malaria, est le premier scientifique chinois nominé.

- Le Maïs serait cultivé depuis 9000 ans

Il y a au moins 9.000 ans, des habitants du Mexique ont domestiqué le téosinte (à gauche) dont l'épi était bien maigre comparé au maïs actuel.

C’est dans la vallée du Balsas, où pousse le téosinte, que les chercheurs ont concentré leurs recherches. Sous un gros rocher, appelé l’abri de Xihuatoxtla, ils ont découvert des restes de maïs, sous formes de phytolithes (cailloux de silice formés dans les tissus de la plante) et de grains d’amidon restés accrochés à des outils servant pour préparer la plante. Vieux de 8.700 ans, ces fossiles sont les plus anciennes preuves archéologiques connues à ce jour témoignant des débuts de la domestication du maïs.

Les dates du néolithique méso-américain se rapprochent de celles du néolithique moyen-oriental, ce qui est très étonnant en l'absence de contacts et plaide en faveur d'une sorte de synchronisation et donc d'un certain déterminisme technologique en réponse aux mêmes variations climatiques.

Revue des sciences précédente | Revue des sciences suivante

Les commentaires sont fermés.