Temps de lecture : 9 minutes Sur le temps long, le seul progrès incontestable et cumulatif, est celui des connaissances (de la techno-science). Bien sûr, cela ne veut pas dire que tout le monde y ait accès ni qu'il n'y aurait pas des retours en arrière, des savoirs oubliés ou refoulés à court terme avant d'être redécouverts, mais, en tout cas, et malgré ce qu'on prétend, ce progrès objectif est largement indépendant de nous, imposé par l'expérience contredisant la plupart du temps nos croyances. Loin d'atteindre un savoir absolu pourtant, cette accumulation de connaissances dévoile plutôt à chaque fois de nouvelles terres inconnues, si bien qu'on peut dire que l'ignorance croît à mesure de notre savoir qui détruit nos anciennes certitudes et préjugés.

Sur le temps long, le seul progrès incontestable et cumulatif, est celui des connaissances (de la techno-science). Bien sûr, cela ne veut pas dire que tout le monde y ait accès ni qu'il n'y aurait pas des retours en arrière, des savoirs oubliés ou refoulés à court terme avant d'être redécouverts, mais, en tout cas, et malgré ce qu'on prétend, ce progrès objectif est largement indépendant de nous, imposé par l'expérience contredisant la plupart du temps nos croyances. Loin d'atteindre un savoir absolu pourtant, cette accumulation de connaissances dévoile plutôt à chaque fois de nouvelles terres inconnues, si bien qu'on peut dire que l'ignorance croît à mesure de notre savoir qui détruit nos anciennes certitudes et préjugés.

Effectivement, les sciences ne progressent que par la rencontre de faits qui échappent aux théories en cours, obligeant à les reformuler. Ainsi, leurs avancées pas à pas démontrent qu'on n'accède pas directement au réel comme à une vérité révélée définitive devenue transparente mais qu'il y a une dialectique cognitive à l'oeuvre corrigeant à chaque fois la position précédente, la complexifiant par une négation partielle ou par un changement de paradigme qui ne peut être anticipé avant. Cette dialectique cognitive à partir de l'état des savoirs illustre bien qu'il n'y a pas d'accès à l'être, comme le disait déjà Montaigne, il n'y a que des approximations, des approches, comme d'une canne d'aveugle qui va de gauche à droite afin de cerner son objet, tester ses limites (Fichte définit le savoir par la rencontre d'un moi libre qui se cogne au non-moi qui lui résiste). Il y a un dualisme irrémédiable entre le savoir et le réel auquel il doit s'ajuster en tâtonnant, la connaissance n'est pas originelle, immédiate, directe, instinctive, mais s'élabore petit à petit avec le temps, se précise, se complète, se nuance.

Pour les sciences, même les théories les plus établies ne sont donc pas à l'abri d'une réinterprétation totale, comme la relativité a réinterprété la physique newtonienne, sans que cela puisse constituer un aboutissement définitif (problème de la gravité quantique, etc). Aucun argument ici pour les théories les plus farfelues ou spiritualistes contestant les sciences mais, au contraire, pour ne pas se fier à nos convictions et suspendre notre jugement en restant ouvert aux remises en cause par l'expérience de nos représentations (plus que des équations elles-mêmes qui restent vérifiées dans leur domaine de validité). On voit que, ce que l'histoire des sciences implique, c'est bien leur temporalité, tout comme l'évolution du vivant et nos propres apprentissages, entre l'héritage du passé et les découvertes à venir impossibles à prévoir, devant passer comme l'enfant par une série de stades de développement et s'enrichissant au cours du temps. Il n'y a dès lors aucune raison qu'on arrête de progresser et que le temps s'arrête. Si Hegel en avait fait l'hypothèse, c'était seulement pour l'accès à un "savoir absolu" qui n'était en réalité que le dépassement de la religion par la conscience de soi comme produit de l'histoire, et non une totale omniscience impensable pour des êtres finis (même artificiels).

Ceci rappelé rend douteux, en effet, que la situation puisse être complètement différente avec des Intelligences Artificielles, même si elles nous surpassent en tout, pouvant exploiter toutes les données disponibles et accélérer significativement les progrès des connaissances. Elles constituent incontestablement un nouveau stade cognitif avec l'accès au savoir pour tous (après wikipédia), mais on ne peut en attendre une révélation soudaine de la vérité (cachée), une "singularité" dont il n'y aurait plus d'au-delà, comme si le temps s'arrêtait. Certes, répétons-le, les IA devraient produire nombre de nouvelles connaissances ou équations en trouvant des corrélations inaperçues entre domaines éloignés, et pourraient même déboucher sur des théories révolutionnaires dépassant nos idées reçues. Cependant, pas plus que les humains, elles ne pourraient inventer des lois effectives et se passer de l'expérience - comme s'il n'y avait plus de monde extérieur, d'incertitudes, de questions. De même, malgré ses compétences universelles, l'Intelligence Artificielle, bien que nourrie aux meilleures sources, ne saurait tenir le rôle d'un Dieu omniscient et de garant ultime de la vérité. Elle peut tout au plus prendre une place de juge de première instance, peut-on dire, assez fiable et fort utile mais dont on sait qu'il peut se tromper et être désavoué par des juridictions supérieures.

Lire la suite

On ne peut considérer qu'il soit trop futile de s'intéresser aux religions alors qu'on assiste à une violente réaction religieuse et obscurantiste contre le progressisme et les sciences. Le rôle des religions est considérable, au moins depuis Sumer et l'Égypte, aussi bien au niveau politique que psychologique. Mon intérêt pour la question est très ancien puisque j'avais déjà tenté une histoire des religions très concise en 1994. Pour l'origine du christianisme, mon article de 2007 sur "l'invention de Jésus" faisait l'inventaire de tous les courants juifs qui avaient pu mener au christianisme en les classant grossièrement selon trois tendances : Messianiste juif, Millénariste essénien, Apocalyptique hellénisée. Je n'abordais pas cependant la constitution historique du christianisme, ramené à une émergence des mouvements précédents. Or, la focalisation sur l'invention de Jésus ratait la nouveauté radicale introduite par Paul et son rôle comme véritable fondateur du christianisme bien que devant composer avec d'autres courants qui l’absorberont. La figure de Paul est d'autant plus importante que son messianisme sans messie hante pas mal de révolutionnaires (pas seulement Benjamin, Agamben ou Badiou).

On ne peut considérer qu'il soit trop futile de s'intéresser aux religions alors qu'on assiste à une violente réaction religieuse et obscurantiste contre le progressisme et les sciences. Le rôle des religions est considérable, au moins depuis Sumer et l'Égypte, aussi bien au niveau politique que psychologique. Mon intérêt pour la question est très ancien puisque j'avais déjà tenté une histoire des religions très concise en 1994. Pour l'origine du christianisme, mon article de 2007 sur "l'invention de Jésus" faisait l'inventaire de tous les courants juifs qui avaient pu mener au christianisme en les classant grossièrement selon trois tendances : Messianiste juif, Millénariste essénien, Apocalyptique hellénisée. Je n'abordais pas cependant la constitution historique du christianisme, ramené à une émergence des mouvements précédents. Or, la focalisation sur l'invention de Jésus ratait la nouveauté radicale introduite par Paul et son rôle comme véritable fondateur du christianisme bien que devant composer avec d'autres courants qui l’absorberont. La figure de Paul est d'autant plus importante que son messianisme sans messie hante pas mal de révolutionnaires (pas seulement Benjamin, Agamben ou Badiou).

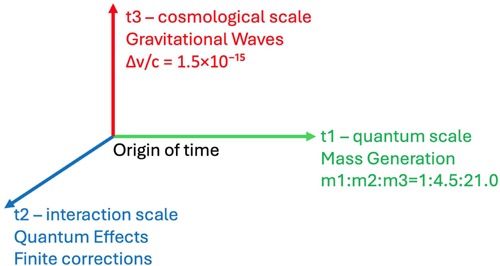

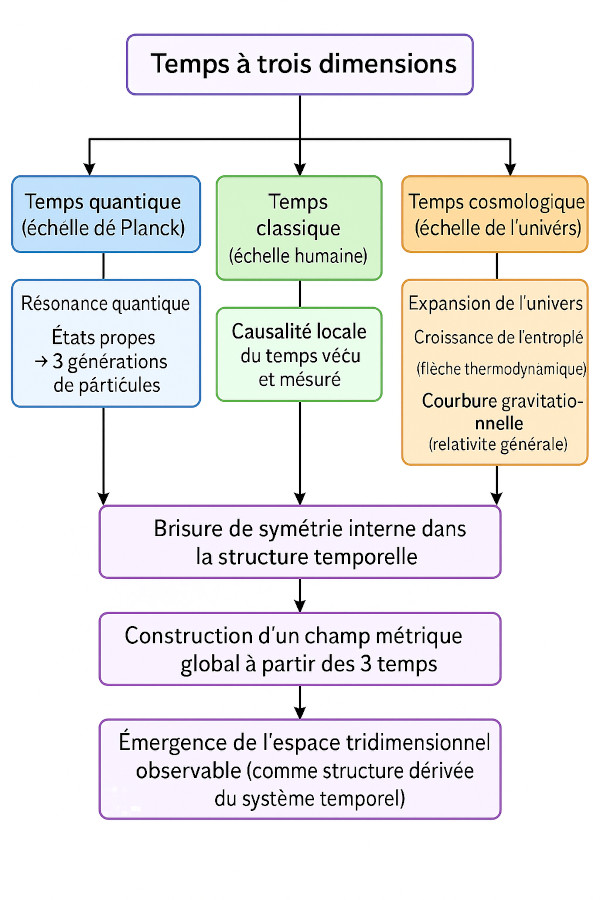

Il est téméraire de parler des nouvelles théories physiques, il y en a bien trop dont on n'entendra plus jamais parler, et il faut bien dire que l’article du mois de janvier "

Il est téméraire de parler des nouvelles théories physiques, il y en a bien trop dont on n'entendra plus jamais parler, et il faut bien dire que l’article du mois de janvier "

Il y a quelques années encore, on désespérait de jamais pouvoir implanter dans un robot nos capacités langagières tant les agents conversationnels étaient limités. L'échec (relatif) du traitement du langage malgré tout ce que la linguistique croyait savoir, entretenait la croyance dans une essence mystique du langage, inaccessible à notre raison comme aux intelligences artificielles. Les performances de ChatGPT ont permis de résoudre ce dernier mystère de notre humanité (celui du langage qui nous sépare de l'animalité), en dévoilant à l'étonnement de tous son mécanisme de prédiction probabiliste de la suite, éclairant du même coup les raisons pour lesquelles nous ne pouvions pas l'imaginer quand nous réduisions le langage à la logique et la grammaire. Ce qui nous semblait l'essence du langage y serait seulement sous-entendu, sélection par l'usage, et ne nous est pas si naturel sous cette forme de règles plaquées de l'extérieur (ainsi on prendra un exemple avec cheval/chevaux pour savoir si on doit employer le pluriel dans une expression, sans être bien clair avec la règle elle-même). Il nous faut donc réexaminer les théories linguistiques précédentes, de Saussure à Chomsky.

Il y a quelques années encore, on désespérait de jamais pouvoir implanter dans un robot nos capacités langagières tant les agents conversationnels étaient limités. L'échec (relatif) du traitement du langage malgré tout ce que la linguistique croyait savoir, entretenait la croyance dans une essence mystique du langage, inaccessible à notre raison comme aux intelligences artificielles. Les performances de ChatGPT ont permis de résoudre ce dernier mystère de notre humanité (celui du langage qui nous sépare de l'animalité), en dévoilant à l'étonnement de tous son mécanisme de prédiction probabiliste de la suite, éclairant du même coup les raisons pour lesquelles nous ne pouvions pas l'imaginer quand nous réduisions le langage à la logique et la grammaire. Ce qui nous semblait l'essence du langage y serait seulement sous-entendu, sélection par l'usage, et ne nous est pas si naturel sous cette forme de règles plaquées de l'extérieur (ainsi on prendra un exemple avec cheval/chevaux pour savoir si on doit employer le pluriel dans une expression, sans être bien clair avec la règle elle-même). Il nous faut donc réexaminer les théories linguistiques précédentes, de Saussure à Chomsky.

Pour les lecteurs de ce blog, et de son ancienne revue des sciences, il n'y a rien de surprenant à ce que la découverte de l'édition génétique ait été récompensée par un prix Nobel car c'est indubitablement une des découvertes les plus importantes qui soient. En effet, le mécanisme CRISPR-Cas9 utilisé par des bactéries pour se défendre des virus en coupant leur ADN s'est révélé un outil puissant d'intervention sur des séquences du génome, facilitant énormément les modifications génétiques jusqu'à les mettre à la portée de n'importe quel biologiste. Si ce n'est donc évidemment pas le début des OGM, c'est un changement d'échelle considérable qui devrait généraliser les manipulations génétiques, y compris sur notre propre génome (un Chinois l'a déjà fait), pour des améliorations qui seront le plus souvent très utiles mais pouvant constituer tout aussi bien une nouvelle "bombe nucléaire" (s'attaquant à l'ADN du noyau) plus dangereuse encore que la menace atomique.

Pour les lecteurs de ce blog, et de son ancienne revue des sciences, il n'y a rien de surprenant à ce que la découverte de l'édition génétique ait été récompensée par un prix Nobel car c'est indubitablement une des découvertes les plus importantes qui soient. En effet, le mécanisme CRISPR-Cas9 utilisé par des bactéries pour se défendre des virus en coupant leur ADN s'est révélé un outil puissant d'intervention sur des séquences du génome, facilitant énormément les modifications génétiques jusqu'à les mettre à la portée de n'importe quel biologiste. Si ce n'est donc évidemment pas le début des OGM, c'est un changement d'échelle considérable qui devrait généraliser les manipulations génétiques, y compris sur notre propre génome (un Chinois l'a déjà fait), pour des améliorations qui seront le plus souvent très utiles mais pouvant constituer tout aussi bien une nouvelle "bombe nucléaire" (s'attaquant à l'ADN du noyau) plus dangereuse encore que la menace atomique.