Temps de lecture : 7 minutes- Les origines de la créativité (PLS)

C'est une vieille histoire de tenter de dater nos origines et une "coupure épistémologique" nous séparant à jamais de l'animalité alors qu'on trouve toujours des précédents dans un processus qui semble plus progressif. Il n'empêche que la véritable révolution culturelle semble se passer vers 50 000 ans et qu'on peut remonter pour ses prémices à 70 000 ans peut-être alors que cet article remonte bien avant, sous le couvert d'une "créativité" tout de même bien lente en ces temps reculés par rapport à l'accélération suivante. La seule véritable coupure pensable et qui n'est pas génétique, me semble celle du langage narratif bien qu'on ait fait l'hypothèse que son potentiel ne se soit révélé qu'une fois l'espérance de vie devenue un peu plus longue avec des groupes plus importants permettant l'élaboration de cultures complexes avec leur transmission par les ancêtres.

Ici, on tente de montrer que nos capacités cérébrales et de coopération sont essentielles dans l'innovation, ce dont on n'aurait jamais douté, mais l'élément déterminant semble la démographie dans un sens différent de la taille des groupes plutôt dans la densité des populations et le réseau de leurs échanges, le seuil minimum de ce que Pierre Chaunu appelait le monde plein au Moyen-Âge, pour une densité bien plus forte, a été estimé par Mark Thomas avoir été atteint il y a 100 000 ans (ce qui ne tient pas compte de l'explosion du Mont Toba et d'un goulot d'étranglement génétique, il y a 70 000 ans). Si c'est vraiment une question de densité, l'évolution technique n'en a pas fini d'accélérer jusqu'au pic de population au moins ! Cette densité est peut-être seulement nécessaire pour qu'il y ait évolution cumulative, que les innovations ne soient pas oubliées, assurant une continuité dans l'humanisation du monde à partir de laquelle nous parlons, dans un monde déterminé par un niveau technique donné. Un encadré insiste plutôt sur les interactions avec l'environnement qui sont au moins aussi déterminantes. Ainsi, on peut penser que l’accélération des innovations au début du Néolithique venait de la nécessité de s'adapter à un nouvel environnement et un nouveau mode de vie alors qu'ensuite, une fois le système rodé, la conservation l'emportera sur l'innovation pour de longs millénaires jusqu'à l'époque contemporaine parfois où le bouleversement est bien plus grand encore.

La lignée de l'homme moderne est apparue en Afrique il y a environ six millions d'années, mais durant près de 3,4 millions d'années, ses premiers membres ont laissé peu de témoignages d'innovation. Cela suggère qu'ils se procuraient de la nourriture à la main, ou avec des outils rudimentaires qui ne se sont pas conservés, des bâtons par exemple.

Puis des homininés (hominidés non arboricoles) nomades ont fabriqué des outils coupants en taillant des galets avec des pierres. Cet acte témoigne d'une étonnante ingéniosité. Mais nos ancêtres semblent avoir utilisé le même type de hache multifonction (un biface) pendant les 1,6 million d'années suivantes, à quelques légères modifications près.

En Afrique du Sud, des chercheurs ont relevé des traces de nombreuses inventions précoces. Les chasseurs-cueilleurs qui habitaient la grotte de Blombos il y a 100 000 à 70 000 ans, par exemple, gravaient des motifs sur de gros morceaux d'ocre. Ils fabriquaient des poinçons en os, peut-être pour façonner des vêtements en peau. Ils se paraient de colliers de perles chatoyantes faites de coquillages et, dans un lieu dédié, réduisaient en poudre de l'ocre rouge et l'emmagasinaient dans les plus anciens récipients connus, faits de coquilles d'ormeaux. Plus loin à l'Ouest, sur le site de Pinnacle Point, des individus travaillaient la pierre il y a 164 000 ans, chauffant une roche locale, la silcrète, sur un feu contrôlé, pour la transformer en un matériau brillant, plus facile à tailler.

Les pointes de pierre provenant du site de Kathu Pan 1, en Afrique du Sud, constituaient autrefois les extrémités de lances vieilles de 500 000 ans qui appartenaient sans doute à Homo heidelbergensis, le dernier ancêtre commun de l'homme de Neandertal et de Homo sapiens. Et dans la grotte de Wonderwerk, toujours en Afrique du Sud, une couche ancienne contenant des cendres de végétaux et des fragments d'os calcinés suggère qu'il y a un million d'années, un homininé encore plus lointain, Homo erectus, a appris à allumer des feux pour se réchauffer et se protéger des prédateurs.

Aussi impressionnants que soient ces premiers éclairs de créativité, l'immense disparité des innovations, tant en quantité qu'en qualité, entre les hommes modernes et nos lointains ancêtres demande une explication.

À l'aide de données génétiques provenant d'Européens modernes, ils ont estimé la taille des populations humaines en Europe au début du Paléolithique supérieur, époque où la créativité semble être apparue dans cette région, et ont calculé la densité de population. Puis ils ont étudié les populations africaines au cours du temps, simulant leur croissance et leurs migrations. Leur modèle montre que les populations africaines ont atteint la même densité que les premiers Européens du Paléolithique supérieur il y a environ 101 000 ans, juste avant que l'innovation ne se manifeste dans les régions subsahariennes selon les témoignages archéologiques. Le modèle montre aussi qu'il existait alors de vastes réseaux sociaux.

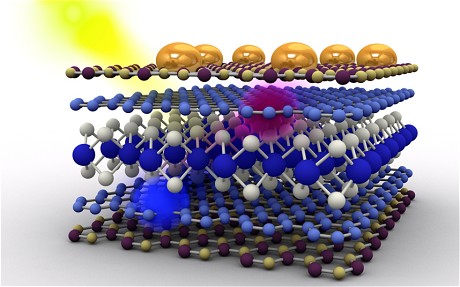

L'apparition de grandes populations connectées a permis aux innovations de se répandre, telle cette recette d'arme de jet à base de lamelles retouchées en pierre, mise au point par Homo sapiens il y a environ 71 000 ans.

Cela n'a rien à voir avec l'article mais je signale un livre de 2003 "La femme des origines : Images de la femme dans la préhistoire occidentale" de Claudine Cohen qui remet en cause les projections des interprétations dominantes (l'identification des squelettes féminins, un culte de la fécondité peu compatible avec les ressources limitées de chasseurs-cueilleurs, etc.), un exercice salutaire contre les préjugés qui ne débouche sur aucune certitude et plaide plutôt pour une grande diversité au lieu de l'uniformité supposée mais le plus étonnant peut-être est la mise en cause de la chasse avant le Paléolithique supérieur :

Lewis Binford souligna déjà, jetant un pavé dans la mare qu’il n’y avait pour lui aucune certitude pour soutenir l’existence de la chasse avant la toute fin du paléolithique. Il pouvait tout aussi bien s’agir de charognage plutôt que de chasse qui aurait tout aussi bien pu être accompli par des femmes. Selon d’autres anthropologues la chasse ne peut être le moteur de la genèse humaine puisque l’humain n’a appris que tardivement à chasser mais bien la cueillette.